8 Dinge, die Sie über große Sprachmodelle wissen sollten

In Kürze

Große Sprachmodelle (LLMs) werden verwendet, um die Nuancen natürlicher Sprache zu erforschen, die Fähigkeit von Maschinen zum Verstehen und Generieren von Text zu verbessern und Aufgaben wie Spracherkennung und maschinelle Übersetzung zu automatisieren.

Es gibt keine einfache Lösung für die Verwaltung von LLMs, aber sie sind genauso fähig wie Menschen.

Mit der rasanten Entwicklung der Verarbeitung natürlicher Sprache und ihrer Verwendung in der Wirtschaft wächst das Interesse an großen Sprachmodellen. Diese Modelle werden verwendet, um die Nuancen natürlicher Sprache zu erforschen, die Fähigkeit von Maschinen zu verbessern, Text zu verstehen und zu generieren und Aufgaben wie Spracherkennung und maschinelle Übersetzung zu automatisieren. Hier sind acht grundlegende Dinge, die Sie über große Sprachmodelle (LLM) wissen sollten.

- LLMs sind „fähiger“, da die Kosten weiter steigen

- Ein kurzer Blick darauf, wie GPT Modelle passen sich an, wenn die Schulungskosten steigen

- LLMs lernen, Brettspiele zu spielen, indem sie Repräsentationen der Außenwelt verwenden

- Es gibt keine einfache Lösung für die Verwaltung von LLM

- Experten haben Schwierigkeiten, die Funktionsweise des LLM zu erklären

- LLMs sind genauso fähig wie Menschen

- LLMs müssen mehr sein als nur „Alleskönner“

- Models sind „intelligenter“, als die Leute aufgrund des ersten Eindrucks denken

LLMs sind „fähiger“, da die Kosten weiter steigen

LLMs werden vorhersehbar „fähiger“ mit steigenden Kosten, auch ohne coole Innovationen. Die Hauptsache hier ist die Vorhersehbarkeit, die im Artikel darüber gezeigt wurde GPT-4: Fünf bis sieben kleine Modelle wurden mit einem Budget von 0.1 % des endgültigen Modells unterrichtet, und dann wurde auf dieser Grundlage eine Vorhersage für ein riesiges Modell getroffen. Für eine allgemeine Einschätzung von Perplexität und Metriken bei einer Teilstichprobe einer bestimmten Aufgabe war eine solche Vorhersage sehr genau. Diese Vorhersagbarkeit ist wichtig für Unternehmen und Organisationen, die sich für ihren Betrieb auf LLMs verlassen, da sie entsprechend budgetieren und zukünftige Ausgaben planen können. Es ist jedoch wichtig zu beachten, dass steigende Kosten zwar zu verbesserten Fähigkeiten führen können, die Verbesserungsrate jedoch schließlich stagnieren kann, was es erforderlich macht, in neue Innovationen zu investieren, um weiter voranzukommen.

Ein kurzer Blick darauf, wie GPT Modelle passen sich an, wenn die Schulungskosten steigen

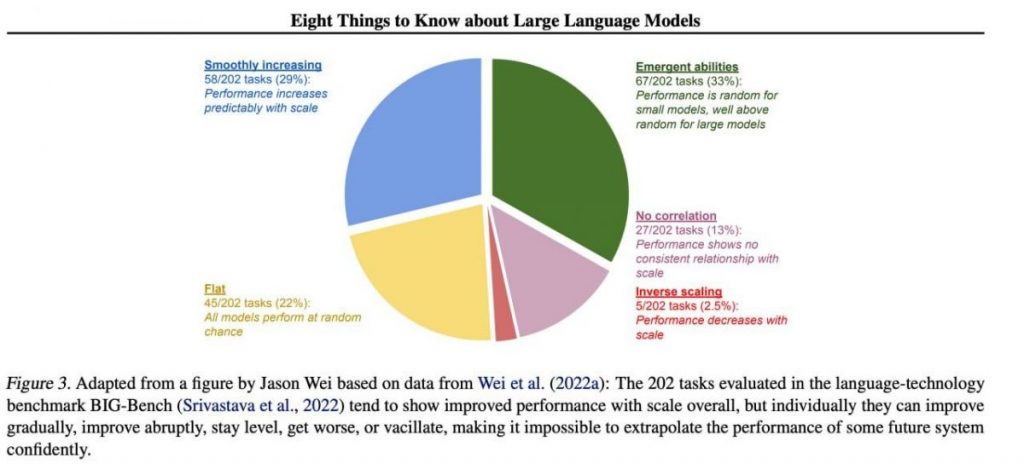

Bestimmte wichtige Fähigkeiten treten jedoch tendenziell unvorhersehbar als Nebenprodukt der Steigerung auf Ausbildungskosten (längeres Training, mehr Daten, größeres Modell) – es ist fast unmöglich vorherzusagen, wann Modelle bestimmte Aufgaben ausführen werden. In unserem haben wir uns intensiver mit dem Thema beschäftigt Artikel über die Entwicklungsgeschichte von GPT Modelle. Das Bild zeigt die Verteilung der Qualitätssteigerung von Modellen auf verschiedene Aufgaben. Nur die großen Modelle können lernen, verschiedene Aufgaben zu erledigen. Diese Grafik verdeutlicht die erheblichen Auswirkungen einer Vergrößerung von GPT für auf ihre Leistung bei verschiedenen Aufgaben. Es ist jedoch wichtig zu beachten, dass dies auf Kosten erhöhter Rechenressourcen und Umweltbelastungen geht.

LLMs lernen, Brettspiele zu spielen, indem sie Repräsentationen der Außenwelt verwenden

LLMs lernen und verwenden häufig Repräsentationen der Außenwelt. Es gibt viele Beispiele hier, und hier ist eines davon: Modelle trainiert Brettspiele basierend auf Beschreibungen einzelner Züge zu spielen, ohne jemals ein Bild des Spielfelds zu sehen, interne Darstellungen des Zustands des Bretts bei jedem Zug zu lernen. Diese internen Darstellungen können dann verwendet werden Zukunft vorhersagen Bewegungen und Ergebnisse, sodass das Modell das Spiel auf hohem Niveau spielen kann. Diese Fähigkeit, Darstellungen zu lernen und zu verwenden, ist ein Schlüsselelement Aspekt des maschinellen Lernens und künstliche Intelligenz.

Es gibt keine einfache Lösung für die Verwaltung von LLM

Es gibt keine zuverlässigen Methoden zur Steuerung des LLM-Verhaltens. Obwohl es einige Fortschritte beim Verständnis und der Minderung verschiedener Probleme (einschließlich ChatGPT und GPT-4 mithilfe von Feedback) besteht kein Konsens darüber, ob wir sie lösen können. Es wächst die Sorge, dass dies in Zukunft zu einem riesigen, potenziell katastrophalen Problem werden könnte, wenn noch größere Systeme geschaffen werden. Daher erforschen Forscher neue Methoden, um sicherzustellen, dass KI-Systeme mit menschlichen Werten und Zielen in Einklang stehen, wie etwa Werteausrichtung und Belohnungstechnik. Es bleibt jedoch eine anspruchsvolle Aufgabe, dies zu gewährleisten Sicherheit und Zuverlässigkeit von LLMs in komplexen realen Szenarien.

Experten haben Schwierigkeiten, die Funktionsweise des LLM zu erklären

Experten können das Innenleben des LLM noch nicht interpretieren. Keine Technik würde es uns erlauben, auf zufriedenstellende Weise anzugeben, welche Arten von Wissen, Argumentation oder Zielen das Modell verwendet, wenn es ein Ergebnis generiert. Dieser Mangel an Interpretierbarkeit wirft Bedenken hinsichtlich der Zuverlässigkeit und Fairness der Entscheidungen des LLM auf, insbesondere bei Anwendungen mit hohem Einsatz wie der Strafjustiz oder der Kreditwürdigkeitsprüfung. Es unterstreicht auch die Notwendigkeit weiterer Forschung zur Entwicklung transparenterer und rechenschaftspflichtiger KI-Modelle.

LLMs sind genauso fähig wie Menschen

Obwohl LLMs in erster Linie darauf trainiert werden menschliches Verhalten beim Schreiben von Texten nachahmenSie haben das Potenzial, uns in vielen Aufgaben zu übertreffen. Dies lässt sich bereits beim Schach- oder Go-Spiel beobachten. Dies liegt an ihrer Fähigkeit, große Datenmengen zu analysieren und auf der Grundlage dieser Analyse Entscheidungen in einer Geschwindigkeit zu treffen, mit der Menschen nicht mithalten können. Allerdings mangelt es LLMs immer noch an der Kreativität und Intuition des Menschen, weshalb sie für viele Aufgaben weniger geeignet sind.

LLMs müssen mehr sein als nur „Alleskönner“

LLMs dürfen nicht die Werte ihrer Schöpfer oder die in einer Auswahl aus dem Internet verschlüsselten Werte zum Ausdruck bringen. Sie sollten keine Stereotypen oder Verschwörungstheorien wiederholen oder versuchen, jemanden zu beleidigen. Stattdessen sollten LLMs so konzipiert sein, dass sie ihren Benutzern unvoreingenommene und sachliche Informationen bieten und gleichzeitig kulturelle und gesellschaftliche Unterschiede respektieren. Darüber hinaus sollten sie regelmäßig getestet und überwacht werden, um sicherzustellen, dass sie diese Standards weiterhin erfüllen.

Models sind „intelligenter“, als die Leute aufgrund des ersten Eindrucks denken

Schätzungen der Fähigkeiten eines Models basierend auf dem ersten Eindruck sind oft irreführend. Sehr oft müssen Sie sich die richtige Aufforderung einfallen lassen, ein Modell vorschlagen und vielleicht Beispiele zeigen, und es wird viel besser damit zurechtkommen. Das heißt, es ist „intelligenter“, als es auf den ersten Blick scheint. Daher ist es entscheidend, dem Modell eine faire Chance zu geben und es mit den notwendigen Ressourcen auszustatten, um seine besten Leistungen zu erbringen. Mit dem richtigen Ansatz können uns selbst scheinbar unzureichende Modelle mit ihren Fähigkeiten überraschen.

Wenn wir uns auf eine Stichprobe von 202 Aufgaben aus dem BIG-Bench-Datensatz konzentrieren (er wurde speziell zum Testen erschwert). Sprachmodelle von und bis), dann zeigen die Modelle in der Regel (im Durchschnitt) eine Qualitätssteigerung mit zunehmendem Maßstab, aber einzeln können die Metriken in Aufgaben:

- allmählich verbessern,

- drastisch verbessern,

- bleiben unverändert,

- verringern,

- keinen Zusammenhang zeigen.

All dies führt dazu, dass es unmöglich ist, die Leistung eines zukünftigen Systems sicher zu extrapolieren. Besonders interessant ist der grüne Teil – genau hier springen die Qualitätsindikatoren grundlos stark in die Höhe.

Lesen Sie mehr über KI:

Haftungsausschluss

Im Einklang mit der Richtlinien des Trust-ProjektsBitte beachten Sie, dass die auf dieser Seite bereitgestellten Informationen nicht als Rechts-, Steuer-, Anlage-, Finanz- oder sonstige Beratung gedacht sind und nicht als solche interpretiert werden sollten. Es ist wichtig, nur so viel zu investieren, wie Sie sich leisten können, zu verlieren, und im Zweifelsfall eine unabhängige Finanzberatung einzuholen. Für weitere Informationen empfehlen wir einen Blick auf die Allgemeinen Geschäftsbedingungen sowie die Hilfe- und Supportseiten des Herausgebers oder Werbetreibenden. MetaversePost ist einer genauen, unvoreingenommenen Berichterstattung verpflichtet, die Marktbedingungen können sich jedoch ohne Vorankündigung ändern.

Über den Autor

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.

Weitere Artikel

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.