Sber AI hat Kandinsky 2.0 vorgestellt, das erste Text-to-Image-Modell zur Generierung in mehr als 100 Sprachen

In Kürze

Kandinsky 2.0, das erste mehrsprachige Diffusionsmodell, wurde von Sber AI-Forschern mit Unterstützung von Forschern des AI Institute of Artificial Intelligence unter Verwendung des kombinierten Datensatzes von 1 Milliarde Text-Bild-Paaren von Sber AI und SberDevices erstellt und trainiert

Diffusion ersetzt zunehmend GANs und autoregressive Modelle in einer Reihe digitaler Bildverarbeitungsaufgaben. Dies ist nicht überraschend, da Diffusion leichter zu erlernen ist, keine komplexe Auswahl von Hyperparametern und Min-Max-Optimierung erfordert und nicht unter Lerninstabilität leidet. Und was am wichtigsten ist: Diffusionsmodelle demonstrieren State-of-the-Art-Ergebnisse für fast alle generativen Aufgaben – Bilderzeugung durch Text, Tonerzeugung, Video und sogar 3D.

Leider konzentrieren sich die meisten Arbeiten im Bereich Text-to-something nur auf Englisch und Chinesisch. Um diese Ungerechtigkeit zu korrigieren, hat Sber AI beschlossen, zu erstellen ein mehrsprachiges Text-zu-Bild-Diffusionsmodell Kandinsky 2.0, das Abfragen in mehr als 100 Sprachen versteht. Umarmendes Gesicht bietet bereits Kandinsky 2.0. Forscher von SberAI und SberDevices haben arbeitete zusammen mit Experten des AI Institute of Artificial Intelligence an diesem Projekt.

Was ist Diffusion?

Im Artikel von 2015 Deep Unsupervised Learning mit Nichtgleichgewichtsthermodynamikwurden Diffusionsmodelle zuerst als Vorgang des Mischens einer Substanz beschrieben, der zu einer Diffusion führt, die die Verteilung ausgleicht. Wie der Titel des Artikels andeutet, näherten sie sich der Erklärung von Diffusionsmodellen durch den Rahmen der Thermodynamik.

Im Fall von Bildern könnte ein solcher Prozess beispielsweise dem allmählichen Entfernen des Gaußschen Rauschens aus dem Bild ähneln.

Das Papier Diffusionsmodelle Schlagen GANs on Image Synthesis, veröffentlicht im Jahr 2021, war das erste, das die Überlegenheit von Diffusionsmodellen gegenüber GANS zeigte. Die Autoren entwickelten auch den Kontrollansatz der ersten Generation (Konditionierung), den sie Klassifikatorführung nannten. Diese Methode erstellt Objekte, die der beabsichtigten Klasse entsprechen, indem sie Farbverläufe von einem anderen Klassifikator (z. B. Hunde) verwendet. Durch den Adaptive Group Norm-Mechanismus, der die Vorhersage von Normalisierungskoeffizienten beinhaltet, wird die Steuerung selbst durchgeführt.

Dieser Artikel kann als Wendepunkt im Bereich der generativen KI angesehen werden, der viele dazu veranlasst, sich dem Studium der Diffusion zuzuwenden. Neue Artikel über Text-zu-Video, Text-zu-3D, Bild einmalen, Audioerzeugung, Diffusion für Superauflösung, und sogar Bewegungserzeugung tauchte alle paar Wochen auf.

Text-zu-Bild-Diffusion

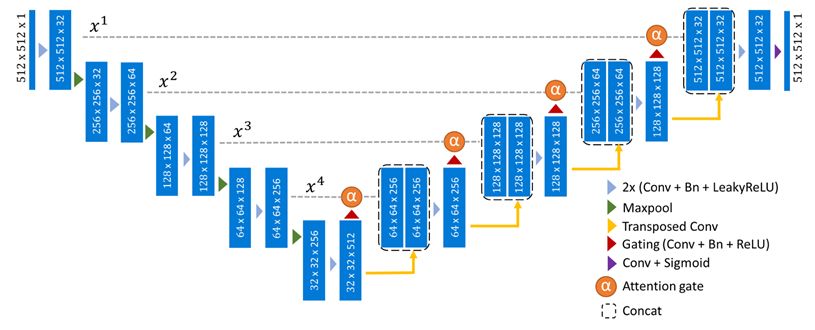

Wie bereits erwähnt, sind Rauschunterdrückung und Rauschunterdrückung typischerweise die Hauptkomponenten von Diffusionsprozessen im Zusammenhang mit Bildmodalitäten, daher werden UNet und seine vielen Variationen häufig als grundlegende Architektur verwendet.

Es ist wichtig, dass dieser Text bei der Generierung in irgendeiner Weise berücksichtigt wird, um darauf basierend ein Bild zu erstellen. Die Autoren der OpenAI In einem Artikel über das GLIDE-Modell wurde vorgeschlagen, den klassifikatorfreien Anleitungsansatz für Text zu ändern.

Der Einsatz von eingefrorenen vorbestrahlten Textcodierern und dem Kaskadenauflösungsverbesserungsmechanismus in der Zukunft erheblich verbesserte Textproduktion (Imagen, ). Es stellte sich heraus, dass es nicht nötig war, den Textteil zu trainieren Text-zu-Bild-Modelle da die Verwendung des eingefrorenen T5-xxl zu einer erheblich verbesserten Bildqualität und Textverständlichkeit führte und viel weniger Schulungsressourcen verbrauchte.

Die Autoren von a Latente Diffusion Artikel zeigte, dass die Bildkomponente eigentlich kein Training erfordert (zumindest nicht vollständig). Das Lernen wird noch schneller voranschreiten, wenn wir einen leistungsfähigen Bild-Autoencoder (VQ-VAE oder KL-VAE) als visuellen Decoder verwenden und versuchen, Einbettungen aus seinem latenten Raum durch Diffusion statt durch das Bild selbst zu erzeugen. Diese Methodik ist auch die Grundlage des kürzlich veröffentlichten Stable Diffusion Modell.

Kandinsky 2.0 KI-Modell

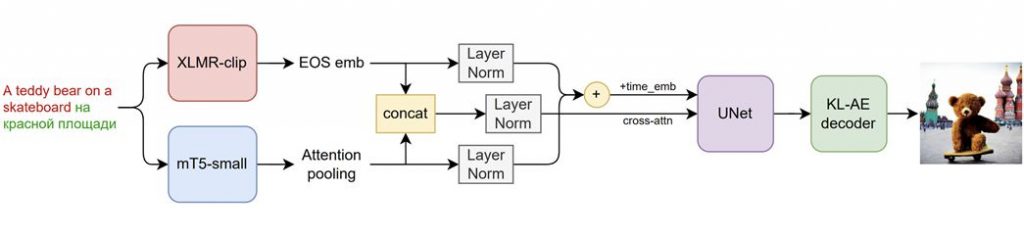

Mit einigen wichtigen Verbesserungen basiert Kandinsky 2.0 auf einer verbesserten Latent-Diffusion-Technik (wir erstellen keine Bilder, sondern deren latente Vektoren):

- Es wurden zwei mehrsprachige Textcodierer eingesetzt und ihre Einbettungen verkettet.

- UNet hinzugefügt (1.2 Milliarden Parameter).

- Dynamisches Schwellwertverfahren des Abtastverfahrens.

Die Forscher verwendeten gleichzeitig zwei mehrsprachige Encoder – XLMR-clip und mT5-small – um die Modell wirklich mehrsprachig. Daher versteht das Modell neben Englisch, Russisch, Französisch und Deutsch auch Sprachen wie Mongolisch, Hebräisch und Farsi. Die KI kennt insgesamt 101 Sprachen. Warum wurde entschieden, Text mit zwei Modellen gleichzeitig zu codieren? Da XLMR-clip Bilder gesehen hat und enge Einbettungen für verschiedene Sprachen bietet und mT5-small in der Lage ist, komplexe Texte zu verstehen, haben diese Modelle unterschiedliche, aber entscheidende Merkmale. Da beide Modelle nur wenige Parameter (560M und 146M) haben, wie unsere Vortests gezeigt haben, entschied man sich für den gleichzeitigen Einsatz von zwei Encodern.

Frisch generierte Bilder von Kandinsky 2.0 AI-Modell unten:

Wie wurde das Modelltraining Kandinsky 2.0 durchgeführt?

Christofari-Supercomputer wurden für das Training auf der ML Space-Plattform verwendet. Es waren 196 NVIDIA A100-Karten mit jeweils 80 GB RAM erforderlich. Es dauerte 14 Tage oder 65,856 GPU-Stunden, um das Training abzuschließen. Die Analyse dauerte fünf Tage bei einer Auflösung von 256 x 256, gefolgt von sechs Tagen bei einer Auflösung von 512 x 512 und dann weitere drei Tage mit den reinsten Daten.

Als Trainingsdaten wurden viele Datensätze kombiniert, die auf Wasserzeichen, niedrige Auflösung und geringe Übereinstimmung mit der Textbeschreibung gemessen durch die CLIP-Score-Metrik vorgefiltert wurden.

Mehrsprachige Generation

Kandinsky 2.0 ist das erste mehrsprachige Modell zur Erstellung von Bildern aus Wörtern und gibt uns die erste Möglichkeit, sprachliche und visuelle Veränderungen über Sprachkulturen hinweg zu bewerten. Die Ergebnisse der Übersetzung derselben Abfrage in mehrere Sprachen sind unten dargestellt. So tauchen in den Generierungsergebnissen für die russische Suchanfrage „eine Person mit höherer Bildung“ nur weiße Männer auf, während die Ergebnisse für die französische Übersetzung „Photo d'une personne diplômée de l'enseignement supérieur“ diversifizierter sind. Ich möchte darauf hinweisen, dass die traurigen Leute mit höherer Bildung nur in der russischsprachigen Ausgabe vorhanden sind.

Obwohl noch eine Menge Versuche mit riesigen Sprachmodellen und verschiedenen Methoden des Verbreitungsprozesses geplant sind, können wir bereits mit Zuversicht sagen, dass Kandinsky 2.0 das erste vollständig mehrsprachige Verbreitungsmodell ist! Auf der FusionBrain-Website und Google Colab, können Sie Beispiele ihrer Zeichnungen sehen.

Lesen Sie mehr über KI:

Haftungsausschluss

Im Einklang mit der Richtlinien des Trust-ProjektsBitte beachten Sie, dass die auf dieser Seite bereitgestellten Informationen nicht als Rechts-, Steuer-, Anlage-, Finanz- oder sonstige Beratung gedacht sind und nicht als solche interpretiert werden sollten. Es ist wichtig, nur so viel zu investieren, wie Sie sich leisten können, zu verlieren, und im Zweifelsfall eine unabhängige Finanzberatung einzuholen. Für weitere Informationen empfehlen wir einen Blick auf die Allgemeinen Geschäftsbedingungen sowie die Hilfe- und Supportseiten des Herausgebers oder Werbetreibenden. MetaversePost ist einer genauen, unvoreingenommenen Berichterstattung verpflichtet, die Marktbedingungen können sich jedoch ohne Vorankündigung ändern.

Über den Autor

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.

Weitere Artikel

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.