Stability AI Stable Diffusion 2 Algorithmus ist endlich öffentlich: neues Depth2IMG-Modell, Super-Resolution-Upscaler, keine Inhalte für Erwachsene

In Kürze

Stable Diffusion Das 2.0-Modell ist schneller, Open Source, skalierbar und robuster als das Vorgängermodell

Stable Diffusion wird GPU-fähig mit neuen Funktionen für Echtzeit-Rendering

Tiefengeführt stable diffusion Modell – Bild-zu-Bild mit neuen Ideen für kreative Anwendungen

Stability AI hat freigegeben ein neues Papier auf seinem Blog über Stable Diffusion 2. Darin, Stability AI schlägt einen neuen Algorithmus vor, der effizienter und robuster als der vorherige ist, und vergleicht ihn gleichzeitig mit anderen hochmodernen Methoden.

Original von CompVis Stable Diffusion V1-Modell revolutioniert die Natur von Open Source KI-Modelle und produzierte Hunderte von verschiedenen Modellen und Fortschritten auf der ganzen Welt. Es verzeichnete einen der schnellsten Anstiege auf 10,000 Github-Sterne und sammelte 33,000 in weniger als zwei Monaten, schneller als mehr Programme auf Github.

Das Original Stable Diffusion Die Veröffentlichung von V1 wurde vom dynamischen Team von Robin Rombach geleitet (Stability AI) und Patrick Esser (Runway ML) von der CompVis-Gruppe der LMU München unter der Leitung von Prof. Dr. Björn Ommer. Sie bauten auf der früheren Arbeit des Labors mit Latent auf Diffusionsmodelle und erhielt kritische Unterstützung von LAION und Eleuther AI.

Was macht Stable Diffusion v1 anders als Stable Diffusion v2?

Stable Diffusion 2.0 enthält eine Reihe bedeutender Verbesserungen und Funktionen gegenüber der vorherigen Version, also werfen wir einen Blick darauf.

Das Stable Diffusion Die Version 2.0 bietet robuste Text-zu-Bild-Modelle, die mit einem neuen Text-Encoder (OpenCLIP) trainiert wurden, der von LAION mit Unterstützung von entwickelt wurde Stability AI, was die Qualität deutlich steigert generierte Bilder gegenüber früheren V1-Versionen. Die Text-zu-Bild-Modelle dieser Version können Bilder mit Standardauflösungen von 512 × 512 Pixel und 768 × 768 Pixel ausgeben.

Diese Modelle werden mithilfe einer ästhetischen Teilmenge des von generierten LAION-5B-Datensatzes trainiert Stability AIDas DeepFloyd-Team wird dann mithilfe des NSFW-Filters von LAION gefiltert, um Inhalte für Erwachsene auszuschließen.

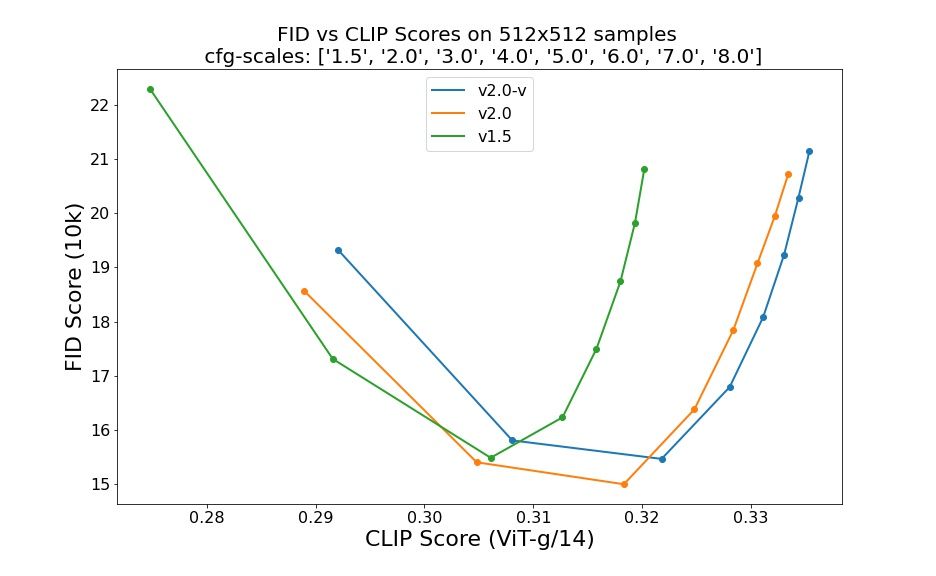

Auswertungen mit 50 DDIM-Stichprobenschritten, 50 klassifikatorfreien Führungsskalen und 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 und 8.0 weisen auf relative Verbesserungen der Prüfpunkte hin:

Stable Diffusion 2.0 enthält jetzt ein Upscaler Diffusion-Modell, das die Bildauflösung um den Faktor vier erhöht. Ein Beispiel unseres Modells Upscaling Unten wird ein generiertes Bild mit geringer Qualität (128×128) in ein Bild mit höherer Auflösung (512×512) gezeigt. Stable Diffusion 2.0 kann nun in Kombination mit unseren Text-to-Image-Modellen Bilder mit Auflösungen von 2048×2048 oder höher erzeugen.

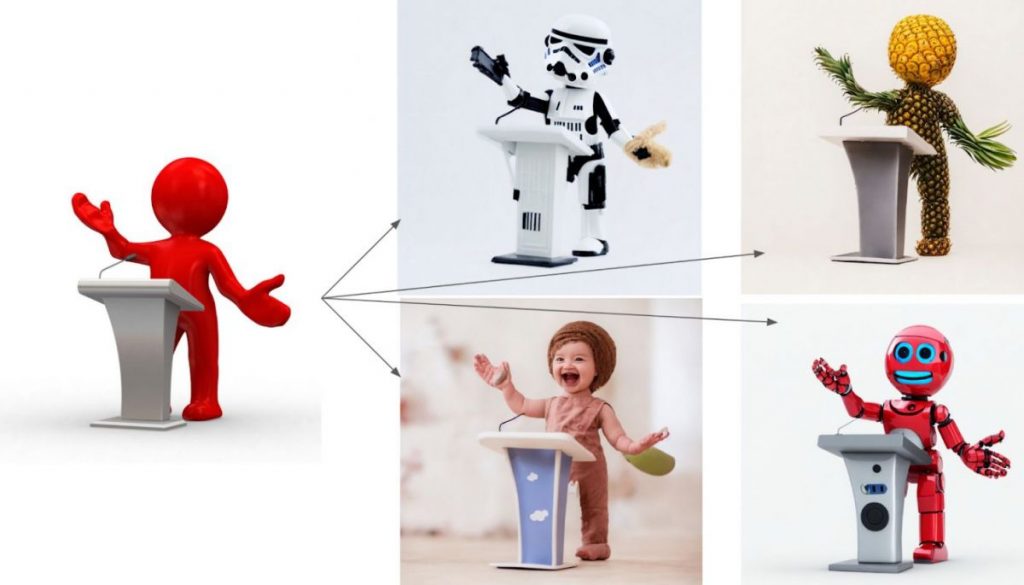

Die neue Tiefenführung stable diffusion Modell, Depth2img, erweitert die vorherige Bild-zu-Bild-Funktion von V1 um völlig neue kreative Möglichkeiten. Depth2img bestimmt die Tiefe eines Eingabebildes (unter Verwendung eines vorhandenen Modells) und generiert dann ein neues Bilder basierend sowohl auf dem Text als auch auf den Tiefeninformationen. Depth-to-Image kann eine Fülle neuer kreativer Anwendungen bieten und Änderungen bieten, die sich deutlich vom Original unterscheiden, während die Kohärenz und Tiefe des Bildes erhalten bleiben.

Was ist neu in Stable Diffusion 2?

- The new stable diffusion Modell bietet eine Auflösung von 768×768.

- Das U-Net hat die gleiche Menge an Parametern wie Version 1.5, aber es wird von Grund auf neu trainiert und verwendet OpenCLIP-ViT/H als seinen Text-Encoder. Ein sogenanntes v-Vorhersagemodell ist SD 2.0-v.

- Das vorgenannte Modell wurde von SD 2.0-Basis angepasst, das ebenfalls zur Verfügung gestellt wird, und wurde als typisches Rauschvorhersagemodell auf 512 × 512-Bildern trainiert.

- Ein latentes textgeführtes Diffusionsmodell mit x4-Skalierung wurde hinzugefügt.

- Raffinierte SD 2.0-Basis tiefengeführt stable diffusion Modell. Das Modell kann für strukturerhaltende img2img- und formbedingte Synthesen verwendet werden und basiert auf von MiDaS abgeleiteten monokularen Tiefenschätzungen.

- Ein verbessertes textgeführtes Inpainting-Modell, das auf der Grundlage von SD 2.0 aufbaut.

Die Entwickler haben hart gearbeitet, genau wie bei der ersten Iteration von Stable Diffusion, um das Modell für die Ausführung auf einer einzelnen GPU zu optimieren – sie wollten es von Anfang an so vielen Menschen wie möglich zugänglich machen. Sie haben bereits gesehen, was passiert, wenn Millionen von Menschen diese Modelle in die Hände bekommen und zusammenarbeiten, um absolut bemerkenswerte Dinge zu bauen. Das ist die Kraft von Open Source: das enorme Potenzial von Millionen talentierter Menschen zu nutzen, die möglicherweise nicht über die Ressourcen verfügen, um ein hochmodernes Modell zu trainieren, aber die Fähigkeit haben, mit einem unglaubliche Dinge zu tun.

Dieses neue Update, kombiniert mit leistungsstarken neuen Funktionen wie deep2img und besseren Auflösungs-Upscaling-Funktionen, wird als Grundlage für eine Fülle neuer Anwendungen dienen und eine Explosion neuen kreativen Potenzials ermöglichen.

Erfahren Sie mehr über Stable Diffusion:

Haftungsausschluss

Im Einklang mit der Richtlinien des Trust-ProjektsBitte beachten Sie, dass die auf dieser Seite bereitgestellten Informationen nicht als Rechts-, Steuer-, Anlage-, Finanz- oder sonstige Beratung gedacht sind und nicht als solche interpretiert werden sollten. Es ist wichtig, nur so viel zu investieren, wie Sie sich leisten können, zu verlieren, und im Zweifelsfall eine unabhängige Finanzberatung einzuholen. Für weitere Informationen empfehlen wir einen Blick auf die Allgemeinen Geschäftsbedingungen sowie die Hilfe- und Supportseiten des Herausgebers oder Werbetreibenden. MetaversePost ist einer genauen, unvoreingenommenen Berichterstattung verpflichtet, die Marktbedingungen können sich jedoch ohne Vorankündigung ändern.

Über den Autor

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.

Weitere Artikel

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.