8 điều bạn nên biết về các mô hình ngôn ngữ lớn

Tóm lại

Mô hình ngôn ngữ lớn (LLM) được sử dụng để khám phá các sắc thái của ngôn ngữ tự nhiên, cải thiện khả năng hiểu và tạo văn bản của máy móc cũng như tự động hóa các tác vụ như nhận dạng giọng nói và dịch máy.

Không có giải pháp dễ dàng nào để quản lý LLM, nhưng họ cũng có khả năng như con người.

Với sự phát triển đột biến của xử lý ngôn ngữ tự nhiên và việc sử dụng nó trong kinh doanh, người ta ngày càng quan tâm đến các mô hình ngôn ngữ lớn. Các mô hình này được sử dụng để khám phá các sắc thái của ngôn ngữ tự nhiên, cải thiện khả năng hiểu và tạo văn bản của máy cũng như tự động hóa các tác vụ như nhận dạng giọng nói và dịch máy. Dưới đây là tám điều cần thiết mà bạn nên biết về các mô hình ngôn ngữ lớn (LLM).

- LLM có nhiều “khả năng” hơn khi chi phí tiếp tục tăng

- Một cái nhìn nhanh về cách GPT mô hình thích ứng khi chi phí đào tạo tăng

- LLM học cách chơi các trò chơi trên bàn bằng cách sử dụng các đại diện của thế giới bên ngoài

- Không có giải pháp dễ dàng để quản lý LLM

- Các chuyên gia gặp khó khăn khi giải thích cách thức hoạt động của LLM

- LLM cũng có khả năng như con người

- LLM không chỉ là "jack-of-all-trades"

- Các mô hình 'thông minh' hơn mọi người nghĩ dựa trên ấn tượng đầu tiên

LLM có nhiều “khả năng” hơn khi chi phí tiếp tục tăng

LLM có thể dự đoán được sẽ trở nên “có khả năng” hơn với chi phí ngày càng tăng, ngay cả khi không có những đổi mới thú vị. Điều chính ở đây là khả năng dự đoán, được thể hiện trong bài viết về GPT-4: năm đến bảy mô hình nhỏ được dạy với ngân sách bằng 0.1% của mô hình cuối cùng, sau đó dự đoán được đưa ra cho một mô hình lớn dựa trên điều này. Để đánh giá chung về sự phức tạp và số liệu trên một mẫu con của một nhiệm vụ cụ thể, dự đoán như vậy là rất chính xác. Khả năng dự đoán này rất quan trọng đối với các doanh nghiệp và tổ chức dựa vào LLM cho các hoạt động của họ, vì họ có thể lập ngân sách phù hợp và lập kế hoạch cho các chi phí trong tương lai. Tuy nhiên, điều quan trọng cần lưu ý là mặc dù việc tăng chi phí có thể dẫn đến khả năng được cải thiện, nhưng tốc độ cải thiện cuối cùng có thể không đổi, do đó cần phải đầu tư vào những cải tiến mới để tiếp tục phát triển.

Một cái nhìn nhanh về cách GPT mô hình thích ứng khi chi phí đào tạo tăng

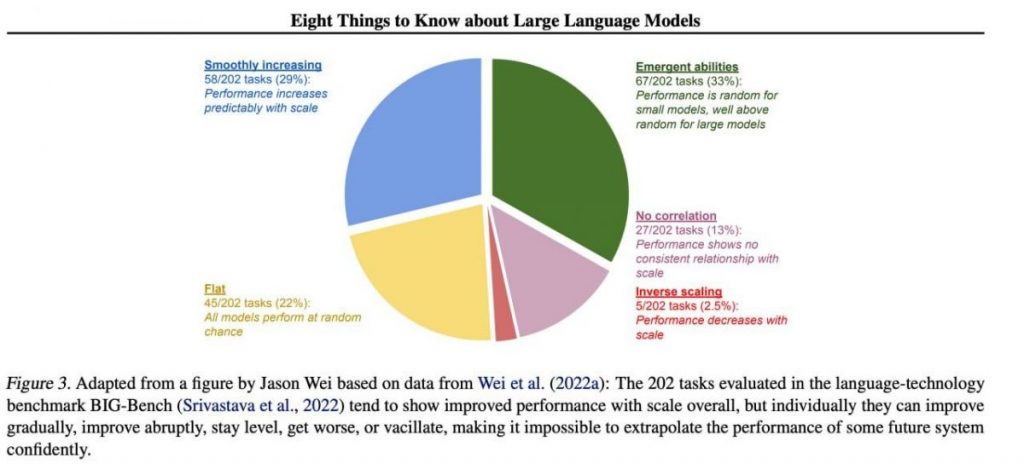

Tuy nhiên, các kỹ năng quan trọng cụ thể có xu hướng nổi lên một cách khó đoán như một sản phẩm phụ của việc gia tăng chi phí đào tạo (đào tạo lâu hơn, nhiều dữ liệu hơn, mô hình lớn hơn) — gần như không thể dự đoán khi nào các mô hình sẽ bắt đầu thực hiện một số tác vụ nhất định. Chúng tôi đã khám phá chủ đề sâu hơn trong bài viết về lịch sử phát triển của GPT các mô hình. Hình ảnh cho thấy sự phân bổ mức tăng chất lượng của các mô hình trong các nhiệm vụ khác nhau. Chỉ những người mẫu lớn mới có thể học cách thực hiện nhiều nhiệm vụ khác nhau. Biểu đồ này nêu bật tác động đáng kể của việc tăng quy mô GPT mô hình về hiệu suất của họ trên các nhiệm vụ khác nhau. Tuy nhiên, điều quan trọng cần lưu ý là điều này phải trả giá bằng việc tăng tài nguyên tính toán và tác động môi trường.

LLM học cách chơi các trò chơi trên bàn bằng cách sử dụng các đại diện của thế giới bên ngoài

LLM thường tìm hiểu và sử dụng các đại diện của thế giới bên ngoài. Có rất nhiều ví dụ ở đây, và đây là một trong số đó: Người mẫu được đào tạo để chơi trò chơi cờ bàn dựa trên mô tả về các nước đi riêng lẻ mà không bao giờ nhìn thấy hình ảnh của sân chơi, hãy tìm hiểu các cách biểu diễn bên trong về trạng thái của bàn cờ ở mỗi nước đi. Những biểu diễn bên trong này sau đó có thể được sử dụng để dự đoán tương lai các bước di chuyển và kết quả, cho phép mô hình chơi trò chơi ở mức cao. Khả năng học hỏi và sử dụng các biểu diễn này là chìa khóa khía cạnh học máy và trí tuệ nhân tạo.

Không có giải pháp dễ dàng để quản lý LLM

Không có phương pháp đáng tin cậy để kiểm soát hành vi LLM. Mặc dù đã có một số tiến bộ trong việc hiểu và giảm thiểu các vấn đề khác nhau (bao gồm ChatGPT và GPT-4 với sự trợ giúp của phản hồi), không có sự đồng thuận về việc liệu chúng ta có thể giải quyết chúng hay không. Ngày càng có nhiều lo ngại rằng điều này sẽ trở thành một vấn đề lớn, có khả năng gây thảm họa trong tương lai khi các hệ thống lớn hơn nữa được tạo ra. Do đó, các nhà nghiên cứu đang khám phá các phương pháp mới để đảm bảo rằng hệ thống AI phù hợp với các giá trị và mục tiêu của con người, chẳng hạn như liên kết giá trị và kỹ thuật khen thưởng. Tuy nhiên, đây vẫn là một nhiệm vụ đầy thách thức để đảm bảo sự an toàn và độ tin cậy của LLM trong các tình huống thực tế phức tạp.

Các chuyên gia gặp khó khăn khi giải thích cách thức hoạt động của LLM

Các chuyên gia chưa thể giải thích hoạt động bên trong của LLM. Không có kỹ thuật nào cho phép chúng ta tuyên bố một cách thỏa đáng những loại kiến thức, lập luận hoặc mục tiêu mà mô hình sử dụng khi nó tạo ra bất kỳ kết quả nào. Việc thiếu khả năng diễn giải này làm dấy lên mối lo ngại về độ tin cậy và tính công bằng của các quyết định của LLM, đặc biệt là trong các ứng dụng có rủi ro cao như tư pháp hình sự hoặc chấm điểm tín dụng. Nó cũng nhấn mạnh sự cần thiết phải nghiên cứu thêm về việc phát triển các mô hình AI minh bạch và có trách nhiệm hơn.

LLM cũng có khả năng như con người

Mặc dù LLM được đào tạo chủ yếu để bắt chước hành vi của con người khi viết văn bản, họ có tiềm năng vượt qua chúng ta trong nhiều nhiệm vụ. Điều này có thể được nhìn thấy khi chơi cờ vua hoặc cờ vây. Điều này là do khả năng phân tích lượng dữ liệu khổng lồ và đưa ra quyết định dựa trên phân tích đó với tốc độ mà con người không thể sánh kịp. Tuy nhiên, LLM vẫn thiếu khả năng sáng tạo và trực giác mà con người sở hữu, khiến chúng ít phù hợp với nhiều nhiệm vụ.

LLM không chỉ là "jack-of-all-trades"

LLM không được thể hiện các giá trị của người tạo ra chúng hoặc các giá trị được mã hóa trong một lựa chọn từ Internet. Họ không nên lặp lại những định kiến, thuyết âm mưu hoặc tìm cách xúc phạm bất kỳ ai. Thay vào đó, các LLM nên được thiết kế để cung cấp thông tin thực tế và không thiên vị cho người dùng của họ đồng thời tôn trọng sự khác biệt về văn hóa và xã hội. Ngoài ra, họ nên trải qua kiểm tra và giám sát thường xuyên để đảm bảo họ tiếp tục đáp ứng các tiêu chuẩn này.

Các mô hình 'thông minh' hơn mọi người nghĩ dựa trên ấn tượng đầu tiên

Ước tính về khả năng của một mô hình dựa trên ấn tượng đầu tiên thường gây hiểu nhầm. Rất thường xuyên, bạn cần đưa ra lời nhắc phù hợp, đề xuất một mô hình và có thể đưa ra các ví dụ, và nó sẽ bắt đầu xử lý tốt hơn nhiều. Đó là, nó "thông minh" hơn so với cái nhìn đầu tiên. Do đó, điều quan trọng là phải tạo cơ hội công bằng cho mô hình và cung cấp cho mô hình các nguồn lực cần thiết để hoạt động tốt nhất. Với cách tiếp cận phù hợp, ngay cả những mô hình dường như không phù hợp cũng có thể khiến chúng ta ngạc nhiên về khả năng của chúng.

Nếu chúng ta tập trung vào một mẫu gồm 202 nhiệm vụ từ tập dữ liệu BIG-Bench (việc kiểm tra đặc biệt khó khăn mô hình ngôn ngữ từ và đến), thì theo quy luật (trung bình), các mô hình cho thấy sự gia tăng về chất lượng khi quy mô ngày càng tăng, nhưng riêng lẻ, các chỉ số trong nhiệm vụ có thể:

- cải thiện dần dần,

- cải thiện mạnh mẽ,

- không thay đổi,

- giảm bớt,

- không cho thấy mối tương quan.

Tất cả điều này dẫn đến việc không thể tự tin ngoại suy hiệu suất của bất kỳ hệ thống nào trong tương lai. Phần màu xanh lá cây đặc biệt thú vị — đây chính xác là nơi các chỉ số chất lượng tăng vọt mà không có lý do gì cả.

Đọc thêm về AI:

Từ chối trách nhiệm

Phù hợp với Hướng dẫn của Dự án Tin cậy, xin lưu ý rằng thông tin được cung cấp trên trang này không nhằm mục đích và không được hiểu là tư vấn pháp lý, thuế, đầu tư, tài chính hoặc bất kỳ hình thức tư vấn nào khác. Điều quan trọng là chỉ đầu tư những gì bạn có thể đủ khả năng để mất và tìm kiếm lời khuyên tài chính độc lập nếu bạn có bất kỳ nghi ngờ nào. Để biết thêm thông tin, chúng tôi khuyên bạn nên tham khảo các điều khoản và điều kiện cũng như các trang trợ giúp và hỗ trợ do nhà phát hành hoặc nhà quảng cáo cung cấp. MetaversePost cam kết báo cáo chính xác, không thiên vị nhưng điều kiện thị trường có thể thay đổi mà không cần thông báo trước.

Giới thiệu về Tác giả

Damir là trưởng nhóm, quản lý sản phẩm và biên tập viên tại Metaverse Post, bao gồm các chủ đề như AI/ML, AGI, LLMs, Metaverse và Web3-các lĩnh vực liên quan. Các bài báo của anh ấy thu hút một lượng lớn độc giả với hơn một triệu người dùng mỗi tháng. Anh ấy có vẻ là một chuyên gia với 10 năm kinh nghiệm về SEO và tiếp thị kỹ thuật số. Damir đã được đề cập trong Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto và các ấn phẩm khác. Anh đi lại giữa Các Tiểu vương quốc Ả Rập Thống nhất, Thổ Nhĩ Kỳ, Nga và CIS với tư cách là một người du mục kỹ thuật số. Damir đã có bằng cử nhân vật lý, bằng cấp mà anh tin rằng đã mang lại cho anh những kỹ năng tư duy phản biện cần thiết để thành công trong bối cảnh luôn thay đổi của Internet.

Xem thêm bài viết

Damir là trưởng nhóm, quản lý sản phẩm và biên tập viên tại Metaverse Post, bao gồm các chủ đề như AI/ML, AGI, LLMs, Metaverse và Web3-các lĩnh vực liên quan. Các bài báo của anh ấy thu hút một lượng lớn độc giả với hơn một triệu người dùng mỗi tháng. Anh ấy có vẻ là một chuyên gia với 10 năm kinh nghiệm về SEO và tiếp thị kỹ thuật số. Damir đã được đề cập trong Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto và các ấn phẩm khác. Anh đi lại giữa Các Tiểu vương quốc Ả Rập Thống nhất, Thổ Nhĩ Kỳ, Nga và CIS với tư cách là một người du mục kỹ thuật số. Damir đã có bằng cử nhân vật lý, bằng cấp mà anh tin rằng đã mang lại cho anh những kỹ năng tư duy phản biện cần thiết để thành công trong bối cảnh luôn thay đổi của Internet.