Die 10 besten Grafikkarten für ML/KI: Top-GPU für Deep Learning

Die Auswahl einer geeigneten Grafikkarte spielt eine entscheidende Rolle für die optimale Leistung bei der Verarbeitung großer Datenmengen und der Durchführung paralleler Berechnungen. Insbesondere bei Aufgaben, die ein tiefes Training neuronaler Netze beinhalten, ist der Bedarf an intensiver Matrix- und Tensorverarbeitung von größter Bedeutung. Es ist erwähnenswert, dass spezialisierte KI-Chips, TPUs und FPGAs in letzter Zeit erheblich an Popularität gewonnen haben.

Hauptmerkmale von Grafikkarten für maschinelles Lernen

Wenn man eine Grafikkarte für maschinelle Lernzwecke in Betracht zieht, sollten mehrere wesentliche Merkmale berücksichtigt werden:

- Rechenleistung:

Die Anzahl der Kerne oder Prozessoren wirkt sich direkt auf die Parallelverarbeitungsfähigkeiten der Grafikkarte aus. Eine höhere Kernanzahl führt zu schnelleren und effizienteren Berechnungen. - GPU-Speicherkapazität:

Ausreichend Speicherkapazität ist für die effektive Verarbeitung großer Datensätze und komplexer Modelle von entscheidender Bedeutung. Die Fähigkeit, Daten effizient zu speichern und darauf zuzugreifen, ist für die Erzielung einer optimalen Leistung von entscheidender Bedeutung. - Unterstützung für Fachbibliotheken:

Die Hardwarekompatibilität mit spezialisierten Bibliotheken wie CUDA oder ROCm kann die Modellierung erheblich beschleunigen Trainingsprozesse. Durch die Nutzung hardwarespezifischer Optimierungen werden Berechnungen optimiert und die Gesamteffizienz verbessert. - Hochleistungsunterstützung:

Grafikkarten mit schnellem Speicher und breiten Speicherbuskonfigurationen bieten leistungsstarke Funktionen beim Modelltraining. Diese Funktionen sorgen für eine reibungslose und schnelle Datenverarbeitung. - Kompatibilität mit Frameworks für maschinelles Lernen:

Es ist wichtig, eine nahtlose Kompatibilität zwischen der ausgewählten Grafikkarte und den verwendeten Frameworks für maschinelles Lernen und Entwicklertools sicherzustellen. Die Kompatibilität garantiert eine reibungslose Integration und optimale Ressourcennutzung.

Vergleichstabelle der Grafikkarten für ML/AI

| Grafikkarte | Speicher, GB | CUDA-Kerne | Tensorkerne | Preis (USD |

|---|---|---|---|---|

| Tesla V100 | 16/32 | 5120 | 640 | 14,999 |

| Tesla A100 | 40/80 | 7936 | 432 | 10,499 |

| Quadro RTX8000 | 48 | 4608 | 576 | 7,999 |

| Ein 6000 Ada | 48 | 18176 | 568 | 6,499 |

| RTX A 5000 | 24 | 8192 | 256 | 1,899 |

| RTX 3090 Ti | 24 | 10752 | 336 | 1,799 |

| RTX 4090 | 24 | 16384 | 512 | 1,499 |

| RTX 3080 Ti | 12 | 10240 | 320 | 1,399 |

| RTX 4080 | 16 | 9728 | 304 | 1,099 |

| RTX 4070 | 12 | 7680 | 184 | 599 |

NVIDIA Tesla V100

NVIDIAs Tesla V100 ist eine leistungsstarke Tensor-Core-GPU, die auf KI, High Performance Computing (HPC) und maschinelles Lernen zugeschnitten ist. Diese Grafikkarte nutzt die hochmoderne Volta-Architektur und bietet herausragende Leistungsfähigkeiten, die eine beeindruckende Leistung von 125 Billionen Gleitkommaoperationen pro Sekunde (TFLOPS) liefern. In diesem Artikel werden wir die bemerkenswerten Vorteile und Überlegungen untersuchen, die mit dem Tesla V100 verbunden sind.

Vorteile von Tesla V100:

- Hochleistung:

Der Tesla V5120 nutzt die Leistung der Volta-Architektur und seiner 100 CUDA-Kerne und bietet außergewöhnliche Leistung für maschinelle Lernaufgaben. Seine Fähigkeit, umfangreiche Datensätze zu verarbeiten und komplexe Berechnungen mit bemerkenswerter Geschwindigkeit auszuführen, ist entscheidend für effiziente Arbeitsabläufe beim maschinellen Lernen. - Große Speicherkapazität:

Mit 16 GB HBM2-Speicher ermöglicht der Tesla V100 die effiziente Verarbeitung großer Datenmengen während des Modelltrainings. Dieses Attribut ist besonders bei der Arbeit mit umfangreichen Datensätzen von Vorteil und ermöglicht eine nahtlose Datenbearbeitung. Darüber hinaus ermöglicht die Breite des Videospeicherbusses von 4096 Bit eine Hochgeschwindigkeits-Datenübertragung zwischen Prozessor und Videospeicher, wodurch die Leistung des Modelltrainings und der Inferenz für maschinelles Lernen weiter verbessert wird. - Deep-Learning-Technologien:

Der Tesla V100 ist mit verschiedenen Deep-Learning-Technologien ausgestattet, darunter Tensor Cores, die Gleitkommaberechnungen beschleunigen. Diese Beschleunigung trägt zu einer erheblichen Verkürzung der Modelltrainingszeit bei und verbessert letztendlich die Gesamtleistung. - Flexibilität und Skalierbarkeit:

Die Vielseitigkeit des Tesla V100 zeigt sich in seiner Kompatibilität sowohl mit Desktop- als auch mit Serversystemen. Es lässt sich nahtlos in eine Vielzahl von Frameworks für maschinelles Lernen wie TensorFlow, PyTorch, Caffe und mehr integrieren und bietet Entwicklern die Freiheit, ihre bevorzugten Tools für die Modellentwicklung und das Training auszuwählen.

Überlegungen zum Tesla V100:

- Hohe Kosten:

Als professionelle Lösung trägt der NVIDIA Tesla V100 einen entsprechenden Preis. Mit einem Preis von 14,447 US-Dollar kann es für Einzelpersonen oder kleine Teams für maschinelles Lernen eine erhebliche Investition darstellen. Die Preisgestaltung sollte bei der Betrachtung des Gesamtbudgets und der Anforderungen berücksichtigt werden. - Stromverbrauch und Kühlung:

Angesichts der robusten Leistung des Tesla V100 benötigt er eine erhebliche Stromversorgung und erzeugt erhebliche Wärme. Um optimale Betriebstemperaturen aufrechtzuerhalten, müssen angemessene Kühlmaßnahmen umgesetzt werden, was zu einem erhöhten Energieverbrauch und den damit verbundenen Kosten führen kann. - Infrastrukturanforderungen:

Um die Fähigkeiten des Tesla V100 voll auszuschöpfen, ist eine kompatible Infrastruktur erforderlich. Dazu gehören ein leistungsstarker Prozessor und ausreichend RAM, um eine effiziente Arbeit zu gewährleisten Datenverarbeitung und Modelltraining.

Fazit:

Der NVIDIA A100, der auf der hochmodernen Ampere-Architektur basiert, stellt einen bedeutenden Fortschritt in der GPU-Technologie für Anwendungen des maschinellen Lernens dar. Mit seinen Hochleistungsfähigkeiten, der großen Speicherkapazität und der Unterstützung der NVLink-Technologie unterstützt der A100 Datenwissenschaftler und Forscher können komplexe Aufgaben des maschinellen Lernens bewältigen mit Effizienz und Präzision. Allerdings sollten die hohen Kosten, der Stromverbrauch und die Softwarekompatibilität vor der Einführung der NVIDIA A100 sorgfältig geprüft werden. Mit seinen Fortschritten und Durchbrüchen eröffnet der A100 neue Möglichkeiten für beschleunigtes Modelltraining und Inferenz und ebnet den Weg für weitere Fortschritte im Bereich des maschinellen Lernens.

NVIDIA Tesla A100

Die NVIDIA A100, die auf der hochmodernen Ampere-Architektur basiert, ist eine bemerkenswerte Grafikkarte, die speziell für die Anforderungen maschineller Lernaufgaben entwickelt wurde. Der A100 bietet außergewöhnliche Leistung und Flexibilität und stellt einen bedeutenden Fortschritt in der GPU-Technologie dar. In diesem Artikel werden wir die bemerkenswerten Vorteile und Überlegungen im Zusammenhang mit der NVIDIA A100 untersuchen.

Vorteile von NVIDIA A100:

- Hochleistung:

Ausgestattet mit einer beträchtlichen Anzahl von CUDA-Kernen (4608) bietet der NVIDIA A100 beeindruckende Leistungsfähigkeiten. Seine verbesserte Rechenleistung ermöglicht beschleunigte Arbeitsabläufe beim maschinellen Lernen, was zu schnelleren Modelltrainings- und Inferenzprozessen führt. - Große Speicherkapazität:

Die NVIDIA A100-Grafikkarte verfügt über 40 GB HBM2-Speicher und ermöglicht so die effiziente Verarbeitung großer Datenmengen Deep-Learning-Modelltraining. Diese große Speicherkapazität ist insbesondere bei der Arbeit mit komplexen und großen Datensätzen von Vorteil und ermöglicht eine reibungslose und nahtlose Datenverarbeitung. - Unterstützung für NVLink-Technologie:

Durch die Einbeziehung der NVLink-Technologie können mehrere NVIDIA A100-Grafikkarten nahtlos in einem einzigen System kombiniert werden, was paralleles Rechnen erleichtert. Diese verbesserte Parallelität verbessert die Leistung erheblich, beschleunigt das Modelltraining und trägt so zu effizienteren Arbeitsabläufen beim maschinellen Lernen bei.

Überlegungen zu NVIDIA A100:

- Hohe Kosten:

Als eine der leistungsstärksten und fortschrittlichsten Grafikkarten auf dem Markt ist die NVIDIA A100 zu einem höheren Preis erhältlich. Mit einem Preis von 10,000 US-Dollar kann es für Einzelpersonen oder Organisationen, die seine Einführung in Betracht ziehen, eine erhebliche Investition sein. - Leistungsaufnahme:

Um das volle Potenzial der NVIDIA A100-Grafikkarte nutzen zu können, ist eine erhebliche Stromversorgung erforderlich. Dies kann zu einem erhöhten Energieverbrauch führen und erfordert geeignete Maßnahmen zur Energieverwaltung, insbesondere beim Einsatz der Karte in großem Maßstab Rechenzentren. - Software-Kompatibilität:

Um eine optimale Leistung zu gewährleisten, ist die NVIDIA A100 auf entsprechende Software und Treiber angewiesen. Es ist wichtig zu beachten, dass einige Programme und Frameworks für maschinelles Lernen dieses spezielle Grafikkartenmodell möglicherweise nicht vollständig unterstützen. Bei der Integration der NVIDIA A100 in bestehende Machine-Learning-Workflows sollten Kompatibilitätsaspekte berücksichtigt werden.

Fazit:

Der Tesla V100 ist mit seiner Volta-Architektur und seinen hochmodernen Funktionen eine beeindruckende Tensor-Core-GPU, die für KI-, HPC- und maschinelle Lernaufgaben entwickelt wurde. Seine leistungsstarken Fähigkeiten, die große Speicherkapazität, Deep-Learning-Technologien und seine Flexibilität machen es zu einer überzeugenden Wahl für Organisationen und Forscher, die fortgeschrittene maschinelle Lernprojekte verfolgen. Allerdings müssen Überlegungen wie Kosten, Stromverbrauch und Infrastrukturanforderungen sorgfältig geprüft werden, um eine gut abgestimmte Investition sicherzustellen. Mit dem Tesla V100 ist das Potenzial für Durchbrüche in den Bereichen KI und maschinelles Lernen in greifbarer Nähe und stärkt die Leistungsfähigkeit Datenwissenschaftler und Forscher, um die Grenzen der Innovation zu verschieben.

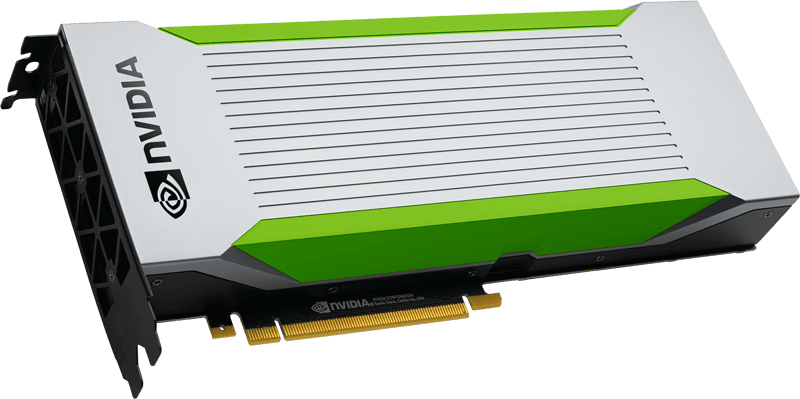

NVIDIA Quadro RTX 8000

Die Quadro RTX 8000 ist eine leistungsstarke Grafikkarte, die speziell für Profis entwickelt wurde, die außergewöhnliche Rendering-Fähigkeiten benötigen. Mit seinen erweiterten Funktionen und leistungsstarken Spezifikationen bietet diese Grafikkarte praktische Vorteile für verschiedene Anwendungen, einschließlich Datenvisualisierung, Computergrafik und maschinelles Lernen. In diesem Artikel werden wir die Unterscheidungsmerkmale und Vorteile der Quadro RTX 8000 untersuchen.

Vorteile der Quadro RTX 8000:

- Hochleistung:

Die Quadro RTX 8000 verfügt über eine leistungsstarke GPU und beeindruckende 5120 CUDA-Kerne und bietet beispiellose Leistung für anspruchsvolle Rendering-Aufgaben. Seine außergewöhnliche Rechenleistung ermöglicht es Profis, komplexe Modelle mit realistischen Schatten, Reflexionen und Brechungen zu rendern und so realistische und realistische Ergebnisse zu liefern immersive visuelle Erlebnisse. - Raytracing-Unterstützung:

Hardwarebeschleunigtes Raytracing ist eine herausragende Funktion der Quadro RTX 8000. Diese Technologie ermöglicht die Erstellung von fotorealistische Bilder und realistische Lichteffekte. Für Profis, die sich mit Datenvisualisierung, Computergrafik oder maschinellem Lernen beschäftigen, verleiht diese Funktion ihrer Arbeit ein gewisses Maß an Realismus und visueller Wiedergabetreue und verbessert so die Gesamtqualität ihrer Projekte. - Große Speicherkapazität:

Die Quadro RTX 8000 bietet satte 48 GB GDDR6-Grafikspeicher. Diese große Speicherkapazität ermöglicht eine effiziente Arbeit Speicherung und Abruf von Daten, insbesondere bei der Arbeit mit umfangreichen Modellen und Datensätzen für maschinelles Lernen. Profis können komplexe Berechnungen durchführen und große Datenmengen verarbeiten, ohne dass die Leistung oder Effizienz darunter leidet. - Bibliotheks- und Framework-Unterstützung:

Die Kompatibilität mit gängigen Bibliotheken und Frameworks für maschinelles Lernen, darunter TensorFlow, PyTorch, CUDA, cuDNN und mehr, gewährleistet eine nahtlose Integration in bestehende Arbeitsabläufe. Profis können die Leistung der Quadro RTX 8000 mit ihren bevorzugten Tools und Frameworks nutzen und so eine effiziente Entwicklung und Schulung von Modellen für maschinelles Lernen ermöglichen.

Überlegungen zur Quadro RTX 8000:

- Hohe Kosten:

Als professioneller Grafikbeschleuniger ist die Quadro RTX 8000 im Vergleich zu anderen Grafikkarten teurer. Die tatsächlichen Kosten belaufen sich auf 8,200 US-Dollar, wodurch es für einzelne Benutzer oder kleine Betriebe möglicherweise weniger zugänglich ist.

Fazit:

Die Quadro RTX 8000 setzt einen Maßstab für leistungsstarke Grafikwiedergabe in professionellen Anwendungen. Mit seiner leistungsstarken GPU, Raytracing-Unterstützung, großer Speicherkapazität und Kompatibilität mit gängigen Bibliotheken und Frameworks für maschinelles Lernen ermöglicht die Quadro RTX 8000 Profis die Erstellung visuell beeindruckender und realistischer Modelle, Visualisierungen und Simulationen. Während die höheren Kosten für manche eine Herausforderung darstellen, machen die Vorteile dieser Grafikkarte sie zu einem wertvollen Vorteil für Profis, die erstklassige Leistung und Speicherkapazität benötigen. Mit der Quadro RTX 8000 können Profis ihr kreatives Potenzial entfalten und die Grenzen ihrer Arbeit in den Bereichen Datenvisualisierung, Computergrafik und maschinelles Lernen erweitern.

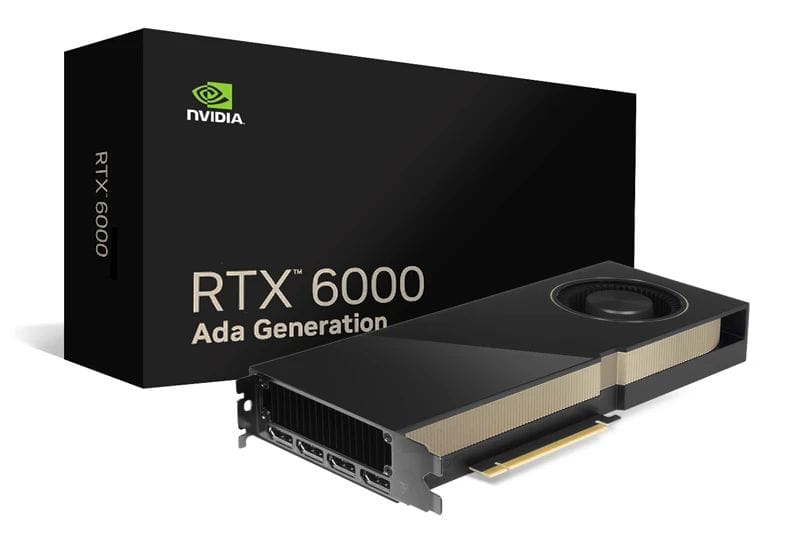

NVIDIA RTX A6000 Ada

Die RTX A6000 Ada-Grafikkarte ist eine überzeugende Option für Profis, die eine leistungsstarke und dennoch energieeffiziente Lösung suchen. Mit seinen erweiterten Funktionen, einschließlich der Ada Lovelace-Architektur, leistungsstarken CUDA-Kernen und reichlich VRAM-Kapazität, bietet der RTX A6000 Ada praktische Vorteile für eine Vielzahl professioneller Anwendungen. In diesem Artikel werden wir die Unterscheidungsmerkmale und Vorteile des RTX A6000 Ada untersuchen.

Vorteile von RTX A6000 Ada:

- Hochleistung:

Der RTX A6000 Ada nutzt die Leistung der Ada Lovelace-Architektur und integriert RT-Kerne der dritten Generation, Tensor-Kerne der vierten Generation und CUDA-Kerne der nächsten Generation. Diese Fortschritte in der Architektur tragen zu einer herausragenden Leistung bei und ermöglichen es Profis, anspruchsvolle Aufgaben problemlos zu bewältigen. Mit 48 GB VRAM bietet die Grafikkarte ausreichend Speicher für die effiziente Verarbeitung großer Datensätze während des Modelltrainings. - Große Speicherkapazität:

Ausgestattet mit 48 GB Arbeitsspeicher sorgt die RTX A6000 Ada für eine effiziente Verarbeitung großer Datenmengen. Diese umfangreiche Speicherkapazität ermöglicht es Fachleuten, komplexe Modelle für maschinelles Lernen zu trainieren und mit riesigen Datensätzen zu arbeiten, ohne Kompromisse bei Leistung oder Effizienz einzugehen. Die Fähigkeit, umfangreiche Datenlasten zu bewältigen, trägt zu einem schnelleren und genaueren Modelltraining bei. - Energieeffizient:

Der RTX A6000 Ada legt Wert auf Energieeffizienz und ist daher die ideale Wahl für Profis, die auf den Stromverbrauch achten. Durch die Optimierung des Stromverbrauchs senkt diese Grafikkarte die Energiekosten und trägt zu einer nachhaltigeren und kostengünstigeren Arbeitsumgebung bei.

Überlegungen zur RTX A6000 Ada:

- Hohe Kosten:

Der RTX A6000 Ada mit seiner beeindruckenden Leistung und Ausstattung ist allerdings zu einem höheren Preis erhältlich. Mit einem Preis von ca. 6,800 US-Dollar kann diese Grafikkarte eine erhebliche Investition für einzelne Benutzer oder kleinere Organisationen darstellen. Die überlegene Leistung und Effizienz rechtfertigen jedoch seinen Wert für Profis, die optimale Ergebnisse erzielen möchten.

Fazit:

Die RTX A6000 Ada erweist sich als hervorragende Grafikkartenwahl für Profis, die Leistung und Effizienz maximieren möchten. Mit ihrer fortschrittlichen Architektur, der beträchtlichen VRAM-Kapazität und dem geringen Stromverbrauch liefert diese Grafikkarte außergewöhnliche Ergebnisse bei einer Reihe professioneller Anwendungen. Die Ada Lovelace-Architektur sorgt in Verbindung mit CUDA-Kernen der nächsten Generation und hoher Speicherkapazität für Hochleistungsrechnen und eine effiziente Verarbeitung großer Datenmengen. Obwohl die RTX A6000 Ada mit höheren Kosten verbunden ist, machen sie ihre Vorteile und Fähigkeiten zu einem wertvollen Aktivposten für Profis, die bei ihrer Arbeit optimale Ergebnisse erzielen möchten. Mit der RTX A6000 Ada können Profis ihr volles Potenzial ausschöpfen und ihre Leistung in verschiedenen Bereichen steigern, darunter maschinelles Lernen, Datenanalyse und Computergrafik.

Nvidia RTX A5000

Die auf der NVIDIA Ampere-Architektur basierende RTX A5000 entpuppt sich als leistungsstarke Grafikkarte, die darauf ausgelegt ist, maschinelle Lernaufgaben zu beschleunigen. Mit seinen robusten Funktionen und Hochleistungsfähigkeiten bietet der RTX A5000 praktische Vorteile und deutliche Vorteile für Profis auf diesem Gebiet. In diesem Artikel werden wir uns mit den Unterscheidungsmerkmalen des RTX A5000 und seinen möglichen Auswirkungen auf Anwendungen des maschinellen Lernens befassen.

Vorteile von RTX A5000:

- Hochleistung:

Ausgestattet mit 8192 CUDA-Kernen und 256 Tensorkernen verfügt der RTX A5000 über eine außergewöhnliche Rechenleistung. Diese Hochleistungsarchitektur ermöglicht die schnelle und effiziente Verarbeitung großer Datensätze und ermöglicht so ein schnelleres Training von Modellen für maschinelles Lernen. Die Fülle an CUDA-Kernen und die hohe Speicherbandbreite tragen zu reibungslosen und beschleunigten Berechnungen bei und erleichtern komplexe Vorgänge in Arbeitsabläufen des maschinellen Lernens. - Unterstützung der KI-Hardwarebeschleunigung:

Die RTX A5000-Grafikkarte bietet Hardwarebeschleunigung für KI-bezogene Vorgänge und Algorithmen. Durch ihr optimiertes Design kann die Karte die Leistung von KI-Aufgaben erheblich steigern und schnellere und effizientere Ergebnisse liefern. Durch die Nutzung der Leistungsfähigkeit der dedizierten KI-Hardwarebeschleunigung können Fachleute ihre Arbeitsabläufe für maschinelles Lernen optimieren und eine höhere Produktivität erzielen. - Große Speicherkapazität:

Mit 24 GB GDDR6-VRAM bietet der RTX A5000 ausreichend Speicher für die Verarbeitung großer Datensätze und komplexer Modelle für maschinelles Lernen. Diese umfangreiche Speicherkapazität ermöglicht es Profis, mit datenintensiven Aufgaben zu arbeiten, ohne Kompromisse bei Leistung oder Effizienz einzugehen. Die Verfügbarkeit von reichlich VRAM sorgt für einen reibungslosen Datenzugriff und ein schnelleres Training und ermöglicht so eine genauere und umfassendere Modellentwicklung. - Unterstützung des Machine Learning Frameworks:

Der RTX A5000 lässt sich nahtlos in gängige Frameworks für maschinelles Lernen wie TensorFlow und PyTorch integrieren. Mit ihren optimierten Treibern und Bibliotheken ermöglicht die Grafikkarte Entwicklern und Forschern, die Fähigkeiten dieser Frameworks voll auszuschöpfen. Diese Kompatibilität gewährleistet eine effiziente Nutzung der Ressourcen des RTX A5000 und ermöglicht es Fachleuten, Modelle für maschinelles Lernen problemlos zu entwickeln und zu trainieren.

Überlegungen zur RTX A5000:

- Stromverbrauch und Kühlung:

Es ist wichtig zu beachten, dass Grafikkarten dieses Kalibers typischerweise viel Strom verbrauchen und während des Betriebs erhebliche Wärme erzeugen. Um optimale Leistung und Langlebigkeit zu gewährleisten, müssen geeignete Kühlmaßnahmen und eine ausreichende Stromversorgungskapazität vorhanden sein. Diese Vorsichtsmaßnahmen garantieren den effizienten und zuverlässigen Einsatz der RTX A5000 in anspruchsvollen maschinellen Lernumgebungen.

Fazit:

Die RTX A5000 zeichnet sich als leistungsstarke Grafikkarte aus, die auf die anspruchsvollen Anforderungen von Machine-Learning-Profis zugeschnitten ist. Mit seinen erweiterten Funktionen, darunter einer hohen Anzahl an CUDA-Kernen, Unterstützung für KI-Hardwarebeschleunigung und umfangreicher Speicherkapazität, bietet der RTX A5000 außergewöhnliche Leistung für die Verarbeitung großer Datenmengen und das Training komplexer Modelle. Die nahtlose Integration in gängige Frameworks für maschinelles Lernen verbessert die Benutzerfreundlichkeit und Vielseitigkeit zusätzlich. Während Überlegungen wie Stromverbrauch und Kühlung von entscheidender Bedeutung sind, können die richtige Infrastruktur und Vorsichtsmaßnahmen die effektive Nutzung der Fähigkeiten des RTX A5000 sicherstellen. Mit der RTX A5000 können Profis neue Möglichkeiten des maschinellen Lernens erschließen und ihre Forschung, Entwicklung und den Einsatz innovativer Modelle vorantreiben.

NVIDIA RTX 4090

Die NVIDIA RTX 4090-Grafikkarte erweist sich als leistungsstarke Lösung, die auf die Anforderungen der neuesten Generation zugeschnitten ist Neuronale Netze. Mit seiner herausragenden Leistung und den erweiterten Funktionen bietet der RTX 4090 praktische Vorteile und zeichnet sich als zuverlässige Option für Profis auf diesem Gebiet aus. In diesem Artikel werden wir die wichtigsten Funktionen des RTX 4090 und seine möglichen Auswirkungen auf die Beschleunigung von Modellen für maschinelles Lernen untersuchen.

Vorteile der NVIDIA RTX 4090:

- Großartige Vorführung:

Ausgestattet mit modernster Technologie liefert die NVIDIA RTX 4090 eine außergewöhnliche Leistung, die eine effiziente Bearbeitung komplexer Berechnungen und großer Datensätze ermöglicht. Die Grafikkarte nutzt ihre leistungsstarke Architektur, um das Training von Modellen für maschinelles Lernen zu beschleunigen und so schnellere und genauere Ergebnisse zu ermöglichen. Dank der leistungsstarken Funktionen des RTX 4090 können Profis anspruchsvolle Aufgaben bewältigen und die Produktivität ihrer neuronalen Netzwerkprojekte steigern.

Überlegungen zur NVIDIA RTX 4090:

- Kühlungsherausforderungen:

Die starke Hitzeentwicklung der NVIDIA RTX 4090 kann bei der Kühlung zu Herausforderungen führen. Aufgrund der hohen Leistungsfähigkeit der Karte ist es wichtig, sicherzustellen, dass ausreichende Kühlmaßnahmen vorhanden sind, um eine Überhitzung zu verhindern. Benutzer sollten sich darüber im Klaren sein, dass in Konfigurationen mit mehreren Karten die Anforderungen an die Wärmeableitung noch wichtiger werden, um eine optimale Leistung aufrechtzuerhalten und automatische Abschaltungen durch das Erreichen kritischer Temperaturen zu verhindern. - Konfigurationseinschränkungen:

Das GPU-Design der NVIDIA RTX 4090 erlegt bestimmte Einschränkungen hinsichtlich der Anzahl der Karten auf, die in einer Workstation installiert werden können. Diese Einschränkung kann Benutzer betreffen, die für ihre Projekte mehrere RTX 4090-Karten benötigen. Um eine optimale Nutzung der Fähigkeiten der RTX 4090 sicherzustellen, ist eine sorgfältige Prüfung der Konfiguration und Kompatibilität der Workstation erforderlich.

Fazit:

Die NVIDIA RTX 4090-Grafikkarte ist eine leistungsstarke Wahl für Profis, die die neueste Generation neuronaler Netze betreiben möchten. Mit seiner herausragenden Leistung und der effizienten Handhabung komplexer Berechnungen und großer Datensätze beschleunigt der RTX 4090 das Training von Modellen für maschinelles Lernen und eröffnet neue Möglichkeiten für Forscher und Entwickler auf diesem Gebiet. Benutzer sollten sich jedoch der Kühlprobleme bewusst sein, die mit der von der Karte erzeugten starken Hitze einhergehen, insbesondere bei Konfigurationen mit mehreren Karten. Darüber hinaus sollten die Konfigurationseinschränkungen berücksichtigt werden, wenn die Installation mehrerer RTX 4090-Karten in einer Workstation in Betracht gezogen wird. Durch die Nutzung der Fähigkeiten der NVIDIA RTX 4090 und die Berücksichtigung dieser Überlegungen können Profis ihre neuronalen Netzwerkprojekte optimieren und neue Grenzen bei der Weiterentwicklung des maschinellen Lernens erschließen.

NVIDIA RTX 4080

Die RTX 4080-Grafikkarte hat sich als leistungsstarke und effiziente Lösung im Bereich der künstlichen Intelligenz herausgestellt. Mit seiner hohen Leistung und seinem günstigen Preis stellt der RTX 4080 eine attraktive Wahl für Entwickler dar, die das Potenzial ihres Systems maximieren möchten. In diesem Artikel befassen wir uns mit den besonderen Merkmalen und praktischen Vorteilen der RTX 4080 und untersuchen ihre Auswirkungen auf die Beschleunigung maschineller Lernaufgaben.

Vorteile der RTX 4080:

- Hochleistung:

Der RTX 4080 verfügt über beeindruckende 9728 NVIDIA CUDA-Kerne, wodurch er außergewöhnliche Rechenleistung für maschinelle Lernaufgaben liefern kann. Diese Hochleistungsfähigkeit trägt in Kombination mit dem Vorhandensein von Tensorkernen und der Unterstützung von Raytracing zu einer effizienteren Datenverarbeitung und einer höheren Genauigkeit bei KI-bezogenen Vorgängen bei. Entwickler können die Leistung des RTX 4080 nutzen, um komplexe Berechnungen und große Datensätze zu verarbeiten und so ihre Arbeitsabläufe für maschinelles Lernen zu optimieren. - Wettbewerbsfähige Preise:

Mit einem Preis von 1,199 US-Dollar bietet die RTX 4080 ein attraktives Angebot für Einzelpersonen und kleine Teams, die eine produktive Lösung für maschinelles Lernen suchen. Seine Kombination aus Erschwinglichkeit und hoher Leistung macht es zu einer zugänglichen Option für Entwickler, die danach suchen Nutzen Sie die Vorteile der KI, ohne Ihr Budget zu sprengen.

Überlegungen zum RTX 4080:

- SLI-Einschränkung:

Es ist wichtig zu beachten, dass die RTX 4080 NVIDIA NVLink mit SLI-Funktion nicht unterstützt. Diese Einschränkung bedeutet, dass Benutzer nicht mehrere RTX 4080-Karten im SLI-Modus kombinieren können, um die Leistung weiter zu verbessern. Während dies die Skalierbarkeit der Grafikkarte in bestimmten Konfigurationen einschränken kann, schmälert es nicht ihre eigenständigen Fähigkeiten bei der Bereitstellung einer effizienten KI-Verarbeitung.

Fazit:

Die RTX 4080-Grafikkarte ist eine überzeugende Wahl für Entwickler, die leistungsstarke KI-Funktionen freischalten möchten. Mit seinen robusten Spezifikationen, darunter 9728 NVIDIA CUDA-Kerne, Tensorkerne und Raytracing-Unterstützung, bietet der RTX 4080 eine praktische Lösung zur Beschleunigung maschineller Lernaufgaben. Darüber hinaus ist es aufgrund seines wettbewerbsfähigen Preises von 1,199 US-Dollar eine zugängliche Option für Einzelpersonen und kleine Teams, die es ihnen ermöglicht, die Leistungsfähigkeit der KI ohne nennenswerten finanziellen Aufwand zu nutzen. Das Fehlen der SLI-Unterstützung schränkt zwar Konfigurationen mit mehreren Karten ein, beeinträchtigt jedoch nicht die eigenständige Leistung und Effizienz des RTX 4080. Durch die Nutzung der Vorteile des RTX 4080 können Entwickler ihre maschinellen Lernprojekte verbessern und neue Durchbrüche in der künstlichen Intelligenz erzielen Fortschritte.

NVIDIA RTX 4070

Die NVIDIA RTX 4070-Grafikkarte, die auf der innovativen Ada Lovelace-Architektur basiert, hat im Bereich des maschinellen Lernens für Aufsehen gesorgt. Mit ihrer Speicherkapazität von 12 GB bietet diese Grafikkarte einen beschleunigten Datenzugriff und verbesserte Trainingsgeschwindigkeiten für Modelle des maschinellen Lernens. In diesem Artikel werden wir uns mit den praktischen Vorteilen und Unterscheidungsmerkmalen der NVIDIA RTX 4070 befassen und ihre Eignung für Personen hervorheben, die in den Bereich des maschinellen Lernens einsteigen.

Vorteile der NVIDIA RTX 4070:

- Hochleistung:

Die NVIDIA RTX 4070 kombiniert die Leistung von 7680 CUDA-Kernen und 184 Tensor-Kernen und bietet Benutzern eine lobenswerte Verarbeitungsfähigkeit für komplexe Vorgänge. Die Speicherkapazität von 12 GB ermöglicht die effiziente Verarbeitung großer Datensätze und ermöglicht nahtlose Arbeitsabläufe bei maschinellen Lernaufgaben. - Energieeffizient:

Mit einer Betriebsleistung von nur 200 W weist die NVIDIA RTX 4070-Grafikkarte eine außergewöhnliche Energieeffizienz auf. Sein geringer Stromverbrauch stellt sicher, dass Benutzer leistungsstarke maschinelle Lernleistungen genießen können, ohne ihre Systeme übermäßig zu belasten oder übermäßige Energiekosten zu verursachen. - Kosteneffiziente Lösung:

Mit einem Preis von 599 US-Dollar stellt die NVIDIA RTX 4070-Grafikkarte eine erschwingliche Option für Personen dar, die maschinelles Lernen erkunden und erlernen möchten. Trotz ihres attraktiven Preises geht die Karte keine Kompromisse bei der Leistung ein, was sie zu einer ausgezeichneten Wahl für preisbewusste Menschen macht.

Überlegungen zur NVIDIA RTX 4070:

- Begrenzte Speicherkapazität:

Während die 4070-GB-Speicherkapazität der NVIDIA RTX 12 für viele Anwendungen des maschinellen Lernens ausreicht, ist es wichtig zu wissen, dass sie bei der Arbeit mit außergewöhnlich großen Datensätzen zu Einschränkungen führen kann. Benutzer sollten ihre spezifischen Anforderungen beurteilen und feststellen, ob die 12-GB-Speicherkapazität ihren Anforderungen entspricht. - Fehlende NVIDIA NVLink- und SLI-Unterstützung:

Die NVIDIA RTX 4070-Grafikkarte unterstützt nicht die NVIDIA NVLink-Technologie, die die Verknüpfung mehrerer Karten in einem Parallelverarbeitungssystem ermöglicht. Daher können Skalierbarkeit und Leistung bei Konfigurationen mit mehreren Karten eingeschränkt sein. Benutzer, die solche Setups in Betracht ziehen, sollten alternative Optionen erkunden, die ihren spezifischen Anforderungen gerecht werden.

Fazit:

Die NVIDIA RTX 4070-Grafikkarte erweist sich als effiziente und kostengünstige Lösung für Personen, die sich in den Bereich des maschinellen Lernens wagen. Mit seiner Ada Lovelace-Architektur, 12 GB Speicherkapazität und erheblicher Rechenleistung liefert es eine beeindruckende Leistung, die Benutzern die Bewältigung komplexer maschineller Lernvorgänge ermöglicht. Darüber hinaus sorgt der geringe Stromverbrauch der Karte von 200 W für eine energieeffiziente Nutzung, entlastet die Systeme und senkt die Energiekosten. Mit einem Preis von 599 US-Dollar bietet die NVIDIA RTX 4070 einen zugänglichen Einstiegspunkt für Personen, die sich mit maschinellem Lernen befassen möchten, ohne ihr Budget zu sprengen.

NVIDIA GeForce RTX 3090 TI

Die NVIDIA GeForce RTX 3090 TI hat als Gaming-GPU Aufmerksamkeit erregt, die auch beeindruckende Fähigkeiten für Deep-Learning-Aufgaben bietet. Mit ihrer Spitzenleistung bei einfacher Präzision (FP32) von 13 Teraflops, 24 GB VRAM und 10,752 CUDA-Kernen bietet diese Grafikkarte außergewöhnliche Leistung und Vielseitigkeit. In diesem Artikel werden wir die praktischen Vorteile und Unterscheidungsmerkmale der NVIDIA GeForce RTX 3090 TI untersuchen und ihre Eignung sowohl für Gaming-Enthusiasten als auch für Deep-Learning-Praktiker hervorheben.

Vorteile der NVIDIA GeForce RTX 3090 TI:

- Hochleistung:

Ausgestattet mit der Ampere-Architektur und beeindruckenden 10,752 CUDA-Kernen liefert die NVIDIA GeForce RTX 3090 TI außergewöhnliche Leistung. Dadurch können Benutzer komplexe Probleme des maschinellen Lernens problemlos lösen und schnellere und effizientere Berechnungen durchführen. - Hardware-Lernbeschleunigung:

Der RTX 3090 TI unterstützt die Tensor Cores-Technologie, die hardwarebeschleunigte neuronale Netzwerkoperationen ermöglicht. Durch die Nutzung von Tensor Cores können Benutzer erhebliche Geschwindigkeitsverbesserungen beim Training von Deep-Learning-Modellen erleben. Dieser Fortschritt trägt zu einer höheren Produktivität und kürzeren Modellschulungszeiten bei. - Große Speicherkapazität:

Mit 24 GB GDDR6X-Speicher bietet die NVIDIA GeForce RTX 3090 TI ausreichend Speicherplatz für die Verarbeitung großer Speicherdatenmengen. Diese Kapazität minimiert die Notwendigkeit häufiger Lese- und Schreibvorgänge auf der Festplatte, was zu reibungsloseren Arbeitsabläufen und verbesserter Effizienz führt, insbesondere bei der Arbeit mit umfangreichen Datensätzen.

Überlegungen zur NVIDIA GeForce RTX 3090 TI:

- Leistungsaufnahme:

Die NVIDIA GeForce RTX 3090 TI benötigt mit einem Stromverbrauch von 450 W eine beträchtliche Menge Strom. Daher ist es von entscheidender Bedeutung, eine robuste Stromversorgung sicherzustellen, um den Betrieb der Karte zu unterstützen. Der hohe Stromverbrauch kann zu erhöhten Energiekosten führen und die Kompatibilität der Karte mit bestimmten Systemen einschränken, insbesondere beim Einsatz mehrerer Karten in parallelen Computerkonfigurationen. - Kompatibilität und Support:

Obwohl es sich bei der NVIDIA GeForce RTX 3090 TI um eine leistungsstarke Grafikkarte handelt, kann es bei bestimmten Softwareplattformen und Bibliotheken für maschinelles Lernen zu Kompatibilitäts- und Unterstützungsaspekten kommen. Benutzer sollten die Kompatibilität überprüfen und darauf vorbereitet sein, die erforderlichen Anpassungen oder Aktualisierungen vorzunehmen, um die Funktionen der Karte in ihren spezifischen Softwareumgebungen vollständig nutzen zu können.

Fazit:

Die NVIDIA GeForce RTX 3090 TI ist eine beeindruckende Gaming-GPU, die auch bei Deep-Learning-Anwendungen brilliert. Mit seiner leistungsstarken Ampere-Architektur, der umfangreichen CUDA-Kernanzahl und den Hardware-Lernbeschleunigungsfunktionen ermöglicht es Benutzern, komplexe maschinelle Lernaufgaben effizient zu bewältigen. Darüber hinaus minimiert die beträchtliche Speicherkapazität von 24 GB Engpässe bei der Datenübertragung und ermöglicht so einen reibungslosen Betrieb auch bei großen Datenmengen.

NVIDIA GeForce RTX 3080 TI

Die NVIDIA GeForce RTX 3080 TI hat sich zu einer hochleistungsfähigen Mittelklasse-Grafikkarte entwickelt, die eine beeindruckende Leistung für maschinelle Lernaufgaben bietet. Mit ihren robusten Spezifikationen, einschließlich der Ampere-Architektur, 8704 CUDA-Kernen und 12 GB GDDR6X-Speicher, liefert diese Karte eine beträchtliche Rechenleistung. In diesem Artikel befassen wir uns mit den praktischen Vorteilen und Unterscheidungsmerkmalen der NVIDIA GeForce RTX 3080 TI und heben ihr Wertversprechen für Benutzer hervor, die hohe Leistung suchen, ohne ihr Budget zu sprengen.

Vorteile der NVIDIA GeForce RTX 3080 TI:

- Leistungsstarke Leistung:

Ausgestattet mit der Ampere-Architektur und 8704 CUDA-Kernen liefert die NVIDIA GeForce RTX 3080 TI außergewöhnliche Rechenleistung. Dadurch können Benutzer anspruchsvolle maschinelle Lernaufgaben problemlos bewältigen, Berechnungen beschleunigen und Trainingszeiten verkürzen. - Hardware-Lernbeschleunigung:

Der Einbau von Tensorkernen in die Grafikkarte ermöglicht hardwarebeschleunigte neuronale Netzwerkoperationen. Die Nutzung von Tensorkernen führt zu einer erheblichen Beschleunigung bei der Ausführung neuronaler Netzwerkaufgaben, was zu einem schnelleren Training von Deep-Learning-Modellen führt. Dieser Fortschritt steigert die Produktivität und ermöglicht schnellere Modelliterationen. - Relativ günstiger Preis:

Mit einem Preis von 1499 US-Dollar bietet die NVIDIA GeForce RTX 3080 TI eine relativ erschwingliche Option für Benutzer, die leistungsstarke Funktionen für maschinelles Lernen suchen. Diese Mittelklasse-Karte bietet ein optimales Verhältnis zwischen Leistung und Kosten und ist somit eine attraktive Wahl für preisbewusste Einzelpersonen oder kleine Teams. - Raytracing und DLSS-Unterstützung:

Der RTX 3080 TI unterstützt hardwarebeschleunigte Raytracing- und Deep Learning Super Sampling (DLSS)-Technologien. Diese Funktionen verbessern die visuelle Qualität von Grafiken und ermöglichen es Benutzern, realistischere und immersivere Umgebungen zu erleben. Raytracing- und DLSS-Funktionen sind wertvolle Vorteile bei der Visualisierung von Modellausgaben und der Darstellung hochwertiger Grafiken.

Überlegungen zur NVIDIA GeForce RTX 3080 TI:

- Begrenzter Speicher:

Obwohl die RTX 3080 TI über 12 GB GDDR6X-Speicher verfügt, ist zu beachten, dass dies die Fähigkeit zur Verarbeitung großer Datenmengen oder komplexer Modelle, die umfangreiche Speicherressourcen erfordern, möglicherweise einschränkt. Benutzer sollten ihre spezifischen Anforderungen bewerten und feststellen, ob die verfügbare Speicherkapazität mit ihren beabsichtigten Anwendungsfällen übereinstimmt.

Fazit:

Die NVIDIA GeForce RTX 3080 TI präsentiert sich als leistungsstarke Mittelklasse-Grafikkarte, die eine bemerkenswerte Leistung für maschinelle Lernaufgaben liefert. Basierend auf der Ampere-Architektur und 8704 CUDA-Kernen bietet diese Karte eine robuste Rechenleistung, um anspruchsvolle Berechnungen effizient durchzuführen. Durch die Unterstützung der Hardware-Lernbeschleunigung durch Tensor Cores können Benutzer von beschleunigten neuronalen Netzwerkoperationen und einem schnelleren Modelltraining profitieren.

Wickeln Sie es

Im Bereich des maschinellen Lernens ist die Auswahl der richtigen Grafikkarte von entscheidender Bedeutung für die Maximierung der Datenverarbeitungsfunktionen und die Ermöglichung effizienter paralleler Datenverarbeitung. Durch die Berücksichtigung von Schlüsselfaktoren wie Rechenleistung, GPU-Speicherkapazität, Unterstützung für Spezialbibliotheken, Hochleistungsunterstützung und Kompatibilität mit Frameworks für maschinelles Lernen können Praktiker sicherstellen, dass sie über die erforderliche Hardware verfügen, um komplexe Aufgaben des maschinellen Lernens zu bewältigen. Während NVIDIA-GPUs die Landschaft des maschinellen Lernens dominieren, ist es wichtig, die spezifischen Anforderungen des Projekts zu bewerten und die Grafikkarte auszuwählen, die diesen Anforderungen am besten entspricht. Mit der richtigen Grafikkarte können Forscher und Praktiker das volle Potenzial ihrer maschinellen Lernbemühungen ausschöpfen.

NVIDIA: Der führende Anbieter von GPUs für maschinelles Lernen

Derzeit NVIDIA steht an der Spitze der GPUs für maschinelles Lernen und bietet optimierte Treiber und umfassende Unterstützung für CUDA und cuDNN. NVIDIA-GPUs bieten eine bemerkenswerte Rechenbeschleunigung, sodass Forscher und Praktiker ihre Arbeit erheblich beschleunigen können.

AMD: Gaming-fokussiert, begrenzte Einführung von maschinellem Lernen

Obwohl sich AMD-GPUs in der Gaming-Branche als ernstzunehmende Konkurrenten etabliert haben, bleibt ihr Einsatz für maschinelles Lernen relativ begrenzt. Dies kann auf Faktoren wie begrenzte Softwareunterstützung und die Notwendigkeit häufiger Aktualisierungen zurückgeführt werden, um den Anforderungen sich weiterentwickelnder Frameworks für maschinelles Lernen gerecht zu werden.

FAQs

Die Auswahl der geeigneten Grafikkarte ist von entscheidender Bedeutung, da sie die Fähigkeit bestimmt, die intensive Matrix- und Tensorverarbeitung zu bewältigen, die für Aufgaben wie das Training tiefer neuronaler Netze erforderlich ist.

Spezialisierte KI-Chips wie TPUs (Tensor Processing Units) und FPGAs (Field Programmable Gate Arrays) erfreuen sich in letzter Zeit großer Beliebtheit.

Aufgaben mit tiefem neuronale Netzwerk Das Training erfordert eine intensive Verarbeitung von Matrizen und Tensoren.

Spezialisierte KI-Chips bieten eine verbesserte Leistung und Effizienz für Aufgaben im Zusammenhang mit künstlicher Intelligenz und sind daher äußerst wünschenswert für die Verarbeitung großer Datensätze und die Durchführung paralleler Berechnungen.

Die Wahl der richtigen Grafikkarte mit ausreichender Rechenleistung und Speicherkapazität ist entscheidend für das Erreichen einer hohen Leistung bei Trainingsaufgaben für tiefe neuronale Netze.

Neben Grafikkarten erfreuen sich auch spezielle KI-Chips wie TPUs und FPGAs aufgrund ihrer Effizienz bei der Bewältigung KI-bezogener Aufgaben großer Beliebtheit.

TPUs und FPGAs erfreuen sich aufgrund ihrer Fähigkeit, eine spezielle Hardwarebeschleunigung für KI-bezogene Aufgaben bereitzustellen, zunehmender Beliebtheit und ermöglichen so eine schnellere und effizientere Verarbeitung großer Datensätze und komplexer Berechnungen.

Spezialisierte KI-Chips wie TPUs und FPGAs übertreffen häufig herkömmliche Grafikkarten hinsichtlich Leistung und Effizienz für KI-Aufgaben, da sie speziell für diese Arbeitslasten entwickelt wurden.

Es gibt mehrere Grafikkarten, die für maschinelles Lernen (ML) und künstliche Intelligenz hoch geschätzt werden (AI) Aufgaben. Hier sind einige der besten Grafikkarten für ML und KI:

- NVIDIA A100: Der A100 basiert auf der Ampere-Architektur und ist ein Kraftpaket für KI- und ML-Aufgaben. Es verfügt über eine enorme Anzahl von CUDA-Kernen und unterstützt fortschrittliche KI-Technologien.

- NVIDIA GeForce RTX 3090: Diese High-End-Grafikkarte bietet außergewöhnliche Leistung mit ihrer leistungsstarken GPU, der großen Speicherkapazität und der Unterstützung von KI-Beschleunigungstechnologien wie Tensor Cores.

- NVIDIA Quadro RTX 8000: Diese professionelle Grafikkarte ist mit ihrer hohen Rechenleistung und umfangreichen Speicherkapazität für anspruchsvolle ML- und KI-Anwendungen konzipiert.

Haftungsausschluss

Im Einklang mit der Richtlinien des Trust-ProjektsBitte beachten Sie, dass die auf dieser Seite bereitgestellten Informationen nicht als Rechts-, Steuer-, Anlage-, Finanz- oder sonstige Beratung gedacht sind und nicht als solche interpretiert werden sollten. Es ist wichtig, nur so viel zu investieren, wie Sie sich leisten können, zu verlieren, und im Zweifelsfall eine unabhängige Finanzberatung einzuholen. Für weitere Informationen empfehlen wir einen Blick auf die Allgemeinen Geschäftsbedingungen sowie die Hilfe- und Supportseiten des Herausgebers oder Werbetreibenden. MetaversePost ist einer genauen, unvoreingenommenen Berichterstattung verpflichtet, die Marktbedingungen können sich jedoch ohne Vorankündigung ändern.

Über den Autor

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.

Weitere Artikel

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.