8 dalykai, kuriuos turėtumėte žinoti apie didelių kalbų modelius

Trumpai

Didelės kalbos modeliai (LLM) naudojami natūralios kalbos niuansams tyrinėti, mašinų gebėjimui suprasti ir generuoti tekstą gerinti ir tokioms užduotims kaip balso atpažinimas ir mašininis vertimas automatizuoti.

Nėra lengvo sprendimo valdyti LLM, tačiau jie yra tokie pat pajėgūs kaip ir žmonės.

Didėjant natūralios kalbos apdorojimo plėtrai ir jos naudojimui versle, didėja susidomėjimas dideliais kalbos modeliais. Šie modeliai naudojami tyrinėti natūralios kalbos niuansus, pagerinti mašinų gebėjimą suprasti ir generuoti tekstą bei automatizuoti užduotis, tokias kaip balso atpažinimas ir mašininis vertimas. Štai aštuoni pagrindiniai dalykai, kuriuos turėtumėte žinoti apie didelius kalbos modelius (LLM).

- LLM yra „pajėgesni“, nes išlaidos nuolat auga

- Greitas žvilgsnis, kaip GPT modeliai prisitaiko, kai didėja mokymo išlaidos

- LLM mokosi žaisti stalo žaidimus naudodamiesi išorinio pasaulio reprezentacijomis

- Nėra lengvo sprendimo valdyti LLM

- Ekspertams sunku paaiškinti, kaip veikia LLM

- LLM yra tokie pat pajėgūs kaip ir žmonės

- LLM turi būti daugiau nei tik „visų amatų pranašumas“

- Modeliai yra „protingesni“, nei žmonės galvoja iš pirmo įspūdžio

LLM yra „pajėgesni“, nes išlaidos nuolat auga

Nuspėjama, kad LLM tampa „pajėgesni“ didėjant sąnaudoms, net ir be šaunių naujovių. Svarbiausia čia yra nuspėjamumas, kuris buvo parodytas straipsnyje apie GPT-4: buvo mokomi nuo penkių iki septynių mažų modelių, kurių biudžetas buvo 0.1% galutinio, o tada pagal tai buvo prognozuojamas didžiulis modelis. Norint bendrai įvertinti vienos konkrečios užduoties imties sudėtingumą ir metriką, tokia prognozė buvo labai tiksli. Šis nuspėjamumas yra svarbus įmonėms ir organizacijoms, kurios savo veikloje pasitiki LLM, nes gali atitinkamai planuoti biudžetą ir planuoti būsimas išlaidas. Tačiau svarbu pažymėti, kad nors didėjančios sąnaudos gali pagerinti pajėgumus, pagerėjimo greitis ilgainiui gali sumažėti, todėl norint toliau tobulėti, reikės investuoti į naujas inovacijas.

Greitas žvilgsnis, kaip GPT modeliai prisitaiko, kai didėja mokymo išlaidos

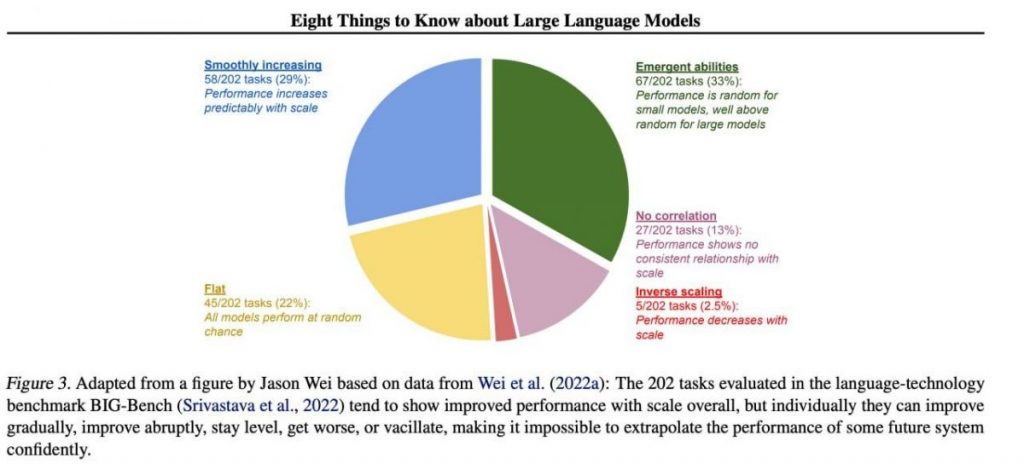

Tačiau specifiniai svarbūs įgūdžiai paprastai atsiranda nenuspėjamai kaip šalutinis augimo produktas mokymo išlaidos (ilgesnis mokymas, daugiau duomenų, didesnis modelis) – beveik neįmanoma nuspėti, kada modeliai pradės atlikti tam tikras užduotis. Mes išsamiau išnagrinėjome temą mūsų straipsnis apie raidos istoriją GPT modeliai. Paveikslėlyje parodytas modelių kokybės padidėjimo pasiskirstymas atliekant skirtingas užduotis. Tik didieji modeliai gali išmokti atlikti įvairias užduotis. Šioje diagramoje pabrėžiamas reikšmingas dydžio padidinimo poveikis GPT modeliai apie jų atlikimą atliekant įvairias užduotis. Tačiau svarbu pažymėti, kad tai kainuoja dėl didesnių skaičiavimo išteklių ir poveikio aplinkai.

LLM mokosi žaisti stalo žaidimus naudodamiesi išorinio pasaulio reprezentacijomis

LLM dažnai mokosi ir naudojasi išorinio pasaulio reprezentacijomis. Čia yra daug pavyzdžių, ir čia yra vienas iš jų: Treniruojami modeliai žaisti stalo žaidimus pagal atskirų judesių aprašymus, niekada nematant žaidimo lauko paveikslėlio, išmokti vidines lentos būsenos atvaizdų kiekviename judesyje. Tada šie vidiniai vaizdai gali būti naudojami numatyti ateitį judesiai ir rezultatai, leidžiantys modeliui žaisti žaidimą aukštu lygiu. Šis gebėjimas mokytis ir naudoti reprezentacijas yra esminis dalykas mašininio mokymosi aspektas ir dirbtinis intelektas.

Nėra lengvo sprendimo valdyti LLM

Nėra patikimų metodų, kaip kontroliuoti LLM elgesį. Nors buvo padaryta tam tikra pažanga suprantant ir sušvelninant įvairias problemas (įskaitant ChatGPT ir GPT-4 naudojant grįžtamąjį ryšį), nėra bendro sutarimo, ar galime juos išspręsti. Didėja susirūpinimas, kad ateityje, kai bus sukurtos dar didesnės sistemos, tai taps didžiule, potencialiai katastrofiška problema. Todėl mokslininkai tiria naujus metodus, siekdami užtikrinti, kad AI sistemos atitiktų žmogaus vertybes ir tikslus, pvz., vertybių derinimą ir atlygio inžineriją. Tačiau tebėra sudėtinga užduotis užtikrinti LLM saugumas ir patikimumas sudėtinguose realaus pasaulio scenarijuose.

| Plačiau paskaitykite čia: OpenAI Suburia daugiau nei 50 ekspertų komandą tobulinti GPT-4saugumas |

Ekspertams sunku paaiškinti, kaip veikia LLM

Ekspertai dar negali interpretuoti vidinio LLM veikimo. Jokia technika neleistų mums patenkinamai teigti, kokias žinias, samprotavimus ar tikslus naudoja modelis, kai sukuria kokį nors rezultatą. Šis aiškinamumo trūkumas kelia susirūpinimą dėl LLM sprendimų patikimumo ir teisingumo, ypač didelės svarbos programose, tokiose kaip baudžiamoji justicija ar kredito įvertinimas. Taip pat pabrėžiamas tolesnių tyrimų, skirtų skaidresniams ir atskaitingesniems AI modeliams kurti, poreikis.

LLM yra tokie pat pajėgūs kaip ir žmonės

Nors LLM mokomi pirmiausia mėgdžioti žmogaus elgesį rašant tekstą, jie gali mus pranokti daugelyje užduočių. Tai jau galima pastebėti žaidžiant šachmatais ar Go. Taip yra dėl jų gebėjimo analizuoti didžiulius duomenų kiekius ir priimti sprendimus remiantis šia analize tokiu greičiu, kurio žmonės negali prilygti. Tačiau LLM vis dar trūksta kūrybiškumo ir intuicijos, kurią turi žmonės, todėl jie nėra tokie tinkami daugeliui užduočių.

| Plačiau paskaitykite čia: OpenAI Suburia daugiau nei 50 ekspertų komandą tobulinti GPT-4saugumas |

LLM turi būti daugiau nei tik „visų amatų pranašumas“

LLM neturi išreikšti savo kūrėjų vertybių arba vertybių, užkoduotų atrankoje iš interneto. Jie neturėtų kartoti stereotipų ar sąmokslo teorijų ar siekti ką nors įžeisti. Vietoj to, LLM turėtų būti sukurtos taip, kad savo vartotojams teiktų nešališką ir faktinę informaciją, atsižvelgiant į kultūrinius ir visuomenės skirtumus. Be to, jie turėtų būti reguliariai tikrinami ir stebimi, siekiant užtikrinti, kad jie ir toliau atitiktų šiuos standartus.

Modeliai yra „protingesni“, nei žmonės galvoja iš pirmo įspūdžio

Pirmuoju įspūdžiu pagrįsti modelio gebėjimų įvertinimai dažnai yra klaidinantys. Labai dažnai reikia sugalvoti tinkamą raginimą, pasiūlyti modelį, o gal parodyti pavyzdžių, ir jis pradės daug geriau susitvarkyti. Tai yra, jis yra „protingesnis“, nei atrodo iš pirmo žvilgsnio. Todėl labai svarbu modeliui suteikti sąžiningą galimybę ir suteikti jam reikiamus išteklius, kad jis veiktų geriausiai. Taikant tinkamą požiūrį, net iš pažiūros neadekvatūs modeliai gali nustebinti savo galimybėmis.

Jei sutelksime dėmesį į 202 užduočių pavyzdį iš BIG-Bench duomenų rinkinio (tai buvo ypač sudėtinga išbandyti kalbos modeliai nuo ir iki), tada paprastai (vidutiniškai) modeliai rodo, kad didėjant mastui gerėja kokybė, tačiau atskirai užduočių metrika gali:

- tobulėti palaipsniui,

- drastiškai tobulėti,

- likti nepakitusi,

- mažinti,

- nerodo jokios koreliacijos.

Visa tai lemia tai, kad neįmanoma užtikrintai ekstrapoliuoti bet kokios būsimos sistemos veikimo. Žalia dalis ypač įdomi – būtent čia be jokios priežasties staigiai šokteli kokybės rodikliai.

Skaitykite daugiau apie AI:

Atsakomybės neigimas

Remdamasi tuo, Pasitikėjimo projekto gairės, atkreipkite dėmesį, kad šiame puslapyje pateikta informacija nėra skirta ir neturėtų būti aiškinama kaip teisinė, mokesčių, investicinė, finansinė ar bet kokia kita konsultacija. Svarbu investuoti tik tai, ką galite sau leisti prarasti, ir, jei turite kokių nors abejonių, kreiptis į nepriklausomą finansinę konsultaciją. Norėdami gauti daugiau informacijos, siūlome peržiūrėti taisykles ir nuostatas bei pagalbos ir palaikymo puslapius, kuriuos pateikia išdavėjas arba reklamuotojas. MetaversePost yra įsipareigojusi teikti tikslias, nešališkas ataskaitas, tačiau rinkos sąlygos gali keistis be įspėjimo.

Apie autorių

Damiras yra komandos vadovas, produktų vadovas ir redaktorius Metaverse Post, apimantis tokias temas kaip AI/ML, AGI, LLM, Metaverse ir Web3– susijusiose srityse. Jo straipsniai kas mėnesį pritraukia didžiulę daugiau nei milijono vartotojų auditoriją. Atrodo, kad jis yra ekspertas, turintis 10 metų SEO ir skaitmeninės rinkodaros patirtį. Damiras buvo paminėtas Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto ir kiti leidiniai. Jis keliauja tarp JAE, Turkijos, Rusijos ir NVS kaip skaitmeninis klajoklis. Damiras įgijo fizikos bakalauro laipsnį, kuris, jo manymu, suteikė jam kritinio mąstymo įgūdžių, reikalingų sėkmingam nuolat besikeičiančiame interneto peizaže.

Daugiau straipsnių

Damiras yra komandos vadovas, produktų vadovas ir redaktorius Metaverse Post, apimantis tokias temas kaip AI/ML, AGI, LLM, Metaverse ir Web3– susijusiose srityse. Jo straipsniai kas mėnesį pritraukia didžiulę daugiau nei milijono vartotojų auditoriją. Atrodo, kad jis yra ekspertas, turintis 10 metų SEO ir skaitmeninės rinkodaros patirtį. Damiras buvo paminėtas Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto ir kiti leidiniai. Jis keliauja tarp JAE, Turkijos, Rusijos ir NVS kaip skaitmeninis klajoklis. Damiras įgijo fizikos bakalauro laipsnį, kuris, jo manymu, suteikė jam kritinio mąstymo įgūdžių, reikalingų sėkmingam nuolat besikeičiančiame interneto peizaže.