8 cose che dovresti sapere sui modelli linguistici di grandi dimensioni

In Breve

Modelli linguistici di grandi dimensioni (LLM) vengono utilizzati per esplorare le sfumature del linguaggio naturale, migliorare la capacità delle macchine di comprendere e generare testo e automatizzare attività come il riconoscimento vocale e la traduzione automatica.

Non esiste una soluzione semplice per gestire gli LLM, ma sono capaci quanto gli umani.

Con un'impennata nello sviluppo dell'elaborazione del linguaggio naturale e del suo utilizzo negli affari, c'è un crescente interesse per i modelli di linguaggio di grandi dimensioni. Questi modelli vengono utilizzati per esplorare le sfumature del linguaggio naturale, migliorare la capacità delle macchine di comprendere e generare testo e automatizzare attività come il riconoscimento vocale e la traduzione automatica. Ecco otto cose essenziali che dovresti sapere sui modelli di linguaggio di grandi dimensioni (LLM).

- Gli LLM sono più "capaci" poiché i costi continuano ad aumentare

- Una rapida occhiata a come GPT i modelli si adattano all’aumento dei costi di formazione

- Gli LLM imparano a giocare a giochi da tavolo usando rappresentazioni del mondo esterno

- Non esiste una soluzione semplice per gestire LLM

- Gli esperti hanno difficoltà a spiegare come funziona il LLM

- Gli LLM sono capaci quanto gli umani

- Gli LLM devono essere più di un semplice "tuttofare"

- I modelli sono "più intelligenti" di quanto la gente pensi in base alle prime impressioni

Gli LLM sono più "capaci" poiché i costi continuano ad aumentare

Gli LLM diventano prevedibilmente più "capaci" con l'aumento dei costi, anche senza innovazioni interessanti. La cosa principale qui è la prevedibilità, che è stata mostrata nell'articolo su GPT-4: sono stati insegnati da cinque a sette piccoli modelli con un budget dello 0.1% di quello finale, quindi è stata fatta una previsione per un modello enorme basato su questo. Per una valutazione generale della perplessità e delle metriche su un sottocampione di un'attività specifica, tale previsione era molto accurata. Questa prevedibilità è importante per le aziende e le organizzazioni che si affidano a LLM per le loro operazioni, in quanto possono preventivare di conseguenza e pianificare le spese future. Tuttavia, è importante notare che mentre l'aumento dei costi può portare a capacità migliorate, il tasso di miglioramento potrebbe stabilizzarsi, rendendo necessario investire in nuove innovazioni per continuare ad avanzare.

Una rapida occhiata a come GPT i modelli si adattano all’aumento dei costi di formazione

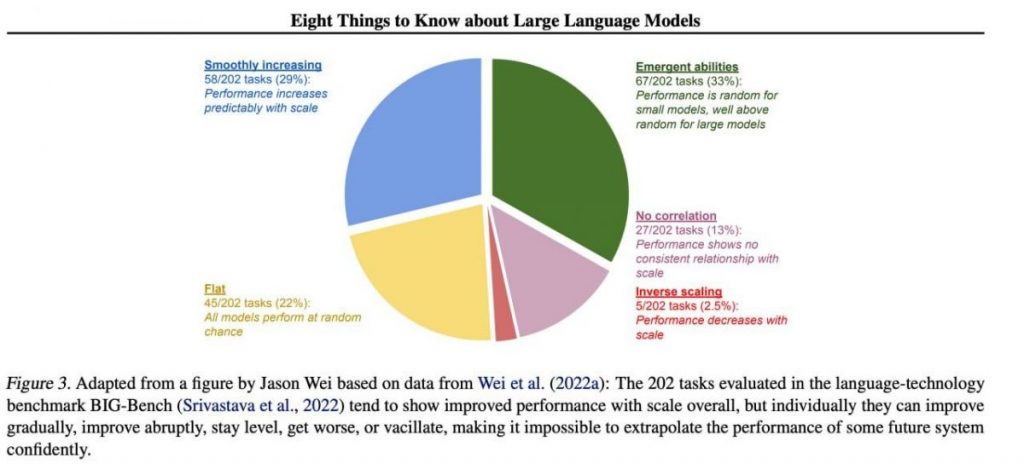

Tuttavia, abilità specifiche importanti tendono ad emergere in modo imprevedibile come sottoprodotto dell'aumento costi di formazione (addestramento più lungo, più dati, modello più grande): è quasi impossibile prevedere quando i modelli inizieranno a eseguire determinate attività. Abbiamo approfondito l'argomento nel ns articolo sulla storia dello sviluppo di GPT Modelli. L'immagine mostra la distribuzione dell'aumento della qualità dei modelli tra diversi compiti. Solo i grandi modelli possono imparare a svolgere vari compiti. Questo grafico evidenzia l'impatto significativo dell'aumento delle dimensioni di GPT modelli sulle loro prestazioni in vari compiti. Tuttavia, è importante notare che ciò comporta un aumento delle risorse computazionali e dell'impatto ambientale.

Gli LLM imparano a giocare a giochi da tavolo usando rappresentazioni del mondo esterno

Gli LLM spesso imparano e usano rappresentazioni del mondo esterno. Ci sono molti esempi qui, ed eccone uno: Modelle addestrate giocare a giochi da tavolo basati sulla descrizione delle singole mosse, senza mai vedere un'immagine del campo di gioco, apprendere rappresentazioni interne dello stato del tabellone ad ogni mossa. Queste rappresentazioni interne possono quindi essere utilizzate predire il futuro mosse e risultati, consentendo al modello di giocare ad alto livello. Questa capacità di apprendere e utilizzare le rappresentazioni è una chiave aspetto dell'apprendimento automatico e intelligenza artificiale.

Non esiste una soluzione semplice per gestire LLM

Non esistono metodi affidabili per controllare il comportamento LLM. Sebbene ci siano stati alcuni progressi nella comprensione e mitigazione di vari problemi (tra cui ChatGPT ed GPT-4 con l’aiuto del feedback), non c’è consenso sulla possibilità di risolverli. Vi è una crescente preoccupazione che ciò diventi un problema enorme e potenzialmente catastrofico in futuro quando verranno creati sistemi ancora più grandi. Pertanto, i ricercatori stanno esplorando nuovi metodi per garantire che i sistemi di intelligenza artificiale si allineino ai valori e agli obiettivi umani, come l’allineamento dei valori e l’ingegneria della ricompensa. Resta tuttavia un compito arduo garantire il sicurezza e affidabilità degli LLM in scenari reali complessi.

Gli esperti hanno difficoltà a spiegare come funziona il LLM

Gli esperti non possono ancora interpretare il funzionamento interno del LLM. Nessuna tecnica ci permetterebbe di affermare in modo soddisfacente quali tipi di conoscenza, ragionamento o obiettivi utilizza il modello quando genera un risultato. Questa mancanza di interpretabilità solleva preoccupazioni circa l'affidabilità e l'equità delle decisioni del LLM, specialmente nelle applicazioni ad alto rischio come la giustizia penale o il punteggio di credito. Sottolinea inoltre la necessità di ulteriori ricerche sullo sviluppo di modelli di IA più trasparenti e responsabili.

Gli LLM sono capaci quanto gli umani

Sebbene i LLM siano addestrati principalmente a imitare il comportamento umano durante la scrittura del testo, hanno il potenziale per superarci in molti compiti. Questo può già essere visto quando si gioca a scacchi o a Go. Ciò è dovuto alla loro capacità di analizzare grandi quantità di dati e prendere decisioni basate su tale analisi a una velocità che gli esseri umani non possono eguagliare. Tuttavia, gli LLM mancano ancora della creatività e dell’intuizione che possiedono gli esseri umani, il che li rende meno adatti a molti compiti.

Gli LLM devono essere più di un semplice "tuttofare"

Gli LLM non devono esprimere i valori dei loro creatori o i valori codificati in una selezione da Internet. Non dovrebbero ripetere stereotipi o teorie del complotto o cercare di offendere nessuno. Invece, gli LLM dovrebbero essere progettati per fornire informazioni imparziali e fattuali ai propri utenti, rispettando le differenze culturali e sociali. Inoltre, dovrebbero sottoporsi a test e monitoraggio regolari per garantire che continuino a soddisfare questi standard.

I modelli sono "più intelligenti" di quanto la gente pensi in base alle prime impressioni

Le stime dell'abilità di un modello basate sulle prime impressioni sono spesso fuorvianti. Molto spesso, devi trovare il suggerimento giusto, suggerire un modello e magari mostrare esempi, e inizierà a far fronte molto meglio. Cioè, è "più intelligente" di quanto sembri a prima vista. Pertanto, è fondamentale dare al modello una giusta possibilità e fornirgli le risorse necessarie per funzionare al meglio. Con il giusto approccio, anche modelli apparentemente inadeguati possono sorprenderci con le loro capacità.

Se ci concentriamo su un campione di 202 attività dal set di dati BIG-Bench (è stato appositamente reso difficile testare modelli linguistici da e a), quindi di norma (in media), i modelli mostrano un aumento della qualità con l'aumentare della scala, ma individualmente, le metriche nelle attività possono:

- migliorare gradualmente,

- migliorare drasticamente,

- rimane invariato,

- diminuire,

- mostrare alcuna correlazione.

Tutto ciò porta all'impossibilità di estrapolare con sicurezza le prestazioni di qualsiasi sistema futuro. La parte verde è particolarmente interessante: è proprio qui che gli indicatori di qualità salgono bruscamente senza motivo.

Per saperne di più sull'intelligenza artificiale:

Negazione di responsabilità

In linea con la Linee guida del progetto Trust, si prega di notare che le informazioni fornite in questa pagina non intendono essere e non devono essere interpretate come consulenza legale, fiscale, di investimento, finanziaria o di qualsiasi altra forma. È importante investire solo ciò che puoi permetterti di perdere e chiedere una consulenza finanziaria indipendente in caso di dubbi. Per ulteriori informazioni, suggeriamo di fare riferimento ai termini e alle condizioni nonché alle pagine di aiuto e supporto fornite dall'emittente o dall'inserzionista. MetaversePost si impegna a fornire report accurati e imparziali, ma le condizioni di mercato sono soggette a modifiche senza preavviso.

Circa l'autore

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.

Altri articoli

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.