8 choses que vous devez savoir sur les grands modèles de langage

En bref

Grands modèles de langage (LLM) sont utilisés pour explorer les nuances du langage naturel, améliorer la capacité des machines à comprendre et générer du texte et automatiser des tâches telles que la reconnaissance vocale et la traduction automatique.

Il n'y a pas de solution simple pour gérer les LLM, mais ils sont tout aussi capables que les humains.

Avec l'essor du développement du traitement du langage naturel et de son utilisation dans les entreprises, il existe un intérêt croissant pour les grands modèles de langage. Ces modèles sont utilisés pour explorer les nuances du langage naturel, améliorer la capacité des machines à comprendre et générer du texte et automatiser des tâches telles que la reconnaissance vocale et la traduction automatique. Voici huit choses essentielles que vous devez savoir sur les grands modèles de langage (LLM).

- Les LLM sont plus "capables" alors que les coûts ne cessent d'augmenter

- Un aperçu rapide de la façon dont GPT les modèles s’adaptent à mesure que les coûts de formation augmentent

- Les LLM apprennent à jouer à des jeux de société en utilisant des représentations du monde extérieur

- Il n'y a pas de solution simple pour gérer LLM

- Les experts ont du mal à expliquer le fonctionnement du LLM

- Les LLM sont tout aussi capables que les humains

- Les LLM doivent être plus que de simples "touches à tout faire"

- Les modèles sont "plus intelligents" que les gens ne le pensent sur la base des premières impressions

Les LLM sont plus "capables" alors que les coûts ne cessent d'augmenter

Les LLM deviennent de manière prévisible plus « capables » avec des coûts croissants, même sans innovations intéressantes. L'essentiel ici est la prévisibilité, qui a été montrée dans l'article sur GPT-4 : cinq à sept petits modèles ont été enseignés avec un budget de 0.1 % du budget final, puis une prédiction a été faite pour un énorme modèle basé sur cela. Pour une évaluation générale de la perplexité et des mesures sur un sous-échantillon d'une tâche spécifique, une telle prédiction était très précise. Cette prévisibilité est importante pour les entreprises et les organisations qui dépendent des LLM pour leurs opérations, car elles peuvent budgétiser en conséquence et planifier les dépenses futures. Cependant, il est important de noter que même si l'augmentation des coûts peut entraîner une amélioration des capacités, le taux d'amélioration peut éventuellement plafonner, ce qui oblige à investir dans de nouvelles innovations pour continuer à progresser.

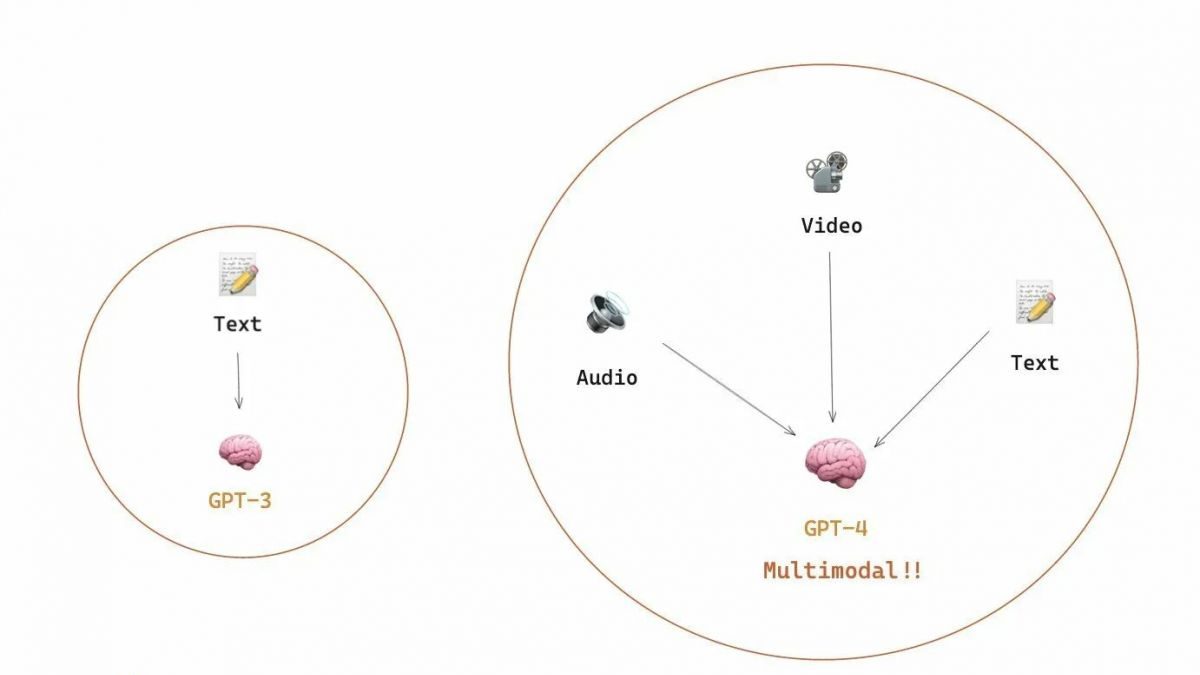

Un aperçu rapide de la façon dont GPT les modèles s’adaptent à mesure que les coûts de formation augmentent

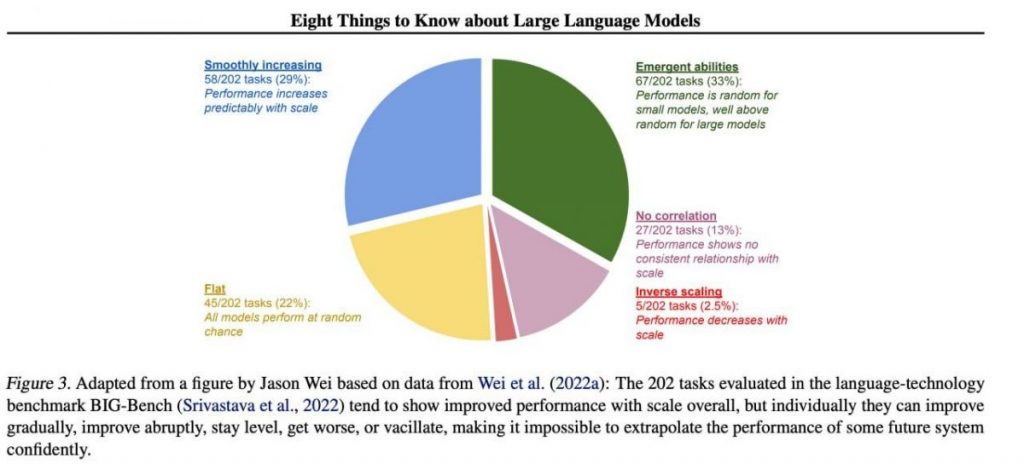

Cependant, des compétences importantes spécifiques ont tendance à émerger de manière imprévisible en tant que sous-produit de l'augmentation frais de formation (formation plus longue, plus de données, modèle plus grand) - il est presque impossible de prédire quand les modèles commenceront à effectuer certaines tâches. Nous avons approfondi le sujet dans notre article sur l'histoire du développement de GPT des modèles. L'image montre la répartition de l'augmentation de la qualité des modèles entre différentes tâches. Seuls les grands modèles peuvent apprendre à effectuer diverses tâches. Ce graphique met en évidence l’impact significatif de l’augmentation de la taille des GPT numériques jumeaux (digital twin models) sur leur performance dans diverses tâches. Cependant, il est important de noter que cela se fait au prix d'une augmentation des ressources de calcul et de l'impact environnemental.

Les LLM apprennent à jouer à des jeux de société en utilisant des représentations du monde extérieur

Les LLM apprennent et utilisent souvent des représentations du monde extérieur. Il y a beaucoup d'exemples ici, et en voici un : Modèles formés jouer à des jeux de société basés sur des descriptions de mouvements individuels, sans jamais voir une image du terrain de jeu, apprendre des représentations internes de l'état du plateau à chaque mouvement. Ces représentations internes peuvent ensuite être utilisées pour prédire l'avenir mouvements et résultats, permettant au modèle de jouer au jeu à un niveau élevé. Cette capacité à apprendre et à utiliser des représentations est une clé aspect de l'apprentissage automatique et l'intelligence artificielle.

Il n'y a pas de solution simple pour gérer LLM

Il n'existe pas de méthodes fiables pour contrôler le comportement LLM. Bien qu'il y ait eu quelques progrès dans la compréhension et l'atténuation de divers problèmes (notamment ChatGPT ainsi que le GPT-4 avec l'aide des commentaires), il n'y a pas de consensus sur la question de savoir si nous pouvons les résoudre. On craint de plus en plus que cela ne devienne un problème énorme, potentiellement catastrophique, à l'avenir, lorsque des systèmes encore plus vastes seront créés. Par conséquent, les chercheurs explorent de nouvelles méthodes pour garantir que les systèmes d’IA s’alignent sur les valeurs et les objectifs humains, comme l’alignement des valeurs et l’ingénierie des récompenses. Cependant, garantir la sécurité et fiabilité des LLM dans des scénarios complexes du monde réel.

Les experts ont du mal à expliquer le fonctionnement du LLM

Les experts ne peuvent pas encore interpréter le fonctionnement interne du LLM. Aucune technique ne nous permettrait d'énoncer de manière satisfaisante quels types de connaissances, de raisonnement ou d'objectifs le modèle utilise lorsqu'il génère un résultat. Ce manque d'interprétabilité soulève des inquiétudes quant à la fiabilité et à l'équité des décisions du LLM, en particulier dans les applications à enjeux élevés telles que la justice pénale ou la notation de crédit. Il souligne également la nécessité de poursuivre les recherches sur le développement de modèles d'IA plus transparents et responsables.

Les LLM sont tout aussi capables que les humains

Bien que les LLM soient formés principalement pour imiter le comportement humain lors de l'écriture d'un texte, ils ont le potentiel de nous surpasser dans de nombreuses tâches. Cela se voit déjà en jouant aux échecs ou au Go. Cela est dû à leur capacité à analyser de grandes quantités de données et à prendre des décisions basées sur cette analyse à une vitesse que les humains ne peuvent égaler. Cependant, les LLM n’ont toujours pas la créativité et l’intuition que possèdent les humains, ce qui les rend moins adaptés à de nombreuses tâches.

Les LLM doivent être plus que de simples "touches à tout faire"

Les LLM ne doivent pas exprimer les valeurs de leurs créateurs ou les valeurs encodées dans une sélection sur Internet. Ils ne doivent pas répéter les stéréotypes ou les théories du complot ou chercher à offenser qui que ce soit. Au lieu de cela, les LLM devraient être conçus pour fournir des informations impartiales et factuelles à leurs utilisateurs tout en respectant les différences culturelles et sociétales. De plus, ils doivent être soumis à des tests et à une surveillance réguliers pour s'assurer qu'ils continuent de répondre à ces normes.

Les modèles sont "plus intelligents" que les gens ne le pensent sur la base des premières impressions

Les estimations de la capacité d'un modèle basées sur les premières impressions sont souvent trompeuses. Très souvent, vous devez proposer la bonne invite, suggérer un modèle et peut-être montrer des exemples, et cela commencera à mieux fonctionner. Autrement dit, il est "plus intelligent" qu'il n'y paraît à première vue. Par conséquent, il est crucial de donner une chance équitable au modèle et de lui fournir les ressources nécessaires pour fonctionner au mieux. Avec la bonne approche, même des modèles apparemment inadéquats peuvent nous surprendre par leurs capacités.

Si nous nous concentrons sur un échantillon de 202 tâches de l'ensemble de données BIG-Bench (il a été spécialement rendu difficile à tester) modèles de langage de et vers), puis en règle générale (en moyenne), les modèles montrent une augmentation de la qualité avec une échelle croissante, mais individuellement, les métriques des tâches peuvent :

- s'améliorer progressivement,

- s'améliorer considérablement,

- restent inchangés,

- diminution,

- ne montrent aucune corrélation.

Tout cela conduit à l'impossibilité d'extrapoler en toute confiance les performances de tout système futur. La partie verte est particulièrement intéressante - c'est exactement là que les indicateurs de qualité augmentent brusquement sans aucune raison.

En savoir plus sur l'IA :

Clause de non-responsabilité

En ligne avec la Lignes directrices du projet de confiance, veuillez noter que les informations fournies sur cette page ne sont pas destinées à être et ne doivent pas être interprétées comme des conseils juridiques, fiscaux, d'investissement, financiers ou toute autre forme de conseil. Il est important d’investir uniquement ce que vous pouvez vous permettre de perdre et de demander des conseils financiers indépendants en cas de doute. Pour plus d'informations, nous vous suggérons de vous référer aux conditions générales ainsi qu'aux pages d'aide et de support mises à disposition par l'émetteur ou l'annonceur. MetaversePost s'engage à fournir des rapports précis et impartiaux, mais les conditions du marché sont susceptibles de changer sans préavis.

A propos de l'auteur

Damir est chef d'équipe, chef de produit et rédacteur en chef chez Metaverse Post, couvrant des sujets tels que l'IA/ML, l'AGI, les LLM, le métaverse et Web3-domaines connexes. Ses articles attirent une audience massive de plus d'un million d'utilisateurs chaque mois. Il semble être un expert avec 10 ans d'expérience dans le référencement et le marketing numérique. Damir a été mentionné dans Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto et d'autres publications. Il voyage entre les Émirats arabes unis, la Turquie, la Russie et la CEI en tant que nomade numérique. Damir a obtenu un baccalauréat en physique, ce qui, selon lui, lui a donné les compétences de pensée critique nécessaires pour réussir dans le paysage en constante évolution d'Internet.

Plus d'articles

Damir est chef d'équipe, chef de produit et rédacteur en chef chez Metaverse Post, couvrant des sujets tels que l'IA/ML, l'AGI, les LLM, le métaverse et Web3-domaines connexes. Ses articles attirent une audience massive de plus d'un million d'utilisateurs chaque mois. Il semble être un expert avec 10 ans d'expérience dans le référencement et le marketing numérique. Damir a été mentionné dans Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto et d'autres publications. Il voyage entre les Émirats arabes unis, la Turquie, la Russie et la CEI en tant que nomade numérique. Damir a obtenu un baccalauréat en physique, ce qui, selon lui, lui a donné les compétences de pensée critique nécessaires pour réussir dans le paysage en constante évolution d'Internet.