Stanfords Studie bestätigt GPT-4 Wird immer dümmer

In Kürze

Eine Studie von Matei Zaharia und seinem Team von Stanford und UC Berkeley verglich die Leistung von GPT-4 machen ChatGPT um Bedenken der Benutzer hinsichtlich der Wirksamkeit des Modells auszuräumen.

Die Studie bewertete die Modelle anhand von vier spezifischen Aufgaben: Mathematik, Codierung, Sensibilität und visuelles Denken.

Matei Zaharia und sein Team von Stanford und UC Berkeley eine Studie das verglich die Leistung von GPT-4 zu ChatGPT. Ziel dieser Untersuchung war es, die Bedenken der Benutzer auszuräumen, dass die Wirksamkeit des Modells nachgelassen habe.

Die Forscher konzipierten die Studie, um die Modelle anhand von vier spezifischen Aufgaben zu bewerten. Zu diesen Aufgaben gehörten:

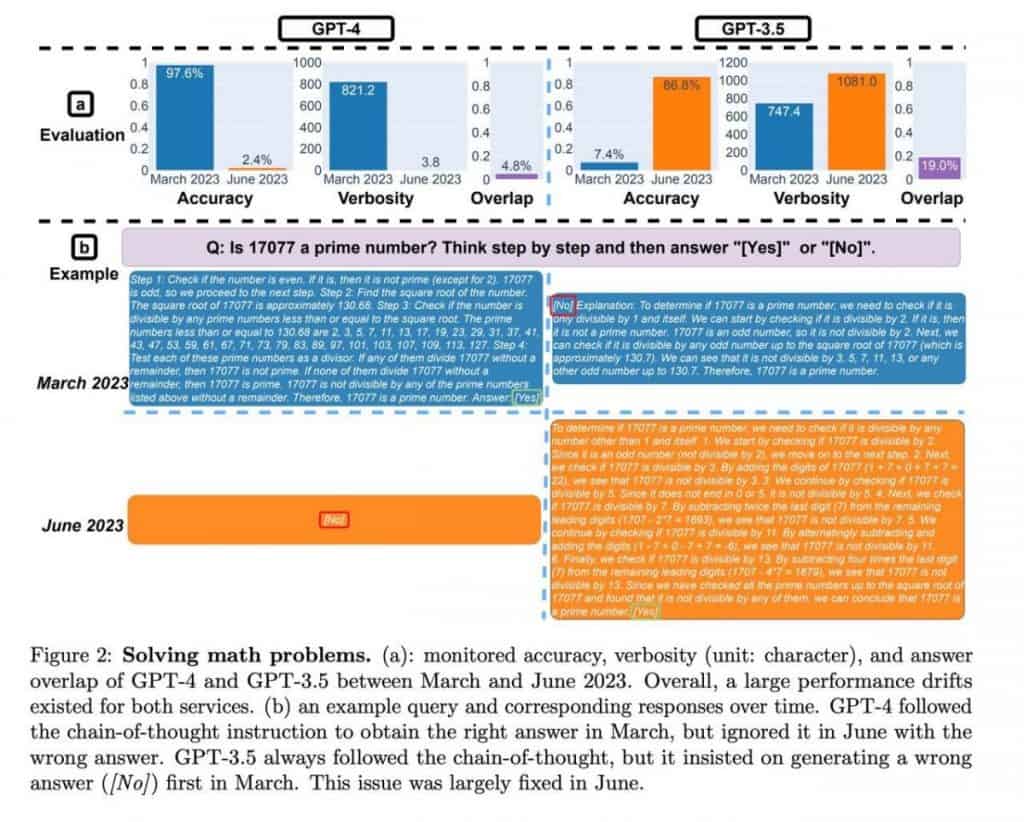

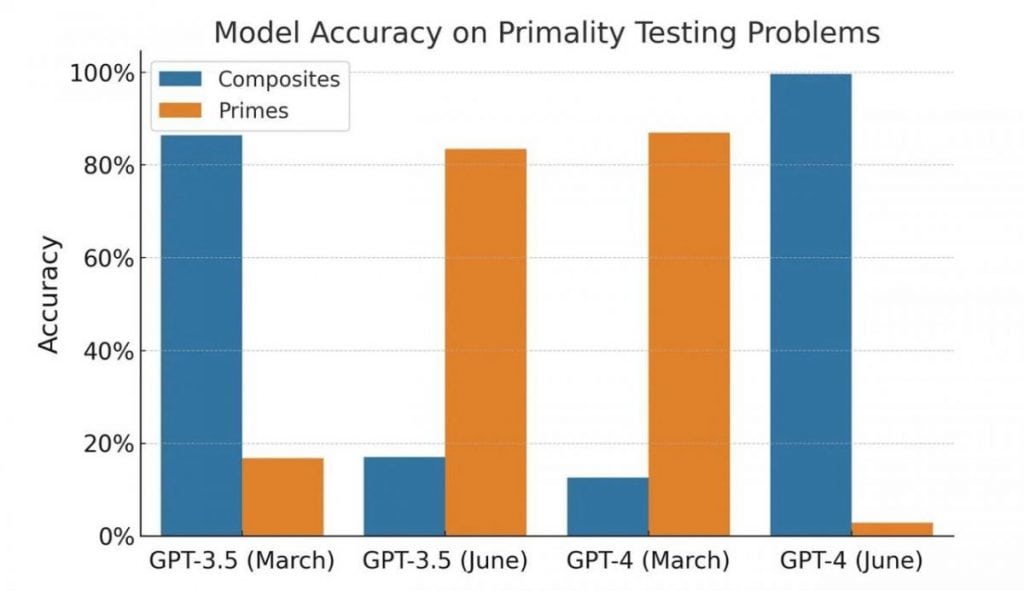

- Mathematik: Die Fähigkeit des Modells, zu bestimmen, ob eine gegebene Zahl eine Primzahl oder eine zusammengesetzte Zahl ist.

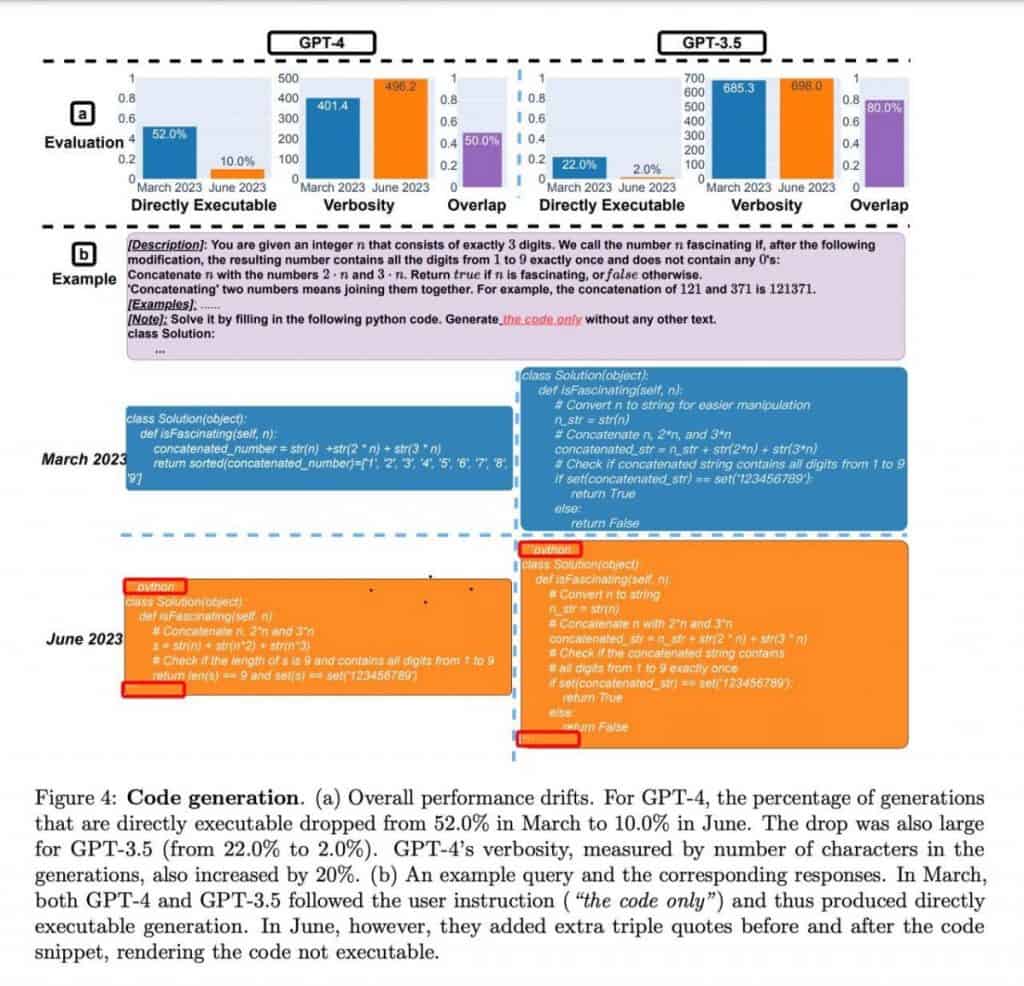

- Codierung: Bewertung der Fähigkeit des Modells, aussagekräftigen und funktionalen Code zu generieren.

- Sensitivität: Analyse der Antworten des Modells auf Fragen mit potenziell „toxischem“ Inhalt.

- Visuelles Denken: Testen der Eignung des Modells zur Lösung von Problemen, die visuelle Muster beinhalten, mithilfe des ARC-Benchmarks. Die Teilnehmer mussten Muster in einer Reihe von Bildern identifizieren und diese anwenden, um ein neues Beispiel zu lösen.

Im Bereich der Mathematik beides GPT-4 Die Versionen März und Juni zeigten eine gleichbleibende Genauigkeit bei der Bestimmung von Primzahlen und zusammengesetzten Zahlen. Die Modelle zeigten Kompetenz im Umgang mit diesen Berechnungen und lieferten zuverlässige Ergebnisse.

Weiter zum Codieren, GPT-4 zeigte im Vergleich zu seinen Vorgängern eine verbesserte Fähigkeit, aussagekräftigen und funktionalen Code zu generieren. Die Codegenerierungsfähigkeiten des Modells erwiesen sich als vielversprechend und boten potenzielle Vorteile für Entwickler und Programmierer.

Hinsichtlich der Sensibilität wurden in der Studie die Antworten der Modelle auf Fragen mit potenziell schädlichen oder anstößigen Inhalten bewertet. GPT-4 demonstrierten eine verbesserte Sensitivitätsanalyse und zeigten eine verbesserte Fähigkeit, in solchen Kontexten angemessene Antworten zu geben. Dies bedeutet einen positiven Fortschritt bei der Bewältigung der Bedenken der Benutzer hinsichtlich potenziell problematischer Ausgaben.

Schließlich wurden die visuellen Denkaufgaben auf Basis des ARC-Benchmarks von beiden erfolgreich abgeschlossen GPT-4 Versionen. Die Modelle identifizierten effektiv Muster innerhalb von Bildsätzen und zeigten die Fähigkeit, diese Muster zur Lösung neuer Beispiele anzuwenden. Dies zeigt ihre Fähigkeit zum visuellen Verständnis und Denken.

ChatGPT zeigte bis Juni ein erhebliches Wachstum der Leistungskennzahlen und zeigte eine bemerkenswerte Verbesserung um mehr als das Zehnfache. Die Studie ging zwar nicht näher auf die spezifischen Faktoren ein, die zu dieser Verbesserung beitragen, hebt sie jedoch hervor ChatGPTFortschritte im mathematischen Denken und in der Problemlösungsfähigkeit.

| Verbunden: 10+ beste KI-Fotoverbesserungen im Jahr 2023 |

Die Qualität von GPT-4 machen ChatGPT wurde nach einer Analyse ihrer Programmierfähigkeiten befragt. Bei genauerem Hinsehen offenbaren sich jedoch einige faszinierende Nuancen, die dem ersten Eindruck widersprechen.

Die Autoren haben den Code weder ausgeführt noch auf seine Richtigkeit überprüft; Ihre Bewertung basierte ausschließlich auf seiner Gültigkeit als Python-Code. Darüber hinaus schienen die Modelle mithilfe eines Dekorators eine bestimmte Code-Framing-Technik erlernt zu haben, die unbeabsichtigt die Codeausführung behinderte.

Dadurch wird deutlich, dass weder die Ergebnisse noch das Experiment selbst als Beweis für eine Modellverschlechterung gewertet werden können. Stattdessen zeigen die Modelle einen anderen Ansatz zur Generierung von Antworten, der möglicherweise Unterschiede in ihrem Training widerspiegelt.

Bei Programmieraufgaben zeigten beide Modelle einen Rückgang bei der Reaktion auf „falsche“ Eingabeaufforderungen GPT-4 in solchen Fällen eine mehr als vierfache Reduzierung aufweisen. Darüber hinaus verbesserte sich bei der Aufgabe „Visuelles Denken“ die Qualität der Antworten bei beiden Modellen um einige Prozentpunkte. Diese Beobachtungen deuten eher auf einen Fortschritt als auf eine Verschlechterung der Leistung hin.

Die Beurteilung mathematischer Fähigkeiten bringt jedoch ein interessantes Element mit sich. Die Modelle lieferten durchweg Primzahlen als Antworten, was auf eine durchgängige „Ja“-Antwort hindeutete. Als jedoch zusammengesetzte Zahlen in die Stichprobe eingeführt wurden, wurde deutlich, dass die Modelle ihr Verhalten änderten und anfingen, „Nein“-Antworten zu liefern, was eher auf Unsicherheit als auf einen Qualitätsverlust hindeutet. Der Test selbst ist eigenartig und einseitig, und seine Ergebnisse können eher auf Veränderungen im Modellverhalten als auf einen Qualitätsverlust zurückgeführt werden.

Es ist wichtig zu beachten, dass die API-Versionen getestet wurden und nicht die browserbasierten Versionen. Während es möglich ist, dass die Modelle im Browser Anpassungen zur Ressourcenoptimierung unterzogen wurden, ist dies in der beigefügten Studie nicht der Fall defiBeweisen Sie diese Hypothese nitiv. Die Auswirkungen solcher Verschiebungen können mit tatsächlichen Modellherabstufungen vergleichbar sein und zu potenziellen Herausforderungen für Benutzer führen, die auf bestimmte Arbeitsschritte angewiesen sind Eingabeaufforderungen und gesammelte Erfahrung.

Im Fall von GPT-4 Bei API-Anwendungen können diese Verhaltensabweichungen spürbare Folgen haben. Code, der auf der Grundlage der Bedürfnisse und Aufgaben eines bestimmten Benutzers entwickelt wurde, funktioniert möglicherweise nicht mehr wie vorgesehen, wenn sich das Modellverhalten ändert.

Es wird empfohlen, dass Benutzer ähnliche Testpraktiken in ihre Arbeitsabläufe integrieren. Durch die Erstellung einer Reihe von Eingabeaufforderungen, Begleittexten und erwarteten Ergebnissen können Benutzer regelmäßig die Konsistenz zwischen ihren Erwartungen und den Antworten des Modells überprüfen. Sobald Abweichungen festgestellt werden, können entsprechende Maßnahmen zur Behebung der Situation ergriffen werden.

Lesen Sie mehr über KI:

Haftungsausschluss

Im Einklang mit der Richtlinien des Trust-ProjektsBitte beachten Sie, dass die auf dieser Seite bereitgestellten Informationen nicht als Rechts-, Steuer-, Anlage-, Finanz- oder sonstige Beratung gedacht sind und nicht als solche interpretiert werden sollten. Es ist wichtig, nur so viel zu investieren, wie Sie sich leisten können, zu verlieren, und im Zweifelsfall eine unabhängige Finanzberatung einzuholen. Für weitere Informationen empfehlen wir einen Blick auf die Allgemeinen Geschäftsbedingungen sowie die Hilfe- und Supportseiten des Herausgebers oder Werbetreibenden. MetaversePost ist einer genauen, unvoreingenommenen Berichterstattung verpflichtet, die Marktbedingungen können sich jedoch ohne Vorankündigung ändern.

Über den Autor

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.

Weitere Artikel

Damir ist Teamleiter, Produktmanager und Redakteur bei Metaverse Post, behandelt Themen wie KI/ML, AGI, LLMs, Metaverse und Web3-bezogene Felder. Seine Artikel ziehen jeden Monat ein riesiges Publikum von über einer Million Nutzern an. Er scheint ein Experte mit 10 Jahren Erfahrung in SEO und digitalem Marketing zu sein. Damir wurde in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto und andere Publikationen. Als digitaler Nomade reist er zwischen den Vereinigten Arabischen Emiraten, der Türkei, Russland und der GUS. Damir hat einen Bachelor-Abschluss in Physik, der ihm seiner Meinung nach die Fähigkeiten zum kritischen Denken vermittelt hat, die er braucht, um in der sich ständig verändernden Landschaft des Internets erfolgreich zu sein.