As 10 melhores placas gráficas para ML/AI: a melhor GPU para aprendizado profundo

A seleção de uma placa gráfica apropriada desempenha um papel crucial na obtenção de desempenho ideal para processamento de grandes conjuntos de dados e realização de cálculos paralelos. Particularmente para tarefas que envolvem treinamento de redes neurais profundas, a demanda por matriz intensiva e processamento tensor é fundamental. Vale a pena notar que chips AI especializados, TPUs e FPGAs ganharam popularidade considerável nos últimos tempos.

Principais características para placas gráficas de aprendizado de máquina

Ao considerar uma placa gráfica para fins de aprendizado de máquina, vários recursos essenciais devem ser levados em consideração:

- Poder de computação:

O número de núcleos ou processadores afeta diretamente os recursos de processamento paralelo da placa gráfica. Uma contagem de núcleos mais alta se traduz em cálculos mais rápidos e eficientes. - Capacidade de memória da GPU:

Ampla capacidade de memória é crucial para lidar efetivamente com grandes conjuntos de dados e modelos complexos. A capacidade de armazenar e acessar dados com eficiência é vital para alcançar o desempenho ideal. - Apoio a Bibliotecas Especializadas:

A compatibilidade de hardware com bibliotecas especializadas como CUDA ou ROCm pode acelerar significativamente o modelo processos de treinamento. Aproveitar as otimizações específicas de hardware simplifica os cálculos e aumenta a eficiência geral. - Suporte de alto desempenho:

Placas gráficas com memória rápida e configurações de barramento de memória ampla oferecem recursos de alto desempenho durante o treinamento do modelo. Esses recursos garantem um processamento de dados suave e rápido. - Compatibilidade com estruturas de aprendizado de máquina:

Garantir a compatibilidade perfeita entre a placa gráfica selecionada e as estruturas de aprendizado de máquina e ferramentas de desenvolvedor empregadas é essencial. A compatibilidade garante integração suave e utilização otimizada de recursos.

Tabela de comparação de placas gráficas para ML/AI

| Placa | Memória, GB | Cursos de CUDA | Núcleos Tensores | Preço, USD |

|---|---|---|---|---|

| Tesla V100 | 16/32 | 5120 | 640 | 14,999 |

| Tesla A100 | 40/80 | 7936 | 432 | 10,499 |

| Quadro RTX 8000 | 48 | 4608 | 576 | 7,999 |

| Uma 6000 Ada | 48 | 18176 | 568 | 6,499 |

| RTX A5000 | 24 | 8192 | 256 | 1,899 |

| RTX 3090TI | 24 | 10752 | 336 | 1,799 |

| RTX 4090 | 24 | 16384 | 512 | 1,499 |

| RTX 3080TI | 12 | 10240 | 320 | 1,399 |

| RTX 4080 | 16 | 9728 | 304 | 1,099 |

| RTX 4070 | 12 | 7680 | 184 | 599 |

NVIDIA Tesla V100

O Tesla V100 da NVIDIA se destaca como uma poderosa GPU Tensor Core adaptada para IA, computação de alto desempenho (HPC) e cargas de trabalho de aprendizado de máquina. Aproveitando a arquitetura Volta de ponta, esta placa gráfica apresenta excelentes capacidades de desempenho, oferecendo um impressionante desempenho de 125 trilhões de operações de ponto flutuante por segundo (TFLOPS). Neste artigo, exploraremos os notáveis benefícios e considerações associados ao Tesla V100.

Vantagens do Tesla V100:

- Alta performance:

Aproveitando o poder da arquitetura Volta e seus 5120 núcleos CUDA, o Tesla V100 oferece desempenho excepcional para tarefas de aprendizado de máquina. Sua capacidade de lidar com conjuntos de dados extensos e executar cálculos complexos em velocidades notáveis é fundamental para conduzir fluxos de trabalho de aprendizado de máquina eficientes. - Grande capacidade de memória:

Com 16 GB de memória HBM2, o Tesla V100 capacita o processamento eficiente de volumes de dados substanciais durante o treinamento do modelo. Esse atributo é particularmente vantajoso ao trabalhar com conjuntos de dados extensos, permitindo a manipulação contínua de dados. Além disso, a largura do barramento de memória de vídeo de 4096 bits facilita a transferência de dados em alta velocidade entre o processador e a memória de vídeo, aprimorando ainda mais o desempenho do treinamento e inferência do modelo de aprendizado de máquina. - Tecnologias de aprendizado profundo:

O Tesla V100 está equipado com várias tecnologias de aprendizado profundo, incluindo Tensor Cores, que agilizam os cálculos de ponto flutuante. Essa aceleração contribui para reduções significativas no tempo de treinamento do modelo, melhorando o desempenho geral. - Flexibilidade e escalabilidade:

A versatilidade do Tesla V100 é evidente em sua compatibilidade com sistemas de desktop e servidor. Ele se integra perfeitamente a uma ampla variedade de estruturas de aprendizado de máquina, como TensorFlow, PyTorch, Caffe e muito mais, oferecendo aos desenvolvedores a liberdade de escolher suas ferramentas preferidas para desenvolvimento e treinamento de modelos.

Considerações para Tesla V100:

- Alto custo:

Como uma solução de nível profissional, a NVIDIA Tesla V100 tem um preço correspondente. Com um custo de US$ 14,447, pode representar um investimento substancial para indivíduos ou pequenas equipes de aprendizado de máquina. O preço deve ser levado em consideração ao considerar o orçamento geral e os requisitos. - Consumo de energia e refrigeração:

Dado o desempenho robusto do Tesla V100, ele exige uma fonte de alimentação significativa e gera calor substancial. Medidas adequadas de resfriamento precisam ser implementadas para manter as temperaturas operacionais ideais, o que pode levar ao aumento do consumo de energia e custos associados. - Requisitos de infraestrutura:

Para aproveitar totalmente os recursos do Tesla V100, é necessária uma infraestrutura compatível. Isso inclui um processador poderoso e RAM suficiente para garantir eficiência processamento de dados e treinamento de modelo.

Conclusão:

A NVIDIA A100, equipada com a arquitetura Ampere de ponta, representa um avanço significativo na tecnologia de GPU para aplicativos de aprendizado de máquina. Com seus recursos de alto desempenho, grande capacidade de memória e suporte para tecnologia NVLink, o A100 capacita cientistas de dados e pesquisadores para lidar com tarefas complexas de aprendizado de máquina com eficiência e precisão. No entanto, o alto custo, consumo de energia e compatibilidade de software devem ser avaliados cuidadosamente antes de adotar a NVIDIA A100. Com seus avanços e descobertas, o A100 abre novas possibilidades para treinamento e inferência de modelos acelerados, abrindo caminho para novos avanços no campo do aprendizado de máquina.

NVIDIATesla A100

A NVIDIA A100, alimentada pela arquitetura Ampere de última geração, se destaca como uma placa gráfica notável projetada para atender às demandas de tarefas de aprendizado de máquina. Oferecendo desempenho e flexibilidade excepcionais, o A100 representa um avanço significativo na tecnologia de GPU. Neste artigo, exploraremos os notáveis benefícios e considerações associados à NVIDIA A100.

Prós da NVIDIA A100:

- Alta performance:

Equipado com um número substancial de núcleos CUDA (4608), o NVIDIA A100 oferece recursos de desempenho impressionantes. Seu poder computacional aprimorado permite fluxos de trabalho de aprendizado de máquina acelerados, resultando em treinamento de modelos e processos de inferência mais rápidos. - Grande capacidade de memória:

A placa gráfica NVIDIA A100 possui 40 GB de memória HBM2, facilitando o manuseio eficiente de grandes quantidades de dados durante treinamento de modelo de aprendizado profundo. Essa grande capacidade de memória é particularmente vantajosa para trabalhar com conjuntos de dados complexos e de grande escala, permitindo um processamento de dados suave e contínuo. - Suporte para tecnologia NVLink:

A inclusão da tecnologia NVLink permite que várias placas gráficas NVIDIA A100 sejam perfeitamente combinadas em um único sistema, facilitando a computação paralela. Esse paralelismo aprimorado melhora significativamente o desempenho e acelera o treinamento do modelo, contribuindo para fluxos de trabalho de aprendizado de máquina mais eficientes.

Considerações para NVIDIA A100:

- Alto custo:

Como uma das placas gráficas mais poderosas e avançadas disponíveis no mercado, a NVIDIA A100 vem com um preço mais alto. Com um preço de $ 10,000, pode ser um investimento substancial para indivíduos ou organizações que consideram sua adoção. - Consumo de energia:

Utilizar todo o potencial da placa gráfica NVIDIA A100 requer uma fonte de alimentação significativa. Isso pode levar ao aumento do consumo de energia e exigir medidas apropriadas para gerenciamento de energia, especialmente ao implantar o cartão em grande escala centros de dados. - Compatibilidade de Software:

Para garantir o desempenho ideal, a NVIDIA A100 conta com software e drivers apropriados. É importante observar que alguns programas e estruturas de aprendizado de máquina podem não suportar totalmente esse modelo de placa gráfica específico. Considerações de compatibilidade devem ser levadas em consideração ao integrar o NVIDIA A100 em fluxos de trabalho de aprendizado de máquina existentes.

Conclusão:

O Tesla V100, com sua arquitetura Volta e recursos de ponta, é uma impressionante GPU Tensor Core projetada para cargas de trabalho de AI, HPC e Machine Learning. Seus recursos de alto desempenho, grande capacidade de memória, tecnologias de aprendizado profundo e flexibilidade o tornam uma escolha atraente para organizações e pesquisadores que buscam projetos avançados de aprendizado de máquina. No entanto, considerações como custo, consumo de energia e requisitos de infraestrutura devem ser cuidadosamente avaliadas para garantir um investimento bem alinhado. Com o Tesla V100, o potencial para inovações em IA e aprendizado de máquina está ao seu alcance, capacitando cientistas de dados e pesquisadores para ultrapassar os limites da inovação.

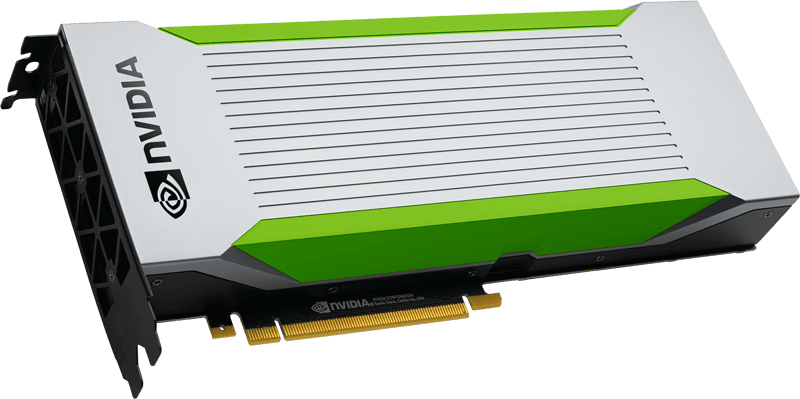

NVIDIA Quadro RTX 8000

A Quadro RTX 8000 se destaca como uma poderosa placa gráfica projetada especificamente para profissionais que precisam de recursos de renderização excepcionais. Com seus recursos avançados e especificações de alto desempenho, esta placa gráfica oferece benefícios práticos para várias aplicações, incluindo visualização de dados, computação gráfica e aprendizado de máquina. Neste artigo, exploraremos os recursos diferenciados e as vantagens da Quadro RTX 8000.

Prós da Quadro RTX 8000:

- Alta performance:

A Quadro RTX 8000 possui uma GPU poderosa e impressionantes 5120 núcleos CUDA, proporcionando desempenho incomparável para tarefas de renderização exigentes. Seu poder computacional excepcional permite que os profissionais renderizem modelos complexos com sombras, reflexos e refrações realistas, proporcionando resultados realistas e experiências visuais imersivas. - Suporte para Ray Tracing:

Ray tracing acelerado por hardware é um recurso de destaque da Quadro RTX 8000. Essa tecnologia permite a criação de imagens fotorrealistas e efeitos de iluminação realistas. Para profissionais envolvidos em visualização de dados, computação gráfica ou aprendizado de máquina, esse recurso adiciona um nível de realismo e fidelidade visual ao seu trabalho, aprimorando a qualidade geral de seus projetos. - Grande capacidade de memória:

A Quadro RTX 8000 oferece amplos 48 GB de memória gráfica GDDR6. Esta grande capacidade de memória permite uma eficiente armazenamento e recuperação de dados, principalmente ao trabalhar com modelos e conjuntos de dados de aprendizado de máquina em larga escala. Os profissionais podem realizar cálculos complexos e lidar com quantidades substanciais de dados sem comprometer o desempenho ou a eficiência. - Suporte de biblioteca e estrutura:

A compatibilidade com bibliotecas e estruturas populares de aprendizado de máquina, incluindo TensorFlow, PyTorch, CUDA, cuDNN e muito mais, garante uma integração perfeita com os fluxos de trabalho existentes. Os profissionais podem aproveitar o poder da Quadro RTX 8000 com suas ferramentas e estruturas preferidas, permitindo o desenvolvimento e o treinamento eficientes de modelos de aprendizado de máquina.

Considerações para Quadro RTX 8000:

- Alto custo:

Como um acelerador gráfico profissional, o Quadro RTX 8000 vem com um preço mais alto em comparação com outras placas gráficas. Seu custo real é de US$ 8,200, o que pode torná-lo menos acessível para usuários individuais ou operações de pequena escala.

Conclusão:

A Quadro RTX 8000 estabelece uma referência para renderização gráfica de alto desempenho em aplicativos profissionais. Com sua poderosa GPU, suporte para rastreamento de raios, grande capacidade de memória e compatibilidade com bibliotecas e estruturas populares de aprendizado de máquina, a Quadro RTX 8000 capacita os profissionais a criar modelos, visualizações e simulações visualmente impressionantes e realistas. Embora o custo mais alto possa representar um desafio para alguns, os benefícios dessa placa de vídeo a tornam um ativo valioso para profissionais que precisam de desempenho e capacidade de memória de alto nível. Com a Quadro RTX 8000, os profissionais podem liberar seu potencial criativo e ultrapassar os limites de seu trabalho nas áreas de visualização de dados, computação gráfica e aprendizado de máquina.

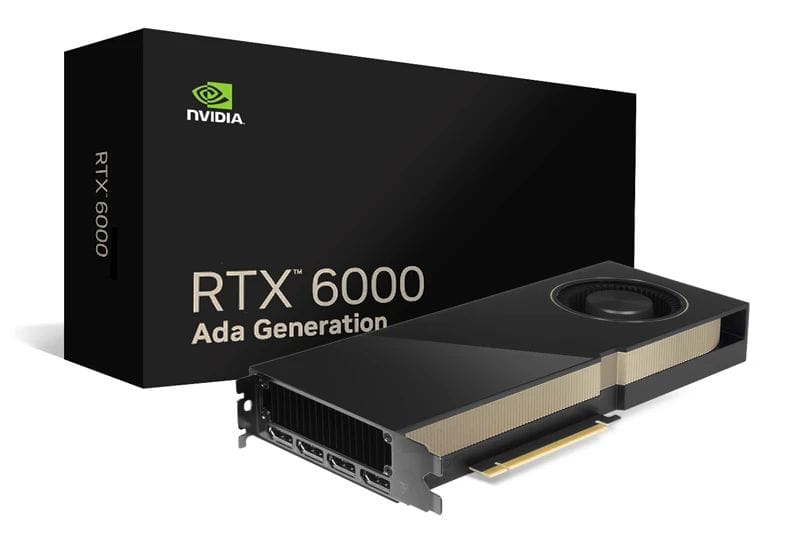

NVIDIA RTX A6000 Ada

A placa de vídeo RTX A6000 Ada se destaca como uma opção atraente para profissionais em busca de uma solução poderosa e com baixo consumo de energia. Com seus recursos avançados, incluindo a arquitetura Ada Lovelace, núcleos CUDA de alto desempenho e ampla capacidade de VRAM, o RTX A6000 Ada oferece benefícios práticos para uma variedade de aplicativos profissionais. Neste artigo, exploraremos os recursos diferenciadores e as vantagens do RTX A6000 Ada.

Prós da RTX A6000 Ada:

- Alta performance:

O RTX A6000 Ada aproveita o poder da arquitetura Ada Lovelace, incorporando núcleos RT de terceira geração, núcleos Tensor de quarta geração e núcleos CUDA de próxima geração. Esses avanços na arquitetura contribuem para um desempenho excepcional, permitindo que os profissionais realizem tarefas exigentes com facilidade. Com 48 GB de VRAM, a placa gráfica oferece ampla memória para manipulação eficiente de grandes conjuntos de dados durante o treinamento do modelo. - Grande capacidade de memória:

Equipado com 48 GB de memória, o RTX A6000 Ada garante o processamento eficiente de grandes volumes de dados. Essa capacidade de memória expansiva permite que os profissionais treinem modelos complexos de aprendizado de máquina e trabalhem com conjuntos de dados massivos sem comprometer o desempenho ou a eficiência. A capacidade de lidar com grandes cargas de dados contribui para um treinamento de modelo mais rápido e preciso. - Baixo consumo de energia:

O RTX A6000 Ada enfatiza a eficiência energética, tornando-o a escolha ideal para profissionais preocupados com o consumo de energia. Ao otimizar o uso de energia, esta placa gráfica reduz os custos de energia e contribui para um ambiente de trabalho mais sustentável e econômico.

Considerações para RTX A6000 Ada:

- Alto custo:

O RTX A6000 Ada, com seu desempenho e recursos impressionantes, tem um preço mais alto. Com um preço aproximado de $ 6,800, esta placa gráfica pode ser um investimento significativo para usuários individuais ou organizações menores. No entanto, o desempenho superior e a eficiência que oferece justificam seu valor para profissionais que buscam ótimos resultados.

Conclusão:

A RTX A6000 Ada surge como uma excelente escolha de placa gráfica para profissionais que buscam maximizar o desempenho e a eficiência. Com sua arquitetura avançada, capacidade substancial de VRAM e baixo consumo de energia, esta placa gráfica oferece resultados excepcionais em uma variedade de aplicativos profissionais. A arquitetura Ada Lovelace, juntamente com núcleos CUDA de última geração e alta capacidade de memória, garante computação de alto desempenho e manuseio eficiente de grandes conjuntos de dados. Embora o RTX A6000 Ada tenha um custo mais alto, seus benefícios e recursos o tornam um ativo valioso para profissionais comprometidos em alcançar os melhores resultados em seu trabalho. Com o RTX A6000 Ada, os profissionais podem liberar todo o seu potencial e elevar seu desempenho em vários domínios, incluindo aprendizado de máquina, análise de dados e computação gráfica.

Nvidia RTX A5000

A RTX A5000, construída na arquitetura NVIDIA Ampere, surge como uma poderosa placa gráfica projetada para acelerar as tarefas de aprendizado de máquina. Com seus recursos robustos e recursos de alto desempenho, o RTX A5000 oferece benefícios práticos e vantagens distintas para profissionais da área. Neste artigo, vamos nos aprofundar nos recursos diferenciadores do RTX A5000 e seu possível impacto em aplicativos de aprendizado de máquina.

Prós da RTX A5000:

- Alta performance:

Equipado com 8192 núcleos CUDA e 256 núcleos tensores, o RTX A5000 possui um poder de processamento excepcional. Essa arquitetura de alto desempenho permite o processamento rápido e eficiente de grandes conjuntos de dados, permitindo um treinamento mais rápido de modelos de aprendizado de máquina. A abundância de núcleos CUDA e a alta largura de banda de memória contribuem para cálculos suaves e acelerados, facilitando operações complexas em fluxos de trabalho de aprendizado de máquina. - Suporte de aceleração de hardware AI:

A placa de vídeo RTX A5000 fornece aceleração de hardware para operações e algoritmos relacionados à IA. Com seu design otimizado, o cartão pode melhorar significativamente o desempenho das tarefas de IA, proporcionando resultados mais rápidos e eficientes. Ao aproveitar o poder da aceleração de hardware de IA dedicada, os profissionais podem simplificar seus fluxos de trabalho de aprendizado de máquina e obter maior produtividade. - Grande capacidade de memória:

Com 24 GB de GDDR6 VRAM, o RTX A5000 oferece ampla memória para lidar com grandes conjuntos de dados e modelos complexos de aprendizado de máquina. Essa ampla capacidade de memória permite que os profissionais trabalhem com tarefas intensivas em dados sem comprometer o desempenho ou a eficiência. A disponibilidade de VRAM abundante garante acesso fácil aos dados e treinamento mais rápido, permitindo um desenvolvimento de modelo mais preciso e abrangente. - Suporte de estrutura de aprendizado de máquina:

O RTX A5000 integra-se perfeitamente com estruturas populares de aprendizado de máquina, como TensorFlow e PyTorch. Com seus drivers e bibliotecas otimizados, a placa gráfica permite que desenvolvedores e pesquisadores aproveitem totalmente os recursos dessas estruturas. Essa compatibilidade garante a utilização eficiente dos recursos do RTX A5000, capacitando os profissionais a desenvolver e treinar modelos de aprendizado de máquina com facilidade.

Considerações para RTX A5000:

- Consumo de energia e refrigeração:

É importante observar que as placas gráficas desse calibre normalmente consomem uma quantidade significativa de energia e geram calor substancial durante a operação. Para garantir desempenho e longevidade ideais, medidas adequadas de resfriamento e uma capacidade de fonte de alimentação suficiente devem estar em vigor. Essas precauções garantem a utilização eficiente e confiável do RTX A5000 em ambientes exigentes de aprendizado de máquina.

Conclusão:

A RTX A5000 se destaca como uma placa de vídeo poderosa, feita sob medida para atender às exigentes necessidades dos profissionais de aprendizado de máquina. Com seus recursos avançados, incluindo um grande número de núcleos CUDA, suporte para aceleração de hardware AI e ampla capacidade de memória, o RTX A5000 oferece desempenho excepcional para processar grandes quantidades de dados e treinar modelos complexos. Sua integração perfeita com estruturas populares de aprendizado de máquina aprimora ainda mais sua usabilidade e versatilidade. Embora considerações como consumo de energia e resfriamento sejam cruciais, infraestrutura e precauções adequadas podem garantir a utilização efetiva dos recursos do RTX A5000. Com o RTX A5000, os profissionais podem desbloquear novas possibilidades em aprendizado de máquina e impulsionar sua pesquisa, desenvolvimento e implantação de modelos inovadores.

NVIDIA RTX 4090

A placa de vídeo NVIDIA RTX 4090 surge como uma poderosa solução sob medida para atender às demandas da última geração de redes neurais. Com seu excelente desempenho e recursos avançados, o RTX 4090 oferece benefícios práticos e se destaca como uma opção confiável para profissionais da área. Neste artigo, exploraremos os principais recursos do RTX 4090 e seu impacto potencial na aceleração de modelos de aprendizado de máquina.

Prós da NVIDIA RTX 4090:

- Desempenho excepcional:

Equipado com tecnologia de ponta, o NVIDIA RTX 4090 oferece desempenho excepcional que permite o manuseio eficiente de cálculos complexos e grandes conjuntos de dados. A placa gráfica aproveita sua poderosa arquitetura para acelerar o treinamento de modelos de aprendizado de máquina, facilitando resultados mais rápidos e precisos. Os recursos de alto desempenho do RTX 4090 permitem que os profissionais enfrentem tarefas desafiadoras e obtenham maior produtividade em seus projetos de rede neural.

Considerações para a NVIDIA RTX 4090:

- Desafios de resfriamento:

A intensa geração de calor da NVIDIA RTX 4090 pode apresentar desafios em termos de resfriamento. Devido à natureza de alto desempenho do cartão, é essencial garantir que medidas de resfriamento adequadas sejam implementadas para evitar o superaquecimento. Os usuários devem estar cientes de que, em configurações com vários cartões, os requisitos de dissipação de calor tornam-se ainda mais críticos para manter o desempenho ideal e evitar desligamentos automáticos acionados ao atingir temperaturas críticas. - Limitações de configuração:

O design da GPU da NVIDIA RTX 4090 impõe certas limitações no número de placas que podem ser instaladas em uma estação de trabalho. Essa restrição pode afetar usuários que precisam de várias placas RTX 4090 para seus projetos. A consideração cuidadosa da configuração e compatibilidade da estação de trabalho é necessária para garantir a utilização ideal dos recursos do RTX 4090.

Conclusão:

A placa gráfica NVIDIA RTX 4090 é uma escolha poderosa para profissionais que buscam alimentar a última geração de redes neurais. Com seu excelente desempenho e manuseio eficiente de cálculos complexos e grandes conjuntos de dados, o RTX 4090 acelera o treinamento de modelos de aprendizado de máquina, abrindo novas possibilidades para pesquisadores e desenvolvedores da área. No entanto, os usuários devem estar atentos aos desafios de resfriamento associados ao intenso calor gerado pelo cartão, especialmente em configurações com vários cartões. Além disso, as limitações de configuração devem ser levadas em consideração ao considerar a instalação de várias placas RTX 4090 em uma estação de trabalho. Ao aproveitar os recursos da NVIDIA RTX 4090 e abordar essas considerações, os profissionais podem otimizar seus projetos de rede neural e desbloquear novas fronteiras nos avanços do aprendizado de máquina.

NVIDIA RTX 4080

A placa gráfica RTX 4080 surgiu como uma solução poderosa e eficiente no campo da inteligência artificial. Com seu alto desempenho e preço razoável, o RTX 4080 apresenta uma opção atraente para desenvolvedores que desejam maximizar o potencial de seu sistema. Neste artigo, vamos nos aprofundar nos recursos diferenciados e nos benefícios práticos do RTX 4080, explorando seu impacto na aceleração de tarefas de aprendizado de máquina.

Prós do RTX 4080:

- Alta performance:

O RTX 4080 possui impressionantes 9728 núcleos NVIDIA CUDA, permitindo que ele forneça um poder de computação excepcional para tarefas de aprendizado de máquina. Essa capacidade de alto desempenho, combinada com a presença de núcleos tensores e suporte para rastreamento de raios, contribui para um processamento de dados mais eficiente e maior precisão em operações relacionadas à IA. Os desenvolvedores podem aproveitar o poder do RTX 4080 para lidar com cálculos complexos e grandes conjuntos de dados, otimizando seus fluxos de trabalho de aprendizado de máquina. - Preços competitivos:

Com um preço de US$ 1,199, o RTX 4080 oferece uma proposta atraente para indivíduos e pequenas equipes que buscam uma solução produtiva de aprendizado de máquina. Sua combinação de preço acessível e alto desempenho o torna uma opção acessível para desenvolvedores que procuram aproveite os benefícios da IA sem quebrar o banco.

Considerações para o RTX 4080:

- Limitação SLI:

É importante observar que o RTX 4080 não suporta NVIDIA NVLink com função SLI. Essa limitação implica que os usuários não podem combinar várias placas RTX 4080 no modo SLI para aprimorar ainda mais o desempenho. Embora isso possa restringir a escalabilidade da placa gráfica em determinadas configurações, isso não diminui seus recursos autônomos no fornecimento de processamento de IA eficiente.

Conclusão:

A placa de vídeo RTX 4080 é uma escolha atraente para desenvolvedores que buscam desbloquear recursos de IA de alto desempenho. Com suas especificações robustas, incluindo 9728 núcleos NVIDIA CUDA, núcleos tensores e suporte para rastreamento de raios, o RTX 4080 oferece uma solução prática para acelerar tarefas de aprendizado de máquina. Além disso, seu preço competitivo de US$ 1,199 o torna uma opção acessível para indivíduos e pequenas equipes, permitindo que aproveitem o poder da IA sem um ônus financeiro significativo. Embora a ausência de suporte SLI restrinja as configurações de várias placas, ela não diminui o desempenho e a eficiência autônomos do RTX 4080. Ao adotar as vantagens do RTX 4080, os desenvolvedores podem elevar seus projetos de aprendizado de máquina e alcançar novos avanços em inteligência artificial avanços.

NVIDIA RTX 4070

A placa de vídeo NVIDIA RTX 4070, construída sobre a inovadora arquitetura Ada Lovelace, vem fazendo ondas no reino do aprendizado de máquina. Com sua capacidade de memória de 12 GB, esta placa gráfica oferece acesso acelerado a dados e velocidades de treinamento aprimoradas para modelos de aprendizado de máquina. Neste artigo, vamos nos aprofundar nos benefícios práticos e nos recursos diferenciados da NVIDIA RTX 4070, destacando sua adequação para pessoas que estão entrando no campo do aprendizado de máquina.

Prós da NVIDIA RTX 4070:

- Alta performance:

A NVIDIA RTX 4070 combina o poder de 7680 núcleos CUDA e 184 núcleos tensores, fornecendo aos usuários uma capacidade de processamento louvável para operações complexas. A capacidade de memória de 12 GB permite o manuseio eficiente de grandes conjuntos de dados, permitindo fluxos de trabalho contínuos em tarefas de aprendizado de máquina. - Baixo consumo de energia:

Operando com apenas 200 W, a placa de vídeo NVIDIA RTX 4070 exibe eficiência energética excepcional. Seu baixo consumo de energia garante que os usuários possam desfrutar de um poderoso desempenho de aprendizado de máquina sem sobrecarregar excessivamente seus sistemas ou incorrer em custos exorbitantes de energia. - Solução econômica:

Com um preço de $ 599, a placa de vídeo NVIDIA RTX 4070 apresenta uma opção acessível para indivíduos que buscam explorar e aprender aprendizado de máquina. Apesar do preço atrativo, a placa não abre mão do desempenho, tornando-se uma excelente opção para quem tem orçamento limitado.

Considerações para a NVIDIA RTX 4070:

- Capacidade de memória limitada:

Embora a capacidade de memória de 4070 GB da NVIDIA RTX 12 seja suficiente para muitos aplicativos de aprendizado de máquina, é importante reconhecer que ela pode apresentar limitações ao trabalhar com conjuntos de dados excepcionalmente grandes. Os usuários devem avaliar seus requisitos específicos e determinar se a capacidade de memória de 12 GB se alinha com suas necessidades. - Ausência de suporte NVIDIA NVLink e SLI:

A placa gráfica NVIDIA RTX 4070 não oferece suporte à tecnologia NVIDIA NVLink, que permite a vinculação de várias placas em um sistema de processamento paralelo. Como resultado, a escalabilidade e o desempenho podem ser limitados em configurações com várias placas. Os usuários que consideram tais configurações devem explorar opções alternativas que atendam aos seus requisitos específicos.

Conclusão:

A placa gráfica NVIDIA RTX 4070 surge como uma solução eficiente e econômica para indivíduos que se aventuram no domínio do aprendizado de máquina. Com sua arquitetura Ada Lovelace, capacidade de memória de 12 GB e poder de processamento substancial, ele oferece um desempenho impressionante que capacita os usuários a lidar com operações complexas de aprendizado de máquina. Além disso, o baixo consumo de energia de 200 W da placa garante um uso eficiente de energia, atenuando a tensão nos sistemas e reduzindo os custos de energia. Com um preço de $ 599, a NVIDIA RTX 4070 oferece um ponto de entrada acessível para pessoas que buscam se aprofundar no aprendizado de máquina sem gastar muito.

NVIDIA GeForce RTX 3090TI

A NVIDIA GeForce RTX 3090 TI chamou a atenção como uma GPU para jogos que também possui recursos impressionantes para tarefas de aprendizado profundo. Com seu desempenho máximo de precisão única (FP32) de 13 teraflops, 24 GB de VRAM e 10,752 núcleos CUDA, esta placa gráfica oferece desempenho e versatilidade excepcionais. Neste artigo, exploraremos os benefícios práticos e os recursos distintos da NVIDIA GeForce RTX 3090 TI, destacando sua adequação tanto para entusiastas de jogos quanto para praticantes de aprendizado profundo.

Prós da NVIDIA GeForce RTX 3090 TI:

- Alta performance:

Equipada com a arquitetura Ampere e impressionantes 10,752 núcleos CUDA, a NVIDIA GeForce RTX 3090 TI oferece desempenho excepcional. Isso permite que os usuários resolvam problemas complexos de aprendizado de máquina com facilidade, permitindo cálculos mais rápidos e eficientes. - Aceleração de aprendizado de hardware:

A RTX 3090 TI suporta a tecnologia Tensor Cores, que facilita as operações de rede neural aceleradas por hardware. Ao aproveitar o Tensor Cores, os usuários podem experimentar melhorias significativas de velocidade no treinamento de modelos de aprendizado profundo. Esse avanço contribui para aumentar a produtividade e reduzir os tempos de treinamento do modelo. - Grande capacidade de memória:

Com 24 GB de memória GDDR6X, a NVIDIA GeForce RTX 3090 TI oferece amplo espaço de armazenamento para lidar com grandes quantidades de dados de memória. Essa capacidade minimiza a necessidade de leituras e gravações frequentes em disco, resultando em fluxos de trabalho mais suaves e maior eficiência, principalmente ao trabalhar com conjuntos de dados extensos.

Considerações para a NVIDIA GeForce RTX 3090 TI:

- Consumo de energia:

A NVIDIA GeForce RTX 3090 TI exige uma quantidade substancial de energia, com uma classificação de consumo de energia de 450 W. Como resultado, é crucial garantir uma fonte de alimentação robusta para suportar a operação do cartão. O alto consumo de energia pode levar ao aumento dos custos de energia e limitar a compatibilidade do cartão com determinados sistemas, principalmente ao implantar vários cartões em configurações de computação paralela. - Compatibilidade e Suporte:

Embora a NVIDIA GeForce RTX 3090 TI seja uma placa gráfica poderosa, pode haver considerações de compatibilidade e suporte com determinadas plataformas de software e bibliotecas de aprendizado de máquina. Os usuários devem verificar a compatibilidade e estar preparados para fazer os ajustes ou atualizações necessários para utilizar totalmente os recursos do cartão em seus ambientes de software específicos.

Conclusão:

A NVIDIA GeForce RTX 3090 TI se destaca como uma impressionante GPU para jogos que também se destaca em aplicativos de aprendizado profundo. Com sua poderosa arquitetura Ampere, extensa contagem de núcleos CUDA e recursos de aceleração de aprendizado de hardware, ele capacita os usuários a lidar com tarefas complexas de aprendizado de máquina com eficiência. Além disso, sua substancial capacidade de memória de 24 GB minimiza os gargalos na transferência de dados, facilitando operações contínuas mesmo com grandes conjuntos de dados.

NVIDIA GeForce RTX 3080TI

A NVIDIA GeForce RTX 3080 TI emergiu como uma placa gráfica de gama média altamente capaz que oferece desempenho impressionante para tarefas de aprendizado de máquina. Com suas especificações robustas, incluindo a arquitetura Ampere, 8704 núcleos CUDA e 12 GB de memória GDDR6X, esta placa oferece poder de processamento substancial. Neste artigo, vamos nos aprofundar nos benefícios práticos e nos diferenciais da NVIDIA GeForce RTX 3080 TI, destacando sua proposta de valor para usuários que buscam alto desempenho sem gastar muito.

Prós da NVIDIA GeForce RTX 3080 TI:

- Desempenho Poderoso:

Equipada com a arquitetura Ampere e com 8704 núcleos CUDA, a NVIDIA GeForce RTX 3080 TI oferece poder de processamento excepcional. Isso permite que os usuários lidem com tarefas exigentes de aprendizado de máquina com facilidade, acelerando os cálculos e reduzindo o tempo de treinamento. - Aceleração de aprendizado de hardware:

A inclusão de Tensor Cores na placa gráfica permite operações de rede neural aceleradas por hardware. Aproveitar os Tensor Cores se traduz em aceleração significativa ao executar tarefas de rede neural, resultando em treinamento mais rápido de modelos de aprendizado profundo. Esse avanço aumenta a produtividade e facilita iterações de modelo mais rápidas. - Preço relativamente acessível:

Com um preço de $ 1499, a NVIDIA GeForce RTX 3080 TI oferece uma opção relativamente acessível para usuários que buscam recursos poderosos de aprendizado de máquina. Esta placa intermediária oferece um equilíbrio ideal entre desempenho e custo, tornando-a uma opção atraente para indivíduos preocupados com o orçamento ou equipes pequenas. - Ray Tracing e Suporte DLSS:

O RTX 3080 TI oferece suporte às tecnologias Ray Tracing e Deep Learning Super Sampling (DLSS) aceleradas por hardware. Esses recursos aprimoram a qualidade visual dos gráficos, permitindo que os usuários experimentem ambientes mais realistas e imersivos. Os recursos Ray Tracing e DLSS são ativos valiosos ao visualizar as saídas do modelo e renderizar gráficos de alta qualidade.

Considerações para a NVIDIA GeForce RTX 3080 TI:

- Memória limitada:

Embora a RTX 3080 TI ofereça 12 GB de memória GDDR6X, é importante observar que isso pode restringir a capacidade de lidar com grandes quantidades de dados ou modelos complexos que exigem muitos recursos de memória. Os usuários devem avaliar seus requisitos específicos e determinar se a capacidade de memória disponível se alinha com seus casos de uso pretendidos.

Conclusão:

A NVIDIA GeForce RTX 3080 TI se apresenta como uma poderosa placa de vídeo intermediária que oferece desempenho notável para tarefas de aprendizado de máquina. Alimentado pela arquitetura Ampere e com 8704 núcleos CUDA, este cartão oferece poder de processamento robusto para lidar com cálculos exigentes de forma eficiente. Com suporte para aceleração de aprendizado de hardware por meio do Tensor Cores, os usuários podem se beneficiar de operações de rede neural aceleradas e treinamento de modelo mais rápido.

Embrulhe isso

No domínio do aprendizado de máquina, selecionar a placa gráfica certa é fundamental para maximizar os recursos de processamento de dados e permitir a computação paralela eficiente. Ao considerar fatores-chave, como poder de computação, capacidade de memória GPU, suporte para bibliotecas especializadas, suporte de alto desempenho e compatibilidade com estruturas de aprendizado de máquina, os profissionais podem garantir que tenham o hardware necessário para lidar com tarefas complexas de aprendizado de máquina. Embora as GPUs NVIDIA dominem o cenário de aprendizado de máquina, é essencial avaliar os requisitos específicos do projeto e escolher a placa gráfica que melhor se alinha a essas necessidades. Com a placa gráfica certa, pesquisadores e profissionais podem liberar todo o potencial de seus empreendimentos de aprendizado de máquina.

NVIDIA: líder em GPUs de aprendizado de máquina

Atualmente, NVIDIA está na vanguarda das GPUs de aprendizado de máquina, fornecendo drivers otimizados e amplo suporte para CUDA e cuDNN. As GPUs NVIDIA oferecem notável aceleração computacional, permitindo que pesquisadores e profissionais agilizem seu trabalho significativamente.

AMD: foco em jogos, adoção limitada de aprendizado de máquina

Embora as GPUs AMD tenham se estabelecido como concorrentes formidáveis na indústria de jogos, sua adoção para aprendizado de máquina permanece relativamente limitada. Isso pode ser atribuído a fatores como suporte de software limitado e a necessidade de atualizações frequentes para atender às demandas das estruturas de aprendizado de máquina em evolução.

Perguntas Frequentes:

A seleção da placa gráfica apropriada é crucial, pois determina a capacidade de lidar com processamento intensivo de matriz e tensor necessário para tarefas como treinamento de rede neural profunda.

Chips de AI especializados, como TPUs (Tensor Processing Units) e FPGAs (Field Programmable Gate Arrays), ganharam popularidade considerável nos últimos tempos.

Tarefas envolvendo profundidade rede neural treinamento requerem processamento intensivo de matrizes e tensores.

Chips de IA especializados oferecem desempenho e eficiência aprimorados para tarefas relacionadas à inteligência artificial, tornando-os altamente desejáveis para processar grandes conjuntos de dados e realizar cálculos paralelos.

Escolher a placa gráfica certa com poder de processamento e capacidade de memória suficientes é crucial para alcançar alto desempenho em tarefas de treinamento de redes neurais profundas.

Além das placas gráficas, chips especializados de IA, como TPUs e FPGAs, ganharam considerável popularidade por sua eficiência no manuseio de tarefas relacionadas à IA.

TPUs e FPGAs ganharam popularidade devido à sua capacidade de fornecer aceleração de hardware especializada para tarefas relacionadas à IA, permitindo um processamento mais rápido e eficiente de grandes conjuntos de dados e cálculos complexos.

Chips de IA especializados, como TPUs e FPGAs, geralmente superam as placas gráficas tradicionais em termos de desempenho e eficiência para tarefas de IA, pois são projetados especificamente para essas cargas de trabalho.

Existem várias placas gráficas altamente consideradas para aprendizado de máquina (ML) e inteligência artificial (AI) tarefas. Aqui estão algumas das melhores placas gráficas para ML e AI:

- NVIDIA A100: Construído na arquitetura Ampere, o A100 é uma potência para tarefas de IA e ML. Possui um grande número de núcleos CUDA e suporta tecnologias avançadas de IA.

- NVIDIA GeForce RTX 3090: Esta placa de vídeo de ponta oferece desempenho excepcional com sua poderosa GPU, grande capacidade de memória e suporte para tecnologias de aceleração de IA, como Tensor Cores.

- NVIDIA Quadro RTX 8000: Esta placa gráfica de nível profissional foi projetada para aplicativos exigentes de ML e AI, com seu alto poder de computação e ampla capacidade de memória.

Aviso Legal

Em linha com a Diretrizes do Projeto Trust, observe que as informações fornecidas nesta página não se destinam e não devem ser interpretadas como aconselhamento jurídico, tributário, de investimento, financeiro ou qualquer outra forma. É importante investir apenas o que você pode perder e procurar aconselhamento financeiro independente se tiver alguma dúvida. Para mais informações, sugerimos consultar os termos e condições, bem como as páginas de ajuda e suporte fornecidas pelo emissor ou anunciante. MetaversePost está comprometida com relatórios precisos e imparciais, mas as condições de mercado estão sujeitas a alterações sem aviso prévio.

Sobre o autor

Damir é o líder de equipe, gerente de produto e editor da Metaverse Post, abordando tópicos como AI/ML, AGI, LLMs, Metaverse e Web3-Campos relacionados. Seus artigos atraem um grande público de mais de um milhão de usuários todos os meses. Ele parece ser um especialista com 10 anos de experiência em SEO e marketing digital. Damir foi mencionado em Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e outras publicações. Ele viaja entre os Emirados Árabes Unidos, Turquia, Rússia e CEI como um nômade digital. Damir formou-se em física, o que ele acredita ter lhe dado as habilidades de pensamento crítico necessárias para ter sucesso no cenário em constante mudança da internet.

Mais artigos

Damir é o líder de equipe, gerente de produto e editor da Metaverse Post, abordando tópicos como AI/ML, AGI, LLMs, Metaverse e Web3-Campos relacionados. Seus artigos atraem um grande público de mais de um milhão de usuários todos os meses. Ele parece ser um especialista com 10 anos de experiência em SEO e marketing digital. Damir foi mencionado em Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e outras publicações. Ele viaja entre os Emirados Árabes Unidos, Turquia, Rússia e CEI como um nômade digital. Damir formou-se em física, o que ele acredita ter lhe dado as habilidades de pensamento crítico necessárias para ter sucesso no cenário em constante mudança da internet.