8 rzeczy, które powinieneś wiedzieć o dużych modelach językowych

W skrócie

Duże modele językowe (LLM) służą do badania niuansów języka naturalnego, poprawy zdolności maszyn do rozumienia i generowania tekstu oraz automatyzacji zadań, takich jak rozpoznawanie głosu i tłumaczenie maszynowe.

Nie ma łatwego rozwiązania do zarządzania LLM, ale są one tak samo zdolne jak ludzie.

Wraz z gwałtownym rozwojem przetwarzania języka naturalnego i jego wykorzystania w biznesie rośnie zainteresowanie dużymi modelami językowymi. Modele te są wykorzystywane do badania niuansów języka naturalnego, poprawy zdolności maszyn do rozumienia i generowania tekstu oraz automatyzacji zadań, takich jak rozpoznawanie głosu i tłumaczenie maszynowe. Oto osiem podstawowych rzeczy, które powinieneś wiedzieć o dużych modelach językowych (LLM).

- LLM są bardziej „zdolne”, ponieważ koszty stale rosną

- Szybkie spojrzenie na to, jak GPT modele dostosowują się do wzrostu kosztów szkolenia

- LLM uczą się grać w gry planszowe, używając reprezentacji świata zewnętrznego

- Nie ma łatwego rozwiązania zarządzania LLM

- Eksperci mają problem z wyjaśnieniem, jak działa LLM

- LLM są tak samo zdolne jak ludzie

- LLM muszą być czymś więcej niż tylko „wszystkimi wyrobami”

- Modele są „mądrzejsze”, niż ludzie myślą na podstawie pierwszego wrażenia

LLM są bardziej „zdolne”, ponieważ koszty stale rosną

Jak można przewidzieć, LLM stają się bardziej „wydajne” wraz ze wzrostem kosztów, nawet bez fajnych innowacji. Najważniejsze tutaj jest przewidywalność, która została pokazana w artykule o GPT-4: uczono od pięciu do siedmiu małych modeli z budżetem wynoszącym 0.1% ostatecznego, a następnie na tej podstawie dokonano prognozy dla dużego modelu. W przypadku ogólnej oceny zakłopotania i metryk na podpróbie jednego konkretnego zadania taka prognoza była bardzo dokładna. Ta przewidywalność jest ważna dla firm i organizacji, które polegają na LLM w swojej działalności, ponieważ mogą odpowiednio budżetować i planować przyszłe wydatki. Należy jednak zauważyć, że chociaż rosnące koszty mogą prowadzić do poprawy możliwości, tempo poprawy może w końcu ustabilizować się, co spowoduje konieczność inwestowania w nowe innowacje w celu dalszego rozwoju.

Szybkie spojrzenie na to, jak GPT modele dostosowują się do wzrostu kosztów szkolenia

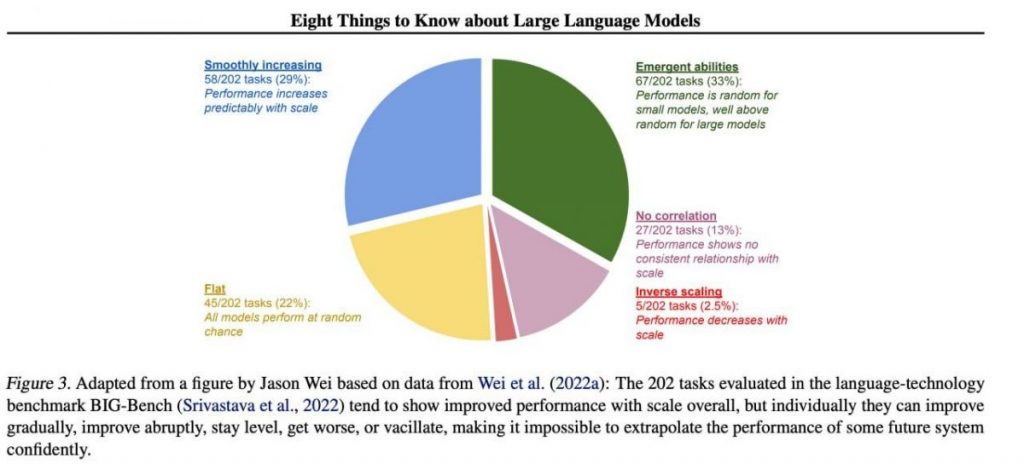

Jednak określone ważne umiejętności zwykle pojawiają się w sposób nieprzewidywalny jako produkt uboczny wzrostu koszty szkolenia (dłuższe szkolenie, więcej danych, większy model) — prawie niemożliwe jest przewidzenie, kiedy modele zaczną wykonywać określone zadania. Dokładniej zgłębiliśmy temat w naszym artykuł o historii rozwoju GPT modele. Na rysunku przedstawiono rozkład wzrostu jakości modeli pomiędzy różnymi zadaniami. Tylko duże modele mogą nauczyć się wykonywania różnych zadań. Ten wykres pokazuje znaczący wpływ zwiększania rozmiaru GPT modele na ich wydajność w różnych zadaniach. Należy jednak zauważyć, że odbywa się to kosztem zwiększonych zasobów obliczeniowych i wpływu na środowisko.

LLM uczą się grać w gry planszowe, używając reprezentacji świata zewnętrznego

LLM często uczą się i wykorzystują reprezentacje świata zewnętrznego. Przykładów jest tutaj wiele, a oto jeden z nich: Wyszkolone modele grać w gry planszowe w oparciu o opisy poszczególnych ruchów, nie widząc obrazu pola gry, poznać wewnętrzne reprezentacje stanu planszy przy każdym ruchu. Można następnie wykorzystać te wewnętrzne reprezentacje przewidzieć przyszłość ruchy i wyniki, dzięki czemu model może grać w grę na wysokim poziomie. Kluczowa jest umiejętność uczenia się i wykorzystywania reprezentacji aspekt uczenia maszynowego i sztuczna inteligencja.

Nie ma łatwego rozwiązania zarządzania LLM

Nie ma niezawodnych metod kontrolowania zachowania LLM. Chociaż nastąpił pewien postęp w zrozumieniu i łagodzeniu różnych problemów (m.in ChatGPT i GPT-4 za pomocą informacji zwrotnej) nie ma zgody co do tego, czy uda nam się je rozwiązać. Rośnie obawa, że w przyszłości, gdy powstaną jeszcze większe systemy, stanie się to ogromnym, potencjalnie katastrofalnym problemem. Dlatego badacze badają nowe metody, które pozwolą zapewnić zgodność systemów sztucznej inteligencji z wartościami i celami ludzkimi, takimi jak dostosowanie wartości i inżynieria nagród. Zagwarantowanie tego pozostaje jednak trudnym zadaniem bezpieczeństwo i niezawodność LLM w złożonych scenariuszach rzeczywistych.

Eksperci mają problem z wyjaśnieniem, jak działa LLM

Eksperci nie potrafią jeszcze zinterpretować wewnętrznego działania LLM. Żadna technika nie pozwoliłaby nam stwierdzić w zadowalający sposób, jakiego rodzaju wiedzy, rozumowania lub celów używa model, gdy generuje jakikolwiek wynik. Ten brak możliwości interpretacji budzi obawy co do wiarygodności i rzetelności decyzji LLM, zwłaszcza w zastosowaniach o wysokich stawkach, takich jak wymiar sprawiedliwości w sprawach karnych lub punktacja kredytowa. Podkreśla również potrzebę dalszych badań nad opracowaniem bardziej przejrzystych i odpowiedzialnych modeli sztucznej inteligencji.

LLM są tak samo zdolne jak ludzie

Chociaż LLM są szkoleni przede wszystkim do naśladuj ludzkie zachowanie podczas pisania tekstu, mają potencjał, aby nas przewyższyć w wielu zadaniach. Widać to już podczas gry w szachy czy Go. Wynika to z ich zdolności do analizowania ogromnych ilości danych i podejmowania decyzji na podstawie tej analizy z szybkością, której człowiek nie jest w stanie dorównać. Jednak osobom LLM nadal brakuje kreatywności i intuicji, które posiadają ludzie, co czyni je mniej odpowiednimi do wielu zadań.

LLM muszą być czymś więcej niż tylko „wszystkimi wyrobami”

LLM nie mogą wyrażać wartości ich twórców ani wartości zakodowanych w wyborze z Internetu. Nie powinni powielać stereotypów ani teorii spiskowych ani dążyć do obrażania kogokolwiek. Zamiast tego LLM powinny być zaprojektowane tak, aby dostarczać użytkownikom bezstronnych i opartych na faktach informacji, przy jednoczesnym poszanowaniu różnic kulturowych i społecznych. Ponadto powinny być poddawane regularnym testom i monitorowaniu, aby upewnić się, że nadal spełniają te standardy.

Modele są „mądrzejsze”, niż ludzie myślą na podstawie pierwszego wrażenia

Szacunki zdolności modelu oparte na pierwszym wrażeniu są często mylące. Bardzo często trzeba wymyślić odpowiedni monit, zaproponować model, a może pokazać przykłady, a zacznie dużo lepiej sobie radzić. Oznacza to, że jest „mądrzejszy” niż się wydaje na pierwszy rzut oka. Dlatego ważne jest, aby dać modelowi uczciwą szansę i zapewnić mu niezbędne zasoby, aby działał jak najlepiej. Przy odpowiednim podejściu nawet z pozoru nieodpowiednie modele mogą nas zaskoczyć swoimi możliwościami.

Jeśli skupimy się na próbie 202 zadań ze zbioru danych BIG-Bench (testowanie było specjalnie utrudnione) modele językowe od i do), to z reguły (średnio) modele wykazują wzrost jakości wraz ze wzrostem skali, ale indywidualnie metryki w zadaniach mogą:

- poprawiać stopniowo,

- radykalnie poprawić,

- pozostają bez zmian,

- zmniejszać,

- nie wykazywać korelacji.

Wszystko to prowadzi do niemożności pewnej ekstrapolacji wydajności jakiegokolwiek przyszłego systemu. Szczególnie interesująca jest zielona część — właśnie w tym miejscu wskaźniki jakości gwałtownie podskakują bez żadnego powodu.

Przeczytaj więcej o sztucznej inteligencji:

Odpowiedzialność

Zgodnie z Zaufaj wytycznym projektu, należy pamiętać, że informacje zawarte na tej stronie nie mają na celu i nie powinny być interpretowane jako porady prawne, podatkowe, inwestycyjne, finansowe lub jakiekolwiek inne formy porad. Ważne jest, aby inwestować tylko tyle, na utratę czego możesz sobie pozwolić, a w przypadku jakichkolwiek wątpliwości zasięgnąć niezależnej porady finansowej. Aby uzyskać więcej informacji, sugerujemy zapoznać się z warunkami oraz stronami pomocy i wsparcia udostępnianymi przez wydawcę lub reklamodawcę. MetaversePost zobowiązuje się do sporządzania dokładnych i bezstronnych raportów, jednakże warunki rynkowe mogą ulec zmianie bez powiadomienia.

O autorze

Damir jest liderem zespołu, menedżerem produktu i redaktorem w Metaverse Post, obejmujący takie tematy, jak AI/ML, AGI, LLM, Metaverse i Web3-pokrewne pola. Jego artykuły przyciągają każdego miesiąca ogromną publiczność, liczącą ponad milion użytkowników. Wydaje się być ekspertem z 10-letnim doświadczeniem w SEO i marketingu cyfrowym. Damir został wspomniany w Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i inne publikacje. Jako cyfrowy koczownik podróżuje między ZEA, Turcją, Rosją i WNP. Damir uzyskał tytuł licencjata z fizyki, co jego zdaniem dało mu umiejętności krytycznego myślenia potrzebne do odniesienia sukcesu w ciągle zmieniającym się środowisku internetowym.

Więcej artykułów

Damir jest liderem zespołu, menedżerem produktu i redaktorem w Metaverse Post, obejmujący takie tematy, jak AI/ML, AGI, LLM, Metaverse i Web3-pokrewne pola. Jego artykuły przyciągają każdego miesiąca ogromną publiczność, liczącą ponad milion użytkowników. Wydaje się być ekspertem z 10-letnim doświadczeniem w SEO i marketingu cyfrowym. Damir został wspomniany w Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i inne publikacje. Jako cyfrowy koczownik podróżuje między ZEA, Turcją, Rosją i WNP. Damir uzyskał tytuł licencjata z fizyki, co jego zdaniem dało mu umiejętności krytycznego myślenia potrzebne do odniesienia sukcesu w ciągle zmieniającym się środowisku internetowym.