Le 10 migliori schede grafiche per ML/AI: la migliore GPU per il deep learning

La selezione di una scheda grafica appropriata svolge un ruolo cruciale nel raggiungimento di prestazioni ottimali per l'elaborazione di grandi set di dati e l'esecuzione di calcoli paralleli. In particolare per le attività che comportano l'addestramento di reti neurali profonde, la richiesta di un'elaborazione intensiva di matrici e tensori è fondamentale. Vale la pena notare che chip, TPU e FPGA IA specializzati hanno guadagnato una notevole popolarità negli ultimi tempi.

Caratteristiche chiave per le schede grafiche di apprendimento automatico

Quando si considera una scheda grafica per scopi di apprendimento automatico, è necessario tenere conto di diverse caratteristiche essenziali:

- Potenza di calcolo:

Il numero di core o processori influisce direttamente sulle capacità di elaborazione parallela della scheda grafica. Un numero di core più elevato si traduce in calcoli più veloci ed efficienti. - Capacità di memoria della GPU:

L'ampia capacità di memoria è fondamentale per gestire efficacemente set di dati di grandi dimensioni e modelli complessi. La capacità di archiviare e accedere ai dati in modo efficiente è fondamentale per ottenere prestazioni ottimali. - Supporto per biblioteche specializzate:

La compatibilità hardware con librerie specializzate come CUDA o ROCm può accelerare significativamente il modello processi formativi. Sfruttare le ottimizzazioni specifiche dell'hardware semplifica i calcoli e migliora l'efficienza complessiva. - Supporto ad alte prestazioni:

Le schede grafiche con memoria veloce e ampie configurazioni del bus di memoria offrono capacità ad alte prestazioni durante l'addestramento del modello. Queste caratteristiche garantiscono un'elaborazione dei dati fluida e rapida. - Compatibilità con i framework di Machine Learning:

È essenziale garantire la perfetta compatibilità tra la scheda grafica selezionata e i framework di apprendimento automatico e gli strumenti di sviluppo utilizzati. La compatibilità garantisce un'integrazione fluida e un utilizzo ottimale delle risorse.

Tabella di confronto delle schede grafiche per ML/AI

| Scheda grafica | Memoria, GB | Core CUDA | Tensor Core | Prezzo, USD |

|---|---|---|---|---|

| Tesla V100 | 16/32 | 5120 | 640 | 14,999 |

| Tesla A100 | 40/80 | 7936 | 432 | 10,499 |

| Quadro RTX8000 | 48 | 4608 | 576 | 7,999 |

| Un 6000 Ada | 48 | 18176 | 568 | 6,499 |

| RTX A5000 | 24 | 8192 | 256 | 1,899 |

| RTX 3090 Ti | 24 | 10752 | 336 | 1,799 |

| RTX 4090 | 24 | 16384 | 512 | 1,499 |

| RTX 3080 Ti | 12 | 10240 | 320 | 1,399 |

| RTX 4080 | 16 | 9728 | 304 | 1,099 |

| RTX 4070 | 12 | 7680 | 184 | 599 |

NVIDIA Tesla V100

Tesla V100 di NVIDIA si pone come una potente GPU Tensor Core su misura per i carichi di lavoro AI, High Performance Computing (HPC) e Machine Learning. Sfruttando l'architettura Volta all'avanguardia, questa scheda grafica mostra capacità prestazionali eccezionali, offrendo prestazioni impressionanti di 125 trilioni di operazioni in virgola mobile al secondo (TFLOPS). In questo articolo, esploreremo i notevoli vantaggi e considerazioni associati alla Tesla V100.

Pro di Tesla V100:

- Alte prestazioni:

Sfruttando la potenza dell'architettura Volta e dei suoi 5120 core CUDA, Tesla V100 offre prestazioni eccezionali per le attività di machine learning. La sua capacità di gestire set di dati estesi ed eseguire calcoli complessi a velocità notevoli è fondamentale per guidare flussi di lavoro di machine learning efficienti. - Grande capacità di memoria:

Con 16 GB di memoria HBM2, Tesla V100 consente un'elaborazione efficiente di notevoli volumi di dati durante l'addestramento del modello. Questo attributo è particolarmente vantaggioso quando si lavora con set di dati estesi, consentendo una manipolazione dei dati senza soluzione di continuità. Inoltre, la larghezza del bus di memoria video di 4096 bit facilita il trasferimento di dati ad alta velocità tra il processore e la memoria video, migliorando ulteriormente le prestazioni dell'addestramento e dell'inferenza del modello di machine learning. - Tecnologie di apprendimento profondo:

La Tesla V100 è dotata di varie tecnologie di deep learning, inclusi i Tensor Core, che accelerano i calcoli in virgola mobile. Questa accelerazione contribuisce a riduzioni significative del tempo di addestramento del modello, migliorando in ultima analisi le prestazioni complessive. - Flessibilità e scalabilità:

La versatilità della Tesla V100 è evidente nella sua compatibilità con i sistemi desktop e server. Si integra perfettamente con un'ampia gamma di framework di machine learning come TensorFlow, PyTorch, Caffe e altri, offrendo agli sviluppatori la libertà di scegliere i propri strumenti preferiti per lo sviluppo e l'addestramento del modello.

Considerazioni per Tesla V100:

- Costo alto:

Come soluzione di livello professionale, NVIDIA Tesla V100 ha un prezzo corrispondente. Con un costo di $ 14,447, può rappresentare un investimento sostanziale per singoli o piccoli team di machine learning. Il prezzo dovrebbe essere preso in considerazione quando si considerano il budget e i requisiti complessivi. - Consumo energetico e raffreddamento:

Date le robuste prestazioni del Tesla V100, richiede un'alimentazione significativa e genera un calore notevole. È necessario implementare adeguate misure di raffreddamento per mantenere temperature operative ottimali, il che può comportare un aumento del consumo energetico e dei costi associati. - Requisiti di infrastruttura:

Per sfruttare appieno le capacità della Tesla V100, è necessaria un'infrastruttura compatibile. Ciò include un potente processore e RAM sufficiente per garantire un'efficienza elaborazione dei dati e addestramento del modello.

Conclusione:

NVIDIA A100, alimentata dall'architettura Ampere all'avanguardia, rappresenta un significativo balzo in avanti nella tecnologia GPU per le applicazioni di machine learning. Con le sue capacità ad alte prestazioni, l'ampia capacità di memoria e il supporto per la tecnologia NVLink, l'A100 consente a data scientist e ricercatori per affrontare complesse attività di apprendimento automatico con efficienza e precisione. Tuttavia, il costo elevato, il consumo energetico e la compatibilità del software devono essere valutati attentamente prima di adottare NVIDIA A100. Con i suoi progressi e scoperte, l'A100 apre nuove possibilità per l'addestramento e l'inferenza di modelli accelerati, aprendo la strada a ulteriori progressi nel campo dell'apprendimento automatico.

NVIDIATesla A100

La NVIDIA A100, alimentata dall'architettura Ampere all'avanguardia, si pone come una straordinaria scheda grafica progettata per soddisfare le esigenze delle attività di apprendimento automatico. Offrendo prestazioni e flessibilità eccezionali, l'A100 rappresenta un significativo progresso nella tecnologia delle GPU. In questo articolo, esploreremo i notevoli vantaggi e considerazioni associati a NVIDIA A100.

Pro di NVIDIA A100:

- Alte prestazioni:

Dotato di un numero considerevole di core CUDA (4608), NVIDIA A100 offre capacità prestazionali impressionanti. La sua maggiore potenza di calcolo consente flussi di lavoro di apprendimento automatico accelerati, con conseguente addestramento del modello e processi di inferenza più rapidi. - Grande capacità di memoria:

La scheda grafica NVIDIA A100 vanta 40 GB di memoria HBM2, facilitando la gestione efficiente di grandi quantità di dati durante formazione del modello di apprendimento profondo. Questa grande capacità di memoria è particolarmente vantaggiosa per lavorare con set di dati complessi e su larga scala, consentendo un'elaborazione dei dati fluida e senza soluzione di continuità. - Supporto per la tecnologia NVLink:

L'inclusione della tecnologia NVLink consente di combinare senza problemi più schede grafiche NVIDIA A100 in un unico sistema, facilitando il calcolo parallelo. Questo parallelismo potenziato migliora significativamente le prestazioni e accelera l'addestramento dei modelli, contribuendo a flussi di lavoro di machine learning più efficienti.

Considerazioni per NVIDIA A100:

- Costo alto:

Essendo una delle schede grafiche più potenti e avanzate disponibili sul mercato, la NVIDIA A100 ha un prezzo più alto. Con un prezzo di $ 10,000, può essere un investimento sostanziale per individui o organizzazioni che ne considerano l'adozione. - Consumo:

L'utilizzo di tutto il potenziale della scheda grafica NVIDIA A100 richiede un alimentatore significativo. Ciò può comportare un aumento del consumo di energia e richiedere misure adeguate per la gestione dell'alimentazione, soprattutto quando si utilizza la scheda su larga scala data center. - Compatibilità software:

Per garantire prestazioni ottimali, NVIDIA A100 si affida a software e driver appropriati. È importante notare che alcuni programmi e framework di apprendimento automatico potrebbero non supportare completamente questo specifico modello di scheda grafica. Le considerazioni sulla compatibilità dovrebbero essere prese in considerazione quando si integra NVIDIA A100 nei flussi di lavoro di machine learning esistenti.

Conclusione:

La Tesla V100, con la sua architettura Volta e funzionalità all'avanguardia, si pone come un'impressionante GPU Tensor Core progettata per carichi di lavoro AI, HPC e Machine Learning. Le sue capacità ad alte prestazioni, l'ampia capacità di memoria, le tecnologie di deep learning e la flessibilità lo rendono una scelta interessante per organizzazioni e ricercatori che perseguono progetti avanzati di machine learning. Tuttavia, considerazioni come il costo, il consumo energetico ei requisiti dell'infrastruttura devono essere attentamente valutati per garantire un investimento ben allineato. Con la Tesla V100, il potenziale per innovazioni nell'intelligenza artificiale e nell'apprendimento automatico è a portata di mano, potenziante data scientist e ricercatori per allargare i confini dell'innovazione.

NVIDIA QuadroRTX 8000

La Quadro RTX 8000 si pone come una potente scheda grafica progettata specificamente per i professionisti che necessitano di eccezionali capacità di rendering. Con le sue funzionalità avanzate e le specifiche ad alte prestazioni, questa scheda grafica offre benefici pratici per varie applicazioni, tra cui la visualizzazione dei dati, la computer grafica e l'apprendimento automatico. In questo articolo, esploreremo le caratteristiche distintive e i vantaggi della Quadro RTX 8000.

Pro di Quadro RTX 8000:

- Alte prestazioni:

La Quadro RTX 8000 vanta una potente GPU e un impressionante 5120 core CUDA, fornendo prestazioni senza pari per attività di rendering impegnative. La sua eccezionale potenza di calcolo consente ai professionisti di eseguire il rendering di modelli complessi con ombre, riflessi e rifrazioni realistici, offrendo risultati realistici e esperienze visive coinvolgenti. - Supporto ray-tracing:

Il ray tracing con accelerazione hardware è una caratteristica distintiva della Quadro RTX 8000. Questa tecnologia consente la creazione di immagini fotorealistiche ed effetti di luce realistici. Per i professionisti impegnati nella visualizzazione dei dati, nella computer grafica o nell'apprendimento automatico, questa funzione aggiunge un livello di realismo e fedeltà visiva al loro lavoro, migliorando la qualità complessiva dei loro progetti. - Grande capacità di memoria:

La Quadro RTX 8000 offre ben 48 GB di memoria grafica GDDR6. Questa grande capacità di memoria consente un'efficiente archiviazione e recupero dei dati, in particolare quando si lavora con modelli e set di dati di machine learning su larga scala. I professionisti possono eseguire calcoli complessi e gestire notevoli quantità di dati senza compromettere le prestazioni o l'efficienza. - Supporto per libreria e framework:

La compatibilità con le librerie e i framework di machine learning più diffusi, tra cui TensorFlow, PyTorch, CUDA, cuDNN e altri, garantisce una perfetta integrazione nei flussi di lavoro esistenti. I professionisti possono sfruttare la potenza della Quadro RTX 8000 con i loro strumenti e framework preferiti, consentendo uno sviluppo e una formazione efficienti dei modelli di machine learning.

Considerazioni per Quadro RTX 8000:

- Costo alto:

Come acceleratore grafico professionale, Quadro RTX 8000 ha un prezzo più alto rispetto ad altre schede grafiche. Il suo costo effettivo è di $ 8,200, il che potrebbe renderlo meno accessibile per singoli utenti o operazioni su piccola scala.

Conclusione:

La Quadro RTX 8000 stabilisce un punto di riferimento per il rendering grafico ad alte prestazioni nelle applicazioni professionali. Con la sua potente GPU, il supporto del ray tracing, l'ampia capacità di memoria e la compatibilità con le librerie e i framework di machine learning più diffusi, Quadro RTX 8000 consente ai professionisti di creare modelli, visualizzazioni e simulazioni visivamente sbalorditivi e realistici. Mentre il costo più elevato può rappresentare una sfida per alcuni, i vantaggi di questa scheda grafica la rendono una risorsa preziosa per i professionisti che necessitano di prestazioni e capacità di memoria di alto livello. Con Quadro RTX 8000, i professionisti possono liberare il loro potenziale creativo e spingere i limiti del loro lavoro nei campi della visualizzazione dei dati, della computer grafica e dell'apprendimento automatico.

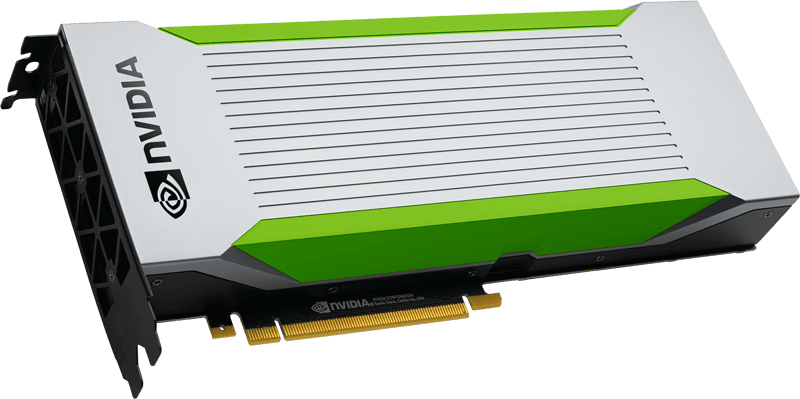

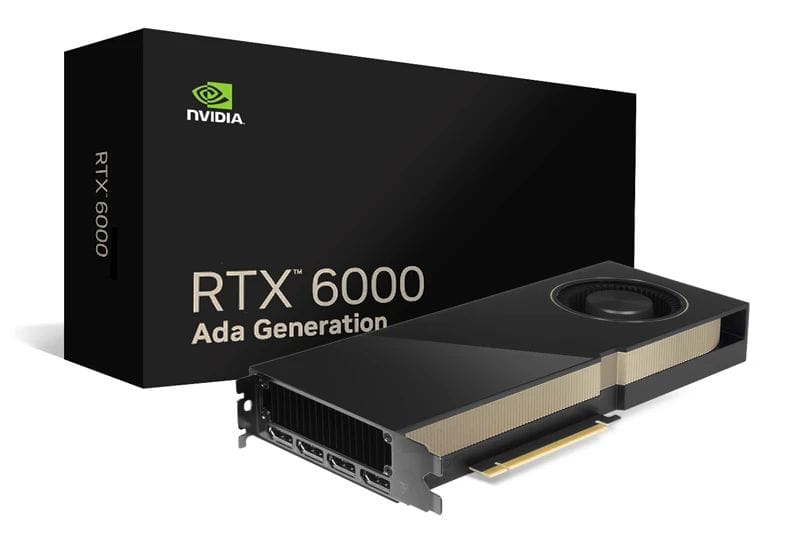

NVIDIA RTX A6000Adatta

La scheda grafica RTX A6000 Ada si distingue come un'opzione convincente per i professionisti alla ricerca di una soluzione potente ma a basso consumo energetico. Con le sue funzionalità avanzate, tra cui l'architettura Ada Lovelace, i core CUDA ad alte prestazioni e l'ampia capacità VRAM, l'RTX A6000 Ada offre vantaggi pratici per una varietà di applicazioni professionali. In questo articolo, esploreremo le caratteristiche distintive e i vantaggi dell'RTX A6000 Ada.

Pro di RTX A6000 Ada:

- Alte prestazioni:

L'RTX A6000 Ada sfrutta la potenza dell'architettura Ada Lovelace, incorporando core RT di terza generazione, Tensor Core di quarta generazione e core CUDA di nuova generazione. Questi progressi nell'architettura contribuiscono a prestazioni eccezionali, consentendo ai professionisti di affrontare compiti impegnativi con facilità. Con 48 GB di VRAM, la scheda grafica offre ampia memoria per la gestione efficiente di grandi set di dati durante l'addestramento del modello. - Grande capacità di memoria:

Dotato di 48 GB di memoria, l'RTX A6000 Ada garantisce un'elaborazione efficiente di grandi volumi di dati. Questa ampia capacità di memoria consente ai professionisti di addestrare complessi modelli di machine learning e lavorare con enormi set di dati senza compromettere le prestazioni o l'efficienza. La capacità di gestire carichi di dati estesi contribuisce a un addestramento del modello più rapido e accurato. - Basso consumo energetico:

L'RTX A6000 Ada pone l'accento sull'efficienza energetica, rendendolo la scelta ideale per i professionisti attenti al consumo energetico. Ottimizzando il consumo energetico, questa scheda grafica riduce i costi energetici e contribuisce a creare un ambiente di lavoro più sostenibile ed economico.

Considerazioni per RTX A6000 Ada:

- Costo alto:

L'RTX A6000 Ada, con le sue prestazioni e caratteristiche impressionanti, ha un prezzo più alto. Con un prezzo di circa $ 6,800, questa scheda grafica può rappresentare un investimento significativo per singoli utenti o organizzazioni più piccole. Tuttavia, le prestazioni e l'efficienza superiori che offre giustificano il suo valore per i professionisti che cercano risultati ottimali.

Conclusione:

L'RTX A6000 Ada emerge come una scelta di scheda grafica eccezionale per i professionisti che mirano a massimizzare le prestazioni e l'efficienza. Con la sua architettura avanzata, la notevole capacità VRAM e il basso consumo energetico, questa scheda grafica offre risultati eccezionali in una vasta gamma di applicazioni professionali. L'architettura Ada Lovelace, unita ai core CUDA di nuova generazione e all'elevata capacità di memoria, garantisce un'elaborazione ad alte prestazioni e una gestione efficiente di grandi set di dati. Sebbene l'RTX A6000 Ada abbia un costo più elevato, i suoi vantaggi e le sue capacità lo rendono una risorsa preziosa per i professionisti impegnati a ottenere risultati ottimali nel loro lavoro. Con RTX A6000 Ada, i professionisti possono sbloccare tutto il loro potenziale ed elevare le loro prestazioni in vari domini, tra cui machine learning, analisi dei dati e computer grafica.

NVIDIARTX A5000

L'RTX A5000, costruita sull'architettura NVIDIA Ampere, emerge come una potente scheda grafica progettata per accelerare le attività di machine learning. Con le sue caratteristiche robuste e le capacità ad alte prestazioni, RTX A5000 offre vantaggi pratici e vantaggi distinti per i professionisti del settore. In questo articolo, approfondiremo le caratteristiche distintive dell'RTX A5000 e il suo potenziale impatto sulle applicazioni di machine learning.

Pro di RTX A5000:

- Alte prestazioni:

Dotato di 8192 CUDA core e 256 tensor core, l'RTX A5000 vanta un'eccezionale potenza di elaborazione. Questa architettura ad alte prestazioni consente un'elaborazione rapida ed efficiente di grandi set di dati, consentendo un addestramento più rapido dei modelli di machine learning. L'abbondanza di core CUDA e l'elevata larghezza di banda della memoria contribuiscono a calcoli fluidi e accelerati, facilitando operazioni complesse all'interno dei flussi di lavoro di machine learning. - Supporto per l'accelerazione hardware AI:

La scheda grafica RTX A5000 fornisce l'accelerazione hardware per le operazioni e gli algoritmi relativi all'intelligenza artificiale. Con il suo design ottimizzato, la scheda può migliorare significativamente le prestazioni delle attività di intelligenza artificiale, offrendo risultati più rapidi ed efficienti. Sfruttando la potenza dell'accelerazione hardware IA dedicata, i professionisti possono semplificare i flussi di lavoro di machine learning e ottenere una maggiore produttività. - Grande capacità di memoria:

Dotato di 24 GB di VRAM GDDR6, RTX A5000 offre ampia memoria per la gestione di grandi set di dati e complessi modelli di machine learning. Questa ampia capacità di memoria consente ai professionisti di lavorare con attività a uso intensivo di dati senza compromettere le prestazioni o l'efficienza. La disponibilità di un'abbondante VRAM garantisce un accesso agevole ai dati e un addestramento più rapido, consentendo uno sviluppo del modello più accurato e completo. - Supporto del framework di apprendimento automatico:

L'RTX A5000 si integra perfettamente con i framework di machine learning più diffusi come TensorFlow e PyTorch. Con i suoi driver e librerie ottimizzati, la scheda grafica consente a sviluppatori e ricercatori di sfruttare appieno le capacità di questi framework. Questa compatibilità garantisce un utilizzo efficiente delle risorse dell'RTX A5000, consentendo ai professionisti di sviluppare e addestrare facilmente modelli di machine learning.

Considerazioni per RTX A5000:

- Consumo energetico e raffreddamento:

È importante notare che le schede grafiche di questo calibro in genere consumano una notevole quantità di energia e generano un notevole calore durante il funzionamento. Per garantire prestazioni e longevità ottimali, è necessario adottare adeguate misure di raffreddamento e una capacità di alimentazione sufficiente. Queste precauzioni garantiscono l'utilizzo efficiente e affidabile dell'RTX A5000 in ambienti di machine learning impegnativi.

Conclusione:

L'RTX A5000 si distingue come una potente scheda grafica su misura per soddisfare le esigenti esigenze dei professionisti del machine learning. Con le sue funzionalità avanzate, tra cui un numero elevato di core CUDA, il supporto dell'accelerazione hardware AI e un'ampia capacità di memoria, RTX A5000 offre prestazioni eccezionali per l'elaborazione di grandi quantità di dati e l'addestramento di modelli complessi. La sua perfetta integrazione con i framework di apprendimento automatico più diffusi ne migliora ulteriormente l'usabilità e la versatilità. Sebbene considerazioni come il consumo energetico e il raffreddamento siano fondamentali, un'infrastruttura e precauzioni adeguate possono garantire l'utilizzo efficace delle capacità dell'RTX A5000. Con RTX A5000, i professionisti possono sbloccare nuove possibilità nell'apprendimento automatico e promuovere la ricerca, lo sviluppo e l'implementazione di modelli innovativi.

NVIDIA RTX 4090

La scheda grafica NVIDIA RTX 4090 emerge come una potente soluzione su misura per soddisfare le esigenze dell'ultima generazione di reti neurali. Con le sue eccezionali prestazioni e le sue funzionalità avanzate, l'RTX 4090 offre vantaggi pratici e si distingue come un'opzione affidabile per i professionisti del settore. In questo articolo, esploreremo le funzionalità chiave dell'RTX 4090 e il suo potenziale impatto sull'accelerazione dei modelli di machine learning.

Pro della NVIDIA RTX 4090:

- Prestazione eccezionale:

Dotata di tecnologia all'avanguardia, NVIDIA RTX 4090 offre prestazioni eccezionali che consentono una gestione efficiente di calcoli complessi e set di dati di grandi dimensioni. La scheda grafica sfrutta la sua potente architettura per accelerare l'addestramento dei modelli di apprendimento automatico, facilitando risultati più rapidi e accurati. Le capacità ad alte prestazioni dell'RTX 4090 consentono ai professionisti di affrontare attività impegnative e ottenere una maggiore produttività nei loro progetti di rete neurale.

Considerazioni per NVIDIA RTX 4090:

- Sfide di raffreddamento:

L'intensa generazione di calore della NVIDIA RTX 4090 può presentare sfide in termini di raffreddamento. A causa della natura ad alte prestazioni della scheda, è essenziale garantire adeguate misure di raffreddamento per evitare il surriscaldamento. Gli utenti devono essere consapevoli del fatto che nelle configurazioni multi-scheda, i requisiti di dissipazione del calore diventano ancora più critici per mantenere prestazioni ottimali e prevenire gli arresti automatici innescati dal raggiungimento di temperature critiche. - Limitazioni di configurazione:

Il design della GPU della NVIDIA RTX 4090 impone alcune limitazioni sul numero di schede che possono essere installate in una workstation. Questa restrizione può interessare gli utenti che richiedono più schede RTX 4090 per i loro progetti. È necessaria un'attenta considerazione della configurazione e della compatibilità della workstation per garantire un utilizzo ottimale delle capacità dell'RTX 4090.

Conclusione:

La scheda grafica NVIDIA RTX 4090 rappresenta una scelta potente per i professionisti che cercano di potenziare l'ultima generazione di reti neurali. Con le sue prestazioni eccezionali e la gestione efficiente di calcoli complessi e set di dati di grandi dimensioni, RTX 4090 accelera l'addestramento dei modelli di machine learning, aprendo nuove possibilità a ricercatori e sviluppatori del settore. Tuttavia, gli utenti dovrebbero essere consapevoli delle sfide di raffreddamento associate all'intenso calore generato dalla scheda, specialmente nelle configurazioni multi-scheda. Inoltre, le limitazioni di configurazione dovrebbero essere prese in considerazione quando si considera l'installazione di più schede RTX 4090 in una workstation. Sfruttando le capacità di NVIDIA RTX 4090 e affrontando queste considerazioni, i professionisti possono ottimizzare i loro progetti di rete neurale e sbloccare nuove frontiere nei progressi del machine learning.

NVIDIA RTX 4080

La scheda grafica RTX 4080 è emersa come una soluzione potente ed efficiente nel campo dell'intelligenza artificiale. Con le sue elevate prestazioni e il suo prezzo ragionevole, l'RTX 4080 rappresenta una scelta allettante per gli sviluppatori che mirano a massimizzare il potenziale del loro sistema. In questo articolo, approfondiremo le caratteristiche distintive e i vantaggi pratici dell'RTX 4080, esplorando il suo impatto sull'accelerazione delle attività di machine learning.

Vantaggi dell'RTX 4080:

- Alte prestazioni:

L'RTX 4080 vanta ben 9728 core NVIDIA CUDA, che gli consentono di fornire un'eccezionale potenza di calcolo per le attività di machine learning. Questa capacità ad alte prestazioni, combinata con la presenza di tensor core e il supporto per il ray tracing, contribuisce a un'elaborazione dei dati più efficiente e a una maggiore precisione nelle operazioni relative all'IA. Gli sviluppatori possono sfruttare la potenza dell'RTX 4080 per gestire calcoli complessi e set di dati di grandi dimensioni, ottimizzando i flussi di lavoro di machine learning. - Prezzi competitivi:

Con un prezzo di vendita di $ 1,199, l'RTX 4080 offre una proposta interessante per singoli e piccoli team che cercano una soluzione di machine learning produttiva. La sua combinazione di convenienza e alte prestazioni lo rende un'opzione accessibile per gli sviluppatori che lo desiderano sfruttare i vantaggi dell'intelligenza artificiale senza spendere una fortuna.

Considerazioni per l'RTX 4080:

- Limitazione SLI:

È importante notare che RTX 4080 non supporta NVIDIA NVLink con funzione SLI. Questa limitazione implica che gli utenti non possono combinare più schede RTX 4080 in modalità SLI per migliorare ulteriormente le prestazioni. Sebbene ciò possa limitare la scalabilità della scheda grafica in determinate configurazioni, non diminuisce le sue capacità autonome nel fornire un'efficiente elaborazione AI.

Conclusione:

La scheda grafica RTX 4080 rappresenta una scelta convincente per gli sviluppatori che cercano di sbloccare funzionalità AI ad alte prestazioni. Con le sue robuste specifiche, tra cui 9728 core NVIDIA CUDA, tensor core e supporto ray tracing, l'RTX 4080 offre una soluzione pratica per accelerare le attività di machine learning. Inoltre, il suo prezzo competitivo di $ 1,199 lo rende un'opzione accessibile per singoli e piccoli team, consentendo loro di sfruttare la potenza dell'IA senza un onere finanziario significativo. Sebbene l'assenza del supporto SLI limiti le configurazioni multi-scheda, ciò non toglie nulla alle prestazioni e all'efficienza standalone dell'RTX 4080. Abbracciando i vantaggi dell'RTX 4080, gli sviluppatori possono elevare i loro progetti di machine learning e ottenere nuove scoperte nell'intelligenza artificiale avanzamenti.

NVIDIA RTX 4070

La scheda grafica NVIDIA RTX 4070, costruita sull'innovativa architettura Ada Lovelace, ha fatto scalpore nel regno dell'apprendimento automatico. Con la sua capacità di memoria di 12 GB, questa scheda grafica offre un accesso ai dati accelerato e velocità di addestramento migliorate per i modelli di machine learning. In questo articolo, approfondiremo i vantaggi pratici e le caratteristiche distintive di NVIDIA RTX 4070, evidenziando la sua idoneità per le persone che entrano nel campo dell'apprendimento automatico.

Pro della NVIDIA RTX 4070:

- Alte prestazioni:

NVIDIA RTX 4070 combina la potenza di 7680 CUDA core e 184 tensor core, fornendo agli utenti un'encomiabile capacità di elaborazione per operazioni complesse. La capacità di memoria di 12 GB consente una gestione efficiente di set di dati di grandi dimensioni, consentendo flussi di lavoro senza soluzione di continuità nelle attività di machine learning. - Basso consumo energetico:

Funzionando a soli 200 W, la scheda grafica NVIDIA RTX 4070 mostra un'eccezionale efficienza energetica. Il suo basso consumo energetico assicura che gli utenti possano godere di potenti prestazioni di apprendimento automatico senza sovraccaricare eccessivamente i loro sistemi o sostenere costi energetici esorbitanti. - Soluzione conveniente:

Con un prezzo di $ 599, la scheda grafica NVIDIA RTX 4070 rappresenta un'opzione conveniente per le persone che cercano di esplorare e apprendere l'apprendimento automatico. Nonostante il suo prezzo interessante, la scheda non scende a compromessi in termini di prestazioni, rendendola una scelta eccellente per chi ha un budget limitato.

Considerazioni per NVIDIA RTX 4070:

- Capacità di memoria limitata:

Sebbene la capacità di memoria di 4070 GB di NVIDIA RTX 12 sia sufficiente per molte applicazioni di machine learning, è importante riconoscere che potrebbe porre dei limiti quando si lavora con set di dati eccezionalmente grandi. Gli utenti devono valutare i loro requisiti specifici e determinare se la capacità di memoria da 12 GB è in linea con le loro esigenze. - Assenza di supporto NVIDIA NVLink e SLI:

La scheda grafica NVIDIA RTX 4070 non supporta la tecnologia NVIDIA NVLink, che consente il collegamento di più schede in un sistema di elaborazione parallela. Di conseguenza, la scalabilità e le prestazioni potrebbero essere limitate nelle configurazioni con più schede. Gli utenti che prendono in considerazione tali configurazioni dovrebbero esplorare opzioni alternative che soddisfino i loro requisiti specifici.

Conclusione:

La scheda grafica NVIDIA RTX 4070 emerge come una soluzione efficiente ed economica per le persone che si avventurano nel regno dell'apprendimento automatico. Con la sua architettura Ada Lovelace, la capacità di memoria di 12 GB e la notevole potenza di elaborazione, offre prestazioni impressionanti che consentono agli utenti di affrontare complesse operazioni di machine learning. Inoltre, il basso consumo energetico della scheda di 200 W garantisce un utilizzo efficiente dal punto di vista energetico, mitigando le sollecitazioni sui sistemi e riducendo i costi energetici. Al prezzo di $ 599, NVIDIA RTX 4070 offre un punto di accesso accessibile per le persone che cercano di approfondire l'apprendimento automatico senza spendere una fortuna.

NVIDIA GeForce RTX 3090 TI

La NVIDIA GeForce RTX 3090 TI ha attirato l'attenzione come GPU di gioco che vanta anche capacità impressionanti per attività di deep learning. Con le sue prestazioni di picco a precisione singola (FP32) di 13 teraflop, 24 GB di VRAM e 10,752 core CUDA, questa scheda grafica offre prestazioni e versatilità eccezionali. In questo articolo, esploreremo i vantaggi pratici e le caratteristiche distintive della NVIDIA GeForce RTX 3090 TI, evidenziando la sua idoneità sia per gli appassionati di giochi che per i professionisti del deep learning.

Pro della NVIDIA GeForce RTX 3090 TI:

- Alte prestazioni:

Dotata dell'architettura Ampere e di ben 10,752 core CUDA, la NVIDIA GeForce RTX 3090 TI offre prestazioni eccezionali. Ciò consente agli utenti di affrontare facilmente problemi complessi di apprendimento automatico, consentendo calcoli più rapidi ed efficienti. - Accelerazione dell'apprendimento dell'hardware:

L'RTX 3090 TI supporta la tecnologia Tensor Cores, che facilita le operazioni di rete neurale con accelerazione hardware. Sfruttando i Tensor Core, gli utenti possono sperimentare significativi miglioramenti della velocità nell'addestramento dei modelli di deep learning. Questo avanzamento contribuisce a migliorare la produttività e ridurre i tempi di addestramento del modello. - Grande capacità di memoria:

Con 24 GB di memoria GDDR6X, la NVIDIA GeForce RTX 3090 TI offre ampio spazio di archiviazione per gestire grandi quantità di dati di memoria. Questa capacità riduce al minimo la necessità di frequenti letture e scritture su disco, con il risultato di flussi di lavoro più fluidi e maggiore efficienza, in particolare quando si lavora con set di dati estesi.

Considerazioni per la NVIDIA GeForce RTX 3090 TI:

- Consumo:

La NVIDIA GeForce RTX 3090 TI richiede una notevole quantità di energia, con un consumo energetico nominale di 450 W. Di conseguenza, è fondamentale garantire un'alimentazione robusta per supportare il funzionamento della scheda. L'elevato consumo energetico può comportare un aumento dei costi energetici e limitare la compatibilità della scheda con determinati sistemi, in particolare quando si distribuiscono più schede in configurazioni di elaborazione parallela. - Compatibilità e supporto:

Sebbene la NVIDIA GeForce RTX 3090 TI sia una potente scheda grafica, potrebbero esserci considerazioni di compatibilità e supporto con determinate piattaforme software e librerie di machine learning. Gli utenti devono verificare la compatibilità ed essere pronti ad apportare le modifiche o gli aggiornamenti necessari per utilizzare appieno le capacità della scheda all'interno dei propri ambienti software specifici.

Conclusione:

La NVIDIA GeForce RTX 3090 TI si pone come un'impressionante GPU di gioco che eccelle anche nelle applicazioni di deep learning. Con la sua potente architettura Ampere, l'ampio numero di core CUDA e le capacità di accelerazione dell'apprendimento hardware, consente agli utenti di affrontare in modo efficiente attività complesse di apprendimento automatico. Inoltre, la sua notevole capacità di memoria da 24 GB riduce al minimo i colli di bottiglia nel trasferimento dei dati, facilitando operazioni senza interruzioni anche con set di dati di grandi dimensioni.

NVIDIA GeForce RTX 3080 TI

La NVIDIA GeForce RTX 3080 TI è emersa come una scheda grafica di fascia media altamente capace che offre prestazioni impressionanti per le attività di machine learning. Con le sue robuste specifiche, tra cui l'architettura Ampere, 8704 core CUDA e 12 GB di memoria GDDR6X, questa scheda offre una notevole potenza di elaborazione. In questo articolo, approfondiremo i vantaggi pratici e le caratteristiche distintive della NVIDIA GeForce RTX 3080 TI, evidenziando la sua proposta di valore per gli utenti che cercano prestazioni elevate senza spendere una fortuna.

Pro della NVIDIA GeForce RTX 3080 TI:

- Prestazioni potenti:

Dotata dell'architettura Ampere e dotata di 8704 core CUDA, la NVIDIA GeForce RTX 3080 TI offre una potenza di elaborazione eccezionale. Ciò consente agli utenti di gestire attività di apprendimento automatico impegnative con facilità, accelerando i calcoli e riducendo i tempi di formazione. - Accelerazione dell'apprendimento dell'hardware:

L'inclusione di Tensor Core nella scheda grafica consente operazioni di rete neurale con accelerazione hardware. Sfruttare i Tensor Core si traduce in un'accelerazione significativa durante l'esecuzione di attività di rete neurale, con conseguente addestramento più rapido dei modelli di deep learning. Questo avanzamento migliora la produttività e facilita iterazioni più rapide del modello. - Prezzo relativamente conveniente:

Con un prezzo di $ 1499, la NVIDIA GeForce RTX 3080 TI offre un'opzione relativamente conveniente per gli utenti che cercano potenti capacità di apprendimento automatico. Questa scheda di fascia media offre un equilibrio ottimale tra prestazioni e costi, rendendola una scelta interessante per individui attenti al budget o piccoli team. - Ray tracing e supporto DLSS:

L'RTX 3080 TI supporta le tecnologie Ray Tracing con accelerazione hardware e Deep Learning Super Sampling (DLSS). Queste funzionalità migliorano la qualità visiva della grafica, consentendo agli utenti di sperimentare ambienti più realistici e coinvolgenti. Le funzionalità di Ray Tracing e DLSS sono risorse preziose quando si visualizzano gli output dei modelli e si esegue il rendering di grafica di alta qualità.

Considerazioni per la NVIDIA GeForce RTX 3080 TI:

- Memoria limitata:

Sebbene RTX 3080 TI offra 12 GB di memoria GDDR6X, è importante notare che ciò potrebbe limitare la capacità di gestire grandi quantità di dati o modelli complessi che richiedono ampie risorse di memoria. Gli utenti devono valutare i propri requisiti specifici e determinare se la capacità di memoria disponibile è in linea con i casi d'uso previsti.

Conclusione:

La NVIDIA GeForce RTX 3080 TI si presenta come una potente scheda grafica di fascia media che offre prestazioni notevoli per le attività di machine learning. Alimentata dall'architettura Ampere e dotata di 8704 core CUDA, questa scheda offre una potenza di elaborazione robusta per gestire in modo efficiente calcoli impegnativi. Con il supporto per l'accelerazione dell'apprendimento dell'hardware tramite Tensor Core, gli utenti possono beneficiare di operazioni di rete neurale accelerate e di un addestramento del modello più rapido.

Avvolgetelo

Nel regno dell'apprendimento automatico, la scelta della scheda grafica giusta è fondamentale per massimizzare le capacità di elaborazione dei dati e consentire un efficiente calcolo parallelo. Considerando fattori chiave come la potenza di calcolo, la capacità di memoria della GPU, il supporto per librerie specializzate, il supporto ad alte prestazioni e la compatibilità con i framework di machine learning, i professionisti possono assicurarsi di disporre dell'hardware necessario per affrontare complesse attività di machine learning. Mentre le GPU NVIDIA dominano il panorama del machine learning, è essenziale valutare i requisiti specifici del progetto e scegliere la scheda grafica che meglio si allinea a tali esigenze. Con la giusta scheda grafica, ricercatori e professionisti possono liberare tutto il potenziale delle loro attività di machine learning.

NVIDIA: il leader nelle GPU di machine learning

Attualmente, NVIDIA è all'avanguardia nelle GPU di machine learning, fornendo driver ottimizzati e ampio supporto per CUDA e cuDNN. Le GPU NVIDIA offrono una straordinaria accelerazione computazionale, consentendo a ricercatori e professionisti di accelerare notevolmente il loro lavoro.

AMD: focalizzata sul gioco, adozione limitata del machine learning

Sebbene le GPU AMD si siano affermate come formidabili contendenti nel settore dei giochi, la loro adozione per l'apprendimento automatico rimane relativamente limitata. Ciò può essere attribuito a fattori come il supporto software limitato e la necessità di aggiornamenti frequenti per soddisfare le esigenze dei framework di machine learning in continua evoluzione.

FAQ

La selezione della scheda grafica appropriata è fondamentale in quanto determina la capacità di gestire l'elaborazione intensiva della matrice e del tensore richiesta per attività come l'addestramento della rete neurale profonda.

Chip AI specializzati come TPU (Tensor Processing Units) e FPGA (Field Programmable Gate Arrays) hanno guadagnato una notevole popolarità negli ultimi tempi.

Compiti che coinvolgono in profondità rete neurale l'addestramento richiede un'elaborazione intensiva di matrici e tensori.

I chip AI specializzati offrono prestazioni ed efficienza migliorate per le attività relative all'intelligenza artificiale, rendendoli altamente desiderabili per l'elaborazione di grandi set di dati e l'esecuzione di calcoli paralleli.

La scelta della scheda grafica giusta con potenza di elaborazione e capacità di memoria sufficienti è fondamentale per ottenere prestazioni elevate nelle attività di addestramento della rete neurale profonda.

Oltre alle schede grafiche, i chip IA specializzati come TPU e FPGA hanno guadagnato una notevole popolarità per la loro efficienza nella gestione delle attività relative all'IA.

TPU e FPGA hanno guadagnato popolarità grazie alla loro capacità di fornire un'accelerazione hardware specializzata per le attività relative all'intelligenza artificiale, consentendo un'elaborazione più rapida ed efficiente di grandi set di dati e calcoli complessi.

I chip AI specializzati come TPU e FPGA spesso superano le schede grafiche tradizionali in termini di prestazioni ed efficienza per le attività AI, poiché sono progettati specificamente per questi carichi di lavoro.

Esistono diverse schede grafiche molto apprezzate per l'apprendimento automatico (ML) e l'intelligenza artificiale (AI) compiti. Ecco alcune delle migliori schede grafiche per ML e AI:

- NVIDIA A100: costruito sull'architettura Ampere, l'A100 è una centrale elettrica per le attività di AI e ML. Vanta un numero enorme di core CUDA e supporta tecnologie AI avanzate.

- NVIDIA GeForce RTX 3090: questa scheda grafica di fascia alta offre prestazioni eccezionali con la sua potente GPU, l'ampia capacità di memoria e il supporto per le tecnologie di accelerazione AI come i Tensor Core.

- NVIDIA Quadro RTX 8000: questa scheda grafica di livello professionale è progettata per applicazioni ML e AI impegnative, con la sua elevata potenza di calcolo e l'ampia capacità di memoria.

Negazione di responsabilità

In linea con la Linee guida del progetto Trust, si prega di notare che le informazioni fornite in questa pagina non intendono essere e non devono essere interpretate come consulenza legale, fiscale, di investimento, finanziaria o di qualsiasi altra forma. È importante investire solo ciò che puoi permetterti di perdere e chiedere una consulenza finanziaria indipendente in caso di dubbi. Per ulteriori informazioni, suggeriamo di fare riferimento ai termini e alle condizioni nonché alle pagine di aiuto e supporto fornite dall'emittente o dall'inserzionista. MetaversePost si impegna a fornire report accurati e imparziali, ma le condizioni di mercato sono soggette a modifiche senza preavviso.

Circa l'autore

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.

Altri articoli

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.