8 Hal Yang Harus Anda Ketahui Tentang Model Bahasa Besar

Singkatnya

Model bahasa besar (LLM) digunakan untuk mengeksplorasi nuansa bahasa alami, meningkatkan kemampuan mesin untuk memahami dan menghasilkan teks, dan mengotomatiskan tugas-tugas seperti pengenalan suara dan terjemahan mesin.

Tidak ada solusi mudah untuk mengelola LLM, tetapi mereka mampu seperti manusia.

Dengan pesatnya perkembangan pemrosesan bahasa alami dan penggunaannya dalam bisnis, minat terhadap model bahasa besar semakin meningkat. Model ini digunakan untuk mengeksplorasi nuansa bahasa alami, meningkatkan kemampuan mesin untuk memahami dan menghasilkan teks, serta mengotomatiskan tugas seperti pengenalan suara dan terjemahan mesin. Berikut adalah delapan hal penting yang harus Anda ketahui tentang model bahasa besar (LLM).

- LLM lebih "mampu" karena biaya terus meningkat

- Sekilas tentang caranya GPT model beradaptasi seiring dengan meningkatnya biaya pelatihan

- LLM belajar memainkan permainan papan dengan menggunakan representasi dunia luar

- Tidak ada solusi mudah untuk mengelola LLM

- Para ahli kesulitan menjelaskan cara kerja LLM

- LLM sama mampunya dengan manusia

- LLM harus lebih dari sekedar "jack-of-all-trade"

- Model 'lebih pintar' dari yang dipikirkan orang berdasarkan kesan pertama

LLM lebih "mampu" karena biaya terus meningkat

LLM diperkirakan menjadi lebih "mampu" dengan biaya yang meningkat, bahkan tanpa inovasi yang keren. Hal utama di sini adalah prediktabilitas, yang ditunjukkan di artikel tentang GPT-4: lima hingga tujuh model kecil diajarkan dengan anggaran 0.1% dari yang terakhir, dan kemudian prediksi dibuat untuk model besar berdasarkan ini. Untuk penilaian umum kebingungan dan metrik pada subsampel dari satu tugas tertentu, prediksi seperti itu sangat akurat. Prediktabilitas ini penting untuk bisnis dan organisasi yang mengandalkan LLM untuk operasi mereka, karena mereka dapat menganggarkan sesuai dan merencanakan pengeluaran masa depan. Namun, penting untuk dicatat bahwa sementara peningkatan biaya dapat mengarah pada peningkatan kemampuan, tingkat peningkatan pada akhirnya mungkin tidak stabil, sehingga diperlukan investasi dalam inovasi baru untuk terus berkembang.

Sekilas tentang caranya GPT model beradaptasi seiring dengan meningkatnya biaya pelatihan

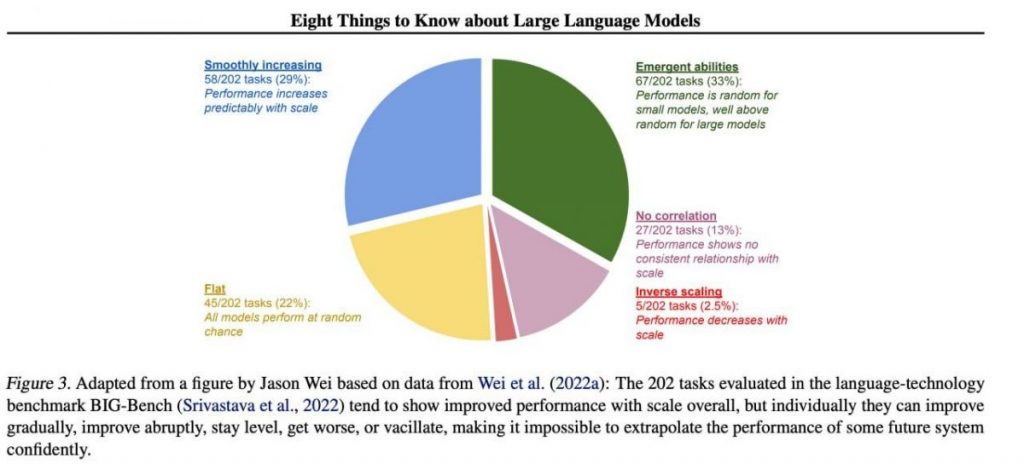

Namun, keterampilan penting tertentu cenderung muncul secara tak terduga sebagai produk sampingan dari peningkatan biaya pelatihan (pelatihan lebih lama, lebih banyak data, model lebih besar) — hampir tidak mungkin memprediksi kapan model akan mulai menjalankan tugas tertentu. Kami menjelajahi topik lebih mendalam di kami artikel tentang sejarah perkembangan GPT model. Gambar tersebut menunjukkan distribusi peningkatan kualitas model di berbagai tugas. Hanya model besar yang bisa belajar melakukan berbagai tugas. Grafik ini menyoroti dampak signifikan dari peningkatan ukuran GPT model pada kinerja mereka di berbagai tugas. Namun, penting untuk dicatat bahwa ini datang dengan biaya peningkatan sumber daya komputasi dan dampak lingkungan.

LLM belajar memainkan permainan papan dengan menggunakan representasi dunia luar

LLM sering belajar dan menggunakan representasi dunia luar. Ada banyak contoh di sini, dan ini salah satunya: Model dilatih memainkan permainan papan berdasarkan deskripsi gerakan individu, tanpa pernah melihat gambar lapangan permainan, mempelajari representasi internal keadaan papan pada setiap gerakan. Representasi internal ini kemudian dapat digunakan memprediksi masa depan pergerakan dan hasil, memungkinkan model memainkan permainan pada level tinggi. Kemampuan untuk mempelajari dan menggunakan representasi adalah kuncinya aspek pembelajaran mesin dan kecerdasan buatan.

Tidak ada solusi mudah untuk mengelola LLM

Tidak ada metode yang dapat diandalkan untuk mengontrol perilaku LLM. Meskipun telah ada beberapa kemajuan dalam memahami dan memitigasi berbagai masalah (termasuk ChatGPT dan GPT-4 dengan bantuan umpan balik), tidak ada konsensus mengenai apakah kita dapat menyelesaikannya. Ada kekhawatiran yang berkembang bahwa hal ini akan menjadi masalah besar dan berpotensi menimbulkan bencana di masa depan ketika sistem yang lebih besar diciptakan. Oleh karena itu, para peneliti mengeksplorasi metode baru untuk memastikan bahwa sistem AI selaras dengan nilai-nilai dan tujuan kemanusiaan, seperti penyelarasan nilai dan rekayasa penghargaan. Namun, menjamin hal tersebut masih merupakan tugas yang menantang keamanan dan keandalan LLM dalam skenario dunia nyata yang kompleks.

| Baca lebih lanjut: OpenAI Merakit Tim yang terdiri dari 50+ Pakar untuk Ditingkatkan GPT-4Keselamatan |

Para ahli kesulitan menjelaskan cara kerja LLM

Para ahli belum bisa menafsirkan cara kerja bagian dalam LLM. Tidak ada teknik yang memungkinkan kita untuk menyatakan dengan cara yang memuaskan jenis pengetahuan, penalaran, atau tujuan apa yang digunakan model ketika menghasilkan hasil apa pun. Kurangnya interpretasi ini menimbulkan kekhawatiran tentang keandalan dan keadilan keputusan LLM, terutama dalam aplikasi berisiko tinggi seperti peradilan pidana atau penilaian kredit. Ini juga menyoroti perlunya penelitian lebih lanjut untuk mengembangkan model AI yang lebih transparan dan akuntabel.

LLM sama mampunya dengan manusia

Meskipun LLM dilatih terutama untuk meniru perilaku manusia saat menulis teks, mereka berpotensi mengungguli kita dalam banyak tugas. Hal ini sudah terlihat saat bermain catur atau Go. Hal ini disebabkan oleh kemampuan mereka menganalisis data dalam jumlah besar dan mengambil keputusan berdasarkan analisis tersebut dengan kecepatan yang tidak dapat ditandingi oleh manusia. Namun, LLM masih kekurangan kreativitas dan intuisi yang dimiliki manusia, sehingga kurang cocok untuk banyak tugas.

| Baca lebih lanjut: OpenAI Merakit Tim yang terdiri dari 50+ Pakar untuk Ditingkatkan GPT-4Keselamatan |

LLM harus lebih dari sekedar "jack-of-all-trade"

LLM tidak boleh mengungkapkan nilai penciptanya atau nilai yang dikodekan dalam pilihan dari Internet. Mereka tidak boleh mengulangi stereotip atau teori konspirasi atau berusaha menyinggung siapa pun. Sebaliknya, LLM harus dirancang untuk memberikan informasi yang tidak bias dan faktual kepada penggunanya sambil menghormati perbedaan budaya dan masyarakat. Selain itu, mereka harus menjalani pengujian dan pemantauan rutin untuk memastikan mereka terus memenuhi standar ini.

Model 'lebih pintar' dari yang dipikirkan orang berdasarkan kesan pertama

Perkiraan kemampuan model berdasarkan kesan pertama seringkali menyesatkan. Sangat sering, Anda perlu memberikan prompt yang tepat, menyarankan model, dan mungkin menunjukkan contoh, dan itu akan mulai mengatasinya dengan lebih baik. Artinya, ini "lebih pintar" dari yang terlihat pada pandangan pertama. Oleh karena itu, sangat penting untuk memberikan model kesempatan yang adil dan menyediakan sumber daya yang diperlukan untuk melakukan yang terbaik. Dengan pendekatan yang tepat, model yang tampaknya tidak memadai pun dapat mengejutkan kita dengan kemampuannya.

Jika kita fokus pada sampel 202 tugas dari kumpulan data BIG-Bench (yang secara khusus dibuat sulit untuk diuji model bahasa dari dan ke), maka sebagai aturan (rata-rata), model menunjukkan peningkatan kualitas seiring dengan meningkatnya skala, namun secara individual, metrik dalam tugas dapat:

- membaik secara bertahap,

- membaik secara drastis,

- tetap tidak berubah,

- mengurangi,

- tidak menunjukkan korelasi.

Semua ini mengarah pada ketidakmungkinan mengekstrapolasi kinerja sistem masa depan dengan percaya diri. Bagian hijau sangat menarik — di sinilah indikator kualitas melonjak tajam tanpa alasan sama sekali.

Baca lebih lanjut tentang AI:

Penolakan tanggung jawab

Sejalan dengan Percayai pedoman Proyek, harap dicatat bahwa informasi yang diberikan pada halaman ini tidak dimaksudkan untuk dan tidak boleh ditafsirkan sebagai nasihat hukum, pajak, investasi, keuangan, atau bentuk nasihat lainnya. Penting untuk hanya menginvestasikan jumlah yang mampu Anda tanggung kerugiannya dan mencari nasihat keuangan independen jika Anda ragu. Untuk informasi lebih lanjut, kami menyarankan untuk merujuk pada syarat dan ketentuan serta halaman bantuan dan dukungan yang disediakan oleh penerbit atau pengiklan. MetaversePost berkomitmen terhadap pelaporan yang akurat dan tidak memihak, namun kondisi pasar dapat berubah tanpa pemberitahuan.

Tentang Penulis

Damir adalah pemimpin tim, manajer produk, dan editor di Metaverse Post, mencakup topik seperti AI/ML, AGI, LLM, Metaverse, dan Web3-bidang terkait. Artikelnya menarik lebih dari satu juta pengguna setiap bulan. Dia tampaknya ahli dengan pengalaman 10 tahun dalam SEO dan pemasaran digital. Damir telah disebutkan dalam Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto, dan publikasi lainnya. Dia melakukan perjalanan antara UEA, Turki, Rusia, dan CIS sebagai pengembara digital. Damir memperoleh gelar sarjana dalam bidang fisika, yang menurutnya telah memberinya keterampilan berpikir kritis yang diperlukan untuk berhasil dalam lanskap internet yang selalu berubah.

lebih artikel

Damir adalah pemimpin tim, manajer produk, dan editor di Metaverse Post, mencakup topik seperti AI/ML, AGI, LLM, Metaverse, dan Web3-bidang terkait. Artikelnya menarik lebih dari satu juta pengguna setiap bulan. Dia tampaknya ahli dengan pengalaman 10 tahun dalam SEO dan pemasaran digital. Damir telah disebutkan dalam Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto, dan publikasi lainnya. Dia melakukan perjalanan antara UEA, Turki, Rusia, dan CIS sebagai pengembara digital. Damir memperoleh gelar sarjana dalam bidang fisika, yang menurutnya telah memberinya keterampilan berpikir kritis yang diperlukan untuk berhasil dalam lanskap internet yang selalu berubah.