Las 10 mejores tarjetas gráficas para ML/AI: GPU superior para aprendizaje profundo

La selección de una tarjeta gráfica adecuada juega un papel crucial para lograr un rendimiento óptimo para procesar grandes conjuntos de datos y realizar cálculos paralelos. Particularmente para tareas que implican un entrenamiento profundo de redes neuronales, la demanda de procesamiento intensivo de matrices y tensores es primordial. Vale la pena señalar que los chips de IA especializados, las TPU y las FPGA han ganado una popularidad considerable en los últimos tiempos.

Características clave de las tarjetas gráficas de aprendizaje automático

Al considerar una tarjeta gráfica para fines de aprendizaje automático, se deben tener en cuenta varias características esenciales:

- Poder computacional:

La cantidad de núcleos o procesadores afecta directamente las capacidades de procesamiento paralelo de la tarjeta gráfica. Un mayor número de núcleos se traduce en cálculos más rápidos y eficientes. - Capacidad de memoria de GPU:

La capacidad de memoria amplia es crucial para manejar de manera efectiva grandes conjuntos de datos y modelos complejos. La capacidad de almacenar y acceder a los datos de manera eficiente es vital para lograr un rendimiento óptimo. - Soporte para Bibliotecas Especializadas:

La compatibilidad de hardware con bibliotecas especializadas como CUDA o ROCm puede acelerar significativamente el modelo procesos de formación. Aprovechar las optimizaciones específicas del hardware agiliza los cálculos y mejora la eficiencia general. - Soporte de alto rendimiento:

Las tarjetas gráficas con memoria rápida y configuraciones de bus de memoria ancha brindan capacidades de alto rendimiento durante el entrenamiento del modelo. Estas características aseguran un procesamiento de datos fluido y rápido. - Compatibilidad con marcos de aprendizaje automático:

Es esencial garantizar una compatibilidad perfecta entre la tarjeta gráfica seleccionada y los marcos de trabajo de aprendizaje automático y las herramientas de desarrollo empleados. La compatibilidad garantiza una integración fluida y una utilización óptima de los recursos.

Tabla comparativa de tarjetas gráficas para ML/AI

| Tarjeta gráfica | Memoria, GB | Núcleos CUDA | Núcleos tensoriales | Precio (dólares americanos |

|---|---|---|---|---|

| Tesla V100 | 16/32 | 5120 | 640 | 14,999 |

| tesla a100 | 40/80 | 7936 | 432 | 10,499 |

| Quadro RTX 8000 | 48 | 4608 | 576 | 7,999 |

| Un 6000 Ada | 48 | 18176 | 568 | 6,499 |

| RTX A5000 | 24 | 8192 | 256 | 1,899 |

| RTX 3090TI | 24 | 10752 | 336 | 1,799 |

| RTX 4090 | 24 | 16384 | 512 | 1,499 |

| RTX 3080TI | 12 | 10240 | 320 | 1,399 |

| RTX 4080 | 16 | 9728 | 304 | 1,099 |

| RTX 4070 | 12 | 7680 | 184 | 599 |

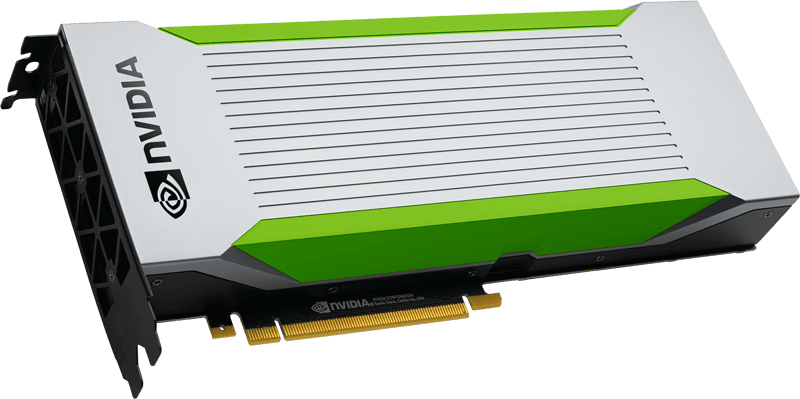

NVIDIA Tesla V100

Tesla V100 de NVIDIA se erige como una potente GPU Tensor Core diseñada para cargas de trabajo de inteligencia artificial, computación de alto rendimiento (HPC) y aprendizaje automático. Aprovechando la arquitectura Volta de vanguardia, esta tarjeta gráfica muestra capacidades de rendimiento sobresalientes, brindando un rendimiento impresionante de 125 billones de operaciones de punto flotante por segundo (TFLOPS). En este artículo, exploraremos los notables beneficios y consideraciones asociados con el Tesla V100.

Ventajas de Tesla V100:

- Alto rendimiento:

Aprovechando el poder de la arquitectura Volta y sus 5120 núcleos CUDA, el Tesla V100 ofrece un rendimiento excepcional para tareas de aprendizaje automático. Su capacidad para manejar extensos conjuntos de datos y ejecutar cálculos complejos a velocidades notables es fundamental para impulsar flujos de trabajo de aprendizaje automático eficientes. - Gran capacidad de memoria:

Con 16 GB de memoria HBM2, el Tesla V100 permite el procesamiento eficiente de volúmenes de datos sustanciales durante el entrenamiento del modelo. Este atributo es particularmente ventajoso cuando se trabaja con conjuntos de datos extensos, lo que permite una manipulación de datos sin problemas. Además, el ancho del bus de la memoria de video de 4096 bits facilita la transferencia de datos de alta velocidad entre el procesador y la memoria de video, lo que mejora aún más el rendimiento del entrenamiento y la inferencia del modelo de aprendizaje automático. - Tecnologías de aprendizaje profundo:

El Tesla V100 está equipado con varias tecnologías de aprendizaje profundo, incluidos Tensor Cores, que aceleran los cálculos de coma flotante. Esta aceleración contribuye a reducciones significativas en el tiempo de entrenamiento del modelo y, en última instancia, mejora el rendimiento general. - Flexibilidad y escalabilidad:

La versatilidad del Tesla V100 es evidente en su compatibilidad con sistemas de escritorio y servidores. Se integra a la perfección con una amplia gama de marcos de aprendizaje automático, como TensorFlow, PyTorch, Caffe y más, y ofrece a los desarrolladores la libertad de elegir sus herramientas preferidas para el desarrollo y la capacitación de modelos.

Consideraciones para Tesla V100:

- Alto costo:

Como solución de nivel profesional, NVIDIA Tesla V100 tiene el precio correspondiente. Con un costo de $14,447, puede representar una inversión sustancial para individuos o pequeños equipos de aprendizaje automático. El precio debe tenerse en cuenta al considerar el presupuesto general y los requisitos. - Consumo de energía y refrigeración:

Dado el sólido rendimiento del Tesla V100, exige una fuente de alimentación significativa y genera una cantidad considerable de calor. Se deben implementar medidas de refrigeración adecuadas para mantener temperaturas de funcionamiento óptimas, lo que puede conducir a un mayor consumo de energía y costos asociados. - Requisitos de infraestructura:

Para aprovechar al máximo las capacidades del Tesla V100, se necesita una infraestructura compatible. Esto incluye un potente procesador y suficiente memoria RAM para garantizar una procesamiento de datos y entrenamiento de modelos.

Conclusión:

NVIDIA A100, con la tecnología de la arquitectura Ampere de vanguardia, representa un avance significativo en la tecnología de GPU para aplicaciones de aprendizaje automático. Con sus capacidades de alto rendimiento, gran capacidad de memoria y soporte para la tecnología NVLink, el A100 empodera a los científicos de datos y investigadores para abordar tareas complejas de aprendizaje automático con eficiencia y precisión. Sin embargo, el alto costo, el consumo de energía y la compatibilidad del software deben evaluarse cuidadosamente antes de adoptar NVIDIA A100. Con sus avances y avances, el A100 abre nuevas posibilidades para la inferencia y el entrenamiento acelerado de modelos, allanando el camino para nuevos avances en el campo del aprendizaje automático.

NVIDIA Tesla A100

La NVIDIA A100, impulsada por la arquitectura Ampere de última generación, se destaca como una tarjeta gráfica notable diseñada para satisfacer las demandas de las tareas de aprendizaje automático. Al ofrecer un rendimiento y una flexibilidad excepcionales, el A100 representa un avance significativo en la tecnología de GPU. En este artículo, exploraremos los notables beneficios y consideraciones asociados con NVIDIA A100.

Ventajas de NVIDIA A100:

- Alto rendimiento:

Equipado con una cantidad sustancial de núcleos CUDA (4608), NVIDIA A100 ofrece capacidades de rendimiento impresionantes. Su poder computacional mejorado permite flujos de trabajo de aprendizaje automático acelerados, lo que resulta en procesos de inferencia y entrenamiento de modelos más rápidos. - Gran capacidad de memoria:

La tarjeta gráfica NVIDIA A100 cuenta con 40 GB de memoria HBM2, lo que facilita el manejo eficiente de grandes cantidades de datos durante entrenamiento del modelo de aprendizaje profundo. Esta gran capacidad de memoria es particularmente ventajosa para trabajar con conjuntos de datos complejos y de gran escala, lo que permite un procesamiento de datos fluido y sin problemas. - Compatibilidad con la tecnología NVLink:

La inclusión de la tecnología NVLink permite que varias tarjetas gráficas NVIDIA A100 se combinen sin problemas en un solo sistema, lo que facilita la computación paralela. Este paralelismo mejorado mejora significativamente el rendimiento y acelera el entrenamiento del modelo, lo que contribuye a flujos de trabajo de aprendizaje automático más eficientes.

Consideraciones para NVIDIA A100:

- Alto costo:

Como una de las tarjetas gráficas más poderosas y avanzadas disponibles en el mercado, NVIDIA A100 tiene un precio más alto. Con un precio de $10,000, puede ser una inversión sustancial para individuos u organizaciones que estén considerando su adopción. - El consumo de energía:

Utilizar todo el potencial de la tarjeta gráfica NVIDIA A100 requiere una fuente de alimentación significativa. Esto puede conducir a un mayor consumo de energía y requerir medidas apropiadas para la administración de energía, especialmente cuando se implementa la tarjeta a gran escala. los centros de datos. - Compatibilidad de software:

Para garantizar un rendimiento óptimo, NVIDIA A100 se basa en el software y los controladores adecuados. Es importante tener en cuenta que es posible que algunos programas y marcos de aprendizaje automático no sean totalmente compatibles con este modelo de tarjeta gráfica específico. Se deben tener en cuenta las consideraciones de compatibilidad al integrar NVIDIA A100 en los flujos de trabajo de aprendizaje automático existentes.

Conclusión:

El Tesla V100, con su arquitectura Volta y características de vanguardia, se erige como una impresionante GPU Tensor Core diseñada para cargas de trabajo de inteligencia artificial, HPC y aprendizaje automático. Sus capacidades de alto rendimiento, gran capacidad de memoria, tecnologías de aprendizaje profundo y flexibilidad lo convierten en una opción convincente para organizaciones e investigadores que buscan proyectos avanzados de aprendizaje automático. Sin embargo, las consideraciones como el costo, el consumo de energía y los requisitos de infraestructura deben evaluarse cuidadosamente para garantizar una inversión bien alineada. Con el Tesla V100, el potencial de avances en IA y aprendizaje automático está al alcance, potenciando científicos de datos e investigadores para empujar los límites de la innovación.

NVIDIA Quadro RTX 8000

La Quadro RTX 8000 se destaca como una poderosa tarjeta gráfica diseñada específicamente para profesionales que necesitan capacidades de renderizado excepcionales. Con sus funciones avanzadas y especificaciones de alto rendimiento, esta tarjeta gráfica ofrece beneficios prácticos para diversas aplicaciones, incluida la visualización de datos, gráficos por computadora y aprendizaje automático. En este artículo, exploraremos las características distintivas y las ventajas de la Quadro RTX 8000.

Ventajas de Quadro RTX 8000:

- Alto rendimiento:

La Quadro RTX 8000 cuenta con una potente GPU y unos impresionantes 5120 núcleos CUDA, lo que proporciona un rendimiento sin igual para tareas de renderizado exigentes. Su poder computacional excepcional permite a los profesionales renderizar modelos complejos con sombras, reflejos y refracciones realistas, entregando imágenes realistas y experiencias visuales inmersivas. - Soporte de trazado de rayos:

El trazado de rayos acelerado por hardware es una característica destacada de Quadro RTX 8000. Esta tecnología permite la creación de imágenes fotorrealistas y efectos de iluminación realistas. Para los profesionales que se dedican a la visualización de datos, gráficos por computadora o aprendizaje automático, esta característica agrega un nivel de realismo y fidelidad visual a su trabajo, mejorando la calidad general de sus proyectos. - Gran capacidad de memoria:

La Quadro RTX 8000 ofrece una amplia memoria gráfica GDDR48 de 6 GB. Esta gran capacidad de memoria permite una eficiente almacenamiento y recuperación de datos, particularmente cuando se trabaja con modelos y conjuntos de datos de aprendizaje automático a gran escala. Los profesionales pueden realizar cálculos complejos y manejar cantidades sustanciales de datos sin comprometer el rendimiento o la eficiencia. - Compatibilidad con bibliotecas y marcos:

La compatibilidad con bibliotecas y marcos de aprendizaje automático populares, incluidos TensorFlow, PyTorch, CUDA, cuDNN y más, garantiza una integración perfecta en los flujos de trabajo existentes. Los profesionales pueden aprovechar la potencia de Quadro RTX 8000 con sus herramientas y marcos preferidos, lo que permite el desarrollo y la capacitación eficientes de modelos de aprendizaje automático.

Consideraciones para Quadro RTX 8000:

- Alto costo:

Como acelerador de gráficos profesional, Quadro RTX 8000 tiene un precio más alto en comparación con otras tarjetas gráficas. Su costo real es de $8,200, lo que puede hacerlo menos accesible para usuarios individuales o para operaciones a pequeña escala.

Conclusión:

Quadro RTX 8000 establece un punto de referencia para la representación de gráficos de alto rendimiento en aplicaciones profesionales. Con su potente GPU, soporte de trazado de rayos, gran capacidad de memoria y compatibilidad con bibliotecas y marcos de aprendizaje automático populares, Quadro RTX 8000 permite a los profesionales crear modelos, visualizaciones y simulaciones visualmente sorprendentes y realistas. Si bien el costo más alto puede representar un desafío para algunos, los beneficios de esta tarjeta gráfica la convierten en un activo valioso para los profesionales que necesitan un rendimiento y una capacidad de memoria de primer nivel. Con Quadro RTX 8000, los profesionales pueden liberar su potencial creativo y ampliar los límites de su trabajo en los campos de visualización de datos, gráficos por computadora y aprendizaje automático.

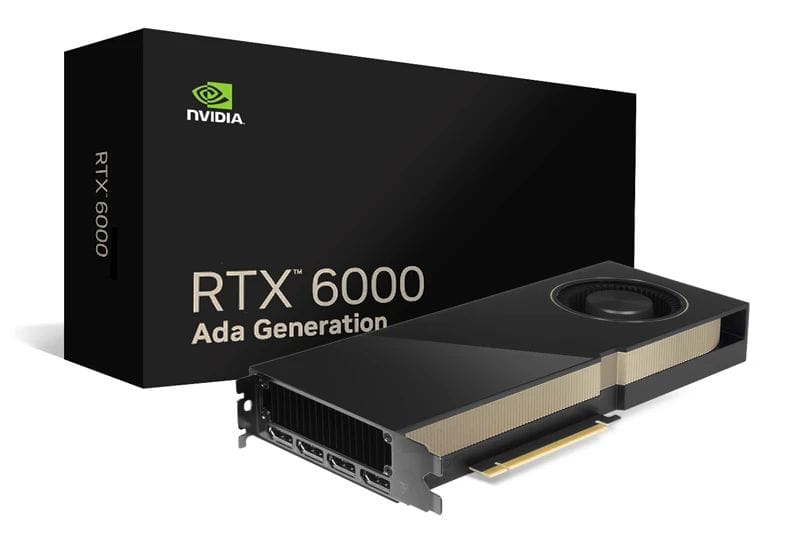

NVIDIA RTX A6000 Ad

La tarjeta gráfica RTX A6000 Ada se destaca como una opción convincente para los profesionales que buscan una solución potente pero eficiente en energía. Con sus funciones avanzadas, que incluyen la arquitectura Ada Lovelace, núcleos CUDA de alto rendimiento y amplia capacidad de VRAM, la RTX A6000 Ada ofrece beneficios prácticos para una variedad de aplicaciones profesionales. En este artículo, exploraremos las características distintivas y las ventajas del RTX A6000 Ada.

Ventajas de RTX A6000 Ada:

- Alto rendimiento:

El RTX A6000 Ada aprovecha el poder de la arquitectura Ada Lovelace, incorporando núcleos RT de tercera generación, núcleos Tensor de cuarta generación y núcleos CUDA de próxima generación. Estos avances en la arquitectura contribuyen a un rendimiento excepcional, lo que permite a los profesionales abordar tareas exigentes con facilidad. Con 48 GB de VRAM, la tarjeta gráfica proporciona amplia memoria para el manejo eficiente de grandes conjuntos de datos durante el entrenamiento del modelo. - Gran capacidad de memoria:

Equipada con 48 GB de memoria, la RTX A6000 Ada garantiza un procesamiento eficiente de grandes volúmenes de datos. Esta capacidad de memoria expansiva permite a los profesionales entrenar modelos complejos de aprendizaje automático y trabajar con conjuntos de datos masivos sin comprometer el rendimiento o la eficiencia. La capacidad de manejar grandes cargas de datos contribuye a un entrenamiento de modelos más rápido y preciso. - Bajo consumo de energía:

El RTX A6000 Ada pone énfasis en la eficiencia energética, lo que lo convierte en una opción ideal para profesionales conscientes del consumo de energía. Al optimizar el uso de energía, esta tarjeta gráfica reduce los costos de energía y contribuye a un entorno de trabajo más sostenible y rentable.

Consideraciones para RTX A6000 Ada:

- Alto costo:

El RTX A6000 Ada, con su rendimiento y características impresionantes, tiene un precio más alto. Con un precio aproximado de $6,800, esta tarjeta gráfica puede ser una inversión significativa para usuarios individuales u organizaciones más pequeñas. Sin embargo, el rendimiento y la eficiencia superiores que ofrece justifican su valor para los profesionales que buscan resultados óptimos.

Conclusión:

La RTX A6000 Ada emerge como una excelente opción de tarjeta gráfica para profesionales que buscan maximizar el rendimiento y la eficiencia. Con su arquitectura avanzada, gran capacidad de VRAM y bajo consumo de energía, esta tarjeta gráfica ofrece resultados excepcionales en una variedad de aplicaciones profesionales. La arquitectura Ada Lovelace, junto con los núcleos CUDA de próxima generación y la alta capacidad de memoria, garantiza una computación de alto rendimiento y un manejo eficiente de grandes conjuntos de datos. Si bien el RTX A6000 Ada tiene un costo más alto, sus beneficios y capacidades lo convierten en un activo valioso para los profesionales comprometidos con lograr resultados óptimos en su trabajo. Con el RTX A6000 Ada, los profesionales pueden liberar todo su potencial y elevar su rendimiento en varios dominios, incluido el aprendizaje automático, el análisis de datos y los gráficos por computadora.

Nvidia RTX A5000

La RTX A5000, basada en la arquitectura NVIDIA Ampere, emerge como una poderosa tarjeta gráfica diseñada para acelerar las tareas de aprendizaje automático. Con sus características sólidas y capacidades de alto rendimiento, el RTX A5000 ofrece beneficios prácticos y ventajas distintivas para los profesionales en el campo. En este artículo, profundizaremos en las características distintivas del RTX A5000 y su impacto potencial en las aplicaciones de aprendizaje automático.

Ventajas de RTX A5000:

- Alto rendimiento:

Equipado con 8192 núcleos CUDA y 256 núcleos tensoriales, el RTX A5000 cuenta con una potencia de procesamiento excepcional. Esta arquitectura de alto rendimiento permite un procesamiento rápido y eficiente de grandes conjuntos de datos, lo que permite un entrenamiento más rápido de modelos de aprendizaje automático. La abundancia de núcleos CUDA y el alto ancho de banda de la memoria contribuyen a los cálculos fluidos y acelerados, lo que facilita las operaciones complejas dentro de los flujos de trabajo de aprendizaje automático. - Soporte de aceleración de hardware AI:

La tarjeta gráfica RTX A5000 proporciona aceleración de hardware para operaciones y algoritmos relacionados con la IA. Con su diseño optimizado, la tarjeta puede mejorar significativamente el rendimiento de las tareas de IA, brindando resultados más rápidos y eficientes. Al aprovechar el poder de la aceleración de hardware de IA dedicada, los profesionales pueden optimizar sus flujos de trabajo de aprendizaje automático y lograr una mayor productividad. - Gran capacidad de memoria:

Con 24 GB de GDDR6 VRAM, el RTX A5000 ofrece una amplia memoria para manejar grandes conjuntos de datos y modelos complejos de aprendizaje automático. Esta amplia capacidad de memoria permite a los profesionales trabajar con tareas de uso intensivo de datos sin comprometer el rendimiento o la eficiencia. La disponibilidad de abundante VRAM garantiza un acceso fluido a los datos y un entrenamiento más rápido, lo que permite un desarrollo de modelos más preciso y completo. - Compatibilidad con el marco de aprendizaje automático:

El RTX A5000 se integra a la perfección con marcos de aprendizaje automático populares, como TensorFlow y PyTorch. Con sus controladores y bibliotecas optimizados, la tarjeta gráfica permite a los desarrolladores e investigadores aprovechar al máximo las capacidades de estos marcos. Esta compatibilidad garantiza la utilización eficiente de los recursos del RTX A5000, lo que permite a los profesionales desarrollar y entrenar modelos de aprendizaje automático con facilidad.

Consideraciones para RTX A5000:

- Consumo de energía y refrigeración:

Es importante tener en cuenta que las tarjetas gráficas de este calibre normalmente consumen una cantidad significativa de energía y generan un calor considerable durante el funcionamiento. Para garantizar un rendimiento y una longevidad óptimos, se deben implementar las medidas de enfriamiento adecuadas y una capacidad de suministro de energía suficiente. Estas precauciones garantizan la utilización eficiente y confiable del RTX A5000 en entornos exigentes de aprendizaje automático.

Conclusión:

La RTX A5000 se destaca como una potente tarjeta gráfica diseñada para satisfacer las exigentes necesidades de los profesionales del aprendizaje automático. Con sus funciones avanzadas, que incluyen una gran cantidad de núcleos CUDA, soporte de aceleración de hardware de IA y amplia capacidad de memoria, el RTX A5000 ofrece un rendimiento excepcional para procesar grandes cantidades de datos y entrenar modelos complejos. Su perfecta integración con los marcos de trabajo de aprendizaje automático más populares mejora aún más su facilidad de uso y versatilidad. Si bien las consideraciones como el consumo de energía y la refrigeración son cruciales, la infraestructura y las precauciones adecuadas pueden garantizar la utilización efectiva de las capacidades del RTX A5000. Con el RTX A5000, los profesionales pueden desbloquear nuevas posibilidades en el aprendizaje automático e impulsar su investigación, desarrollo e implementación de modelos innovadores.

NVIDIA RTX 4090

La tarjeta gráfica NVIDIA RTX 4090 surge como una poderosa solución diseñada para satisfacer las demandas de la última generación de redes neuronales. Con su excelente rendimiento y funciones avanzadas, la RTX 4090 ofrece beneficios prácticos y se distingue como una opción confiable para los profesionales en el campo. En este artículo, exploraremos las características clave del RTX 4090 y su impacto potencial en la aceleración de los modelos de aprendizaje automático.

Ventajas de NVIDIA RTX 4090:

- Rendimiento excepcional:

Equipado con tecnología de punta, NVIDIA RTX 4090 ofrece un rendimiento excepcional que permite el manejo eficiente de cálculos complejos y grandes conjuntos de datos. La tarjeta gráfica aprovecha su poderosa arquitectura para acelerar el entrenamiento de modelos de aprendizaje automático, lo que facilita resultados más rápidos y precisos. Las capacidades de alto rendimiento del RTX 4090 permiten a los profesionales abordar tareas desafiantes y lograr una mayor productividad en sus proyectos de redes neuronales.

Consideraciones para NVIDIA RTX 4090:

- Desafíos de enfriamiento:

La intensa generación de calor de NVIDIA RTX 4090 puede presentar desafíos en términos de enfriamiento. Debido a la naturaleza de alto rendimiento de la tarjeta, es esencial garantizar que se implementen las medidas de enfriamiento adecuadas para evitar el sobrecalentamiento. Los usuarios deben tener en cuenta que en configuraciones de varias tarjetas, los requisitos de disipación de calor se vuelven aún más críticos para mantener un rendimiento óptimo y evitar apagados automáticos provocados por alcanzar temperaturas críticas. - Limitaciones de configuración:

El diseño de GPU de NVIDIA RTX 4090 impone ciertas limitaciones en la cantidad de tarjetas que se pueden instalar en una estación de trabajo. Esta restricción puede afectar a los usuarios que requieren varias tarjetas RTX 4090 para sus proyectos. Es necesario considerar detenidamente la configuración y la compatibilidad de la estación de trabajo para garantizar la utilización óptima de las capacidades de la RTX 4090.

Conclusión:

La tarjeta gráfica NVIDIA RTX 4090 es una opción poderosa para los profesionales que buscan potenciar la última generación de redes neuronales. Con su desempeño sobresaliente y manejo eficiente de cálculos complejos y grandes conjuntos de datos, el RTX 4090 acelera el entrenamiento de modelos de aprendizaje automático, abriendo nuevas posibilidades para investigadores y desarrolladores en el campo. Sin embargo, los usuarios deben tener en cuenta los desafíos de refrigeración asociados con el intenso calor generado por la tarjeta, especialmente en configuraciones de varias tarjetas. Además, las limitaciones de configuración deben tenerse en cuenta al considerar la instalación de varias tarjetas RTX 4090 en una estación de trabajo. Al aprovechar las capacidades de NVIDIA RTX 4090 y abordar estas consideraciones, los profesionales pueden optimizar sus proyectos de redes neuronales y desbloquear nuevas fronteras en los avances del aprendizaje automático.

NVIDIA RTX 4080

La tarjeta gráfica RTX 4080 se ha perfilado como una solución potente y eficiente en el campo de la inteligencia artificial. Con su alto rendimiento y precio razonable, el RTX 4080 presenta una opción atractiva para los desarrolladores que buscan maximizar el potencial de su sistema. En este artículo, profundizaremos en las características distintivas y los beneficios prácticos del RTX 4080, explorando su impacto en la aceleración de las tareas de aprendizaje automático.

Ventajas de la RTX 4080:

- Alto rendimiento:

El RTX 4080 cuenta con unos impresionantes 9728 núcleos NVIDIA CUDA, lo que le permite ofrecer una potencia informática excepcional para tareas de aprendizaje automático. Esta capacidad de alto rendimiento, combinada con la presencia de núcleos tensoriales y la compatibilidad con el trazado de rayos, contribuye a un procesamiento de datos más eficiente y una mayor precisión en las operaciones relacionadas con la IA. Los desarrolladores pueden aprovechar la potencia del RTX 4080 para manejar cálculos complejos y grandes conjuntos de datos, optimizando sus flujos de trabajo de aprendizaje automático. - Precio competitivo:

Con un precio de $1,199, el RTX 4080 ofrece una propuesta atractiva para individuos y equipos pequeños que buscan una solución productiva de aprendizaje automático. Su combinación de asequibilidad y alto rendimiento lo convierte en una opción accesible para los desarrolladores que buscan aprovechar los beneficios de la IA sin romper el banco.

Consideraciones para el RTX 4080:

- Limitación SLI:

Es importante tener en cuenta que el RTX 4080 no es compatible con NVIDIA NVLink con la función SLI. Esta limitación implica que los usuarios no pueden combinar varias tarjetas RTX 4080 en modo SLI para mejorar aún más el rendimiento. Si bien esto puede restringir la escalabilidad de la tarjeta gráfica en ciertas configuraciones, no disminuye sus capacidades independientes para brindar un procesamiento de IA eficiente.

Conclusión:

La tarjeta gráfica RTX 4080 es una opción convincente para los desarrolladores que buscan desbloquear capacidades de inteligencia artificial de alto rendimiento. Con sus sólidas especificaciones, que incluyen 9728 núcleos NVIDIA CUDA, núcleos tensoriales y soporte de trazado de rayos, el RTX 4080 ofrece una solución práctica para acelerar las tareas de aprendizaje automático. Además, su precio competitivo de $ 1,199 lo convierte en una opción accesible para individuos y equipos pequeños, lo que les permite aprovechar el poder de la IA sin una carga financiera significativa. Si bien la ausencia de compatibilidad con SLI restringe las configuraciones de múltiples tarjetas, no resta valor al rendimiento y la eficiencia independientes de la RTX 4080. Al aprovechar las ventajas de la RTX 4080, los desarrolladores pueden elevar sus proyectos de aprendizaje automático y lograr nuevos avances en inteligencia artificial. avances

NVIDIA RTX 4070

La tarjeta gráfica NVIDIA RTX 4070, basada en la innovadora arquitectura Ada Lovelace, ha causado sensación en el ámbito del aprendizaje automático. Con su capacidad de memoria de 12 GB, esta tarjeta gráfica ofrece acceso a datos acelerado y velocidades de entrenamiento mejoradas para modelos de aprendizaje automático. En este artículo, profundizaremos en los beneficios prácticos y las características distintivas de NVIDIA RTX 4070, destacando su idoneidad para las personas que ingresan al campo del aprendizaje automático.

Ventajas de NVIDIA RTX 4070:

- Alto rendimiento:

NVIDIA RTX 4070 combina la potencia de 7680 núcleos CUDA y 184 núcleos tensoriales, brindando a los usuarios una capacidad de procesamiento encomiable para operaciones complejas. La capacidad de memoria de 12 GB permite el manejo eficiente de grandes conjuntos de datos, lo que permite flujos de trabajo fluidos en tareas de aprendizaje automático. - Bajo consumo de energía:

Operando a solo 200 W, la tarjeta gráfica NVIDIA RTX 4070 exhibe una eficiencia energética excepcional. Su bajo consumo de energía garantiza que los usuarios puedan disfrutar de un potente rendimiento de aprendizaje automático sin ejercer una presión excesiva sobre sus sistemas o incurrir en costos de energía exorbitantes. - Solución rentable:

Con un precio de $599, la tarjeta gráfica NVIDIA RTX 4070 presenta una opción asequible para las personas que buscan explorar y aprender el aprendizaje automático. A pesar de su precio atractivo, la tarjeta no compromete el rendimiento, lo que la convierte en una excelente opción para quienes tienen un presupuesto limitado.

Consideraciones para NVIDIA RTX 4070:

- Capacidad de memoria limitada:

Si bien la capacidad de memoria de 4070 GB de NVIDIA RTX 12 es suficiente para muchas aplicaciones de aprendizaje automático, es importante reconocer que puede presentar limitaciones cuando se trabaja con conjuntos de datos excepcionalmente grandes. Los usuarios deben evaluar sus requisitos específicos y determinar si la capacidad de memoria de 12 GB se alinea con sus necesidades. - Ausencia de compatibilidad con NVIDIA NVLink y SLI:

La tarjeta gráfica NVIDIA RTX 4070 no es compatible con la tecnología NVIDIA NVLink, que permite vincular varias tarjetas en un sistema de procesamiento paralelo. Como resultado, la escalabilidad y el rendimiento pueden verse limitados en configuraciones de varias tarjetas. Los usuarios que consideren tales configuraciones deben explorar opciones alternativas que se adapten a sus requisitos específicos.

Conclusión:

La tarjeta gráfica NVIDIA RTX 4070 surge como una solución eficiente y rentable para las personas que se aventuran en el ámbito del aprendizaje automático. Con su arquitectura Ada Lovelace, capacidad de memoria de 12 GB y una potencia de procesamiento sustancial, ofrece un rendimiento impresionante que permite a los usuarios abordar operaciones complejas de aprendizaje automático. Además, el bajo consumo de energía de la tarjeta de 200 W garantiza un uso eficiente de la energía, mitigando la tensión en los sistemas y reduciendo los costos de energía. Con un precio de $ 599, NVIDIA RTX 4070 ofrece un punto de entrada accesible para las personas que buscan profundizar en el aprendizaje automático sin arruinarse.

NVIDIA GeForce RTX 3090 TI

La NVIDIA GeForce RTX 3090 TI ha llamado la atención como una GPU para juegos que también cuenta con capacidades impresionantes para tareas de aprendizaje profundo. Con su rendimiento máximo de precisión única (FP32) de 13 teraflops, 24 GB de VRAM y 10,752 3090 núcleos CUDA, esta tarjeta gráfica ofrece un rendimiento y una versatilidad excepcionales. En este artículo, exploraremos los beneficios prácticos y las características distintivas de NVIDIA GeForce RTX XNUMX TI, destacando su idoneidad tanto para los entusiastas de los juegos como para los profesionales del aprendizaje profundo.

Ventajas de NVIDIA GeForce RTX 3090 TI:

- Alto rendimiento:

Equipada con la arquitectura Ampere y unos impresionantes 10,752 3090 núcleos CUDA, la NVIDIA GeForce RTX XNUMX TI ofrece un rendimiento excepcional. Esto permite a los usuarios abordar problemas complejos de aprendizaje automático con facilidad, lo que permite cálculos más rápidos y eficientes. - Aceleración del aprendizaje de hardware:

El RTX 3090 TI es compatible con la tecnología Tensor Cores, que facilita las operaciones de redes neuronales aceleradas por hardware. Al aprovechar Tensor Cores, los usuarios pueden experimentar mejoras significativas en la velocidad en el entrenamiento de modelos de aprendizaje profundo. Este avance contribuye a mejorar la productividad y reducir los tiempos de capacitación de los modelos. - Gran capacidad de memoria:

Con 24 GB de memoria GDDR6X, NVIDIA GeForce RTX 3090 TI ofrece un amplio espacio de almacenamiento para manejar grandes cantidades de datos de memoria. Esta capacidad minimiza la necesidad de lecturas y escrituras frecuentes en el disco, lo que da como resultado flujos de trabajo más fluidos y una mayor eficiencia, especialmente cuando se trabaja con grandes conjuntos de datos.

Consideraciones para NVIDIA GeForce RTX 3090 TI:

- El consumo de energía:

La NVIDIA GeForce RTX 3090 TI exige una cantidad sustancial de energía, con una clasificación de consumo de energía de 450 W. Como resultado, es fundamental garantizar una fuente de alimentación sólida para respaldar el funcionamiento de la tarjeta. El alto consumo de energía puede aumentar los costos de energía y limitar la compatibilidad de la tarjeta con ciertos sistemas, particularmente cuando se implementan varias tarjetas en configuraciones informáticas paralelas. - Compatibilidad y soporte:

Si bien NVIDIA GeForce RTX 3090 TI es una tarjeta gráfica poderosa, puede haber consideraciones de compatibilidad y soporte con ciertas plataformas de software y bibliotecas de aprendizaje automático. Los usuarios deben verificar la compatibilidad y estar preparados para realizar los ajustes o actualizaciones necesarios para aprovechar al máximo las capacidades de la tarjeta dentro de sus entornos de software específicos.

Conclusión:

La NVIDIA GeForce RTX 3090 TI se destaca como una impresionante GPU para juegos que también sobresale en aplicaciones de aprendizaje profundo. Con su poderosa arquitectura Ampere, su extenso número de núcleos CUDA y capacidades de aceleración de aprendizaje de hardware, permite a los usuarios abordar tareas complejas de aprendizaje automático de manera eficiente. Además, su gran capacidad de memoria de 24 GB minimiza los cuellos de botella en la transferencia de datos, lo que facilita las operaciones sin problemas incluso con grandes conjuntos de datos.

NVIDIA GeForce RTX 3080 TI

La NVIDIA GeForce RTX 3080 TI se ha convertido en una tarjeta gráfica de rango medio altamente capaz que ofrece un rendimiento impresionante para tareas de aprendizaje automático. Con sus sólidas especificaciones, incluida la arquitectura Ampere, 8704 núcleos CUDA y 12 GB de memoria GDDR6X, esta tarjeta ofrece una potencia de procesamiento sustancial. En este artículo, profundizaremos en los beneficios prácticos y las características distintivas de NVIDIA GeForce RTX 3080 TI, destacando su propuesta de valor para los usuarios que buscan un alto rendimiento sin gastar mucho dinero.

Ventajas de NVIDIA GeForce RTX 3080 TI:

- Potente rendimiento:

Equipada con la arquitectura Ampere y con 8704 núcleos CUDA, NVIDIA GeForce RTX 3080 TI ofrece una potencia de procesamiento excepcional. Esto permite a los usuarios manejar tareas exigentes de aprendizaje automático con facilidad, acelerando los cálculos y reduciendo los tiempos de capacitación. - Aceleración del aprendizaje de hardware:

La inclusión de Tensor Cores en la tarjeta gráfica permite operaciones de red neuronal aceleradas por hardware. Aprovechar Tensor Cores se traduce en una aceleración significativa al realizar tareas de redes neuronales, lo que resulta en un entrenamiento más rápido de modelos de aprendizaje profundo. Este avance mejora la productividad y facilita iteraciones de modelos más rápidas. - Precio relativamente asequible:

Con un precio de $ 1499, NVIDIA GeForce RTX 3080 TI ofrece una opción relativamente asequible para los usuarios que buscan potentes capacidades de aprendizaje automático. Esta tarjeta de gama media proporciona un equilibrio óptimo entre rendimiento y coste, lo que la convierte en una opción atractiva para personas o equipos pequeños que se preocupan por su presupuesto. - Trazado de rayos y compatibilidad con DLSS:

El RTX 3080 TI es compatible con las tecnologías Ray Tracing y Deep Learning Super Sampling (DLSS) aceleradas por hardware. Estas funciones mejoran la calidad visual de los gráficos, lo que permite a los usuarios experimentar entornos más realistas e inmersivos. Las capacidades de Ray Tracing y DLSS son activos valiosos cuando se visualizan los resultados del modelo y se renderizan gráficos de alta calidad.

Consideraciones para NVIDIA GeForce RTX 3080 TI:

- Memoria limitada:

Si bien la RTX 3080 TI ofrece 12 GB de memoria GDDR6X, es importante tener en cuenta que esto puede restringir la capacidad de manejar grandes cantidades de datos o modelos complejos que requieren muchos recursos de memoria. Los usuarios deben evaluar sus requisitos específicos y determinar si la capacidad de memoria disponible se alinea con los casos de uso previstos.

Conclusión:

NVIDIA GeForce RTX 3080 TI se presenta como una potente tarjeta gráfica de gama media que ofrece un rendimiento extraordinario para tareas de aprendizaje automático. Impulsada por la arquitectura Ampere y con 8704 núcleos CUDA, esta tarjeta ofrece una potencia de procesamiento robusta para manejar cálculos exigentes de manera eficiente. Con soporte para aceleración de aprendizaje de hardware a través de Tensor Cores, los usuarios pueden beneficiarse de operaciones de redes neuronales aceleradas y entrenamiento de modelos más rápido.

Envuélvelo

En el ámbito del aprendizaje automático, seleccionar la tarjeta gráfica adecuada es fundamental para maximizar las capacidades de procesamiento de datos y permitir una computación paralela eficiente. Al considerar factores clave como la potencia de cómputo, la capacidad de memoria GPU, el soporte para bibliotecas especializadas, el soporte de alto rendimiento y la compatibilidad con marcos de aprendizaje automático, los profesionales pueden asegurarse de tener el hardware necesario para abordar tareas complejas de aprendizaje automático. Si bien las GPU NVIDIA dominan el panorama del aprendizaje automático, es esencial evaluar los requisitos específicos del proyecto y elegir la tarjeta gráfica que mejor se adapte a esas necesidades. Con la tarjeta gráfica adecuada, los investigadores y profesionales pueden liberar todo el potencial de sus esfuerzos de aprendizaje automático.

NVIDIA: el jugador líder en GPU de aprendizaje automático

Actualmente, NVIDIA se encuentra a la vanguardia de las GPU de aprendizaje automático, proporcionando controladores optimizados y un amplio soporte para CUDA y cuDNN. Las GPU NVIDIA ofrecen una aceleración computacional notable, lo que permite a los investigadores y profesionales agilizar su trabajo de manera significativa.

AMD: Adopción de aprendizaje automático limitada y centrada en los juegos

Aunque las GPU de AMD se han establecido como contendientes formidables en la industria del juego, su adopción para el aprendizaje automático sigue siendo relativamente limitada. Esto se puede atribuir a factores como el soporte de software limitado y la necesidad de actualizaciones frecuentes para satisfacer las demandas de los marcos de aprendizaje automático en evolución.

Preguntas Frecuentes

La selección de la tarjeta gráfica adecuada es crucial, ya que determina la capacidad para manejar el procesamiento intensivo de matriz y tensor requerido para tareas como el entrenamiento profundo de redes neuronales.

Los chips de IA especializados como las TPU (Unidades de procesamiento de tensores) y las FPGA (Matrices de puertas programables en campo) han ganado una popularidad considerable en los últimos tiempos.

Tareas que involucran profundidad red neural El entrenamiento requiere un procesamiento intensivo de matrices y tensores.

Los chips de IA especializados ofrecen un rendimiento y una eficiencia mejorados para tareas relacionadas con la inteligencia artificial, lo que los hace muy deseables para procesar grandes conjuntos de datos y realizar cálculos paralelos.

Elegir la tarjeta gráfica adecuada con suficiente potencia de procesamiento y capacidad de memoria es crucial para lograr un alto rendimiento en tareas de entrenamiento de redes neuronales profundas.

Además de las tarjetas gráficas, los chips de IA especializados, como los TPU y los FPGA, han ganado una popularidad considerable por su eficiencia en el manejo de tareas relacionadas con la IA.

Las TPU y las FPGA han ganado popularidad debido a su capacidad para proporcionar aceleración de hardware especializada para tareas relacionadas con la IA, lo que permite un procesamiento más rápido y eficiente de grandes conjuntos de datos y cálculos complejos.

Los chips de IA especializados como TPU y FPGA a menudo superan a las tarjetas gráficas tradicionales en términos de rendimiento y eficiencia para tareas de IA, ya que están diseñados específicamente para estas cargas de trabajo.

Hay varias tarjetas gráficas que son muy apreciadas para el aprendizaje automático (ML) y la inteligencia artificial (AI) tareas. Estas son algunas de las mejores tarjetas gráficas para ML e IA:

- NVIDIA A100: Basado en la arquitectura Ampere, el A100 es una potencia para tareas de IA y ML. Cuenta con una gran cantidad de núcleos CUDA y es compatible con tecnologías avanzadas de IA.

- NVIDIA GeForce RTX 3090: esta tarjeta gráfica de gama alta ofrece un rendimiento excepcional con su potente GPU, gran capacidad de memoria y soporte para tecnologías de aceleración de IA como Tensor Cores.

- NVIDIA Quadro RTX 8000: esta tarjeta gráfica de nivel profesional está diseñada para aplicaciones exigentes de ML e IA, con su alto poder de cómputo y su amplia capacidad de memoria.

Observación

En línea con la Directrices del Proyecto Confianza, tenga en cuenta que la información proporcionada en esta página no pretende ser ni debe interpretarse como asesoramiento legal, fiscal, de inversión, financiero o de cualquier otro tipo. Es importante invertir sólo lo que pueda permitirse perder y buscar asesoramiento financiero independiente si tiene alguna duda. Para mayor información sugerimos consultar los términos y condiciones así como las páginas de ayuda y soporte proporcionadas por el emisor o anunciante. MetaversePost se compromete a brindar informes precisos e imparciales, pero las condiciones del mercado están sujetas a cambios sin previo aviso.

Sobre el Autor

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.

Más artículos

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.