8 cosas que debe saber sobre los modelos de lenguaje grande

En Resumen

Modelos de lenguaje grande (LLM) se utilizan para explorar los matices del lenguaje natural, mejorar la capacidad de las máquinas para comprender y generar texto y automatizar tareas como el reconocimiento de voz y la traducción automática.

No existe una solución fácil para administrar LLM, pero son tan capaces como los humanos.

Con un aumento en el desarrollo del procesamiento del lenguaje natural y su uso en los negocios, existe un interés creciente en los modelos de lenguaje grandes. Estos modelos se utilizan para explorar los matices del lenguaje natural, mejorar la capacidad de las máquinas para comprender y generar texto y automatizar tareas como el reconocimiento de voz y la traducción automática. Aquí hay ocho cosas esenciales que debe saber sobre los modelos de lenguaje grande (LLM).

- Los LLM son más "capaces" a medida que los costos siguen aumentando

- Una mirada rápida a cómo GPT Los modelos se adaptan a medida que aumentan los costos de capacitación.

- Los LLM aprenden a jugar juegos de mesa usando representaciones del mundo exterior

- No hay una solución fácil para administrar LLM

- Los expertos tienen problemas para explicar cómo funciona el LLM

- Los LLM son tan capaces como los humanos

- Los LLM deben ser algo más que "un experto en todos los oficios"

- Las modelos son 'más inteligentes' de lo que la gente piensa según las primeras impresiones

Los LLM son más "capaces" a medida que los costos siguen aumentando

Como era de esperar, los LLM se vuelven más "capaces" con el aumento de los costos, incluso sin innovaciones geniales. Lo principal aquí es la previsibilidad, que se mostró en el artículo sobre GPT-4: se enseñaron de cinco a siete modelos pequeños con un presupuesto del 0.1% del final, y luego se hizo una predicción para un modelo grande en base a esto. Para una evaluación general de perplejidad y métricas en una submuestra de una tarea específica, tal predicción fue muy precisa. Esta previsibilidad es importante para las empresas y organizaciones que dependen de LLM para sus operaciones, ya que pueden presupuestar en consecuencia y planificar gastos futuros. Sin embargo, es importante tener en cuenta que, si bien el aumento de los costos puede conducir a una mejora de las capacidades, la tasa de mejora puede llegar a estancarse, lo que hace necesario invertir en nuevas innovaciones para seguir avanzando.

Una mirada rápida a cómo GPT Los modelos se adaptan a medida que aumentan los costos de capacitación.

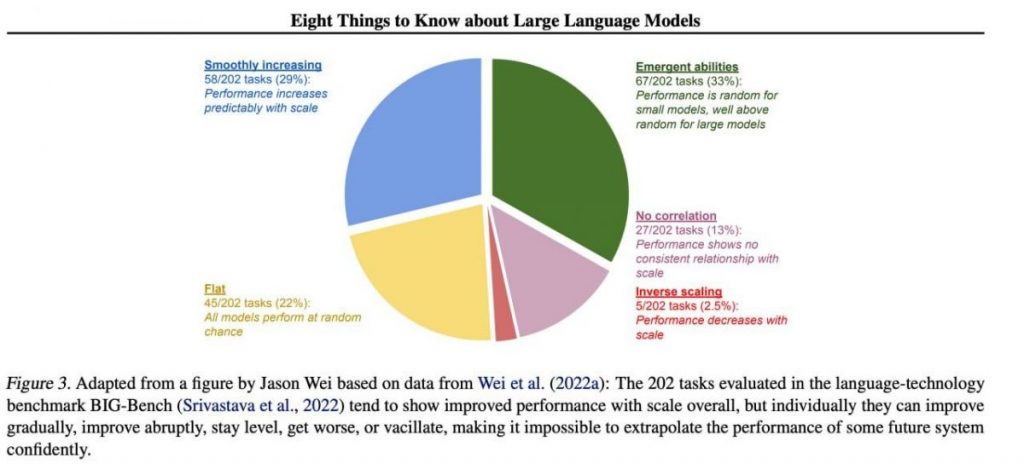

Sin embargo, ciertas habilidades específicas importantes tienden a surgir de manera impredecible como un subproducto del aumento costes de formación (entrenamiento más largo, más datos, modelo más grande): es casi imposible predecir cuándo los modelos comenzarán a realizar ciertas tareas. Exploramos el tema más a fondo en nuestro artículo sobre la historia del desarrollo de GPT modelos. La imagen muestra la distribución del aumento en la calidad de los modelos entre diferentes tareas. Sólo los modelos grandes pueden aprender a realizar diversas tareas. Este gráfico destaca el impacto significativo de ampliar el tamaño de GPT modelos en su desempeño en varias tareas. Sin embargo, es importante tener en cuenta que esto tiene el costo de mayores recursos computacionales e impacto ambiental.

Los LLM aprenden a jugar juegos de mesa usando representaciones del mundo exterior

Los LLM a menudo aprenden y usan representaciones del mundo exterior. Hay muchos ejemplos aquí, y aquí está uno de ellos: Modelos entrenados jugar juegos de mesa basados en descripciones de movimientos individuales, sin siquiera ver una imagen del campo de juego, aprender representaciones internas del estado del tablero en cada movimiento. Estas representaciones internas pueden luego usarse para predecir el futuro movimientos y resultados, lo que permite que el modelo juegue a un alto nivel. Esta capacidad de aprender y utilizar representaciones es clave. aspecto del aprendizaje automático e inteligencia artificial.

No hay una solución fácil para administrar LLM

No existen métodos confiables para controlar el comportamiento de LLM. Aunque ha habido algún progreso en la comprensión y mitigación de varios problemas (incluyendo ChatGPT y GPT-4 con la ayuda de la retroalimentación), no hay consenso sobre si podemos resolverlos. Existe una creciente preocupación de que esto se convierta en un problema enorme y potencialmente catastrófico en el futuro, cuando se creen sistemas aún más grandes. Por lo tanto, los investigadores están explorando nuevos métodos para garantizar que los sistemas de IA se alineen con los valores y objetivos humanos, como la alineación de valores y la ingeniería de recompensas. Sin embargo, sigue siendo una tarea difícil garantizar la seguridad y confiabilidad de los LLM en escenarios complejos del mundo real.

Los expertos tienen problemas para explicar cómo funciona el LLM

Los expertos aún no pueden interpretar el funcionamiento interno del LLM. Ninguna técnica nos permitiría afirmar de manera satisfactoria qué tipo de conocimiento, razonamiento o metas utiliza el modelo cuando genera algún resultado. Esta falta de interpretabilidad plantea preocupaciones sobre la confiabilidad y equidad de las decisiones del LLM, especialmente en aplicaciones de alto riesgo como la justicia penal o la calificación crediticia. También destaca la necesidad de más investigación sobre el desarrollo de modelos de IA más transparentes y responsables.

Los LLM son tan capaces como los humanos

Aunque los LLM están capacitados principalmente para imitar el comportamiento humano al escribir texto, tienen el potencial de superarnos en muchas tareas. Esto ya se puede ver al jugar al ajedrez o al Go. Esto se debe a su capacidad para analizar grandes cantidades de datos y tomar decisiones basadas en ese análisis a una velocidad que los humanos no pueden igualar. Sin embargo, los LLM todavía carecen de la creatividad y la intuición que poseen los humanos, lo que los hace menos aptos para muchas tareas.

Los LLM deben ser algo más que "un experto en todos los oficios"

Los LLM no deben expresar los valores de sus creadores o los valores codificados en una selección de Internet. No deben repetir estereotipos o teorías conspirativas ni buscar ofender a nadie. En cambio, los LLM deben diseñarse para proporcionar información objetiva y objetiva a sus usuarios respetando las diferencias culturales y sociales. Además, deben someterse a pruebas y controles regulares para garantizar que continúan cumpliendo con estos estándares.

Las modelos son 'más inteligentes' de lo que la gente piensa según las primeras impresiones

Las estimaciones de la capacidad de un modelo basadas en las primeras impresiones suelen ser engañosas. Muy a menudo, debe encontrar el mensaje correcto, sugerir un modelo y tal vez mostrar ejemplos, y comenzará a funcionar mucho mejor. Es decir, es “más inteligente” de lo que parece a simple vista. Por lo tanto, es crucial darle al modelo una oportunidad justa y dotarlo de los recursos necesarios para que rinda al máximo. Con el enfoque correcto, incluso los modelos aparentemente inadecuados pueden sorprendernos con sus capacidades.

Si nos centramos en una muestra de 202 tareas del conjunto de datos BIG-Bench (se hizo especialmente difícil probar modelos de lenguaje desde y hacia), entonces, como regla general (en promedio), los modelos muestran un aumento en la calidad al aumentar la escala, pero individualmente, las métricas en las tareas pueden:

- mejorar gradualmente,

- mejorar drásticamente,

- permanece inalterable,

- disminución,

- mostrar ninguna correlación.

Todo esto conduce a la imposibilidad de extrapolar con confianza el desempeño de cualquier sistema futuro. La parte verde es especialmente interesante: aquí es exactamente donde los indicadores de calidad saltan bruscamente sin ningún motivo.

Lea más sobre la IA:

Observación

En línea con la Directrices del Proyecto Confianza, tenga en cuenta que la información proporcionada en esta página no pretende ser ni debe interpretarse como asesoramiento legal, fiscal, de inversión, financiero o de cualquier otro tipo. Es importante invertir sólo lo que pueda permitirse perder y buscar asesoramiento financiero independiente si tiene alguna duda. Para mayor información sugerimos consultar los términos y condiciones así como las páginas de ayuda y soporte proporcionadas por el emisor o anunciante. MetaversePost se compromete a brindar informes precisos e imparciales, pero las condiciones del mercado están sujetas a cambios sin previo aviso.

Sobre el Autor

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.

Más artículos

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.