8 věcí, které byste měli vědět o velkých jazykových modelech

Stručně

Velké jazykové modely (LLM) se používají k prozkoumání nuancí přirozeného jazyka, ke zlepšení schopnosti strojů porozumět a generovat text a k automatizaci úloh, jako je rozpoznávání hlasu a strojový překlad.

Neexistuje jednoduché řešení pro správu LLM, ale jsou stejně schopné jako lidé.

S prudkým rozvojem zpracování přirozeného jazyka a jeho využití v podnikání roste zájem o velké jazykové modely. Tyto modely se používají k prozkoumání nuancí přirozeného jazyka, ke zlepšení schopnosti strojů porozumět a generovat text a k automatizaci úloh, jako je rozpoznávání hlasu a strojový překlad. Zde je osm základních věcí, které byste měli vědět o velkých jazykových modelech (LLM).

- LLM jsou „schopnější“, protože náklady neustále rostou

- Rychlý pohled jak GPT modely se přizpůsobují, jak rostou náklady na školení

- LLM se učí hrát deskové hry pomocí reprezentací vnějšího světa

- Pro správu LLM neexistuje jednoduché řešení

- Odborníci mají problém vysvětlit, jak LLM funguje

- LLM jsou stejně schopné jako lidé

- LLM musí být více než jen „jack-of-all-trades“

- Modelky jsou „chytřejší“, než si lidé myslí na základě prvního dojmu

LLM jsou „schopnější“, protože náklady neustále rostou

LLM se předvídatelně stávají „schopnějšími“ s rostoucími náklady, a to i bez skvělých inovací. Hlavní věc je zde předvídatelnost, což bylo ukázáno v článku o GPT-4: bylo vyučováno pět až sedm malých modelů s rozpočtem 0.1 % konečného modelu a na základě toho byla vytvořena předpověď pro obrovský model. Pro obecné posouzení zmatenosti a metrik na dílčím vzorku jednoho konkrétního úkolu byla taková předpověď velmi přesná. Tato předvídatelnost je důležitá pro podniky a organizace, které při svých operacích spoléhají na LLM, protože mohou podle toho plánovat a plánovat budoucí výdaje. Je však důležité poznamenat, že zatímco rostoucí náklady mohou vést ke zlepšení schopností, míra zlepšování může nakonec stagnovat, takže bude nutné investovat do nových inovací, aby bylo možné pokračovat vpřed.

Rychlý pohled jak GPT modely se přizpůsobují, jak rostou náklady na školení

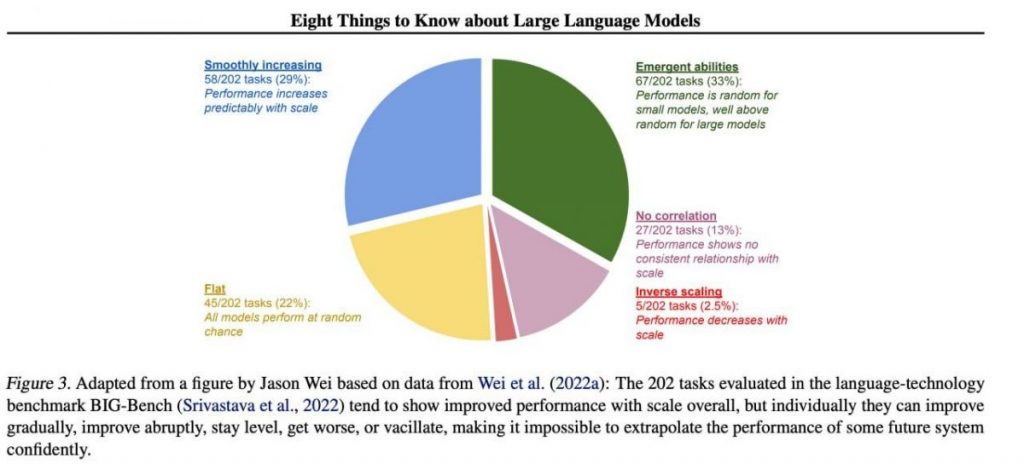

Specifické důležité dovednosti však mají tendenci se nepředvídatelně objevovat jako vedlejší produkt zvyšování náklady na školení (delší trénink, více dat, větší model) — je téměř nemožné předpovědět, kdy modely začnou plnit určité úkoly. V našem článku jsme toto téma prozkoumali hlouběji článek o historii vývoje GPT modely. Obrázek ukazuje rozložení nárůstu kvality modelů napříč různými úkoly. Jsou to jen velké modely, které se mohou naučit dělat různé úkoly. Tento graf zdůrazňuje významný dopad zvětšení velikosti GPT modely na jejich plnění v různých úkolech. Je však důležité poznamenat, že je to za cenu zvýšených výpočetních zdrojů a dopadu na životní prostředí.

LLM se učí hrát deskové hry pomocí reprezentací vnějšího světa

LLM se často učí a používají reprezentace vnějšího světa. Je zde mnoho příkladů a zde je jeden z nich: Modelky vycvičené hrát deskové hry založené na popisech jednotlivých tahů, aniž byste kdy viděli obrázek hracího pole, naučte se vnitřní reprezentace stavu desky při každém tahu. Tyto vnitřní reprezentace pak mohou být použity předpovídat budoucnost pohyby a výsledky, což umožňuje modelu hrát hru na vysoké úrovni. Tato schopnost učit se a používat reprezentace je klíčová aspekt strojového učení a umělá inteligence.

Pro správu LLM neexistuje jednoduché řešení

Neexistují žádné spolehlivé metody kontroly chování LLM. Přestože došlo k určitému pokroku v pochopení a zmírnění různých problémů (včetně ChatGPT a GPT-4 pomocí zpětné vazby), neexistuje shoda na tom, zda je dokážeme vyřešit. Rostou obavy, že se z toho v budoucnu stane obrovský, potenciálně katastrofický problém, až budou vytvořeny ještě větší systémy. Výzkumníci proto zkoumají nové metody, jak zajistit, aby systémy umělé inteligence byly v souladu s lidskými hodnotami a cíli, jako je sladění hodnot a inženýrství odměn. Zůstává však náročným úkolem zajistit bezpečnost a spolehlivost LLM ve složitých scénářích reálného světa.

Odborníci mají problém vysvětlit, jak LLM funguje

Odborníci zatím nemohou interpretovat vnitřní fungování LLM. Žádná technika by nám nedovolila uspokojivým způsobem uvést, jaké druhy znalostí, úvah nebo cílů model používá, když generuje jakýkoli výsledek. Tento nedostatek interpretovatelnosti vyvolává obavy ohledně spolehlivosti a spravedlnosti rozhodnutí LLM, zejména v aplikacích s vysokými sázkami, jako je trestní soudnictví nebo kreditní skóring. Zdůrazňuje také potřebu dalšího výzkumu vývoje transparentnějších a odpovědnějších modelů umělé inteligence.

LLM jsou stejně schopné jako lidé

Přestože LLM jsou vyškoleni především k napodobovat lidské chování při psaní textu, mají potenciál nás v mnoha úkolech předčit. To už je vidět při hraní šachů nebo Go. Je to kvůli jejich schopnosti analyzovat obrovské množství dat a rozhodovat se na základě této analýzy rychlostí, které se lidé nemohou vyrovnat. LLM však stále postrádají kreativitu a intuici, kterou lidé vlastní, což je činí méně vhodnými pro mnoho úkolů.

LLM musí být více než jen „jack-of-all-trades“

LLM nesmí vyjadřovat hodnoty svých tvůrců ani hodnoty zakódované ve výběru z internetu. Neměli by opakovat stereotypy nebo konspirační teorie nebo se snažit někoho urazit. Místo toho by LLM měly být navrženy tak, aby svým uživatelům poskytovaly nezaujaté a faktické informace a zároveň respektovaly kulturní a společenské rozdíly. Kromě toho by měly podstupovat pravidelné testování a monitorování, aby bylo zajištěno, že nadále splňují tyto normy.

Modelky jsou „chytřejší“, než si lidé myslí na základě prvního dojmu

Odhady schopností modelky na základě prvního dojmu jsou často zavádějící. Velmi často je potřeba vymyslet správnou výzvu, navrhnout model a třeba ukázat příklady, a ono to začne zvládat mnohem lépe. To znamená, že je „chytřejší“, než se na první pohled zdá. Proto je klíčové dát modelu spravedlivou šanci a poskytnout mu potřebné zdroje, aby fungoval co nejlépe. Při správném přístupu nás mohou překvapit svými schopnostmi i zdánlivě nedostačující modely.

Pokud se zaměříme na vzorek 202 úloh z datové sady BIG-Bench (bylo speciálně ztíženo testování jazykové modely od a do), pak zpravidla (v průměru) modely vykazují nárůst kvality s rostoucím měřítkem, ale jednotlivě mohou metriky v úkolech:

- postupně zlepšovat,

- výrazně zlepšit,

- zůstat beze změny,

- pokles,

- nevykazují žádnou korelaci.

To vše vede k nemožnosti sebevědomě extrapolovat výkon jakéhokoli budoucího systému. Zajímavá je především zelená část — přesně zde ukazatele kvality bezdůvodně prudce vyskočí.

Přečtěte si více o AI:

Odmítnutí odpovědnosti

V souladu s Pokyny k projektu Trust, prosím vezměte na vědomí, že informace uvedené na této stránce nejsou určeny a neměly by být vykládány jako právní, daňové, investiční, finanční nebo jakékoli jiné formy poradenství. Je důležité investovat jen to, co si můžete dovolit ztratit, a v případě pochybností vyhledat nezávislé finanční poradenství. Pro další informace doporučujeme nahlédnout do smluvních podmínek a také na stránky nápovědy a podpory poskytnuté vydavatelem nebo inzerentem. MetaversePost se zavázala poskytovat přesné a nezaujaté zprávy, ale podmínky na trhu se mohou bez upozornění změnit.

O autorovi

Damir je vedoucí týmu, produktový manažer a editor ve společnosti Metaverse Post, pokrývající témata jako AI/ML, AGI, LLM, Metaverse a Web3- související obory. Jeho články přitahují každý měsíc masivní publikum čítající více než milion uživatelů. Jeví se jako odborník s 10 lety zkušeností v oblasti SEO a digitálního marketingu. Damir byl zmíněn v Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto a další publikace. Jako digitální nomád cestuje mezi SAE, Tureckem, Ruskem a SNS. Damir získal bakalářský titul z fyziky, o kterém se domnívá, že mu dal dovednosti kritického myšlení potřebné k úspěchu v neustále se měnícím prostředí internetu.

Další články

Damir je vedoucí týmu, produktový manažer a editor ve společnosti Metaverse Post, pokrývající témata jako AI/ML, AGI, LLM, Metaverse a Web3- související obory. Jeho články přitahují každý měsíc masivní publikum čítající více než milion uživatelů. Jeví se jako odborník s 10 lety zkušeností v oblasti SEO a digitálního marketingu. Damir byl zmíněn v Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto a další publikace. Jako digitální nomád cestuje mezi SAE, Tureckem, Ruskem a SNS. Damir získal bakalářský titul z fyziky, o kterém se domnívá, že mu dal dovednosti kritického myšlení potřebné k úspěchu v neustále se měnícím prostředí internetu.