8 неща, които трябва да знаете за големите езикови модели

Накратко

Големи езикови модели (LLM) се използват за изследване на нюансите на естествения език, подобряване на способността на машините да разбират и генерират текст и автоматизиране на задачи като разпознаване на глас и машинен превод.

Няма лесно решение за управление на LLM, но те са също толкова способни, колкото и хората.

С нарастването на развитието на обработката на естествен език и използването му в бизнеса, има нарастващ интерес към големите езикови модели. Тези модели се използват за изследване на нюансите на естествения език, подобряване на способността на машините да разбират и генерират текст и автоматизиране на задачи като гласово разпознаване и машинен превод. Ето осем основни неща, които трябва да знаете за големите езикови модели (LLM).

- LLM са по-„способни“, тъй като разходите продължават да растат

- Бърз поглед как GPT моделите се адаптират с нарастването на разходите за обучение

- LLMs се научават да играят настолни игри, като използват представяния на външния свят

- Няма лесно решение за управление на LLM

- Експертите имат проблеми да обяснят как работи LLM

- LLM са също толкова способни, колкото и хората

- LLM трябва да бъде нещо повече от просто „майстор на всички сделки“

- Моделите са „по-умни“, отколкото хората си мислят въз основа на първо впечатление

LLM са по-„способни“, тъй като разходите продължават да растат

LLM предвидимо стават по-„способни“ с нарастващи разходи, дори без страхотни иновации. Основното тук е предвидимостта, която беше показана в статията за GPT-4: пет до седем малки модела бяха обучени с бюджет от 0.1% от крайния и след това въз основа на това беше направена прогноза за огромен модел. За обща оценка на объркването и показателите на подизвадка от една конкретна задача, такава прогноза беше много точна. Тази предсказуемост е важна за предприятията и организациите, които разчитат на LLM за своите операции, тъй като те могат да бюджетират съответно и да планират бъдещи разходи. Въпреки това е важно да се отбележи, че докато увеличаването на разходите може да доведе до подобрени възможности, скоростта на подобрение може в крайна сметка да достигне плато, което налага инвестирането в нови иновации, за да продължи напредъка.

Бърз поглед как GPT моделите се адаптират с нарастването на разходите за обучение

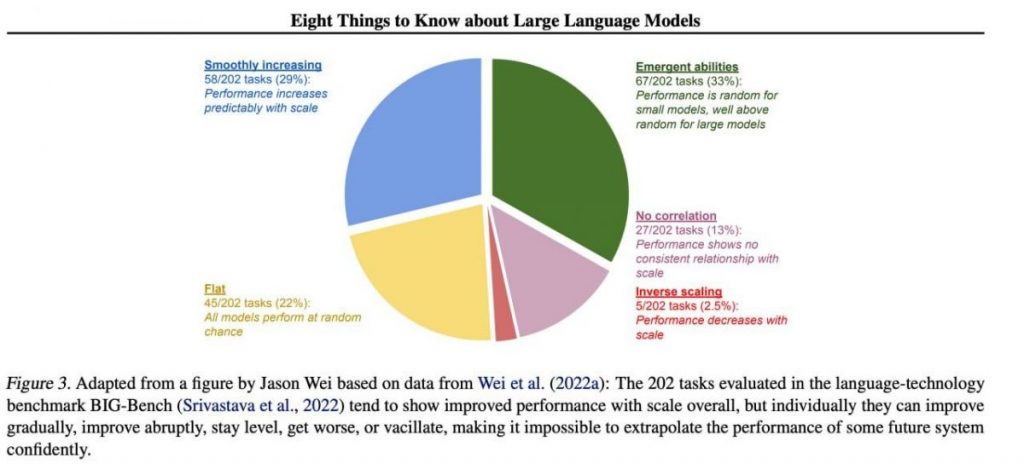

Въпреки това специфични важни умения са склонни да се появяват непредсказуемо като страничен продукт от нарастването разходи за обучение (по-дълго обучение, повече данни, по-голям модел) — почти невъзможно е да се предвиди кога моделите ще започнат да изпълняват определени задачи. Разгледахме темата по-задълбочено в нашия статията за историята на развитието на GPT модели. Картината показва разпределението на повишаването на качеството на моделите в различните задачи. Само големите модели могат да се научат да изпълняват различни задачи. Тази графика подчертава значителното въздействие от увеличаването на размера на GPT модели върху тяхното представяне при различни задачи. Важно е обаче да се отбележи, че това става с цената на увеличени изчислителни ресурси и въздействие върху околната среда.

LLMs се научават да играят настолни игри, като използват представяния на външния свят

LLM често учат и използват представяния на външния свят. Тук има много примери и ето един от тях: Обучени модели да играете настолни игри въз основа на описания на отделни ходове, без изобщо да виждате картина на игралното поле, научете вътрешни представяния на състоянието на дъската при всеки ход. След това тези вътрешни представяния могат да се използват за предсказват бъдеще ходове и резултати, което позволява на модела да играе играта на високо ниво. Тази способност за научаване и използване на представяния е ключова аспект на машинното обучение и изкуствен интелект.

Няма лесно решение за управление на LLM

Няма надеждни методи за контрол на поведението на LLM. Въпреки че има известен напредък в разбирането и смекчаването на различни проблеми (включително ChatGPT намлява GPT-4 с помощта на обратна връзка), няма консенсус дали можем да ги разрешим. Има нарастваща загриженост, че това ще се превърне в огромен, потенциално катастрофален проблем в бъдеще, когато бъдат създадени още по-големи системи. Ето защо изследователите проучват нови методи, за да гарантират, че AI системите се привеждат в съответствие с човешките ценности и цели, като привеждане в съответствие на стойността и инженерство за възнаграждение. Въпреки това остава предизвикателна задача да се гарантира безопасност и надеждност на LLM в сложни сценарии от реалния свят.

Експертите имат проблеми да обяснят как работи LLM

Експертите все още не могат да интерпретират вътрешната работа на LLM. Никоя техника не би ни позволила да посочим по задоволителен начин какви видове знания, разсъждения или цели използва моделът, когато генерира някакъв резултат. Тази липса на тълкуемост поражда опасения относно надеждността и справедливостта на решенията на LLM, особено при приложения с високи залози като наказателно правосъдие или кредитен рейтинг. Той също така подчертава необходимостта от по-нататъшни изследвания за разработване на по-прозрачни и отговорни модели на ИИ.

LLM са също толкова способни, колкото и хората

Въпреки че LLM се обучават предимно за имитират човешко поведение при писане на текст, те имат потенциала да ни надминат в много задачи. Това вече може да се види, когато играете шах или Го. Това се дължи на способността им да анализират огромни количества данни и да вземат решения въз основа на този анализ със скорост, която хората не могат да достигнат. Въпреки това, LLM все още нямат креативността и интуицията, които хората притежават, което ги прави по-малко подходящи за много задачи.

LLM трябва да бъде нещо повече от просто „майстор на всички сделки“

LLM не трябва да изразяват ценностите на своите създатели или ценностите, кодирани в селекция от Интернет. Те не трябва да повтарят стереотипи или теории на конспирацията или да се опитват да обидят някого. Вместо това, LLMs трябва да бъдат проектирани да предоставят безпристрастна и фактическа информация на своите потребители, като същевременно зачитат културните и обществени различия. Освен това те трябва да се подлагат на редовно тестване и наблюдение, за да се гарантира, че продължават да отговарят на тези стандарти.

Моделите са „по-умни“, отколкото хората си мислят въз основа на първо впечатление

Оценките за способностите на модела въз основа на първите впечатления често са подвеждащи. Много често трябва да излезете с правилната подкана, да предложите модел и може би да покажете примери, и той ще започне да се справя много по-добре. Тоест, той е „по-умен“, отколкото изглежда на пръв поглед. Ето защо е изключително важно да се даде справедлив шанс на модела и да му се осигурят необходимите ресурси, за да се представи по най-добрия начин. С правилен подход дори и на пръв поглед неадекватни модели могат да ни изненадат с възможностите си.

Ако се съсредоточим върху извадка от 202 задачи от набора от данни на BIG-Bench (беше специално направен труден за тестване езикови модели от и до), тогава като правило (средно) моделите показват повишаване на качеството с увеличаване на мащаба, но поотделно показателите в задачите могат:

- подобрявайте се постепенно,

- подобрява драстично,

- остават непроменени,

- намаляване,

- не показват корелация.

Всичко това води до невъзможност за уверено екстраполиране на производителността на която и да е бъдеща система. Зелената част е особено интересна — точно там показателите за качество скачат рязко нагоре без никаква причина.

Прочетете повече за AI:

Отказ от отговорност

В съответствие с Доверете се насоките на проекта, моля, имайте предвид, че предоставената на тази страница информация не е предназначена да бъде и не трябва да се тълкува като правен, данъчен, инвестиционен, финансов или каквато и да е друга форма на съвет. Важно е да инвестирате само това, което можете да си позволите да загубите, и да потърсите независим финансов съвет, ако имате някакви съмнения. За допълнителна информация предлагаме да се обърнете към правилата и условията, както и към страниците за помощ и поддръжка, предоставени от издателя или рекламодателя. MetaversePost се ангажира с точно, безпристрастно отчитане, но пазарните условия подлежат на промяна без предизвестие.

За автора

Дамир е ръководител на екип, продуктов мениджър и редактор в Metaverse Post, обхващащи теми като AI/ML, AGI, LLMs, Metaverse и Web3- свързани полета. Статиите му привличат огромна аудитория от над милион потребители всеки месец. Изглежда, че е експерт с 10 години опит в SEO и дигитален маркетинг. Дамир е споменат в Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto и други публикации. Той пътува между ОАЕ, Турция, Русия и ОНД като дигитален номад. Дамир получава бакалавърска степен по физика, която според него му е дала уменията за критично мислене, необходими за успех в непрекъснато променящия се пейзаж на интернет.

Още статии

Дамир е ръководител на екип, продуктов мениджър и редактор в Metaverse Post, обхващащи теми като AI/ML, AGI, LLMs, Metaverse и Web3- свързани полета. Статиите му привличат огромна аудитория от над милион потребители всеки месец. Изглежда, че е експерт с 10 години опит в SEO и дигитален маркетинг. Дамир е споменат в Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto и други публикации. Той пътува между ОАЕ, Турция, Русия и ОНД като дигитален номад. Дамир получава бакалавърска степен по физика, която според него му е дала уменията за критично мислене, необходими за успех в непрекъснато променящия се пейзаж на интернет.