Stability AI, Stable Diffusion 2 El algoritmo finalmente es público: nuevo modelo depth2img, escalador de súper resolución, sin contenido para adultos

En Resumen

Stable Diffusion El modelo 2.0 es más rápido, de código abierto, escalable y más robusto que el anterior

Stable Diffusion se prepara para la GPU con nuevas características para el renderizado en tiempo real

guiado en profundidad stable diffusion modelo – Imagen a imagen con nuevas ideas para aplicaciones creativas

Stability AI tiene liberado un nuevo artículo en su blog sobre Stable Diffusion 2. En ella, Stability AI propone un nuevo algoritmo que es más eficiente y robusto que el anterior y lo compara con otros métodos de última generación.

Original de CompVis Stable Diffusion Modelo V1 revolucionado la naturaleza del código abierto Modelos AI y produjo cientos de modelos y avances diferentes en todo el mundo. Obtuvo uno de los ascensos más rápidos a 10,000 33,000 estrellas de Github, acumulando XNUMX XNUMX en menos de dos meses, más rápido que otros programas en Github.

El original Stable Diffusion El lanzamiento de V1 fue dirigido por el dinámico equipo de Robin Rombach (Stability AI) y Patrick Esser (Runway ML) del Grupo CompVis en LMU Munich, dirigido por el Prof. Dr. Björn Ommer. Se basaron en el trabajo anterior del laboratorio con Latent Modelos de difusión y recibió apoyo crítico de LAION y Eleuther AI.

¿Qué te hace Stable Diffusion v1 diferente de Stable Diffusion v2?

Stable Diffusion 2.0 incluye una serie de mejoras y características significativas con respecto a la versión anterior, así que echemos un vistazo a ellas.

El Stable Diffusion La versión 2.0 presenta modelos robustos de texto a imagen entrenados con un codificador de texto nuevo y fresco (OpenCLIP) desarrollado por LAION con la ayuda de Stability AI, lo que mejora significativamente la calidad de la imagenes generadas sobre versiones anteriores de V1. Los modelos de texto a imagen de esta versión pueden generar imágenes con resoluciones predeterminadas de 512 × 512 píxeles y 768 × 768 píxeles.

Estos modelos se entrenan utilizando un subconjunto estético del conjunto de datos LAION-5B generado por Stability AIEl equipo de DeepFloyd, que luego se filtra para excluir contenido para adultos usando el filtro NSFW de LAION.

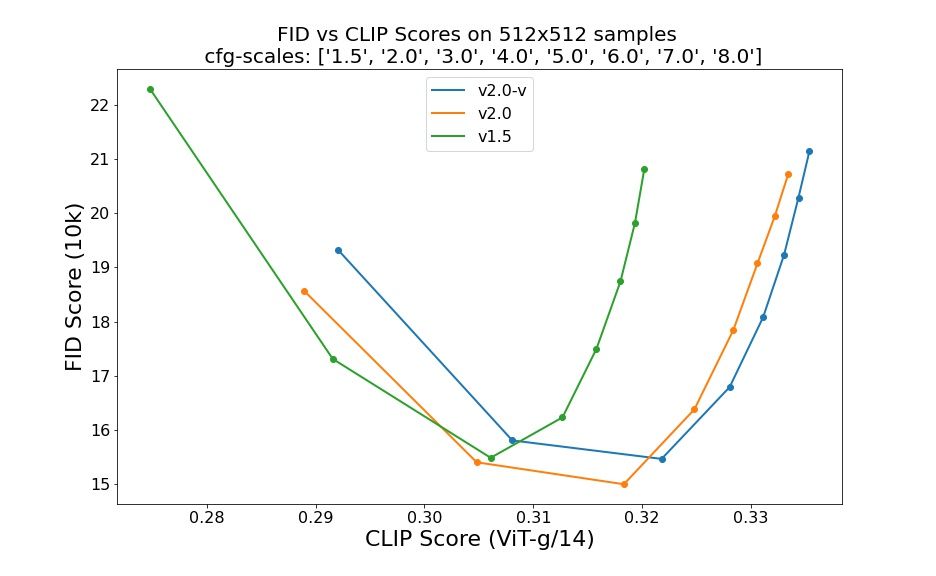

Las evaluaciones que utilizan 50 pasos de muestra de DDIM, 50 escalas guía sin clasificador y 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 y 8.0 indican mejoras relativas de los puntos de control:

Stable Diffusion 2.0 ahora incorpora un modelo Upscaler Diffusion, que aumenta la resolución de la imagen en un factor de cuatro. Un ejemplo de nuestro modelo. ampliación de la escala A continuación se muestra una imagen generada de baja calidad (128 × 128) en una imagen de mayor resolución (512 × 512). Stable Diffusion 2.0, cuando se combina con nuestros modelos de texto a imagen, ahora puede generar imágenes con resoluciones de 2048 × 2048 o superiores.

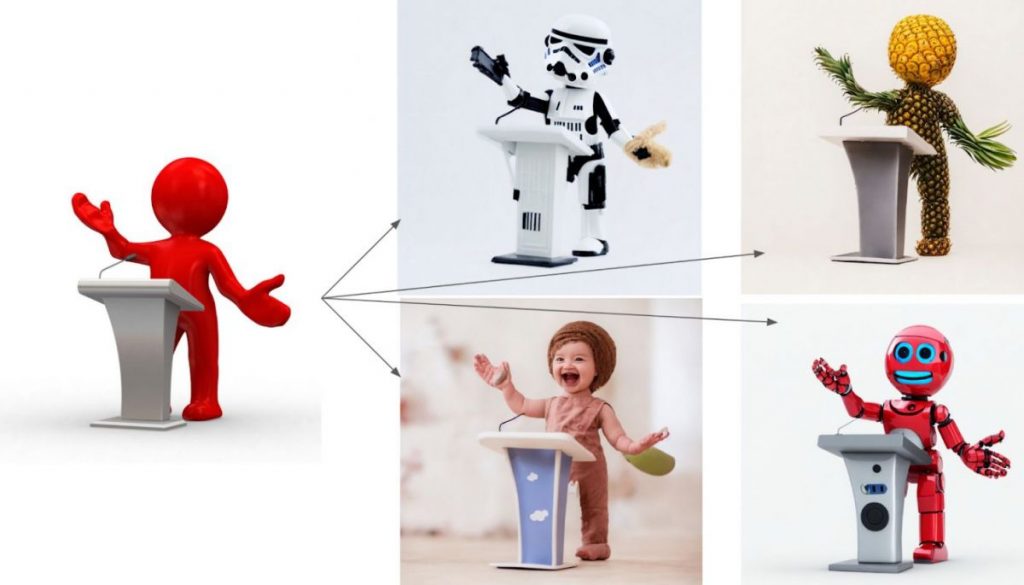

La nueva guía de profundidad stable diffusion modelo, depth2img, amplía la característica anterior de imagen a imagen de V1 con posibilidades creativas completamente nuevas. Depth2img determina la profundidad de una imagen de entrada (usando un modelo existente) y luego genera una nueva imágenes basado tanto en el texto como en la información de profundidad. Depth-to-Image puede proporcionar una plétora de nuevas aplicaciones creativas, ofreciendo cambios que parecen significativamente diferentes del original mientras conservan la coherencia y la profundidad de la imagen.

¿Qué hay de nuevo en Stable Diffusion 2?

- El nuevo stable diffusion modelo ofrece una resolución de 768×768.

- U-Net tiene la misma cantidad de parámetros que la versión 1.5, pero está entrenado desde cero y usa OpenCLIP-ViT/H como codificador de texto. El llamado modelo de predicción v es SD 2.0-v.

- El modelo antes mencionado se ajustó a partir de la base SD 2.0, que también está disponible y se entrenó como un modelo típico de predicción de ruido en imágenes de 512 × 512.

- Se ha agregado un modelo de difusión guiada por texto latente con escala x4.

- Guía de profundidad base SD 2.0 refinada stable diffusion modelo. El modelo se puede utilizar para img2img que preserva la estructura y síntesis condicional de forma y está condicionado a estimaciones de profundidad monocular deducidas por MiDaS.

- Un modelo mejorado de pintura guiada por texto construido sobre la base SD 2.0.

Los desarrolladores trabajaron duro, al igual que la iteración inicial de Stable Diffusion, para optimizar el modelo para que se ejecutara en una sola GPU: querían que fuera accesible para la mayor cantidad de personas posible desde el principio. Ya han visto lo que sucede cuando millones de personas tienen en sus manos estos modelos y colaboran para construir cosas absolutamente notables. Este es el poder del código abierto: aprovechar el gran potencial de millones de personas talentosas que pueden no tener los recursos para entrenar un modelo de vanguardia pero tienen la capacidad de hacer cosas increíbles con uno.

Esta nueva actualización, combinada con potentes funciones nuevas como depth2img y mejores capacidades de escalado de resolución, servirá como base para una plétora de nuevas aplicaciones y permitirá una explosión de nuevo potencial creativo.

Lea más sobre Stable Diffusion:

Observación

En línea con la Directrices del Proyecto Confianza, tenga en cuenta que la información proporcionada en esta página no pretende ser ni debe interpretarse como asesoramiento legal, fiscal, de inversión, financiero o de cualquier otro tipo. Es importante invertir sólo lo que pueda permitirse perder y buscar asesoramiento financiero independiente si tiene alguna duda. Para mayor información sugerimos consultar los términos y condiciones así como las páginas de ayuda y soporte proporcionadas por el emisor o anunciante. MetaversePost se compromete a brindar informes precisos e imparciales, pero las condiciones del mercado están sujetas a cambios sin previo aviso.

Sobre el Autor

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.

Más artículos

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.