Sber AI ha presentado Kandinsky 2.0, el primer modelo de texto a imagen para generar en más de 100 idiomas

En Resumen

Kandinsky 2.0, el primer modelo de difusión multilingüe, fue creado y entrenado por investigadores de Sber AI con la ayuda de investigadores del Instituto de Inteligencia Artificial de AI utilizando el conjunto de datos combinado de mil millones de pares de texto e imágenes de Sber AI y SberDevices.

La difusión está reemplazando cada vez más a las GAN y los modelos autorregresivos en una serie de tareas de procesamiento de imágenes digitales. Esto no es sorprendente porque la difusión es más fácil de aprender, no requiere una selección compleja de hiperparámetros, optimización min-max y no sufre de inestabilidad de aprendizaje. Y lo que es más importante, los modelos de difusión demuestran resultados de vanguardia en casi todas las tareas generativas: generación de imágenes por texto, generación de sonido, video e incluso 3D.

Desafortunadamente, la mayor parte del trabajo en el campo de texto a algo se enfoca solo en inglés y chino. Para corregir esta injusticia, Sber AI decidió crear un modelo de difusión de texto a imagen multilingüe Kandinsky 2.0, que comprende consultas en más de 100 idiomas. AbrazandoCara ya ofrece Kandinsky 2.0. Investigadores de SberAI y SberDevices han colaborado con expertos del Instituto AI de Inteligencia Artificial en este proyecto.

¿Qué es la difusión?

En el artículo de 2015 Aprendizaje profundo no supervisado usando termodinámica sin equilibrio, los modelos de difusión se describieron por primera vez como el acto de mezclar una sustancia que da como resultado la difusión, lo que iguala la distribución. Como implica el título del artículo, abordaron la explicación de los modelos de difusión a través del marco de la termodinámica.

En el caso de las imágenes, dicho proceso podría parecerse, por ejemplo, a la eliminación gradual del ruido gaussiano de la imagen.

Los modelos de difusión en papel borracho GANs on Image Synthesis, publicado en 2021, fue el primero en mostrar la superioridad de los modelos de difusión sobre GANS. Los autores también idearon el enfoque de control de primera generación (condicionamiento), al que llamaron guía del clasificador. Este método crea objetos que se ajustan a la clase deseada usando gradientes de un clasificador diferente (por ejemplo, perros). A través del mecanismo de Norma de Grupo Adaptativo, que implica la previsión de coeficientes de normalización, se realiza el control propiamente dicho.

Este artículo puede verse como un punto de inflexión en el campo de la IA generativa, lo que lleva a muchos a dedicarse al estudio de la difusión. Nuevos artículos sobre texto a video, texto a 3D, imagen pintura, generación de audio, difusión para súper resolución, e incluso la generación de movimiento comenzó a aparecer cada pocas semanas.

Difusión de texto a imagen

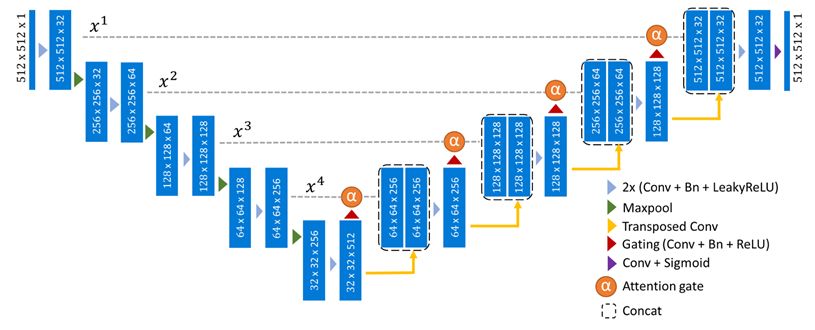

Como mencionamos anteriormente, la reducción y la eliminación de ruido suelen ser los componentes principales de los procesos de difusión en el contexto de las modalidades de imagen, por lo que UNet y sus muchas variaciones se utilizan con frecuencia como arquitectura fundamental.

Es fundamental que este texto sea tomado en consideración de alguna manera durante la generación para poder crear una imagen a partir de él. Los autores de la OpenAI El artículo sobre el modelo GLIDE sugirió modificar el enfoque de orientación sin clasificador para el texto.

El empleo de codificadores de texto preirradiados congelados y el mecanismo de mejora de la resolución en cascada en el futuro mejoró considerablemente la producción de texto (Imagen). Resultó que no había necesidad de entrenar la parte de texto de modelos de texto a imagen ya que el uso del T5-xxl congelado dio como resultado una calidad de imagen y una comprensión del texto considerablemente mejoradas y utilizó muchos menos recursos de capacitación.

Los autores de un Difusión latente El artículo demostró que el componente de imagen en realidad no requiere capacitación (al menos no completamente). El aprendizaje procederá aún más rápido si usamos un potente autocodificador de imágenes (VQ-VAE o KL-VAE) como decodificador visual e intentamos generar incrustaciones a partir de su espacio latente por difusión en lugar de la imagen misma. Esta metodología es también la base de la recientemente lanzada Stable Diffusion modelo.

Modelo de IA de Kandinsky 2.0

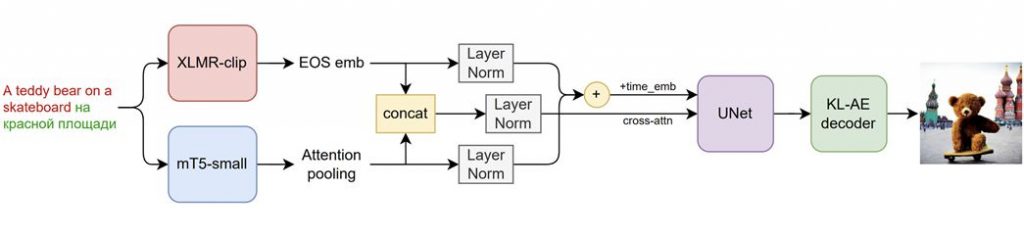

Con algunas mejoras clave, Kandinsky 2.0 se basa en una técnica de difusión latente mejorada (no creamos imágenes, sino sus vectores latentes):

- Empleó dos codificadores de texto multilingües y concatenó sus incrustaciones.

- Añadido UNet (1.2 millones de parámetros).

- Umbralización dinámica del procedimiento de muestreo.

Los investigadores emplearon dos codificadores multilingües simultáneamente, XLMR-clip y mT5-small, para hacer el modelo realmente multilingüe. Por lo tanto, además de inglés, ruso, francés y alemán, el modelo también puede comprender idiomas como mongol, hebreo y farsi. La IA sabe un total de 101 idiomas. ¿Por qué se decidió codificar texto usando dos modelos simultáneamente? Dado que XLMR-clip ha visto imágenes y proporciona incrustaciones cercanas para varios idiomas, y mT5-small es capaz de comprender textos complejos, estos modelos tienen características diferentes pero cruciales. Dado que ambos modelos solo tienen una pequeña cantidad de parámetros (560M y 146M), como lo demuestran nuestras pruebas preliminares, se decidió usar dos codificadores simultáneamente.

Imágenes recién generadas por el modelo Kandinsky 2.0 AI a continuación:

¿Cómo se hizo el entrenamiento del modelo Kandinsky 2.0?

Las supercomputadoras Christofari se utilizaron para la capacitación en la plataforma ML Space. Requería 196 tarjetas NVIDIA A100, cada una con 80 GB de RAM. Se necesitaron 14 días, o 65,856 256 horas de GPU, para completar la capacitación. El análisis tomó cinco días con una resolución de 256 × 512, seguido de seis días con una resolución de 512 × XNUMX, luego tres días adicionales con los datos más puros.

Como datos de entrenamiento, se combinaron muchos conjuntos de datos que se habían filtrado previamente para marcas de agua, baja resolución y baja adherencia a la descripción del texto según lo medido por la métrica CLIP-score.

Generación multilingüe

Kandinsky 2.0 es el primer modelo multilingüe para crear imágenes a partir de palabras, lo que nos brinda la primera oportunidad de evaluar los cambios lingüísticos y visuales en las culturas lingüísticas. Los resultados de traducir la misma consulta a varios idiomas se muestran a continuación. Por ejemplo, solo aparecen hombres blancos en los resultados de generación de la consulta rusa "una persona con educación superior", mientras que los resultados de la traducción francesa, "Photo d'une personne diplômée de l'enseignement supérieur", son más diversificados. Me gustaría señalar que las personas afligidas con educación superior solo están presentes en la edición en ruso.

Aunque todavía hay un montón de pruebas con modelos de lenguaje enormes y diferentes métodos del proceso de difusión planificados, ¡ya podemos afirmar con confianza que Kandinsky 2.0 es el primer modelo de difusión totalmente multilingüe! Sobre el Sitio web de FusionBrain y Colaboración de Google, puedes ver ejemplos de sus dibujos.

Lea más sobre la IA:

Observación

En línea con la Directrices del Proyecto Confianza, tenga en cuenta que la información proporcionada en esta página no pretende ser ni debe interpretarse como asesoramiento legal, fiscal, de inversión, financiero o de cualquier otro tipo. Es importante invertir sólo lo que pueda permitirse perder y buscar asesoramiento financiero independiente si tiene alguna duda. Para mayor información sugerimos consultar los términos y condiciones así como las páginas de ayuda y soporte proporcionadas por el emisor o anunciante. MetaversePost se compromete a brindar informes precisos e imparciales, pero las condiciones del mercado están sujetas a cambios sin previo aviso.

Sobre el Autor

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.

Más artículos

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.