Google presenta una innovadora dinámica de imágenes generativas que simula escenas dinámicas en imágenes estáticas

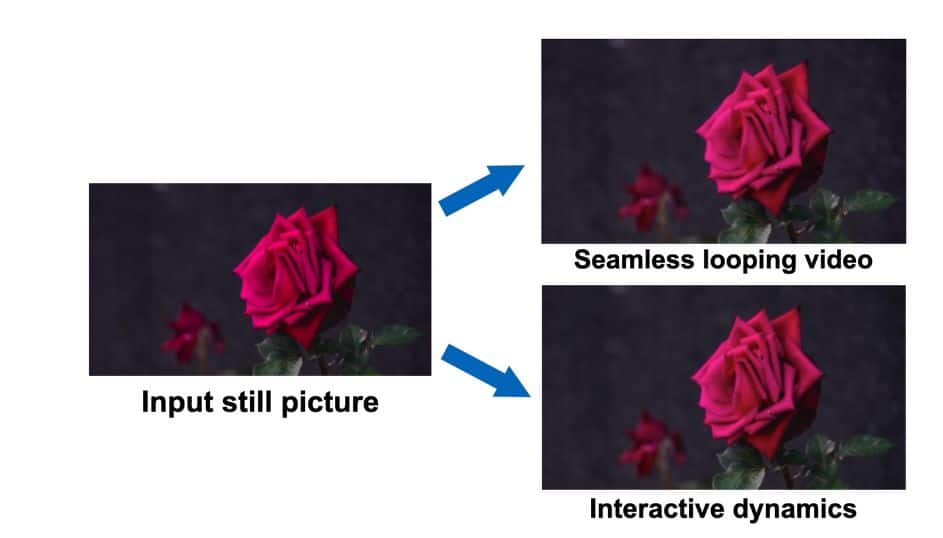

Google ha presentado un Dinámica de imagen generativa, un enfoque novedoso permite la transformación de una una sola imagen estática en un vídeo en bucle sin interrupciones o una escena dinámica interactiva, que ofrece una amplia gama de aplicaciones prácticas.

El núcleo de esta tecnología pionera es el modelado de un espacio de imagen previo a la dinámica de la escena. El objetivo es crear una comprensión integral de cómo los objetos y elementos dentro de una imagen pueden comportarse cuando se los somete a diversas interacciones dinámicas. Esta comprensión se puede utilizar para simular eficazmente la respuesta de la dinámica de objetos a las interacciones del usuario.

La característica clave de esta tecnología es la capacidad de generar vídeos en bucle sin interrupciones. Al aprovechar el espacio de la imagen antes de la dinámica de la escena, el sistema de Google puede extrapolar y extender el movimiento de los elementos dentro de una imagen, transformándola en un bucle de video continuo y cautivador. Esta funcionalidad abre numerosas posibilidades creativas para los creadores y diseñadores de contenido.

La tecnología permite a los usuarios interactuar con objetos dentro de imágenes estáticas de manera realista. Al simular la respuesta de la dinámica de los objetos a la excitación del usuario, el sistema de Google permite experiencias inmersivas e interactivas dentro de imágenes. Esto tiene el potencial de revolucionar espacios metaversos y cómo los usuarios interactúan con el contenido visual.

La base de esta innovación reside en un modelo meticulosamente entrenado. El modelo de Google aprende de un vasto conjunto de datos de trayectorias de movimiento extraídas de secuencias de video reales que presentan movimiento oscilante natural. Estas secuencias incluyen escenas con elementos como árboles balanceándose, flores moviéndose, velas parpadeando y ropa ondeando con el viento. Este conjunto de datos diverso permite que el modelo comprenda una amplia gama de comportamientos dinámicos.

Cuando se le presenta un Imagen única, el modelo entrenado emplea un proceso de muestreo de difusión coordinado en frecuencia. Este proceso predice una representación de movimiento a largo plazo por píxel en el dominio de Fourier, denominada textura de movimiento estocástico neuronal. Esta representación luego se transforma en densas trayectorias de movimiento que abarcan todo un vídeo. Junto con un módulo de renderizado basado en imágenes, estas trayectorias se pueden aprovechar para diversas aplicaciones prácticas.

En comparación con los anteriores sobre píxeles RGB sin procesar, los anteriores sobre el movimiento capturan una estructura subdimensional más fundamental y de dimensiones inferiores que explica de manera eficiente las variaciones en los valores de los píxeles. Esto conduce a una generación más coherente a largo plazo y a un control más detallado sobre las animaciones en comparación con los métodos anteriores que realizaban animación de imagen a través de síntesis de vídeo sin procesar.

La representación del movimiento generado es conveniente para una serie de aplicaciones posteriores, como la creación de videos en bucle continuo, la edición del movimiento generado y la habilitación interactiva. imagenes dinámicas, simulando la respuesta de la dinámica del objeto a las fuerzas aplicadas por el usuario.

Leer más temas relacionados:

Observación

En línea con la Directrices del Proyecto Confianza, tenga en cuenta que la información proporcionada en esta página no pretende ser ni debe interpretarse como asesoramiento legal, fiscal, de inversión, financiero o de cualquier otro tipo. Es importante invertir sólo lo que pueda permitirse perder y buscar asesoramiento financiero independiente si tiene alguna duda. Para mayor información sugerimos consultar los términos y condiciones así como las páginas de ayuda y soporte proporcionadas por el emisor o anunciante. MetaversePost se compromete a brindar informes precisos e imparciales, pero las condiciones del mercado están sujetas a cambios sin previo aviso.

Sobre el Autor

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.

Más artículos

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.