Text-zu-Video-KI-Modell

Was ist ein Text-zu-Video-KI-Modell?

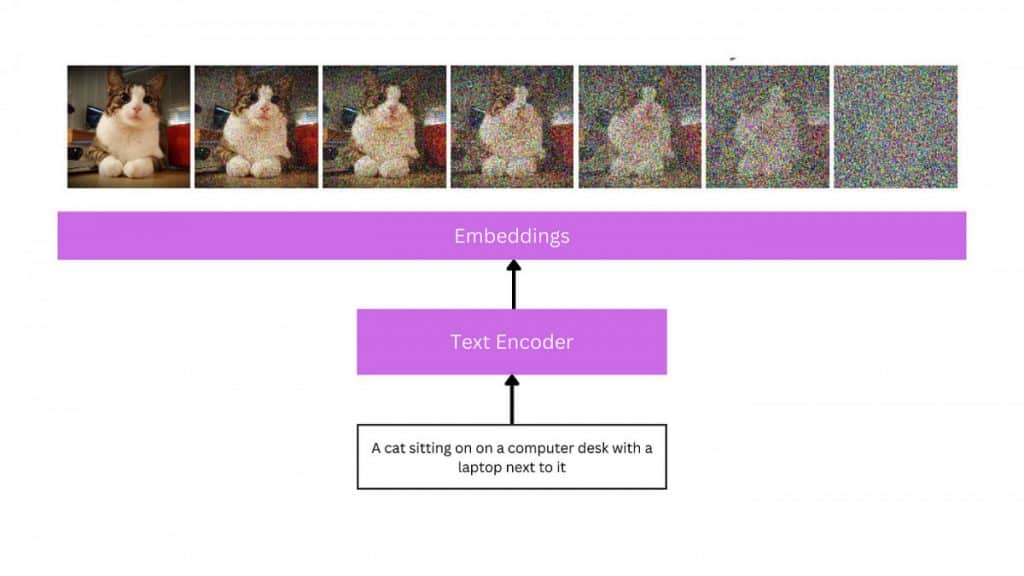

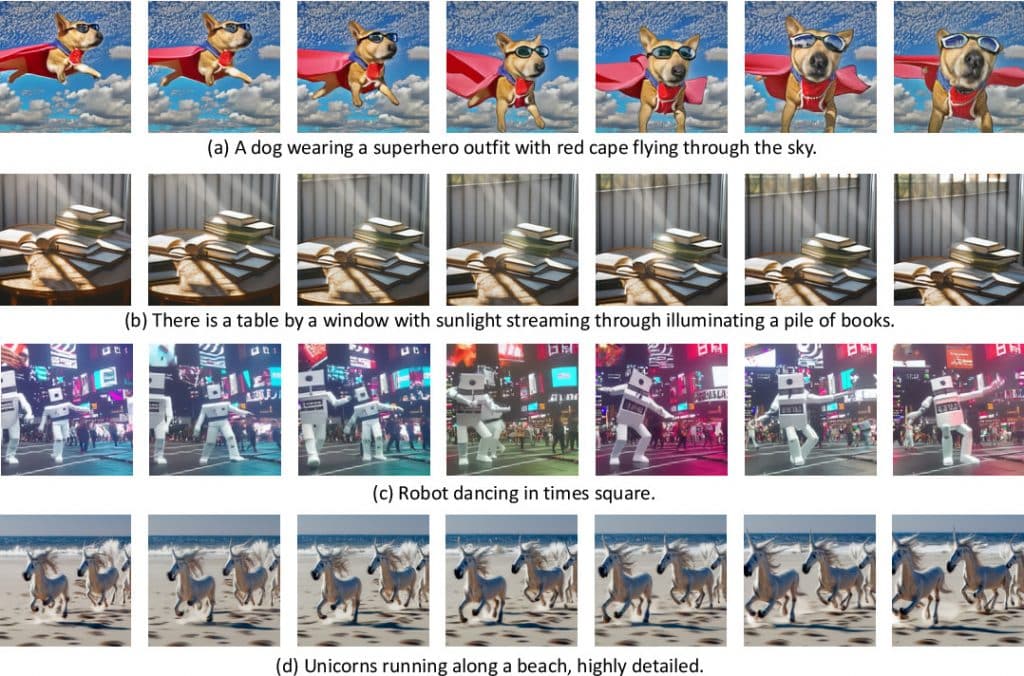

Eingabeaufforderungen in natürlicher Sprache sind die Eingaben, die von Text-zu-Video-Modellen zum Erstellen von Videos verwendet werden. Diese Modelle verstehen den Kontext und die Semantik des Eingabetextes und erzeugen dann mithilfe ausgefeilter Methoden eine entsprechende Videosequenz Maschinelles Lernen, Deep Learning oder wiederkehrende neuronale Netzwerkansätze. Text-to-Video ist ein sich schnell entwickelnder Bereich, dessen Schulung enorme Datenmengen und Rechenleistung erfordert. Sie können zur Unterstützung des Filmemachens oder zur Produktion unterhaltsamer oder werblicher Videos eingesetzt werden.

Verständnis des Text-to-Video-KI-Modells

Ähnlich wie das Text-zu-Bild-Problem wird die Text-zu-Video-Produktion derzeit erst seit einigen Jahren untersucht. Frühere Studien generierten Frames mit Untertiteln größtenteils automatisch regressiv mithilfe von GAN- und VAE-basierten Techniken. Diese Studien beschränken sich auf niedrige Auflösung, kurze Reichweite und einzigartige, isolierte Bewegungen, obwohl sie den Grundstein für ein neuartiges Computer-Vision-Problem legten.

Die folgende Welle der Forschung zur Text-zu-Video-Generierung verwendete Transformatorstrukturen, die auf dem Erfolg groß angelegter vorab trainierter Transformatormodelle in Text beruhten (GPT-3) und Bild (DALL-E). Während Werke wie TATS hybride Ansätze präsentieren, die VQGAN für die Bilderstellung mit einem zeitempfindlichen Transformatormodul für die sequentielle Bilderzeugung umfassen, Phenaki, Make-A-Video, NUWA, VideoGPTund CogVideo schlagen alle transformatorbasierte Frameworks vor. Phenaki, eines der Werke dieser zweiten Welle, ist besonders faszinierend, da es einem erlaubt, beliebig lange Filme zu erstellen, die auf einer Reihe von Anregungen oder einer Erzählung basieren. Ebenso ermöglicht NUWA-Infinity die Erstellung erweiterter, hochentwickelterdefiNitionsfilme, indem eine autoregressive über autoregressive Generierungstechnik für die endlose Bild- und Videosynthese aus Texteingaben vorgeschlagen wird. Allerdings sind die Modelle NUWA und Phenaki nicht für die breite Öffentlichkeit zugänglich.

Die meisten Text-zu-Video-Modelle der dritten und aktuellen Welle umfassen diffusionsbasierte Topologien. Diffusionsmodelle haben beeindruckende Ergebnisse bei der Erzeugung reichhaltiger, hyperrealistischer und abwechslungsreicher Bilder gezeigt. Dies hat das Interesse an der Anwendung von Diffusionsmodellen auf andere Bereiche geweckt, darunter Audio, 3D und neuerdings auch Video. Videodiffusionsmodelle (VDM), die Diffusionsmodelle auf den Videobereich erweitern, und MagicVideo, das ein Framework für die Produktion von Videoclips in einem niedrigdimensionalen latenten Raum vorschlägt und erhebliche Effizienzvorteile gegenüber VDM verspricht, sind die Vorläufer dieser Modellgeneration . Ein weiteres bemerkenswertes Beispiel ist Tune-a-Video, das die Verwendung eines Text-Video-Paars zur Feinabstimmung eines vorab trainierten Text-zu-Bild-Modells ermöglicht und es ermöglicht, den Videoinhalt zu ändern und dabei die Bewegung beizubehalten.

Zukunft des Text-to-Video-KI-Modells

Hollywoods Text-to-Video- und künstliche Intelligenz (KI) Die Zukunft ist voller Chancen und Schwierigkeiten. Wir können mit viel komplexeren und lebensechteren KI-generierten Videos rechnen, wenn sich diese generativen KI-Systeme weiterentwickeln und besser darin werden, Videos aus Textaufforderungen zu produzieren. Die Möglichkeiten, die Programme wie Runways Gen2, NVIDIAs NeRF und Googles Transframer bieten, sind nur die Spitze des Eisbergs. Komplexere emotionale Ausdrücke, Videobearbeitung in Echtzeit und sogar die Möglichkeit, aus einer Texteingabe abendfüllende Spielfilme zu erstellen, sind mögliche zukünftige Entwicklungen. Beispielsweise könnte die Storyboard-Visualisierung während der Vorproduktion mithilfe der Text-to-Video-Technologie erfolgen, sodass Regisseure vor dem Dreh Zugriff auf eine unvollendete Version einer Szene haben. Dies könnte zu Ressourcen- und Zeiteinsparungen führen und die Effizienz des Filmherstellungsprozesses verbessern. Mit diesen Tools lässt sich auch für Marketing- und Werbezwecke schnell und kostengünstig hochwertiges Videomaterial produzieren. Mit ihnen lassen sich auch fesselnde Videos erstellen.

Aktuelle Neuigkeiten zum Text-to-Video-KI-Modell

- Zeroskop, eine kostenlose und quelloffene Text-zu-Video-Technologie, ist ein Konkurrent von Gen-2 von Runway ML. Ziel ist es, geschriebene Wörter in dynamische Bilder umzuwandeln und dabei eine höhere Auflösung und ein näheres Seitenverhältnis von 16:9 zu bieten. Es ist in zwei Versionen erhältlich, Zeroskop_v2 567w und Zeroskop_v2 XL, erfordert 7.9 GB VRam und führt Offset-Rauschen ein, um die Datenverteilung zu verbessern. Zeroskop ist eine praktikable Open-Source-Alternative zu Runways Gen-2 und bietet eine vielfältigere Auswahl an realistischen Videos.

- VideoDirectorGPT ist ein innovativer Ansatz zur Text-zu-Video-Generierung, der Large Language Models (LLMs) mit Videoplanung kombiniert, um präzise und konsistente Videos mit mehreren Szenen zu erstellen. Es verwendet LLMs als Meister des Geschichtenerzählens und erstellt Textbeschreibungen auf Szenenebene, Objektlisten und Bild-für-Bild-Layouts. Layout2Vid, ein Videogenerierungsmodul, bietet räumliche Kontrolle über Objektlayouts. Die Modelle Masterpiece von Yandex und Gen-2 von Runway bieten Zugänglichkeit und Einfachheit und verbessern gleichzeitig die Erstellung und Weitergabe von Inhalten auf Social-Media-Plattformen.

- Yandex hat eine neue Funktion namens Masterpiece eingeführt, mit der Benutzer kurze Videos mit einer Länge von bis zu 4 Sekunden und einer Bildrate von 24 Bildern pro Sekunde erstellen können. Die Technologie nutzt die kaskadierte Diffusionsmethode, um aufeinanderfolgende Videobilder zu erstellen, sodass Benutzer eine breite Palette von Inhalten generieren können. Die Masterpiece-Plattform ergänzt bestehende Funktionen, einschließlich Bilderstellung und Textbeiträge. Das neuronale Netzwerk generiert Videos durch textbasierte Beschreibungen, Bildauswahl und automatisierte Generierung. Die Funktion erfreut sich zunehmender Beliebtheit und steht derzeit ausschließlich aktiven Benutzern zur Verfügung.

Neueste soziale Beiträge zum Text-to-Video-KI-Modell

Haftungsausschluss

Im Einklang mit der Richtlinien des Trust-ProjektsBitte beachten Sie, dass die auf dieser Seite bereitgestellten Informationen nicht als Rechts-, Steuer-, Anlage-, Finanz- oder sonstige Beratung gedacht sind und nicht als solche interpretiert werden sollten. Es ist wichtig, nur so viel zu investieren, wie Sie sich leisten können, zu verlieren, und im Zweifelsfall eine unabhängige Finanzberatung einzuholen. Für weitere Informationen empfehlen wir einen Blick auf die Allgemeinen Geschäftsbedingungen sowie die Hilfe- und Supportseiten des Herausgebers oder Werbetreibenden. MetaversePost ist einer genauen, unvoreingenommenen Berichterstattung verpflichtet, die Marktbedingungen können sich jedoch ohne Vorankündigung ändern.

Über den Autor

Viktoriia ist Autorin zu verschiedenen Technologiethemen, darunter Web3.0, KI und Kryptowährungen. Ihre umfangreiche Erfahrung ermöglicht es ihr, aufschlussreiche Artikel für ein breiteres Publikum zu schreiben.

Weitere Artikel

Viktoriia ist Autorin zu verschiedenen Technologiethemen, darunter Web3.0, KI und Kryptowährungen. Ihre umfangreiche Erfahrung ermöglicht es ihr, aufschlussreiche Artikel für ein breiteres Publikum zu schreiben.