8 coses que hauríeu de saber sobre els grans models lingüístics

En breu

Grans models lingüístics (LLMs) s'utilitzen per explorar els matisos del llenguatge natural, millorar la capacitat de les màquines per comprendre i generar text i automatitzar tasques com ara el reconeixement de veu i la traducció automàtica.

No hi ha una solució fàcil per gestionar els LLM, però són tan capaços com els humans.

Amb l'augment del desenvolupament del processament del llenguatge natural i el seu ús als negocis, hi ha un interès creixent pels grans models de llenguatge. Aquests models s'utilitzen per explorar els matisos del llenguatge natural, millorar la capacitat de les màquines per comprendre i generar text i automatitzar tasques com ara el reconeixement de veu i la traducció automàtica. Aquí teniu vuit coses essencials que hauríeu de saber sobre els grans models de llenguatge (LLM).

- Els LLM són més "capaços" a mesura que els costos segueixen augmentant

- Un cop d'ull a com GPT els models s'adapten a mesura que augmenten els costos de formació

- Els LLM aprenen a jugar a jocs de taula utilitzant representacions del món exterior

- No hi ha una solució fàcil per gestionar LLM

- Els experts tenen problemes per explicar com funciona el LLM

- Els LLM són tan capaços com els humans

- Els LLM han de ser més que un "joc de tot"

- Els models són "més intel·ligents" del que la gent pensa segons les primeres impressions

Els LLM són més "capaços" a mesura que els costos segueixen augmentant

Com era previsible, els LLM es tornen més "capaços" amb costos creixents, fins i tot sense innovacions interessants. El més important aquí és la previsibilitat, que es va mostrar a l'article sobre GPT-4: es van ensenyar de cinc a set models petits amb un pressupost del 0.1% del final, i després es va fer una predicció per a un model enorme basat en això. Per a una avaluació general de la perplexitat i les mètriques en una submostra d'una tasca específica, aquesta predicció era molt precisa. Aquesta predictibilitat és important per a les empreses i organitzacions que depenen dels LLM per a les seves operacions, ja que poden pressupostar en conseqüència i planificar despeses futures. No obstant això, és important tenir en compte que, tot i que l'augment dels costos pot comportar una millora de les capacitats, el ritme de millora pot arribar a s'aplanar, la qual cosa fa que sigui necessari invertir en noves innovacions per continuar avançant.

Un cop d'ull a com GPT els models s'adapten a mesura que augmenten els costos de formació

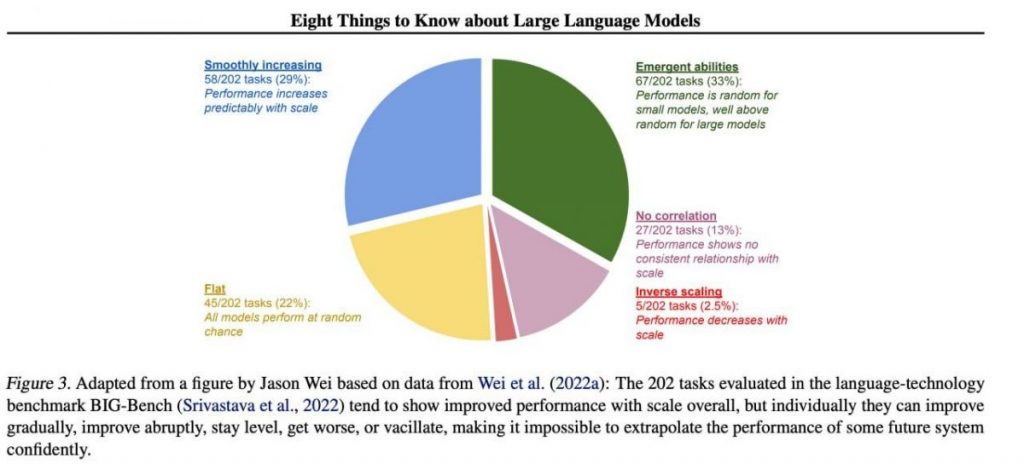

Tanmateix, les habilitats importants específiques solen sorgir de manera imprevisible com a subproducte de l'augment costos de formació (entrenament més llarg, més dades, model més gran): és gairebé impossible predir quan els models començaran a realitzar determinades tasques. Hem explorat el tema amb més profunditat al nostre article sobre la història del desenvolupament de GPT models. La imatge mostra la distribució de l'augment de la qualitat dels models en diferents tasques. Només els grans models poden aprendre a fer diverses tasques. Aquest gràfic destaca l'impacte significatiu d'augmentar la mida de GPT models sobre el seu rendiment en diferents tasques. No obstant això, és important tenir en compte que això té el cost d'augmentar els recursos computacionals i l'impacte ambiental.

Els LLM aprenen a jugar a jocs de taula utilitzant representacions del món exterior

Els LLM sovint aprenen i utilitzen representacions del món exterior. Hi ha molts exemples aquí, i aquí en teniu un: Models formats per jugar a jocs de taula basats en descripcions de moviments individuals, sense veure mai una imatge del terreny de joc, aprendre representacions internes de l'estat del tauler a cada moviment. Aquestes representacions internes es poden utilitzar llavors predir futur moviments i resultats, permetent al model jugar el joc a un alt nivell. Aquesta capacitat d'aprendre i utilitzar representacions és clau aspecte de l'aprenentatge automàtic i intel·ligència artificial.

No hi ha una solució fàcil per gestionar LLM

No hi ha mètodes fiables per controlar el comportament de LLM. Tot i que hi ha hagut alguns avenços en la comprensió i la mitigació de diversos problemes (inclosos ChatGPT i GPT-4 amb l'ajuda de la retroalimentació), no hi ha consens sobre si podem resoldre'ls. Hi ha una creixent preocupació que es converteixi en un problema enorme i potencialment catastròfic en el futur quan es creïn sistemes encara més grans. Per tant, els investigadors estan explorant nous mètodes per garantir que els sistemes d'IA s'alineen amb els valors i objectius humans, com ara l'alineació de valors i l'enginyeria de recompenses. No obstant això, segueix sent una tasca difícil de garantir seguretat i fiabilitat dels LLM en escenaris complexos del món real.

Els experts tenen problemes per explicar com funciona el LLM

Els experts encara no poden interpretar el funcionament intern del LLM. Cap tècnica ens permetria afirmar de manera satisfactòria quins tipus de coneixements, raonaments o objectius utilitza el model quan genera algun resultat. Aquesta manca d'interpretabilitat genera preocupacions sobre la fiabilitat i l'equitat de les decisions del LLM, especialment en aplicacions de gran risc com ara la justícia penal o la puntuació de crèdit. També destaca la necessitat de més investigacions sobre el desenvolupament de models d'IA més transparents i responsables.

Els LLM són tan capaços com els humans

Tot i que els LLM estan formats principalment per imitar el comportament humà quan escriu text, tenen el potencial de superar-nos en moltes tasques. Això ja es pot veure quan es juga a escacs o Go. Això es deu a la seva capacitat per analitzar grans quantitats de dades i prendre decisions basades en aquesta anàlisi a una velocitat que els humans no poden igualar. Tanmateix, els LLM encara no tenen la creativitat i la intuïció que posseeixen els humans, cosa que els fa menys aptes per a moltes tasques.

Els LLM han de ser més que un "joc de tot"

Els LLM no han d'expressar els valors dels seus creadors ni els valors codificats en una selecció d'Internet. No han de repetir estereotips ni teories de conspiració ni intentar ofendre ningú. En lloc d'això, els LLM s'han de dissenyar per proporcionar informació imparcial i real als seus usuaris respectant les diferències culturals i socials. A més, s'han de sotmetre a proves i controls periòdics per assegurar-se que segueixen complint aquests estàndards.

Els models són "més intel·ligents" del que la gent pensa segons les primeres impressions

Les estimacions de la capacitat d'un model basades en les primeres impressions sovint són enganyoses. Molt sovint, cal que trobis la indicació adequada, suggerir un model i potser mostrar exemples, i començarà a fer front molt millor. És a dir, és "més intel·ligent" del que sembla a primera vista. Per tant, és fonamental donar-li una oportunitat justa al model i dotar-li dels recursos necessaris per rendir-se al màxim. Amb l'enfocament correcte, fins i tot models aparentment inadequats ens poden sorprendre amb les seves capacitats.

Si ens centrem en una mostra de 202 tasques del conjunt de dades BIG-Bench (es va dificultar especialment la prova models lingüístics de i fins a), aleshores, per regla general (de mitjana), els models mostren un augment de la qualitat amb l'augment de l'escala, però individualment, les mètriques de les tasques poden:

- millorar gradualment,

- millorar dràsticament,

- romandre sense canvis,

- disminuir,

- no mostren cap correlació.

Tot això comporta la impossibilitat d'extrapolar amb confiança el rendiment de qualsevol sistema futur. La part verda és especialment interessant: aquí és exactament on els indicadors de qualitat augmenten bruscament sense cap motiu.

Llegeix més sobre AI:

renúncia

En línia amb la Directrius del projecte Trust, si us plau, tingueu en compte que la informació proporcionada en aquesta pàgina no pretén ni s'ha d'interpretar com a assessorament legal, fiscal, d'inversió, financer o de cap altra forma. És important invertir només el que et pots permetre perdre i buscar assessorament financer independent si tens dubtes. Per obtenir més informació, us suggerim que feu referència als termes i condicions, així com a les pàgines d'ajuda i assistència proporcionades per l'emissor o l'anunciant. MetaversePost es compromet a fer informes precisos i imparcials, però les condicions del mercat estan subjectes a canvis sense previ avís.

About The Autor

Damir és el líder d'equip, cap de producte i editor de Metaverse Post, que cobreix temes com AI/ML, AGI, LLMs, Metaverse i Web3-camps relacionats. Els seus articles atrauen una audiència massiva de més d'un milió d'usuaris cada mes. Sembla ser un expert amb 10 anys d'experiència en SEO i màrqueting digital. Damir ha estat esmentat a Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i altres publicacions. Viatja entre els Emirats Àrabs Units, Turquia, Rússia i la CEI com a nòmada digital. Damir va obtenir una llicenciatura en física, que creu que li ha donat les habilitats de pensament crític necessàries per tenir èxit en el paisatge en constant canvi d'Internet.

més articles

Damir és el líder d'equip, cap de producte i editor de Metaverse Post, que cobreix temes com AI/ML, AGI, LLMs, Metaverse i Web3-camps relacionats. Els seus articles atrauen una audiència massiva de més d'un milió d'usuaris cada mes. Sembla ser un expert amb 10 anys d'experiència en SEO i màrqueting digital. Damir ha estat esmentat a Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i altres publicacions. Viatja entre els Emirats Àrabs Units, Turquia, Rússia i la CEI com a nòmada digital. Damir va obtenir una llicenciatura en física, que creu que li ha donat les habilitats de pensament crític necessàries per tenir èxit en el paisatge en constant canvi d'Internet.