Stability AIАвтора Stable Diffusion 2 Алгоритм нарешті став загальнодоступним: нова модель deep2img, масштабатор високої роздільної здатності, без вмісту для дорослих

Коротко

Stable Diffusion Модель 2.0 швидша, з відкритим вихідним кодом, масштабована, надійніша за попередню

Stable Diffusion готовий до графічного процесора з новими функціями для візуалізації в реальному часі

Поглиблений stable diffusion модель – Зображення до зображення з новими ідеями для творчих застосувань

Stability AI має випущений нова стаття у своєму блозі про Stable Diffusion 2. У ньому Stability AI пропонує новий алгоритм, який є більш ефективним і надійним, ніж попередній, одночасно порівнюючи його з іншими найсучаснішими методами.

Оригінал CompVis Stable Diffusion Модель V1 революціонізували природа open-source Моделі AI і виготовив сотні різних моделей і вдосконалень по всьому світу. Він став одним із найшвидших підйомів до 10,000 33,000 зірок Github, набравши XNUMX XNUMX менш ніж за два місяці, швидше, ніж інші програми на Github.

Оригінальний Stable Diffusion Випуск V1 очолив динамічна команда Робіна Ромбаха (Stability AI) і Патрік Ессер (Runway ML) з групи CompVis LMU Мюнхена під керівництвом професора, доктора Бйорна Оммера. Вони ґрунтувалися на попередній роботі лабораторії з Latent Дифузійні моделі і отримав критичну підтримку від LAION і Eleuther AI.

Що робить Stable Diffusion v1 відрізняється від Stable Diffusion v2?

Stable Diffusion 2.0 містить низку значних удосконалень і функцій порівняно з попередньою версією, тому давайте подивимося на них.

Команда Stable Diffusion Випуск 2.0 містить надійні моделі перетворення тексту в зображення, навчені новим кодувальником тексту (OpenCLIP), розробленим LAION за підтримки Stability AI, що значно підвищує якість створені зображення порівняно з попередніми випусками V1. Моделі перетворення тексту в зображення цього випуску можуть виводити зображення з роздільною здатністю за замовчуванням 512 × 512 пікселів і 768 × 768 пікселів.

Ці моделі тренуються з використанням естетичної підмножини набору даних LAION-5B, створеного Stability AIкоманда DeepFloyd, яка потім фільтрується, щоб виключити вміст для дорослих за допомогою фільтра NSFW LAION.

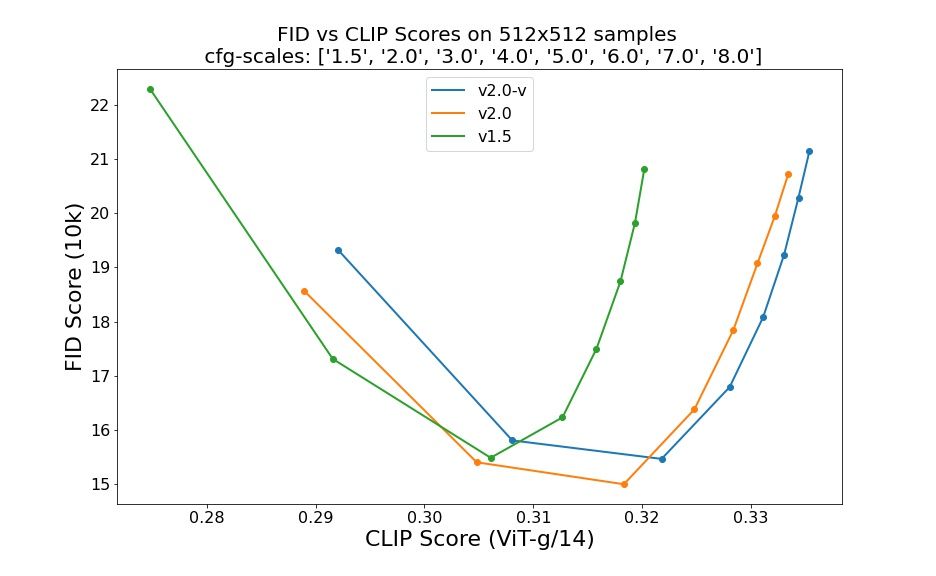

Оцінки з використанням 50 зразкових кроків DDIM, 50 орієнтовних шкал без класифікаторів і 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 і 8.0 вказують на відносне покращення контрольних точок:

Stable Diffusion 2.0 тепер включає модель Upscaler Diffusion, яка збільшує роздільну здатність зображення в чотири рази. Приклад нашої моделі підвищення масштабу згенероване зображення низької якості (128 × 128) у зображення з вищою роздільною здатністю показано нижче (512 × 512). Stable Diffusion 2.0 у поєднанні з нашими моделями перетворення тексту в зображення тепер може створювати зображення з роздільністю 2048 × 2048 або вище.

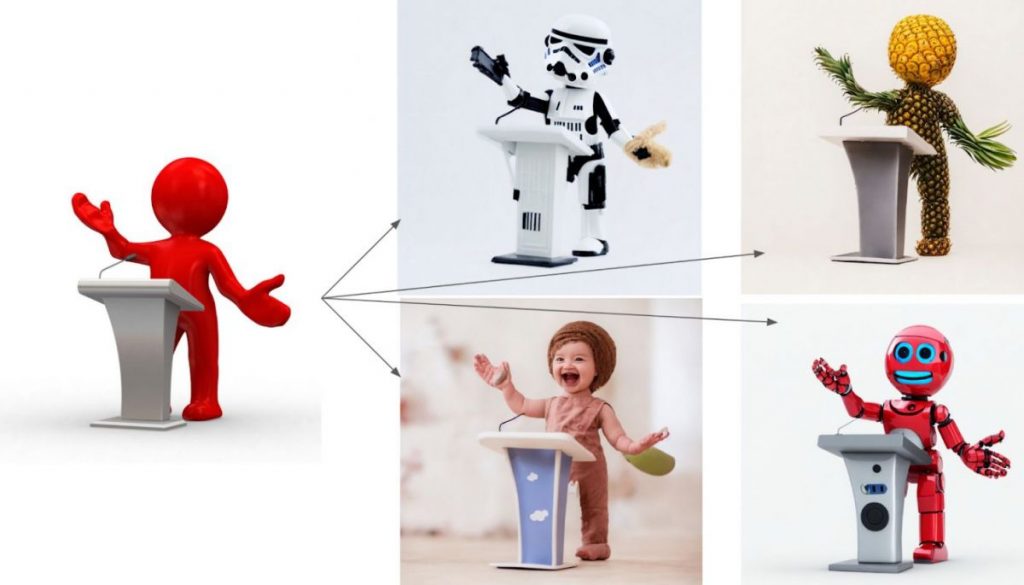

Нова система керування глибиною stable diffusion модель, deep2img, розширює попередню функцію зображення до зображення з V1 абсолютно новими творчими можливостями. Depth2img визначає глибину вхідного зображення (використовуючи наявну модель), а потім створює нове зображень на основі тексту та глибинної інформації. Depth-to-Image може надати безліч нових творчих додатків, пропонуючи зміни, які, здається, значно відрізняються від оригіналу, зберігаючи когерентність і глибину зображення.

Що нового в Stable Diffusion 2?

- Новий stable diffusion модель пропонує роздільну здатність 768×768.

- U-Net має таку саму кількість параметрів, як і версія 1.5, але вона навчена з нуля та використовує OpenCLIP-ViT/H як текстовий кодер. Так звана модель v-прогнозування — це SD 2.0-v.

- Вищезгадану модель було налаштовано на базі SD 2.0, яка також стала доступною, і була навчена як типова модель прогнозування шуму на зображеннях 512×512.

- Додано латентну текстову модель дифузії з масштабуванням x4.

- Удосконалений стандарт SD 2.0 із наведенням по глибині stable diffusion модель. Модель може бути використана для img2img зі збереженням структури та умовного синтезу форми та базується на оцінках глибини монокуляра, отриманих MiDaS.

- Покращена модель малювання з керуванням текстом, побудована на основі SD 2.0.

Розробники наполегливо працювали, як і в початковій ітерації Stable Diffusion, щоб оптимізувати модель для роботи на одному GPU — вони хотіли зробити її доступною для якомога більшої кількості людей із самого початку. Вони вже бачили, що відбувається, коли мільйони людей отримують у свої руки ці моделі та співпрацюють, щоб створювати неймовірні речі. Це сила відкритого вихідного коду: використання величезного потенціалу мільйонів талановитих людей, які, можливо, не мають ресурсів для навчання передової моделі, але мають здатність робити неймовірні речі з нею.

Це нове оновлення, у поєднанні з новими потужними функціями, як-от deep2img, і кращими можливостями збільшення роздільної здатності, стане основою для безлічі нових програм і дозволить розкрити новий творчий потенціал.

Докладніше про Stable Diffusion:

відмова

Відповідно до Правила проекту Trust, будь ласка, зверніть увагу, що інформація, надана на цій сторінці, не призначена і не повинна тлумачитися як юридична, податкова, інвестиційна, фінансова або будь-яка інша форма консультації. Важливо інвестувати лише те, що ви можете дозволити собі втратити, і звернутися за незалежною фінансовою порадою, якщо у вас виникнуть сумніви. Щоб отримати додаткову інформацію, ми пропонуємо звернутися до положень та умов, а також до сторінок довідки та підтримки, наданих емітентом або рекламодавцем. MetaversePost прагне до точного, неупередженого звітування, але ринкові умови можуть змінюватися без попередження.

про автора

Дамір є керівником групи, менеджером із продуктів і редактором Metaverse Post, що охоплює такі теми, як AI/ML, AGI, LLMs, Metaverse тощо Web3- суміжні поля. Його статті щомісяця приваблюють величезну аудиторію понад мільйон користувачів. Здається, він є експертом із 10-річним досвідом роботи в SEO та цифровому маркетингу. Даміра згадували в Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto та інші видання. Він подорожує між ОАЕ, Туреччиною, Росією та СНД як цифровий кочівник. Дамір отримав ступінь бакалавра з фізики, що, на його думку, дало йому навички критичного мислення, необхідні для досягнення успіху в Інтернеті, який постійно змінюється.

інші статті

Дамір є керівником групи, менеджером із продуктів і редактором Metaverse Post, що охоплює такі теми, як AI/ML, AGI, LLMs, Metaverse тощо Web3- суміжні поля. Його статті щомісяця приваблюють величезну аудиторію понад мільйон користувачів. Здається, він є експертом із 10-річним досвідом роботи в SEO та цифровому маркетингу. Даміра згадували в Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto та інші видання. Він подорожує між ОАЕ, Туреччиною, Росією та СНД як цифровий кочівник. Дамір отримав ступінь бакалавра з фізики, що, на його думку, дало йому навички критичного мислення, необхідні для досягнення успіху в Інтернеті, який постійно змінюється.