Stability AIÄr Stable Diffusion 2 Algoritmen är äntligen offentlig: ny depth2img-modell, uppskalare med superupplösning, inget vuxet innehåll

I korthet

Stable Diffusion 2.0-modellen är snabbare, öppen källkod, skalbar, mer robust än den tidigare

Stable Diffusion blir GPU-klar med nya funktioner för realtidsrendering

Djupstyrd stable diffusion modell – Bild-till-bild med nya idéer för kreativa tillämpningar

Stability AI har frigörs en ny tidning på sin blogg om Stable Diffusion 2. I den, Stability AI föreslår en ny algoritm som är mer effektiv och robust än den tidigare samtidigt som den jämförs med andra toppmoderna metoder.

CompVis original Stable Diffusion V1-modell revolution karaktären av öppen källkod AI-modeller och producerade hundratals olika modeller och framsteg runt om i världen. Den såg en av de snabbaste klättringarna till 10,000 33,000 Github-stjärnor, och samlade XNUMX XNUMX på mindre än två månader, snabbare än fler program på Github.

Den ursprungliga Stable Diffusion V1-släppet leddes av det dynamiska teamet av Robin Rombach (Stability AI) och Patrick Esser (Runway ML) från CompVis Group vid LMU München, ledd av Prof. Dr. Björn Ommer. De byggde vidare på labbets tidigare arbete med Latent Diffusionsmodeller och fick kritiskt stöd från LAION och Eleuther AI.

Vad gör Stable Diffusion v1 skiljer sig från Stable Diffusion v2?

Stable Diffusion 2.0 innehåller ett antal betydande förbättringar och funktioner jämfört med den tidigare versionen, så låt oss ta en titt på dem.

Smakämnen Stable Diffusion 2.0-versionen har robusta text-till-bild-modeller tränade med en fräsch ny textkodare (OpenCLIP) utvecklad av LAION med hjälp från Stability AI, vilket avsevärt förbättrar kvaliteten på genererade bilder över tidigare V1-släpp. Den här versionens text-till-bild-modeller kan mata ut bilder med standardupplösningar på 512×512 pixlar och 768×768 pixlar.

Dessa modeller tränas med hjälp av en estetisk delmängd av LAION-5B-datauppsättningen som genereras av Stability AIs DeepFloyd-team, som sedan filtreras för att utesluta vuxet innehåll med hjälp av LAIONs NSFW-filter.

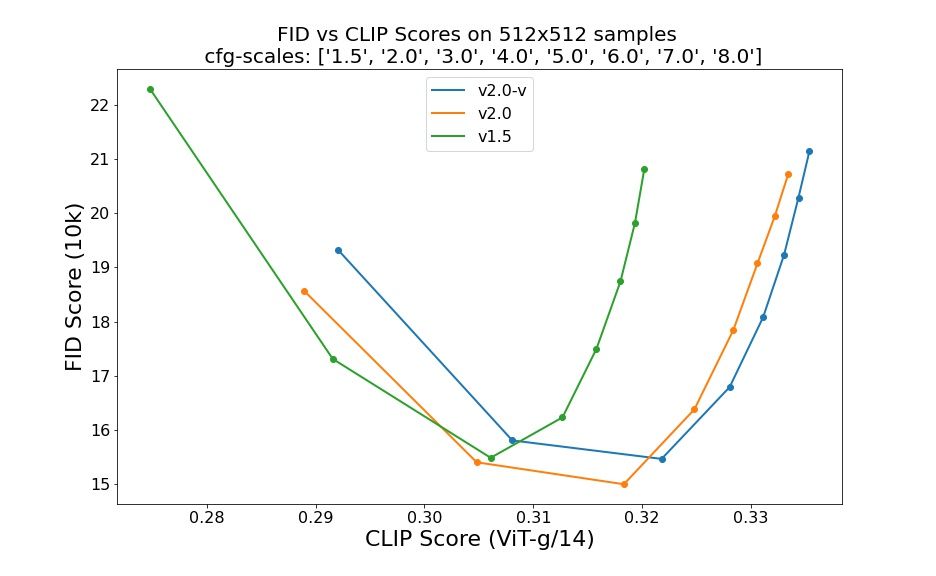

Utvärderingar med 50 DDIM-provsteg, 50 klassificerarefria vägledande skalor och 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 och 8.0 indikerar relativa förbättringar av kontrollpunkterna:

Stable Diffusion 2.0 innehåller nu en Upscaler Diffusion-modell, som ökar bildupplösningen med en faktor fyra. Ett exempel på vår modell uppskalning en bild av låg kvalitet (128×128) till en bild med högre upplösning visas nedan (512×512). Stable Diffusion 2.0, i kombination med våra text-till-bild-modeller, kan nu generera bilder med upplösningar på 2048×2048 eller högre.

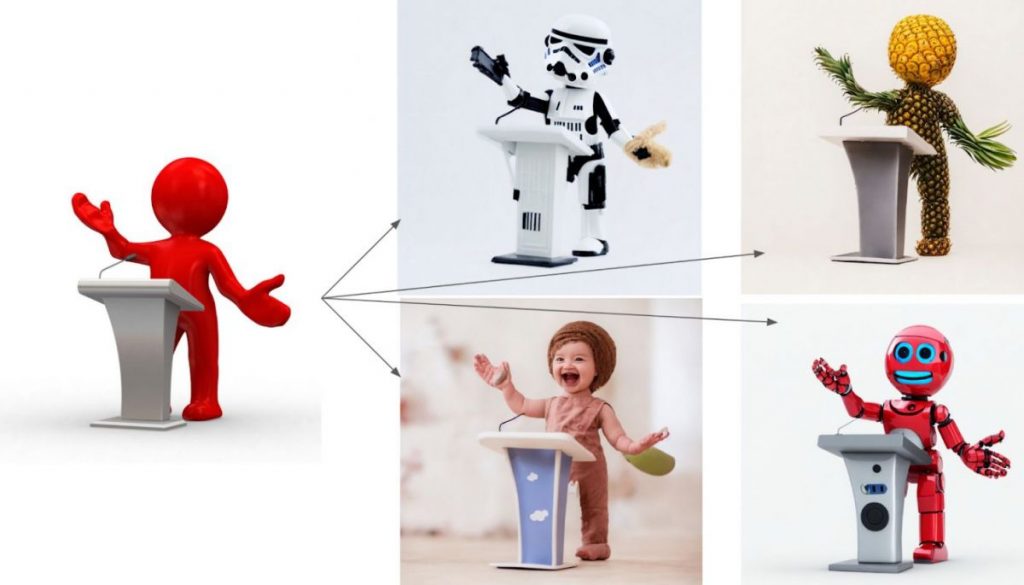

Den nya djupledda stable diffusion modell, depth2img, utökar den tidigare bild-till-bild-funktionen från V1 med helt nya kreativa möjligheter. Depth2img bestämmer djupet på en ingångsbild (med en befintlig modell) och genererar sedan nya bilder baserat på både texten och djupinformationen. Depth-to-Image kan tillhandahålla en uppsjö av nya kreativa applikationer som erbjuder förändringar som verkar väsentligt annorlunda än originalet samtidigt som bildens koherens och djup bibehålls.

Vad är nytt i Stable Diffusion 2?

- Den nya stable diffusion modell erbjuder en upplösning på 768×768.

- U-Net har samma mängd parametrar som version 1.5, men det är tränat från grunden och använder OpenCLIP-ViT/H som sin textkodare. En så kallad v-prediktionsmodell är SD 2.0-v.

- Ovannämnda modell justerades från SD 2.0-bas, som också görs tillgänglig och tränades som en typisk brusprediktionsmodell på 512×512 bilder.

- En latent textstyrd diffusionsmodell med x4-skalning har lagts till.

- Förfinad SD 2.0-bas djupstyrd stable diffusion modell. Modellen kan användas för strukturbevarande img2img och formbetingad syntes och är betingad av monokulära djupuppskattningar härledda av MiDaS.

- En förbättrad textstyrd målningsmodell byggd på SD 2.0-grunden.

Utvecklare arbetade hårt, precis som den första iterationen av Stable Diffusion, för att optimera modellen för att köras på en enda GPU – de ville göra den tillgänglig för så många människor som möjligt redan från början. De har redan sett vad som händer när miljontals individer lägger vantarna på dessa modeller och samarbetar för att bygga helt anmärkningsvärda saker. Detta är kraften med öppen källkod: att utnyttja den enorma potentialen hos miljontals begåvade människor som kanske inte har resurserna att träna en banbrytande modell men har förmågan att göra otroliga saker med en.

Denna nya uppdatering, i kombination med kraftfulla nya funktioner som depth2img och bättre upplösningsuppskalningsmöjligheter, kommer att fungera som grunden för en uppsjö av nya applikationer och möjliggöra en explosion av ny kreativ potential.

Läs mer om Stable Diffusion:

Villkor

I linje med den Riktlinjer för Trust Project, vänligen notera att informationen på den här sidan inte är avsedd att vara och inte ska tolkas som juridisk, skattemässig, investerings-, finansiell eller någon annan form av rådgivning. Det är viktigt att bara investera det du har råd att förlora och att söka oberoende finansiell rådgivning om du har några tvivel. För ytterligare information föreslår vi att du hänvisar till villkoren samt hjälp- och supportsidorna som tillhandahålls av utfärdaren eller annonsören. MetaversePost är engagerad i korrekt, opartisk rapportering, men marknadsförhållandena kan ändras utan föregående meddelande.

Om författaren

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.

fler artiklar

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.