Google introducerar innovativ generativ bilddynamik som simulerar dynamiska scener i statiska bilder

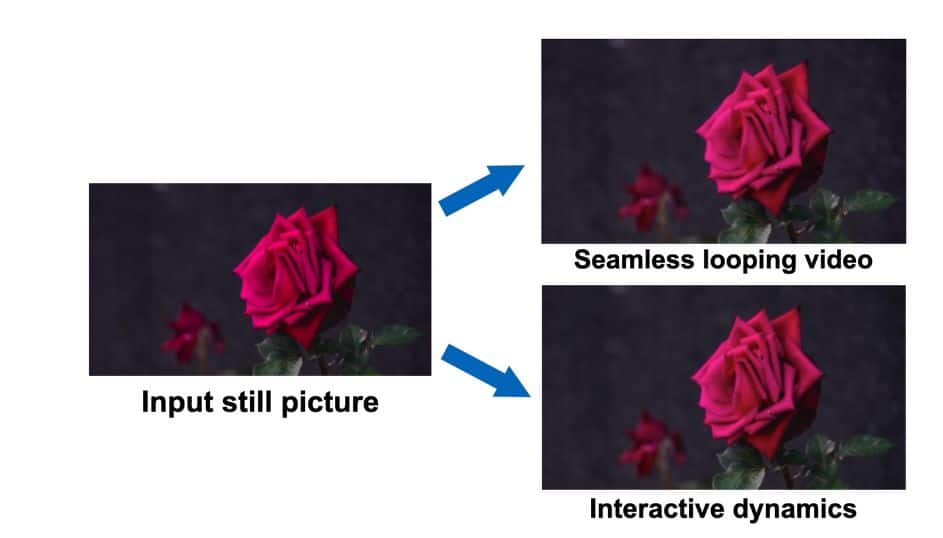

Google har avslöjat en Generativ bilddynamik, ett nytt tillvägagångssätt möjliggör omvandlingen av en en statisk bild till en sömlös looping video eller en interaktiv dynamisk scen som erbjuder ett brett utbud av praktiska tillämpningar.

Kärnan i denna banbrytande teknologi är modelleringen av ett bildrum före scenens dynamik. Målet är att skapa en heltäckande förståelse för hur objekt och element i en bild kan bete sig när de utsätts för olika dynamiska interaktioner. Denna förståelse kan sedan användas för att effektivt simulera objektdynamikens reaktion på användarinteraktioner.

Nyckelfunktionen hos denna teknik är förmågan att generera sömlösa looping-videor. Genom att utnyttja bildutrymmet före scendynamiken kan Googles system extrapolera och utöka rörelsen hos element i en bild och omvandla den till en fängslande och kontinuerlig videoslinga. Denna funktion öppnar upp för många kreativa möjligheter för innehållsskapare och designers.

Tekniken gör det möjligt för användare att interagera med objekt i statiska bilder på ett realistiskt sätt. Genom att simulera objektdynamikens reaktion på användarexitation tillåter Googles system uppslukande och interaktiva upplevelser i bilder. Detta har potential att revolutionera metaversa utrymmen och hur användare interagerar med visuellt innehåll.

Grunden för denna innovation ligger i en noggrant utbildad modell. Googles modell lär sig från ett stort dataset av rörelsebanor som extraherats från riktiga videosekvenser med naturlig, oscillerande rörelse. Dessa sekvenser inkluderar scener med element som träd som vajar, blommor som rör sig, ljus som flimrar och kläder som böljar i vinden. Denna mångsidiga datauppsättning gör det möjligt för modellen att förstå ett brett spektrum av dynamiska beteenden.

När den presenteras med en Enda bild, använder den tränade modellen en frekvenskoordinerad diffusionsprovtagningsprocess. Denna process förutsäger en långsiktig rörelserepresentation per pixel i Fourier-domänen, kallad en neural stokastisk rörelsetextur. Denna representation omvandlas sedan till täta rörelsebanor som spänner över en hel video. Tillsammans med en bildbaserad renderingsmodul kan dessa banor utnyttjas för olika praktiska tillämpningar.

Jämfört med tidigare över råa RGB-pixlar, fångar priors över motion mer fundamental, lägre dimensionell underdimensionell struktur som effektivt förklarar variationer i pixelvärden. Detta leder till mer sammanhängande långsiktig generering och mer finkornig kontroll över animationer jämfört med tidigare metoder som presterar bildanimering via rå videosyntes.

Den genererade rörelserepresentationen är bekväm för ett antal nedströmsapplikationer, som att skapa sömlösa looping-videor, redigera den genererade rörelsen och möjliggöra interaktiv dynamiska bilder, simulerar objektdynamikens respons på användartillämpade krafter.

Läs mer relaterade ämnen:

Villkor

I linje med den Riktlinjer för Trust Project, vänligen notera att informationen på den här sidan inte är avsedd att vara och inte ska tolkas som juridisk, skattemässig, investerings-, finansiell eller någon annan form av rådgivning. Det är viktigt att bara investera det du har råd att förlora och att söka oberoende finansiell rådgivning om du har några tvivel. För ytterligare information föreslår vi att du hänvisar till villkoren samt hjälp- och supportsidorna som tillhandahålls av utfärdaren eller annonsören. MetaversePost är engagerad i korrekt, opartisk rapportering, men marknadsförhållandena kan ändras utan föregående meddelande.

Om författaren

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.

fler artiklar

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.