8 saker du bör veta om stora språkmodeller

I korthet

Stora språkmodeller (LLM) används för att utforska nyanserna i naturligt språk, förbättra maskinernas förmåga att förstå och generera text och automatisera uppgifter som röstigenkänning och maskinöversättning.

Det finns ingen enkel lösning för att hantera LLM, men de är lika kapabla som människor.

Med en ökning av utvecklingen av naturlig språkbehandling och dess användning i näringslivet, finns det ett växande intresse för stora språkmodeller. Dessa modeller används för att utforska nyanserna av naturligt språk, förbättra maskinernas förmåga att förstå och generera text och automatisera uppgifter som röstigenkänning och maskinöversättning. Här är åtta viktiga saker som du bör veta om stora språkmodeller (LLM).

- LLM:er är mer "kapabla" eftersom kostnaderna fortsätter att stiga

- En snabb titt på hur GPT modeller anpassas när utbildningskostnaderna ökar

- LLM:er lär sig att spela brädspel genom att använda representationer av omvärlden

- Det finns ingen enkel lösning för att hantera LLM

- Experter har problem med att förklara hur LLM fungerar

- LLM:er är lika kapabla som människor

- LLM:er måste vara mer än bara ”jack-of-all-trades”

- Modeller är "smartare" än vad folk tror baserat på första intryck

LLM:er är mer "kapabla" eftersom kostnaderna fortsätter att stiga

LLM:er blir förutsägbart mer "kapabla" med ökande kostnader, även utan coola innovationer. Huvudsaken här är förutsägbarhet, vilket visades i artikeln om GPT-4: fem till sju små modeller lärdes ut med en budget på 0.1 % av den slutliga, och sedan gjordes en förutsägelse för en enorm modell baserad på detta. För en allmän bedömning av förvirring och mått på ett delprov av en specifik uppgift var en sådan förutsägelse mycket exakt. Denna förutsägbarhet är viktig för företag och organisationer som förlitar sig på LLM:er för sin verksamhet, eftersom de kan budgetera därefter och planera för framtida utgifter. Det är dock viktigt att notera att även om ökade kostnader kan leda till förbättrad kapacitet, kan förbättringstakten så småningom platåga, vilket gör det nödvändigt att investera i nya innovationer för att fortsätta utvecklas.

En snabb titt på hur GPT modeller anpassas när utbildningskostnaderna ökar

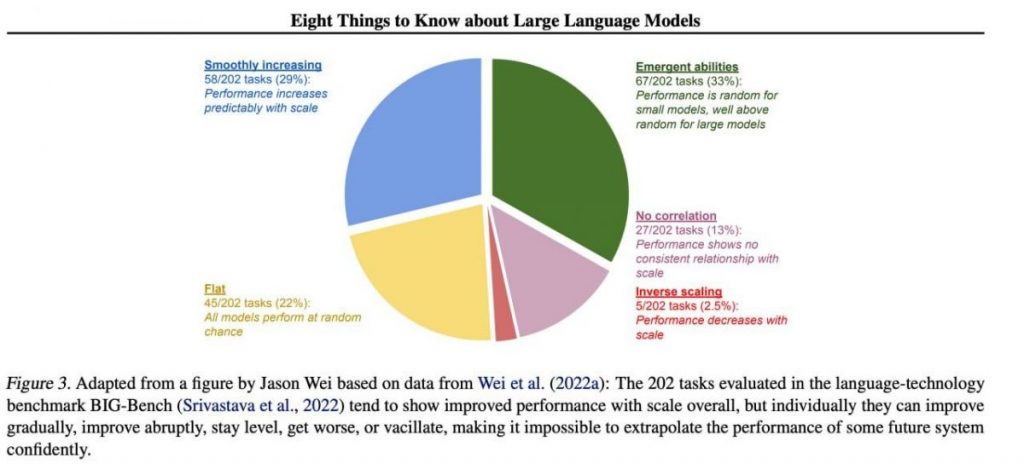

Men specifika viktiga färdigheter tenderar att framträda oförutsägbart som en biprodukt av att öka utbildningskostnader (längre träning, mer data, större modell) — det är nästan omöjligt att förutsäga när modeller kommer att börja utföra vissa uppgifter. Vi utforskade ämnet mer ingående i vår Artikeln om historien om utvecklingen av GPT modeller. Bilden visar fördelningen av kvalitetshöjningen på modeller över olika uppgifter. Det är bara de stora modellerna som kan lära sig att utföra olika uppgifter. Det här diagrammet visar den betydande effekten av att skala upp storleken på GPT modeller på deras prestationer för olika uppgifter. Det är dock viktigt att notera att detta sker på bekostnad av ökade beräkningsresurser och miljöpåverkan.

LLM:er lär sig att spela brädspel genom att använda representationer av omvärlden

LLMs lär sig och använder ofta representationer av omvärlden. Det finns många exempel här, och här är ett av dem: Modeller utbildade att spela brädspel baserat på beskrivningar av individuella drag, utan att någonsin se en bild av spelplanen, lära dig interna representationer av brädets tillstånd vid varje drag. Dessa interna representationer kan sedan användas till förutsäga framtiden rörelser och resultat, vilket gör att modellen kan spela spelet på en hög nivå. Denna förmåga att lära sig och använda representationer är en nyckel aspekt av maskininlärning och artificiell intelligens.

Det finns ingen enkel lösning för att hantera LLM

Det finns inga tillförlitliga metoder för att kontrollera LLM-beteende. Även om det har gjorts vissa framsteg när det gäller att förstå och mildra olika problem (inklusive ChatGPT och GPT-4 med hjälp av feedback) finns det ingen konsensus om vi kan lösa dem. Det finns en växande oro att detta kommer att bli ett enormt, potentiellt katastrofalt problem i framtiden när ännu större system skapas. Därför undersöker forskare nya metoder för att säkerställa att AI-system överensstämmer med mänskliga värderingar och mål, såsom värdeanpassning och belöningsteknik. Det är dock fortfarande en utmanande uppgift att garantera säkerhet och tillförlitlighet för LLM i komplexa verkliga scenarier.

Experter har problem med att förklara hur LLM fungerar

Experter kan ännu inte tolka LLM:s inre funktioner. Ingen teknik skulle tillåta oss att på något tillfredsställande sätt ange vilken typ av kunskap, resonemang eller mål som modellen använder när den genererar något resultat. Denna brist på tolkningsbarhet väcker farhågor om tillförlitligheten och rättvisan i LLM:s beslut, särskilt i höginsatsapplikationer som straffrätt eller kreditvärdering. Det belyser också behovet av ytterligare forskning om att utveckla mer transparenta och ansvarsfulla AI-modeller.

LLM:er är lika kapabla som människor

Även om LLMs är utbildade främst till imitera mänskligt beteende när du skriver text, de har potential att överträffa oss i många uppgifter. Detta kan redan ses när man spelar schack eller Go. Detta beror på deras förmåga att analysera stora mängder data och fatta beslut baserat på den analysen med en hastighet som människor inte kan matcha. Men LLM:er saknar fortfarande den kreativitet och intuition som människor besitter, vilket gör dem mindre lämpade för många uppgifter.

LLM:er måste vara mer än bara ”jack-of-all-trades”

LLM:er får inte uttrycka värderingarna hos sina skapare eller de värden som kodats i ett urval från Internet. De ska inte upprepa stereotyper eller konspirationsteorier eller försöka kränka någon. Istället bör LLM:er utformas för att tillhandahålla opartisk och saklig information till sina användare samtidigt som kulturella och samhälleliga skillnader respekteras. Dessutom bör de genomgå regelbunden testning och övervakning för att säkerställa att de fortsätter att uppfylla dessa standarder.

Modeller är "smartare" än vad folk tror baserat på första intryck

Uppskattningar av en modells förmåga baserat på första intryck är ofta missvisande. Mycket ofta måste du komma med rätt uppmaning, föreslå en modell och kanske visa exempel, och det kommer att börja klara sig mycket bättre. Det vill säga, det är "smartare" än det verkar vid första anblicken. Därför är det avgörande att ge modellen en rättvis chans och förse den med de nödvändiga resurserna för att prestera som bäst. Med rätt tillvägagångssätt kan även till synes otillräckliga modeller överraska oss med sina förmågor.

Om vi fokuserar på ett urval av 202 uppgifter från BIG-Bench-dataset (det var speciellt svårt att testa språkmodeller från och till), då som regel (i genomsnitt) visar modellerna en kvalitetshöjning med ökande skala, men individuellt kan måtten i uppgifterna:

- förbättras gradvis,

- förbättras drastiskt,

- fortsätter vara oförändrat,

- minska,

- visar inget samband.

Allt detta leder till omöjligheten att med tillförsikt extrapolera prestandan för ett framtida system. Den gröna delen är särskilt intressant — det är precis där kvalitetsindikatorerna hoppar upp kraftigt utan anledning alls.

Läs mer om AI:

Villkor

I linje med den Riktlinjer för Trust Project, vänligen notera att informationen på den här sidan inte är avsedd att vara och inte ska tolkas som juridisk, skattemässig, investerings-, finansiell eller någon annan form av rådgivning. Det är viktigt att bara investera det du har råd att förlora och att söka oberoende finansiell rådgivning om du har några tvivel. För ytterligare information föreslår vi att du hänvisar till villkoren samt hjälp- och supportsidorna som tillhandahålls av utfärdaren eller annonsören. MetaversePost är engagerad i korrekt, opartisk rapportering, men marknadsförhållandena kan ändras utan föregående meddelande.

Om författaren

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.

fler artiklar

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.