8 stvari, ki bi jih morali vedeti o velikih jezikovnih modelih

Na kratko

Veliki jezikovni modeli (LLM) se uporabljajo za raziskovanje odtenkov naravnega jezika, izboljšanje zmožnosti strojev za razumevanje in ustvarjanje besedila ter avtomatizacijo nalog, kot sta prepoznavanje glasu in strojno prevajanje.

Ni enostavne rešitve za upravljanje LLM-jev, vendar so enako sposobni kot ljudje.

Z naraščajočim razvojem obdelave naravnega jezika in njegove uporabe v poslovanju narašča zanimanje za velike jezikovne modele. Ti modeli se uporabljajo za raziskovanje odtenkov naravnega jezika, izboljšanje zmožnosti strojev za razumevanje in ustvarjanje besedila ter avtomatizacijo nalog, kot sta prepoznavanje glasu in strojno prevajanje. Tukaj je osem bistvenih stvari, ki bi jih morali vedeti o velikih jezikovnih modelih (LLM).

- LLM-ji so bolj »sposobni«, saj stroški nenehno naraščajo

- Hiter pogled na to, kako GPT modeli se prilagajajo z naraščanjem stroškov usposabljanja

- LLM se naučijo igrati družabne igre z uporabo predstavitev zunanjega sveta

- Za upravljanje LLM ni enostavne rešitve

- Strokovnjaki imajo težave z razlago delovanja LLM

- LLM-ji so prav tako sposobni kot ljudje

- Študenti LLM morajo biti več kot le "vester za vse"

- Manekenke so 'pametnejše', kot si ljudje mislijo na podlagi prvega vtisa

LLM-ji so bolj »sposobni«, saj stroški nenehno naraščajo

LLM-ji bodo predvidljivo postali bolj "sposobni" z naraščajočimi stroški, tudi brez kul inovacij. Tu je glavna stvar predvidljivost, kar je bilo prikazano v članku o GPT-4: poučenih je bilo pet do sedem majhnih modelov s proračunom 0.1 % končnega, nato pa je bila na podlagi tega narejena napoved za ogromen model. Za splošno oceno zapletenosti in meritev na podvzorcu ene specifične naloge je bila taka napoved zelo točna. Ta predvidljivost je pomembna za podjetja in organizacije, ki se pri svojem delovanju zanašajo na LLM, saj lahko ustrezno pripravijo proračun in načrtujejo prihodnje stroške. Vendar je pomembno opozoriti, da medtem ko lahko naraščajoči stroški vodijo do izboljšanih zmogljivosti, se lahko stopnja izboljšave sčasoma ustavi, zaradi česar je treba vlagati v nove inovacije, da bi še naprej napredovali.

Hiter pogled na to, kako GPT modeli se prilagajajo z naraščanjem stroškov usposabljanja

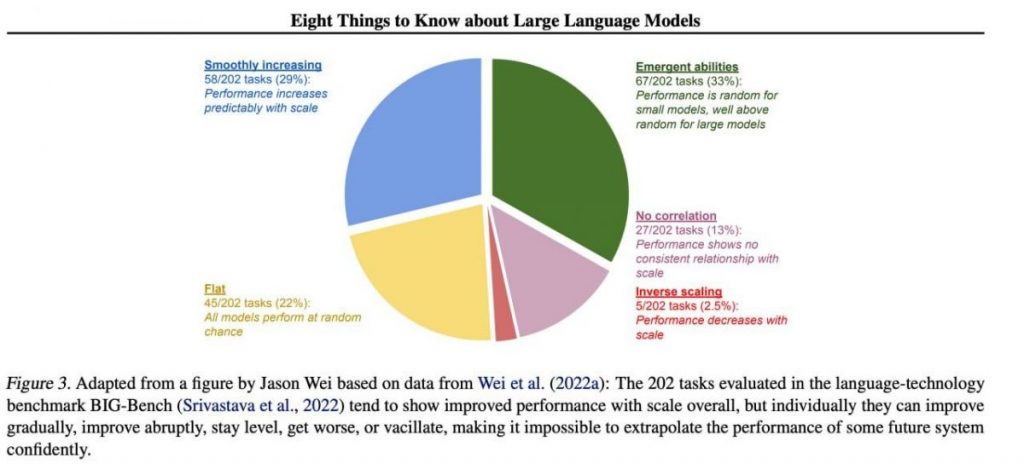

Vendar se posebne pomembne veščine ponavadi nepredvidljivo pojavijo kot stranski produkt naraščanja stroški usposabljanja (daljše usposabljanje, več podatkov, večji model) — skoraj nemogoče je predvideti, kdaj bodo modeli začeli opravljati določene naloge. Temo smo podrobneje raziskali v našem članek o zgodovini razvoja GPT modeli. Slika prikazuje porazdelitev povečanja kakovosti modelov po različnih nalogah. Samo veliki modeli se lahko naučijo opravljati različne naloge. Ta graf poudarja pomemben vpliv povečevanja velikosti GPT modeli na njihovo uspešnost pri različnih nalogah. Vendar je pomembno opozoriti, da je to posledica povečanja računalniških virov in vpliva na okolje.

LLM se naučijo igrati družabne igre z uporabo predstavitev zunanjega sveta

LLM se pogosto učijo in uporabljajo predstavitve zunanjega sveta. Tukaj je veliko primerov in tukaj je eden od njih: Izurjeni modeli igrati družabne igre na podlagi opisov posameznih potez, ne da bi sploh videli sliko igralnega polja, se naučite notranjih predstavitev stanja plošče pri vsaki potezi. Te notranje predstavitve lahko nato uporabite za napovedati prihodnost poteze in rezultate, kar modelu omogoča, da igra igro na visoki ravni. Ta sposobnost učenja in uporabe predstavitev je ključna vidik strojnega učenja in umetna inteligenca.

Za upravljanje LLM ni enostavne rešitve

Ni zanesljivih metod za nadzor obnašanja LLM. Čeprav je bil dosežen določen napredek pri razumevanju in blažitvi različnih težav (vključno z ChatGPT in GPT-4 s pomočjo povratnih informacij), ni soglasja o tem, ali jih lahko rešimo. Vse večja je zaskrbljenost, da bo to v prihodnosti, ko bodo ustvarjeni še večji sistemi, postalo velik, potencialno katastrofalen problem. Zato raziskovalci raziskujejo nove metode za zagotovitev, da so sistemi umetne inteligence usklajeni s človeškimi vrednotami in cilji, kot sta usklajevanje vrednosti in inženiring nagrajevanja. Vendar je zagotavljanje še vedno zahtevna naloga varnost in zanesljivost LLM v zapletenih scenarijih resničnega sveta.

Strokovnjaki imajo težave z razlago delovanja LLM

Strokovnjaki še ne morejo razložiti notranjega delovanja LLM. Nobena tehnika nam ne bi omogočila, da bi na kakršen koli zadovoljiv način navedli, kakšne vrste znanja, sklepanja ali ciljev uporablja model, ko ustvari kakršen koli rezultat. To pomanjkanje razlage vzbuja pomisleke glede zanesljivosti in poštenosti odločitev LLM, zlasti pri aplikacijah z visokimi vložki, kot sta kazensko pravosodje ali kreditno točkovanje. Poudarja tudi potrebo po nadaljnjih raziskavah o razvoju preglednejših in odgovornejših modelov umetne inteligence.

LLM-ji so prav tako sposobni kot ljudje

Čeprav so LLM usposobljeni predvsem za posnemati človeško vedenje pri pisanju besedila, imajo potencial, da nas presežejo v mnogih nalogah. To se vidi že pri igranju šaha ali Goa. To je posledica njihove sposobnosti analiziranja ogromnih količin podatkov in sprejemanja odločitev na podlagi te analize s hitrostjo, ki ji ljudje niso kos. Vendar LLM-ji še vedno nimajo ustvarjalnosti in intuicije, ki jo premore človek, zaradi česar so manj primerni za številne naloge.

Študenti LLM morajo biti več kot le "vester za vse"

LLM-ji ne smejo izražati vrednot svojih ustvarjalcev ali vrednot, zakodiranih v izboru iz interneta. Ne smejo ponavljati stereotipov ali teorij zarote ali poskušati kogar koli užaliti. Namesto tega bi morali biti LLM zasnovani tako, da svojim uporabnikom zagotavljajo nepristranske in dejanske informacije ob spoštovanju kulturnih in družbenih razlik. Poleg tega jih je treba redno testirati in spremljati, da zagotovimo, da še naprej izpolnjujejo te standarde.

Manekenke so 'pametnejše', kot si ljudje mislijo na podlagi prvega vtisa

Ocene sposobnosti modela na podlagi prvega vtisa so pogosto zavajajoče. Zelo pogosto se morate domisliti pravega poziva, predlagati model in morda pokazati primere, in začelo se bo obvladovati veliko bolje. To pomeni, da je "pametnejši", kot se zdi na prvi pogled. Zato je ključnega pomena, da modelu damo pošteno priložnost in mu zagotovimo potrebna sredstva za najboljše delovanje. S pravilnim pristopom nas lahko tudi na videz neustrezni modeli presenetijo s svojimi zmogljivostmi.

Če se osredotočimo na vzorec 202 nalog iz nabora podatkov BIG-Bench (je bil posebej otežen za testiranje jezikovni modeli od in do), potem modeli praviloma (v povprečju) kažejo porast kakovosti z naraščajočo lestvico, posamično pa lahko metrike v nalogah:

- izboljšati postopoma,

- drastično izboljšati,

- ostani nespremenjen,

- zmanjšanje,

- ne kažejo nobene korelacije.

Vse to vodi v nezmožnost zanesljive ekstrapolacije delovanja katerega koli prihodnjega sistema. Posebej zanimiv je zeleni del — ravno tu kazalniki kakovosti brez razloga močno poskočijo navzgor.

Preberite več o AI:

Zavrnitev odgovornosti

V skladu z Smernice projekta Trust, upoštevajte, da informacije na tej strani niso namenjene in se jih ne sme razlagati kot pravni, davčni, naložbeni, finančni ali kakršen koli drug nasvet. Pomembno je, da vlagate samo tisto, kar si lahko privoščite izgubiti, in da poiščete neodvisen finančni nasvet, če imate kakršne koli dvome. Za dodatne informacije predlagamo, da si ogledate določila in pogoje ter strani s pomočjo in podporo, ki jih nudi izdajatelj ali oglaševalec. MetaversePost se zavzema za natančno in nepristransko poročanje, vendar se tržni pogoji lahko spremenijo brez predhodnega obvestila.

O avtorju

Damir je vodja ekipe, produktni vodja in urednik pri Metaverse Post, ki pokriva teme, kot so AI/ML, AGI, LLMs, Metaverse in Web3- sorodna področja. Njegovi članki vsak mesec pritegnejo množično občinstvo več kot milijon uporabnikov. Zdi se, da je strokovnjak z 10-letnimi izkušnjami na področju SEO in digitalnega trženja. Damir je bil omenjen v Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto in druge publikacije. Kot digitalni nomad potuje med ZAE, Turčijo, Rusijo in SND. Damir je diplomiral iz fizike, kar mu je po njegovem mnenju dalo sposobnosti kritičnega razmišljanja, potrebne za uspeh v nenehno spreminjajočem se okolju interneta.

več člankov

Damir je vodja ekipe, produktni vodja in urednik pri Metaverse Post, ki pokriva teme, kot so AI/ML, AGI, LLMs, Metaverse in Web3- sorodna področja. Njegovi članki vsak mesec pritegnejo množično občinstvo več kot milijon uporabnikov. Zdi se, da je strokovnjak z 10-letnimi izkušnjami na področju SEO in digitalnega trženja. Damir je bil omenjen v Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto in druge publikacije. Kot digitalni nomad potuje med ZAE, Turčijo, Rusijo in SND. Damir je diplomiral iz fizike, kar mu je po njegovem mnenju dalo sposobnosti kritičnega razmišljanja, potrebne za uspeh v nenehno spreminjajočem se okolju interneta.