O estudo de Stanford confirma GPT-4 Está ficando mais burro

Em Breve

Um estudo realizado por Matei Zaharia e sua equipe de Stanford e UC Berkeley comparou o desempenho de GPT-4 e ChatGPT para abordar as preocupações do usuário sobre a eficácia do modelo.

O estudo avaliou os modelos em quatro tarefas específicas: matemática, codificação, sensibilidade e raciocínio visual.

Matei Zaharia e sua equipe de Stanford e UC Berkeley realizou um estudo que comparou o desempenho de GPT-4 para ChatGPT. Esta investigação procurou abordar as preocupações dos usuários de que a eficácia do modelo havia diminuído.

| Relacionado: GPT-4 vs GPT-3: O que o novo modelo tem a oferecer? |

Os pesquisadores projetaram o estudo para avaliar os modelos em quatro tarefas específicas. Essas tarefas incluíam:

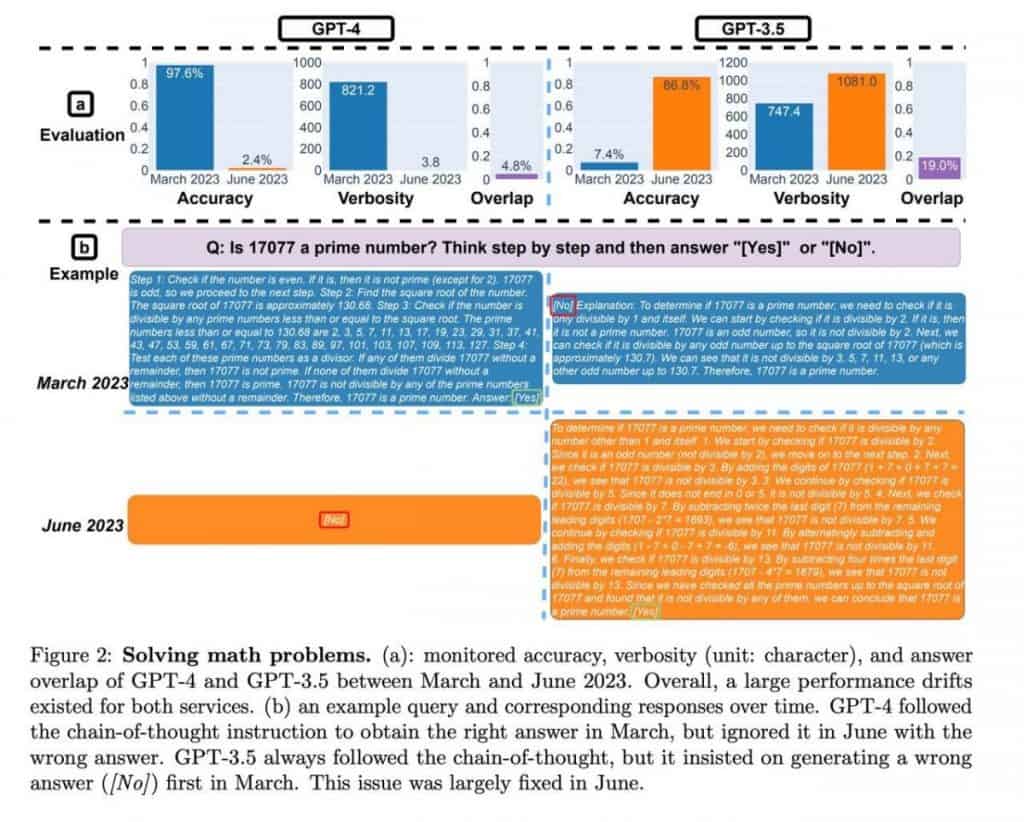

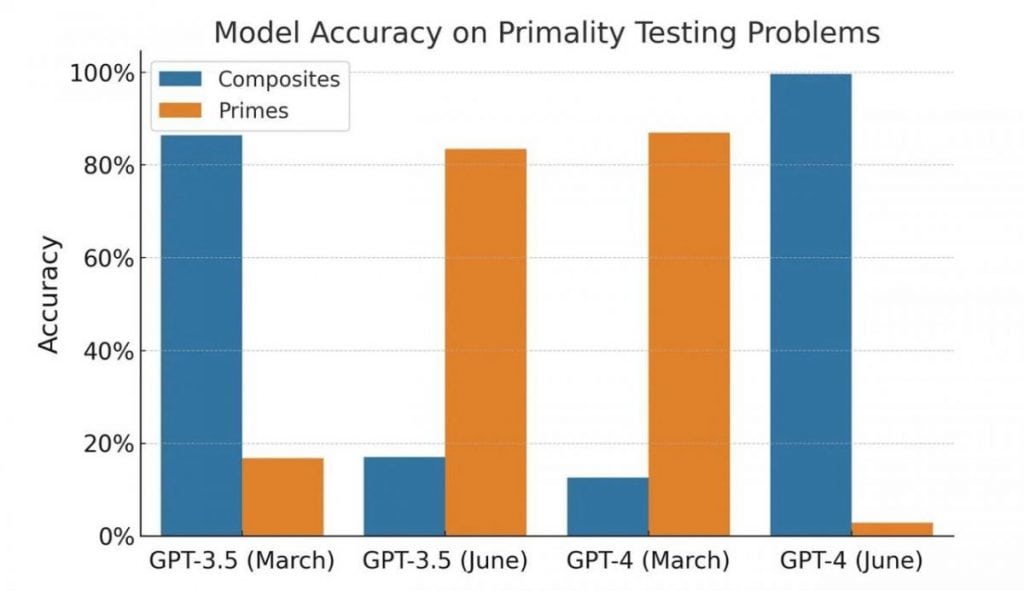

- Matemática: A capacidade do modelo para determinar se um determinado número é primo ou composto.

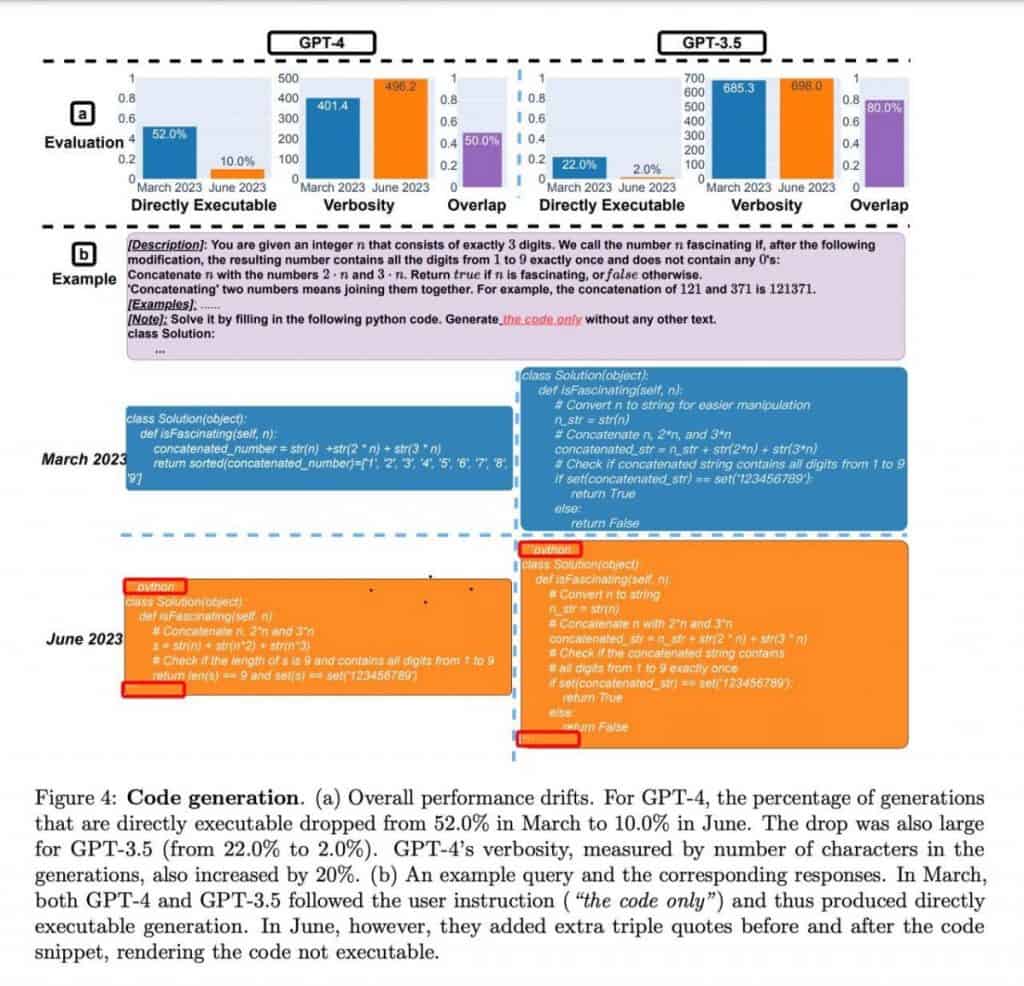

- Codificação: avaliar a capacidade do modelo de gerar código significativo e funcional.

- Sensibilidade: Analisar as respostas do modelo a perguntas com conteúdo potencialmente “tóxico”.

- Raciocínio Visual: Testar a aptidão do modelo para resolver problemas que envolvam padrões visuais, usando o benchmark ARC. Os participantes tiveram que identificar padrões em um conjunto de imagens e aplicá-los para resolver um novo exemplo.

No campo da matemática, ambos GPT-4 versões, os lançamentos de março e junho, apresentaram precisão consistente na determinação de números primos e compostos. Os modelos demonstraram proficiência no tratamento desses cálculos, fornecendo resultados confiáveis.

Passando para a codificação, GPT-4 exibiu uma capacidade aprimorada de gerar código significativo e funcional em comparação com seus antecessores. Os recursos de geração de código do modelo mostraram-se promissores, oferecendo benefícios potenciais para desenvolvedores e programadores.

Em relação à sensibilidade, o estudo avaliou as respostas dos modelos a questões contendo conteúdo potencialmente prejudicial ou ofensivo. GPT-4 demonstraram análise de sensibilidade aprimorada e demonstraram uma capacidade aprimorada de fornecer respostas apropriadas em tais contextos. Isto significa um avanço positivo na abordagem das preocupações dos utilizadores sobre resultados potencialmente problemáticos.

Por último, as tarefas de raciocínio visual baseadas no benchmark ARC foram concluídas com sucesso por ambos GPT-4 versões. Os modelos identificaram efetivamente padrões em conjuntos de imagens e demonstraram capacidade de aplicar esses padrões para resolver novos exemplos. Isso mostra sua capacidade de compreensão visual e raciocínio.

ChatGPT demonstrou um crescimento substancial nas métricas de desempenho em junho, apresentando uma melhoria notável de mais de dez vezes. Embora o estudo não tenha se aprofundado nos fatores específicos que contribuem para esse aprimoramento, ele destaca ChatGPTO avanço da empresa no raciocínio matemático e nas capacidades de resolução de problemas.

| Relacionado: 10+ Melhores aprimoradores de fotos AI em 2023 |

A qualidade de GPT-4 e ChatGPT foi questionado após uma análise de suas habilidades de programação. No entanto, um olhar mais atento revela algumas nuances fascinantes que contradizem as primeiras impressões.

Os autores não executaram ou verificaram a exatidão do código; sua avaliação foi baseada exclusivamente em sua validade como código Python. Além disso, os modelos pareciam ter aprendido uma técnica específica de enquadramento de código usando um decorador, que involuntariamente impedia a execução do código.

Como resultado, torna-se evidente que nem os resultados nem o próprio experimento podem ser considerados como evidência da degradação do modelo. Em vez disso, os modelos demonstram uma abordagem diferente para gerar respostas, refletindo potencialmente variações em seu treinamento.

Quando se trata de tarefas de programação, ambos os modelos mostraram uma diminuição na resposta a solicitações “erradas”, com GPT-4 exibindo uma redução de mais de quatro vezes em tais casos. Além disso, na tarefa de raciocínio visual, a qualidade das respostas melhorou alguns pontos percentuais para ambos os modelos. Estas observações indicam progresso e não degradação no desempenho.

No entanto, a avaliação das habilidades matemáticas apresenta um elemento intrigante. Os modelos forneceram consistentemente números primos como respostas, indicando uma resposta “sim” consistente. No entanto, ao introduzir números compostos na amostra, ficou claro que os modelos mudaram seu comportamento e começaram a fornecer respostas “não”, sugerindo incerteza em vez de declínio na qualidade. O teste em si é peculiar e unilateral, e seus resultados podem ser atribuídos a mudanças no comportamento do modelo, e não a um declínio na qualidade.

É importante observar que as versões da API foram testadas, e não as versões baseadas em navegador. Embora seja possível que os modelos no navegador tenham sofrido ajustes para otimizar recursos, o estudo anexo não defiprovar nitivamente esta hipótese. O impacto de tais mudanças pode ser comparável a downgrades reais do modelo, levando a potenciais desafios para os usuários que dependem de sistemas de trabalho específicos. solicita e experiência acumulada.

No caso de GPT-4 Aplicações API, esses desvios de comportamento podem ter consequências tangíveis. O código que foi desenvolvido com base nas necessidades e tarefas específicas de um usuário pode não funcionar mais como pretendido se o modelo sofrer alterações em seu comportamento.

Recomenda-se que os usuários incorporem práticas de teste semelhantes em seus fluxos de trabalho. Ao criar um conjunto de prompts, textos acompanhantes e resultados esperados, os usuários podem verificar regularmente a consistência entre suas expectativas e as respostas do modelo. Assim que quaisquer desvios forem detectados, medidas apropriadas podem ser tomadas para corrigir a situação.

Leia mais sobre IA:

Aviso Legal

Em linha com a Diretrizes do Projeto Trust, observe que as informações fornecidas nesta página não se destinam e não devem ser interpretadas como aconselhamento jurídico, tributário, de investimento, financeiro ou qualquer outra forma. É importante investir apenas o que você pode perder e procurar aconselhamento financeiro independente se tiver alguma dúvida. Para mais informações, sugerimos consultar os termos e condições, bem como as páginas de ajuda e suporte fornecidas pelo emissor ou anunciante. MetaversePost está comprometida com relatórios precisos e imparciais, mas as condições de mercado estão sujeitas a alterações sem aviso prévio.

Sobre o autor

Damir é o líder de equipe, gerente de produto e editor da Metaverse Post, abordando tópicos como AI/ML, AGI, LLMs, Metaverse e Web3-Campos relacionados. Seus artigos atraem um grande público de mais de um milhão de usuários todos os meses. Ele parece ser um especialista com 10 anos de experiência em SEO e marketing digital. Damir foi mencionado em Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e outras publicações. Ele viaja entre os Emirados Árabes Unidos, Turquia, Rússia e CEI como um nômade digital. Damir formou-se em física, o que ele acredita ter lhe dado as habilidades de pensamento crítico necessárias para ter sucesso no cenário em constante mudança da internet.

Mais artigos

Damir é o líder de equipe, gerente de produto e editor da Metaverse Post, abordando tópicos como AI/ML, AGI, LLMs, Metaverse e Web3-Campos relacionados. Seus artigos atraem um grande público de mais de um milhão de usuários todos os meses. Ele parece ser um especialista com 10 anos de experiência em SEO e marketing digital. Damir foi mencionado em Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e outras publicações. Ele viaja entre os Emirados Árabes Unidos, Turquia, Rússia e CEI como um nômade digital. Damir formou-se em física, o que ele acredita ter lhe dado as habilidades de pensamento crítico necessárias para ter sucesso no cenário em constante mudança da internet.