8 coisas que você deve saber sobre modelos de linguagem grandes

Em Breve

Grandes modelos de linguagem (LLMs) são usados para explorar as nuances da linguagem natural, melhorar a capacidade das máquinas de compreender e gerar texto e automatizar tarefas como reconhecimento de voz e tradução automática.

Não existe uma solução fácil para gerenciar LLMs, mas eles são tão capazes quanto os humanos.

Com um aumento no desenvolvimento do processamento de linguagem natural e seu uso nos negócios, há um interesse crescente em grandes modelos de linguagem. Esses modelos são usados para explorar as nuances da linguagem natural, melhorar a capacidade das máquinas de compreender e gerar texto e automatizar tarefas como reconhecimento de voz e tradução automática. Aqui estão oito coisas essenciais que você deve saber sobre modelos de linguagem grandes (LLM).

- Os LLMs são mais “capazes” à medida que os custos continuam aumentando

- Uma rápida olhada em como GPT modelos se adaptam à medida que os custos de treinamento aumentam

- Os LLMs aprendem a jogar jogos de tabuleiro usando representações do mundo exterior

- Não há solução fácil para gerenciar o LLM

- Especialistas têm dificuldade em explicar como funciona o LLM

- Os LLMs são tão capazes quanto os humanos

- Os LLMs devem ser mais do que apenas "pau para toda obra"

- Modelos são 'mais inteligentes' do que as pessoas pensam com base nas primeiras impressões

Os LLMs são mais “capazes” à medida que os custos continuam aumentando

Os LLMs previsivelmente se tornam mais “capazes” com custos crescentes, mesmo sem inovações bacanas. O principal aqui é a previsibilidade, que foi mostrada no artigo sobre GPT-4: cinco a sete modelos pequenos foram ensinados com um orçamento de 0.1% do final e, a partir disso, foi feita uma previsão para um modelo enorme. Para uma avaliação geral de perplexidade e métricas em uma subamostra de uma tarefa específica, essa previsão foi muito precisa. Essa previsibilidade é importante para empresas e organizações que dependem de LLMs para suas operações, pois podem orçar adequadamente e planejar despesas futuras. No entanto, é importante observar que, embora o aumento dos custos possa levar a melhores capacidades, a taxa de melhoria pode eventualmente se estabilizar, tornando necessário investir em novas inovações para continuar avançando.

Uma rápida olhada em como GPT modelos se adaptam à medida que os custos de treinamento aumentam

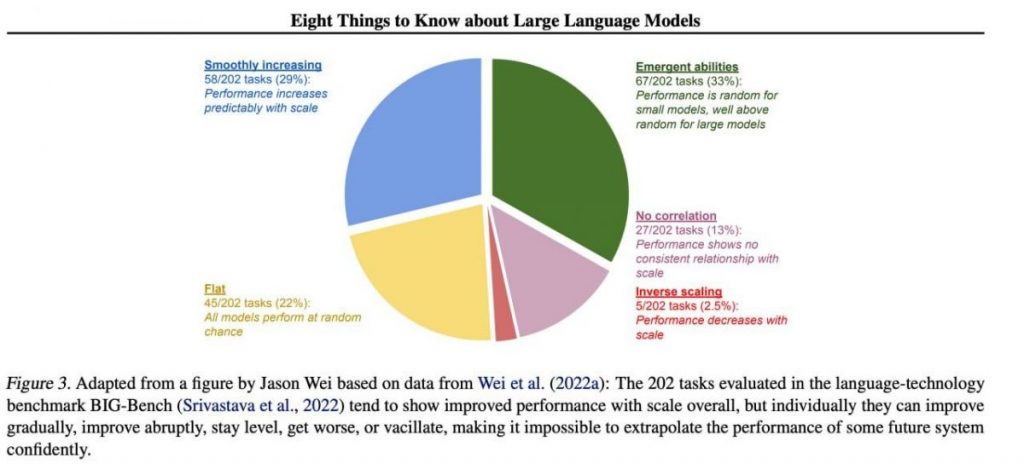

No entanto, habilidades específicas importantes tendem a surgir de forma imprevisível como um subproduto do aumento custos de treinamento (treinamento mais longo, mais dados, modelo maior) — é quase impossível prever quando os modelos começarão a executar determinadas tarefas. Exploramos o tema com mais profundidade em nosso artigo sobre a história do desenvolvimento de GPT modelos. A imagem mostra a distribuição do aumento na qualidade dos modelos em diferentes tarefas. Somente os grandes modelos podem aprender a realizar diversas tarefas. Este gráfico destaca o impacto significativo do aumento do tamanho do GPT modelos em seu desempenho em várias tarefas. No entanto, é importante observar que isso ocorre com o custo de aumento de recursos computacionais e impacto ambiental.

Os LLMs aprendem a jogar jogos de tabuleiro usando representações do mundo exterior

Os LLMs geralmente aprendem e usam representações do mundo exterior. Existem muitos exemplos aqui, e aqui está um deles: Modelos treinados jogar jogos de tabuleiro baseados em descrições de movimentos individuais, sem nunca ver uma imagem do campo de jogo, aprender representações internas do estado do tabuleiro em cada movimento. Essas representações internas podem então ser usadas para prever o futuro movimentos e resultados, permitindo que o modelo jogue em um alto nível. Esta capacidade de aprender e usar representações é fundamental aspecto do aprendizado de máquina e inteligência artificial.

Não há solução fácil para gerenciar o LLM

Não há métodos confiáveis para controlar o comportamento do LLM. Embora tenha havido algum progresso na compreensão e mitigação de vários problemas (incluindo ChatGPT e GPT-4 com a ajuda do feedback), não há consenso sobre se podemos resolvê-los. Há uma preocupação crescente de que isso se tornará um problema enorme e potencialmente catastrófico no futuro, quando sistemas ainda maiores forem criados. Portanto, os investigadores estão a explorar novos métodos para garantir que os sistemas de IA se alinham com os valores e objetivos humanos, tais como alinhamento de valores e engenharia de recompensas. Contudo, continua a ser uma tarefa difícil garantir a segurança e confiabilidade de LLMs em cenários complexos do mundo real.

Especialistas têm dificuldade em explicar como funciona o LLM

Os especialistas ainda não conseguem interpretar o funcionamento interno do LLM. Nenhuma técnica nos permitiria afirmar de maneira satisfatória quais tipos de conhecimento, raciocínio ou objetivos o modelo usa quando gera qualquer resultado. Essa falta de interpretabilidade levanta preocupações sobre a confiabilidade e justiça das decisões do LLM, especialmente em aplicações de alto risco, como justiça criminal ou pontuação de crédito. Também destaca a necessidade de mais pesquisas sobre o desenvolvimento de modelos de IA mais transparentes e responsáveis.

Os LLMs são tão capazes quanto os humanos

Embora os LLMs sejam treinados principalmente para imitar o comportamento humano ao escrever um texto, eles têm potencial para nos superar em muitas tarefas. Isso já pode ser visto ao jogar xadrez ou Go. Isto se deve à sua capacidade de analisar grandes quantidades de dados e tomar decisões com base nessa análise a uma velocidade que os humanos não conseguem igualar. No entanto, os LLMs ainda carecem da criatividade e da intuição que os humanos possuem, o que os torna menos adequados para muitas tarefas.

Os LLMs devem ser mais do que apenas "pau para toda obra"

Os LLMs não devem expressar os valores de seus criadores ou os valores codificados em uma seleção da Internet. Eles não devem repetir estereótipos ou teorias da conspiração ou tentar ofender alguém. Em vez disso, os LLMs devem ser projetados para fornecer informações imparciais e factuais a seus usuários, respeitando as diferenças culturais e sociais. Além disso, eles devem passar por testes e monitoramento regulares para garantir que continuem a atender a esses padrões.

Modelos são 'mais inteligentes' do que as pessoas pensam com base nas primeiras impressões

As estimativas da capacidade de um modelo com base nas primeiras impressões costumam ser enganosas. Muitas vezes, você precisa apresentar o prompt certo, sugerir um modelo e talvez mostrar exemplos, e ele começará a funcionar muito melhor. Ou seja, é “mais inteligente” do que parece à primeira vista. Portanto, é crucial dar uma chance justa ao modelo e fornecer a ele os recursos necessários para ter o melhor desempenho. Com a abordagem correta, mesmo modelos aparentemente inadequados podem nos surpreender com suas capacidades.

Se nos concentrarmos em uma amostra de 202 tarefas do conjunto de dados BIG-Bench (foi especialmente difícil de testar modelos de linguagem de e para), então via de regra (em média) os modelos apresentam aumento de qualidade com o aumento da escala, mas individualmente as métricas nas tarefas podem:

- melhorar gradualmente,

- melhorar drasticamente,

- permanece inalterado,

- diminuir,

- não apresentam correlação.

Tudo isso leva à impossibilidade de extrapolar com segurança o desempenho de qualquer sistema futuro. A parte verde é especialmente interessante - é exatamente aqui que os indicadores de qualidade aumentam acentuadamente sem motivo algum.

Leia mais sobre IA:

Aviso Legal

Em linha com a Diretrizes do Projeto Trust, observe que as informações fornecidas nesta página não se destinam e não devem ser interpretadas como aconselhamento jurídico, tributário, de investimento, financeiro ou qualquer outra forma. É importante investir apenas o que você pode perder e procurar aconselhamento financeiro independente se tiver alguma dúvida. Para mais informações, sugerimos consultar os termos e condições, bem como as páginas de ajuda e suporte fornecidas pelo emissor ou anunciante. MetaversePost está comprometida com relatórios precisos e imparciais, mas as condições de mercado estão sujeitas a alterações sem aviso prévio.

Sobre o autor

Damir é o líder de equipe, gerente de produto e editor da Metaverse Post, abordando tópicos como AI/ML, AGI, LLMs, Metaverse e Web3-Campos relacionados. Seus artigos atraem um grande público de mais de um milhão de usuários todos os meses. Ele parece ser um especialista com 10 anos de experiência em SEO e marketing digital. Damir foi mencionado em Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e outras publicações. Ele viaja entre os Emirados Árabes Unidos, Turquia, Rússia e CEI como um nômade digital. Damir formou-se em física, o que ele acredita ter lhe dado as habilidades de pensamento crítico necessárias para ter sucesso no cenário em constante mudança da internet.

Mais artigos

Damir é o líder de equipe, gerente de produto e editor da Metaverse Post, abordando tópicos como AI/ML, AGI, LLMs, Metaverse e Web3-Campos relacionados. Seus artigos atraem um grande público de mais de um milhão de usuários todos os meses. Ele parece ser um especialista com 10 anos de experiência em SEO e marketing digital. Damir foi mencionado em Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e outras publicações. Ele viaja entre os Emirados Árabes Unidos, Turquia, Rússia e CEI como um nômade digital. Damir formou-se em física, o que ele acredita ter lhe dado as habilidades de pensamento crítico necessárias para ter sucesso no cenário em constante mudança da internet.