Badanie Stanforda potwierdza GPT-4 Robi się coraz głupszy

W skrócie

W badaniu przeprowadzonym przez Matei Zaharię i jego zespół ze Stanford i Uniwersytetu Kalifornijskiego w Berkeley porównano wydajność GPT-4 i ChatGPT aby odpowiedzieć na obawy użytkowników dotyczące skuteczności modelu.

W badaniu oceniono modele pod kątem czterech konkretnych zadań: matematyki, kodowania, wrażliwości i rozumowania wizualnego.

Matei Zaharia i jego zespół ze Stanford i UC Berkeley przeprowadził badanie który porównał wydajność GPT-4 do ChatGPT. Dochodzenie to miało na celu rozwianie obaw użytkowników, że skuteczność modelu spadła.

Naukowcy zaprojektowali badanie w celu oceny modeli pod kątem czterech konkretnych zadań. Zadania te obejmowały:

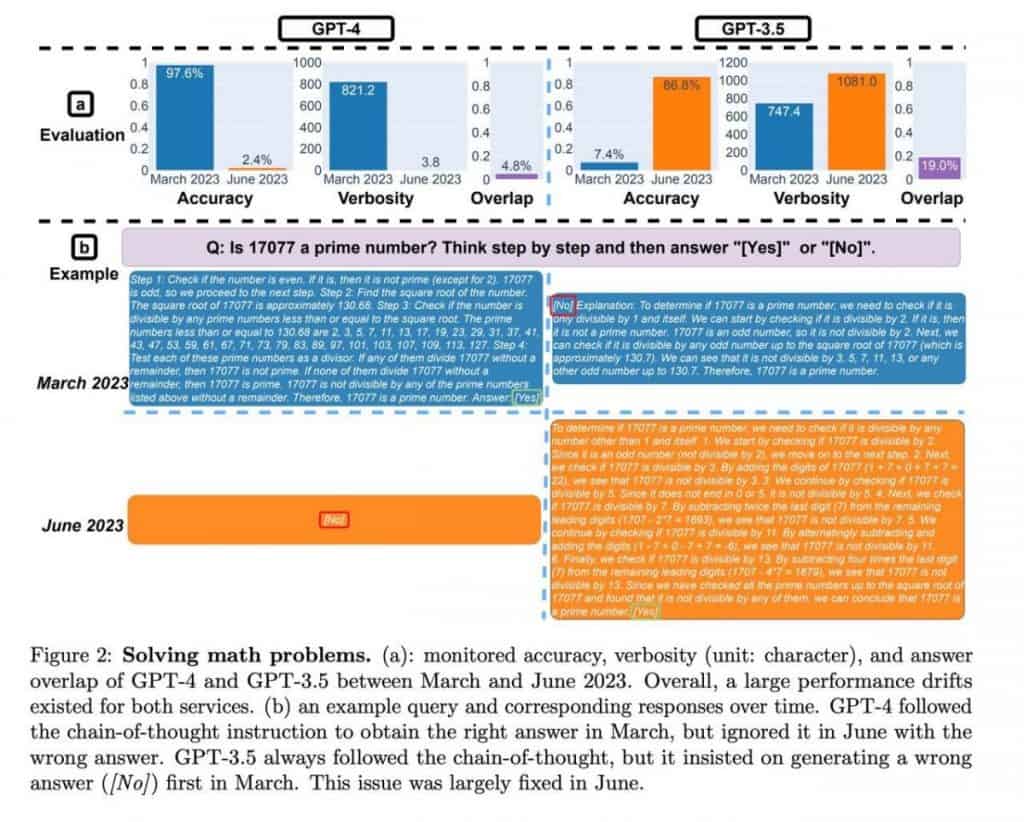

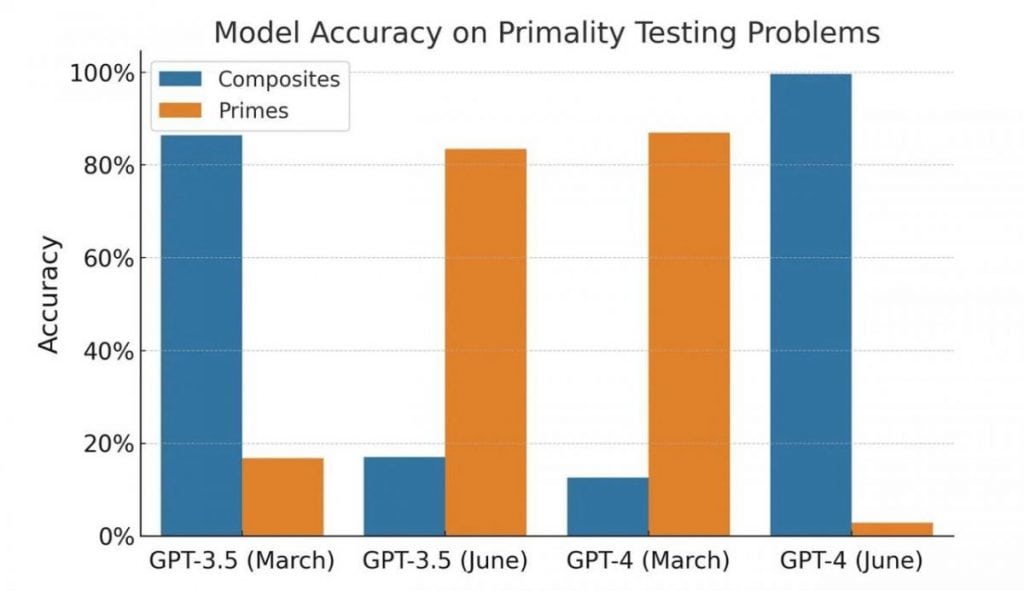

- Matematyka: Zdolność modelu do określenia, czy dana liczba jest liczbą pierwszą, czy złożoną.

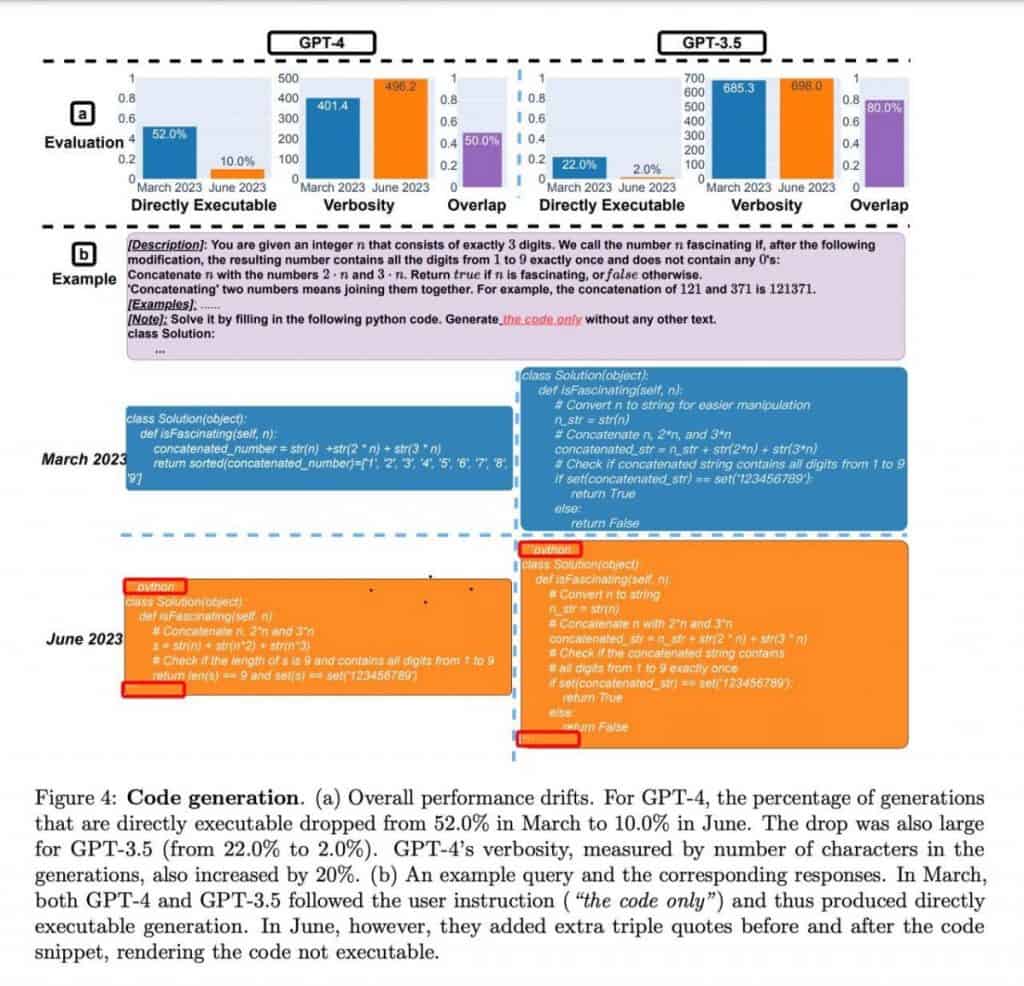

- Kodowanie: ocena zdolności modelu do generowania sensownego i funkcjonalnego kodu.

- Czułość: Analiza odpowiedzi modelki na pytania o potencjalnie „toksycznej” treści.

- Rozumowanie wizualne: Testowanie zdolności modelu do rozwiązywania problemów związanych z wzorcami wizualnymi za pomocą testu porównawczego ARC. Uczestnicy musieli zidentyfikować wzorce w zestawie obrazów i zastosować je do rozwiązania nowego przykładu.

W matematyce jedno i drugie GPT-4 wersje, czyli wydania z marca i czerwca, wykazały stałą dokładność w określaniu liczb pierwszych i złożonych. Modele wykazały się biegłością w obsłudze tych obliczeń, zapewniając wiarygodne wyniki.

Przejdźmy do kodowania, GPT-4 wykazał lepszą zdolność do generowania znaczącego i funkcjonalnego kodu w porównaniu do swoich poprzedników. Możliwości generowania kodu modelu okazały się obiecujące, oferując potencjalne korzyści programistom i programistom.

Jeśli chodzi o wrażliwość, w badaniu oceniano odpowiedzi modelek na pytania zawierające treści potencjalnie szkodliwe lub obraźliwe. GPT-4 wykazał ulepszoną analizę wrażliwości i wykazał lepszą zdolność do zapewniania odpowiednich odpowiedzi w takich kontekstach. Oznacza to pozytywny krok naprzód w rozwianiu obaw użytkowników dotyczących potencjalnie problematycznych wyników.

Na koniec obaj pomyślnie wykonali zadania polegające na rozumowaniu wizualnym w oparciu o test porównawczy ARC GPT-4 wersje. Modele skutecznie zidentyfikowały wzorce w zestawach obrazów i wykazały umiejętność zastosowania tych wzorców do rozwiązywania nowych przykładów. To pokazuje ich zdolność do wizualnego zrozumienia i rozumowania.

ChatGPT wykazał znaczny wzrost wskaźników wydajności do czerwca, wykazując niezwykłą poprawę ponad dziesięciokrotną. Chociaż badanie nie zagłębiało się w konkretne czynniki przyczyniające się do tego ulepszenia, podkreśla ChatGPTpostęp w rozumowaniu matematycznym i zdolnościach rozwiązywania problemów.

Jakość GPT-4 i ChatGPT został przesłuchany po analizie ich umiejętności programistycznych. Jednak bliższe przyjrzenie się ujawnia kilka fascynujących niuansów, które przeczą pierwszemu wrażeniu.

Autorzy nie wykonali ani nie zweryfikowali poprawności kodu; ich ocena opierała się wyłącznie na jego ważności jako kodu Pythona. Ponadto wydawało się, że modele nauczyły się określonej techniki kadrowania kodu przy użyciu dekoratora, co nieumyślnie utrudniało wykonanie kodu.

W rezultacie staje się jasne, że ani wyniki, ani sam eksperyment nie mogą być uznane za dowód degradacji modelu. Zamiast tego modele demonstrują inne podejście do generowania odpowiedzi, potencjalnie odzwierciedlając różnice w ich szkoleniu.

Jeśli chodzi o zadania programistyczne, oba modele wykazały spadek reakcji na „złe” podpowiedzi, m.in GPT-4 wykazując w takich przypadkach ponad czterokrotny spadek. Dodatkowo w zadaniu „Wizualne rozumowanie” jakość odpowiedzi poprawiła się o kilka punktów procentowych w obu modelach. Obserwacje te wskazują raczej na postęp niż na pogorszenie wydajności.

Jednak ocena umiejętności matematycznych wprowadza intrygujący element. Modele konsekwentnie podawały liczby pierwsze jako odpowiedzi, wskazując na spójną odpowiedź „tak”. Jednak po wprowadzeniu liczb złożonych do próby stało się jasne, że modele zmieniły swoje zachowanie i zaczęły udzielać odpowiedzi „nie”, sugerując raczej niepewność niż spadek jakości. Sam test jest osobliwy i jednostronny, a jego wyniki można przypisać zmianom w zachowaniu modelu, a nie spadkowi jakości.

Należy zauważyć, że testowano wersje API, a nie wersje oparte na przeglądarce. Chociaż możliwe jest, że modele w przeglądarce zostały dostosowane w celu optymalizacji zasobów, załączone badanie tego nie robi defimerytorycznie udowodnij tę hipotezę. Wpływ takich zmian może być porównywalny z faktycznym obniżeniem wersji modelu, co może prowadzić do potencjalnych wyzwań dla użytkowników polegających na określonej pracy monity i zgromadzone doświadczenie.

W przypadku GPT-4 W przypadku aplikacji API te odchylenia w zachowaniu mogą mieć wymierne konsekwencje. Kod, który został stworzony w oparciu o konkretne potrzeby i zadania użytkownika, może przestać działać zgodnie z zamierzeniami, jeśli model ulegnie zmianom w swoim zachowaniu.

Zaleca się, aby użytkownicy włączyli podobne praktyki testowania do swoich przepływów pracy. Tworząc zestaw podpowiedzi, towarzyszących im tekstów i oczekiwanych rezultatów, użytkownicy mogą regularnie sprawdzać zgodność swoich oczekiwań z odpowiedziami modelu. Gdy tylko zostaną wykryte jakiekolwiek odchylenia, można podjąć odpowiednie środki w celu naprawienia sytuacji.

Przeczytaj więcej o sztucznej inteligencji:

Odpowiedzialność

Zgodnie z Zaufaj wytycznym projektu, należy pamiętać, że informacje zawarte na tej stronie nie mają na celu i nie powinny być interpretowane jako porady prawne, podatkowe, inwestycyjne, finansowe lub jakiekolwiek inne formy porad. Ważne jest, aby inwestować tylko tyle, na utratę czego możesz sobie pozwolić, a w przypadku jakichkolwiek wątpliwości zasięgnąć niezależnej porady finansowej. Aby uzyskać więcej informacji, sugerujemy zapoznać się z warunkami oraz stronami pomocy i wsparcia udostępnianymi przez wydawcę lub reklamodawcę. MetaversePost zobowiązuje się do sporządzania dokładnych i bezstronnych raportów, jednakże warunki rynkowe mogą ulec zmianie bez powiadomienia.

O autorze

Damir jest liderem zespołu, menedżerem produktu i redaktorem w Metaverse Post, obejmujący takie tematy, jak AI/ML, AGI, LLM, Metaverse i Web3-pokrewne pola. Jego artykuły przyciągają każdego miesiąca ogromną publiczność, liczącą ponad milion użytkowników. Wydaje się być ekspertem z 10-letnim doświadczeniem w SEO i marketingu cyfrowym. Damir został wspomniany w Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i inne publikacje. Jako cyfrowy koczownik podróżuje między ZEA, Turcją, Rosją i WNP. Damir uzyskał tytuł licencjata z fizyki, co jego zdaniem dało mu umiejętności krytycznego myślenia potrzebne do odniesienia sukcesu w ciągle zmieniającym się środowisku internetowym.

Więcej artykułów

Damir jest liderem zespołu, menedżerem produktu i redaktorem w Metaverse Post, obejmujący takie tematy, jak AI/ML, AGI, LLM, Metaverse i Web3-pokrewne pola. Jego artykuły przyciągają każdego miesiąca ogromną publiczność, liczącą ponad milion użytkowników. Wydaje się być ekspertem z 10-letnim doświadczeniem w SEO i marketingu cyfrowym. Damir został wspomniany w Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i inne publikacje. Jako cyfrowy koczownik podróżuje między ZEA, Turcją, Rosją i WNP. Damir uzyskał tytuł licencjata z fizyki, co jego zdaniem dało mu umiejętności krytycznego myślenia potrzebne do odniesienia sukcesu w ciągle zmieniającym się środowisku internetowym.