Stability AI'S Stable Diffusion 2 Algorytm jest wreszcie publiczny: nowy model deep2img, skalowanie super rozdzielczości, brak treści dla dorosłych

W skrócie

Stable Diffusion Model 2.0 jest szybszy, open source, skalowalny, bardziej niezawodny niż poprzedni

Stable Diffusion jest gotowy na GPU dzięki nowym funkcjom renderowania w czasie rzeczywistym

Naprowadzanie na głębokość stable diffusion model – Image-to-image z nowymi pomysłami na kreatywne zastosowania

Stability AI ma wydany nowy artykuł na swoim blogu nt Stable Diffusion 2. W nim Stability AI proponuje nowy algorytm, który jest bardziej wydajny i solidny niż poprzedni, porównując go z innymi najnowocześniejszymi metodami.

Oryginał CompVis Stable Diffusion Model V1 zrewolucjonizował charakter open source Modele AI i wyprodukował setki różnych modeli i postępów na całym świecie. Widział jedną z najszybszych wspinaczek do 10,000 33,000 gwiazd Github, gromadząc XNUMX XNUMX w mniej niż dwa miesiące, szybciej niż więcej programów na Github.

Oryginał Stable Diffusion Wersja V1 była prowadzona przez dynamiczny zespół Robina Rombacha (Stability AI) i Patrick Esser (Runway ML) z CompVis Group w LMU Monachium, kierowany przez prof. dr Björna Ommera. Opierali się na wcześniejszej pracy laboratorium z Latent Modele dyfuzyjne i otrzymał krytyczne wsparcie od LAION i Eleuther AI.

Co sprawia, że Stable Diffusion v1 różni się od Stable Diffusion v2?

Stable Diffusion Wersja 2.0 zawiera wiele znaczących ulepszeń i funkcji w stosunku do poprzedniej wersji, więc przyjrzyjmy się im.

Połączenia Stable Diffusion Wersja 2.0 zawiera solidne modele zamiany tekstu na obraz przeszkolone przy użyciu świeżego, nowego kodera tekstu (OpenCLIP) opracowanego przez firmę LAION przy pomocy Stability AI, co znacznie poprawia jakość wygenerowane obrazy w stosunku do poprzednich wersji V1. Modele zamiany tekstu na obraz w tej wersji mogą generować obrazy w domyślnych rozdzielczościach 512×512 pikseli i 768×768 pikseli.

Modele te są trenowane przy użyciu estetycznego podzbioru zbioru danych LAION-5B generowanego przez Stability AIzespołu DeepFloyd, który jest następnie filtrowany w celu wykluczenia treści dla dorosłych za pomocą filtra NSFW firmy LAION.

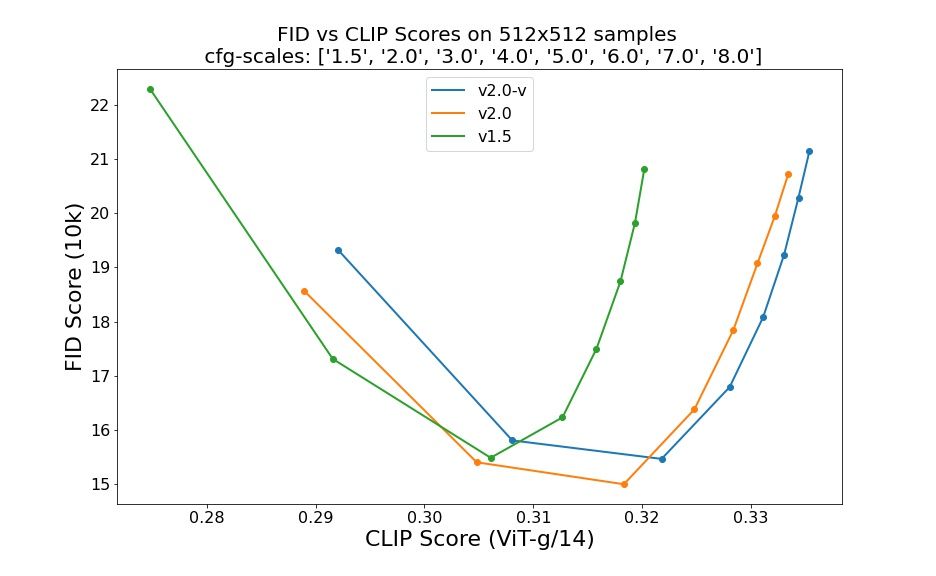

Oceny z wykorzystaniem 50 próbnych kroków DDIM, 50 skal przewodnich bez klasyfikatorów oraz 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 i 8.0 wskazują na względną poprawę punktów kontrolnych:

Stable Diffusion Wersja 2.0 zawiera teraz model Upscaler Diffusion, który zwiększa rozdzielczość obrazu czterokrotnie. Przykład naszego modelu skalowanie poniżej pokazano wygenerowany obraz o niskiej jakości (128×128) w obrazie o wyższej rozdzielczości (512×512). Stable Diffusion 2.0, w połączeniu z naszymi modelami zamiany tekstu na obraz, może teraz generować obrazy o rozdzielczości 2048×2048 lub wyższej.

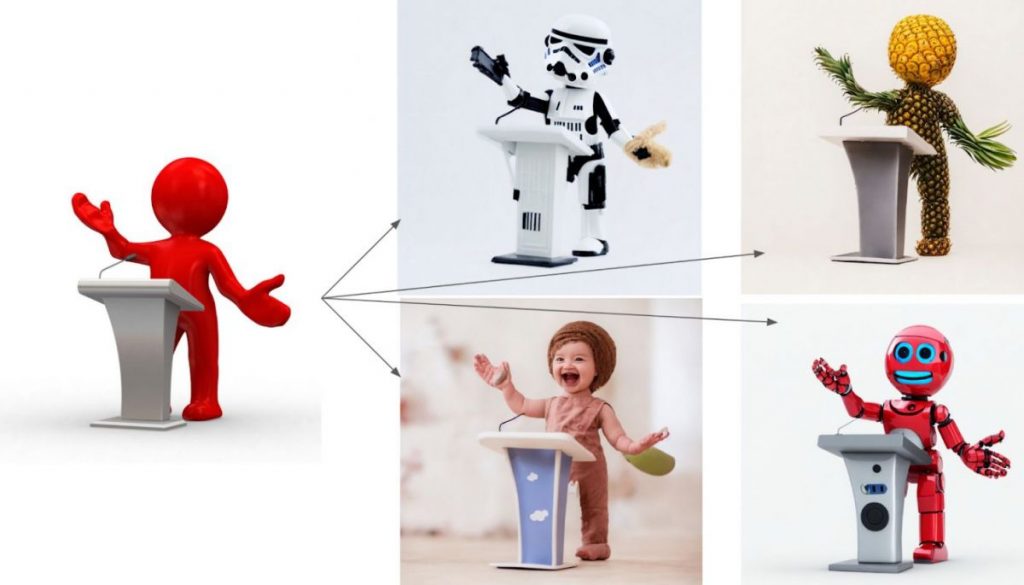

Nowa głębokość prowadzenia stable diffusion model, deep2img, rozszerza poprzednią funkcję obrazu do obrazu z wersji 1 o zupełnie nowe możliwości twórcze. Depth2img określa głębokość obrazu wejściowego (przy użyciu istniejącego modelu), a następnie generuje nowy zdjęcia na podstawie zarówno tekstu, jak i informacji o głębokości. Depth-to-Image może zapewnić mnóstwo nowych kreatywnych aplikacji, oferując zmiany, które wydają się znacznie różnić od oryginału, przy jednoczesnym zachowaniu spójności i głębi obrazu.

Co nowego w Stable Diffusion 2?

- Nowa stable diffusion model oferuje rozdzielczość 768×768.

- U-Net ma taką samą liczbę parametrów jak wersja 1.5, ale jest szkolony od podstaw i używa OpenCLIP-ViT/H jako kodera tekstu. Tak zwany model predykcji v to SD 2.0-v.

- Wspomniany model został dostosowany z SD 2.0-base, który również jest udostępniony i został wytrenowany jako typowy model przewidywania szumów na obrazach 512×512.

- Dodano model dyfuzji kierowany tekstem ukrytym ze skalowaniem x4.

- Udoskonalone prowadzenie na głębokość SD 2.0 stable diffusion model. Model można wykorzystać do zachowania struktury img2img i syntezy warunkowej kształtu i jest on zależny od szacunków głębokości jednoocznych wydedukowanych przez MiDaS.

- Ulepszony model malowania z przewodnikiem tekstowym zbudowany na fundamencie SD 2.0.

Deweloperzy ciężko pracowali, podobnie jak początkowa iteracja Stable Diffusion, aby zoptymalizować model do działania na jednym GPU — od samego początku chcieli udostępnić go jak największej liczbie osób. Widzieli już, co się dzieje, gdy miliony osób dostają w swoje ręce te modele i współpracują przy tworzeniu absolutnie niezwykłych rzeczy. Na tym polega siła otwartego oprogramowania: wykorzystanie ogromnego potencjału milionów utalentowanych ludzi, którzy mogą nie mieć zasobów, aby wyszkolić najnowocześniejszy model, ale mają możliwość robienia z nim niesamowitych rzeczy.

Ta nowa aktualizacja, w połączeniu z potężnymi nowymi funkcjami, takimi jak deep2img i lepsze możliwości skalowania rozdzielczości, posłuży jako podstawa dla mnóstwa nowych aplikacji i umożliwi eksplozję nowego potencjału twórczego.

Przeczytaj Więcej Stable Diffusion:

Odpowiedzialność

Zgodnie z Zaufaj wytycznym projektu, należy pamiętać, że informacje zawarte na tej stronie nie mają na celu i nie powinny być interpretowane jako porady prawne, podatkowe, inwestycyjne, finansowe lub jakiekolwiek inne formy porad. Ważne jest, aby inwestować tylko tyle, na utratę czego możesz sobie pozwolić, a w przypadku jakichkolwiek wątpliwości zasięgnąć niezależnej porady finansowej. Aby uzyskać więcej informacji, sugerujemy zapoznać się z warunkami oraz stronami pomocy i wsparcia udostępnianymi przez wydawcę lub reklamodawcę. MetaversePost zobowiązuje się do sporządzania dokładnych i bezstronnych raportów, jednakże warunki rynkowe mogą ulec zmianie bez powiadomienia.

O autorze

Damir jest liderem zespołu, menedżerem produktu i redaktorem w Metaverse Post, obejmujący takie tematy, jak AI/ML, AGI, LLM, Metaverse i Web3-pokrewne pola. Jego artykuły przyciągają każdego miesiąca ogromną publiczność, liczącą ponad milion użytkowników. Wydaje się być ekspertem z 10-letnim doświadczeniem w SEO i marketingu cyfrowym. Damir został wspomniany w Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i inne publikacje. Jako cyfrowy koczownik podróżuje między ZEA, Turcją, Rosją i WNP. Damir uzyskał tytuł licencjata z fizyki, co jego zdaniem dało mu umiejętności krytycznego myślenia potrzebne do odniesienia sukcesu w ciągle zmieniającym się środowisku internetowym.

Więcej artykułów

Damir jest liderem zespołu, menedżerem produktu i redaktorem w Metaverse Post, obejmujący takie tematy, jak AI/ML, AGI, LLM, Metaverse i Web3-pokrewne pola. Jego artykuły przyciągają każdego miesiąca ogromną publiczność, liczącą ponad milion użytkowników. Wydaje się być ekspertem z 10-letnim doświadczeniem w SEO i marketingu cyfrowym. Damir został wspomniany w Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i inne publikacje. Jako cyfrowy koczownik podróżuje między ZEA, Turcją, Rosją i WNP. Damir uzyskał tytuł licencjata z fizyki, co jego zdaniem dało mu umiejętności krytycznego myślenia potrzebne do odniesienia sukcesu w ciągle zmieniającym się środowisku internetowym.