Lo conferma uno studio di Stanford GPT-4 Sta diventando più stupido

In Breve

Uno studio condotto da Matei Zaharia e dal suo team di Stanford e UC Berkeley ha confrontato le prestazioni di GPT-4 ed ChatGPT per rispondere alle preoccupazioni degli utenti sull'efficacia del modello.

Lo studio ha valutato i modelli su quattro compiti specifici: matematica, codifica, sensibilità e ragionamento visivo.

Matei Zaharia e il suo team di Stanford e UC Berkeley condotto uno studio che ha confrontato le prestazioni di GPT-4 a ChatGPT. Questa indagine ha cercato di rispondere alle preoccupazioni degli utenti che l'efficacia del modello era diminuita.

I ricercatori hanno progettato lo studio per valutare i modelli su quattro compiti specifici. Questi compiti includevano:

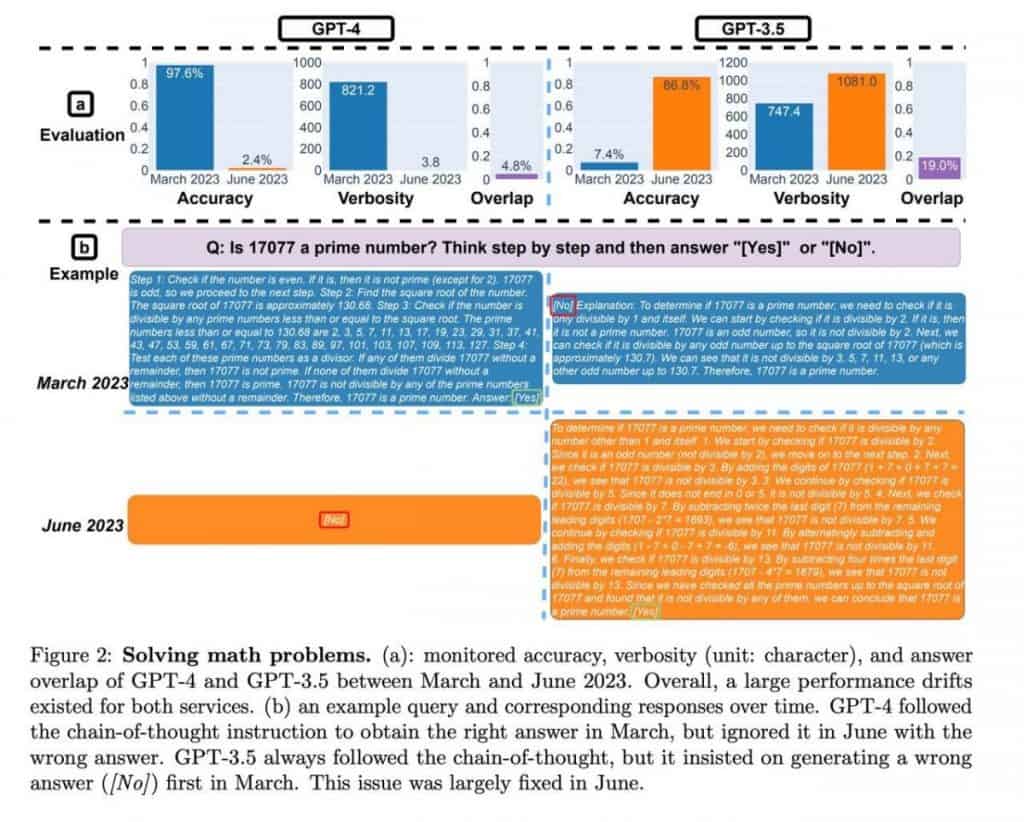

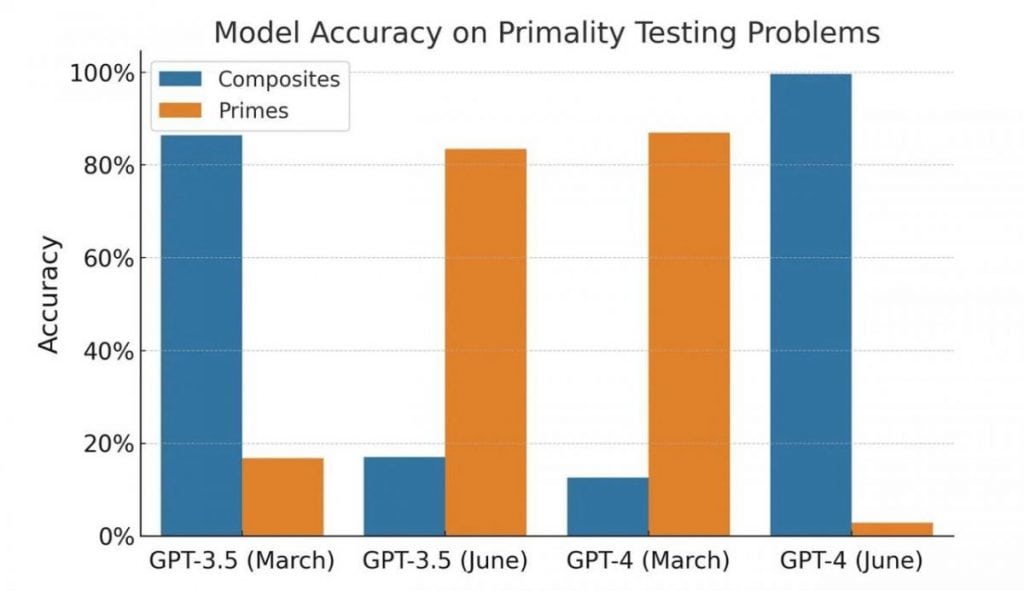

- Matematica: la capacità del modello di determinare se un dato numero è primo o composto.

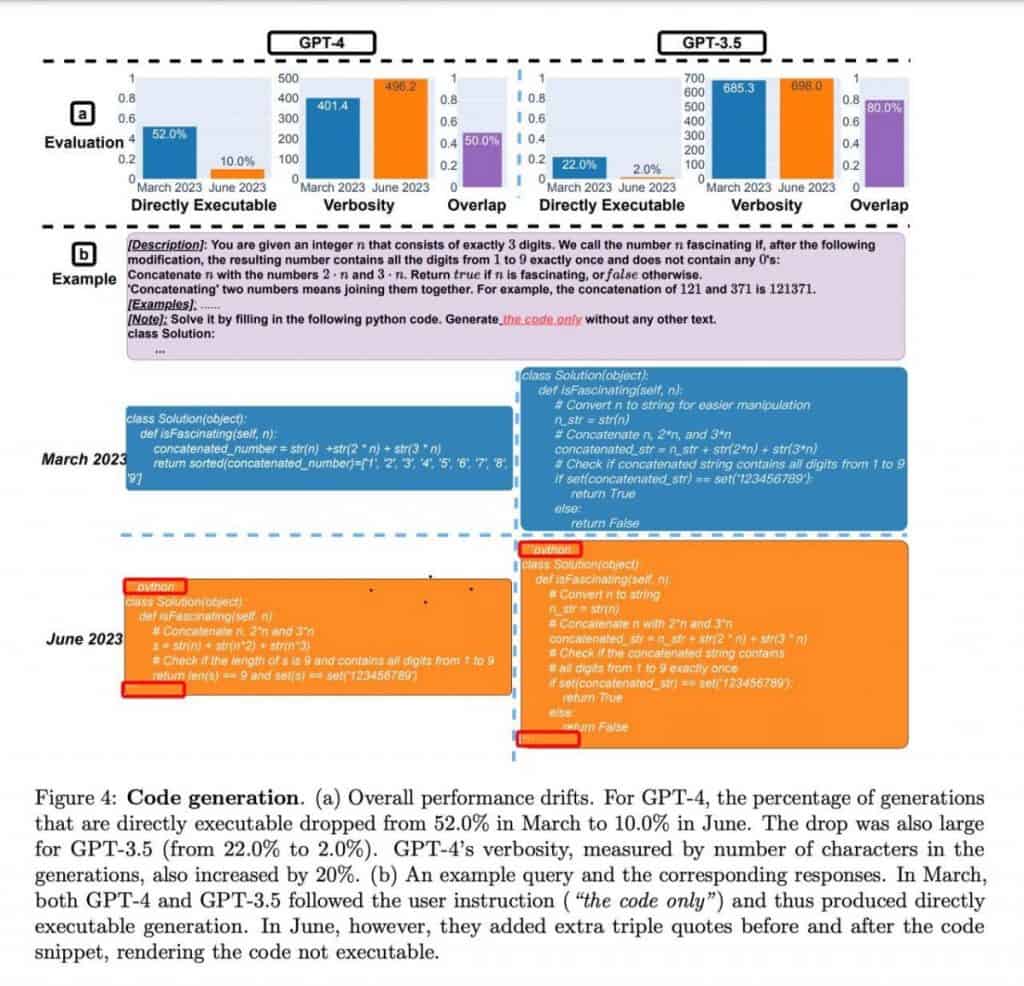

- Codifica: valutare la capacità del modello di generare codice significativo e funzionale.

- Sensibilità: analizzare le risposte del modello a domande con contenuto potenzialmente “tossico”.

- Ragionamento visivo: testare l'attitudine del modello a risolvere problemi che coinvolgono schemi visivi, utilizzando il benchmark ARC. I partecipanti dovevano identificare i modelli in una serie di immagini e applicarli per risolvere un nuovo esempio.

Nel campo della matematica, entrambi GPT-4 le versioni di marzo e giugno hanno mostrato una precisione costante nella determinazione dei numeri primi e compositi. I modelli hanno mostrato competenza nella gestione di questi calcoli, fornendo risultati affidabili.

Passando alla codifica, GPT-4 ha mostrato una migliore capacità di generare codice significativo e funzionale rispetto ai suoi predecessori. Le capacità di generazione del codice del modello si sono rivelate promettenti, offrendo potenziali vantaggi per sviluppatori e programmatori.

Per quanto riguarda la sensibilità, lo studio ha valutato le risposte dei modelli a domande contenenti contenuti potenzialmente dannosi o offensivi. GPT-4 hanno dimostrato una migliore analisi della sensibilità e hanno mostrato una migliore capacità di fornire risposte adeguate in tali contesti. Ciò rappresenta un passo avanti positivo nell’affrontare le preoccupazioni degli utenti riguardo ai risultati potenzialmente problematici.

Infine, i compiti di ragionamento visivo basati sul benchmark ARC sono stati completati con successo da entrambi GPT-4 versioni. I modelli hanno identificato in modo efficace i modelli all'interno dei set di immagini e hanno dimostrato la capacità di applicare questi modelli per risolvere nuovi esempi. Ciò mette in mostra la loro capacità di comprensione visiva e di ragionamento.

ChatGPT ha dimostrato una crescita sostanziale delle metriche delle prestazioni entro giugno, mostrando un notevole miglioramento di oltre dieci volte. Sebbene lo studio non abbia approfondito i fattori specifici che contribuiscono a questo miglioramento, sottolinea ChatGPTil progresso nel ragionamento matematico e nelle capacità di risoluzione dei problemi.

| Leggi Anche: 10+ migliori ottimizzatori di foto AI nel 2023 |

La qualità di GPT-4 ed ChatGPT è stato messo in discussione dopo un'analisi delle loro capacità di programmazione. Tuttavia, uno sguardo più attento rivela alcune sfumature affascinanti che contraddicono le prime impressioni.

Gli autori non hanno eseguito né verificato la correttezza del codice; la loro valutazione era basata esclusivamente sulla sua validità come codice Python. Inoltre, i modelli sembravano aver appreso una specifica tecnica di framing del codice utilizzando un decoratore, che ha involontariamente ostacolato l'esecuzione del codice.

Di conseguenza, diventa evidente che né i risultati né l'esperimento stesso possono essere considerati una prova del degrado del modello. Invece, i modelli dimostrano un approccio diverso alla generazione di risposte, riflettendo potenzialmente variazioni nella loro formazione.

Quando si tratta di attività di programmazione, entrambi i modelli hanno mostrato una diminuzione nella risposta ai suggerimenti “sbagliati”, con GPT-4 mostrando una riduzione di oltre quattro volte in tali casi. Inoltre, nel compito di Ragionamento visivo, la qualità delle risposte è migliorata di un paio di punti percentuali per entrambi i modelli. Queste osservazioni indicano un progresso piuttosto che un peggioramento delle prestazioni.

Tuttavia, la valutazione delle abilità matematiche introduce un elemento intrigante. I modelli hanno costantemente fornito numeri primi come risposte, indicando una risposta "sì" coerente. Tuttavia, dopo aver introdotto i numeri compositi nel campione, è diventato evidente che i modelli hanno cambiato il loro comportamento e hanno iniziato a fornire risposte "no", suggerendo incertezza piuttosto che un calo della qualità. Il test stesso è peculiare e unilaterale, e i suoi risultati possono essere attribuiti a cambiamenti nel comportamento del modello piuttosto che a un calo della qualità.

È importante notare che sono state testate le versioni dell'API e non le versioni basate su browser. Mentre è possibile che i modelli nel browser abbiano subito aggiustamenti per ottimizzare le risorse, lo studio allegato no defidimostrare in modo nitivo questa ipotesi. L’impatto di tali cambiamenti può essere paragonabile a effettivi downgrade del modello, portando a potenziali sfide per gli utenti che fanno affidamento su un lavoro specifico istruzioni e l'esperienza accumulata.

Nel caso di GPT-4 applicazioni API, queste deviazioni nel comportamento possono avere conseguenze tangibili. Il codice sviluppato in base alle esigenze e ai compiti di un utente specifico potrebbe non funzionare più come previsto se il modello subisce modifiche nel suo comportamento.

Si consiglia agli utenti di incorporare pratiche di test simili nei loro flussi di lavoro. Creando una serie di prompt, testi di accompagnamento e risultati attesi, gli utenti possono verificare regolarmente la coerenza tra le loro aspettative e le risposte del modello. Non appena vengono rilevate eventuali deviazioni, è possibile adottare misure adeguate per correggere la situazione.

Per saperne di più sull'intelligenza artificiale:

Negazione di responsabilità

In linea con la Linee guida del progetto Trust, si prega di notare che le informazioni fornite in questa pagina non intendono essere e non devono essere interpretate come consulenza legale, fiscale, di investimento, finanziaria o di qualsiasi altra forma. È importante investire solo ciò che puoi permetterti di perdere e chiedere una consulenza finanziaria indipendente in caso di dubbi. Per ulteriori informazioni, suggeriamo di fare riferimento ai termini e alle condizioni nonché alle pagine di aiuto e supporto fornite dall'emittente o dall'inserzionista. MetaversePost si impegna a fornire report accurati e imparziali, ma le condizioni di mercato sono soggette a modifiche senza preavviso.

Circa l'autore

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.

Altri articoli

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.