Stability AI'S Stable Diffusion 2 L'algoritmo è finalmente pubblico: nuovo modello depth2img, upscaler a super risoluzione, nessun contenuto per adulti

In Breve

Stable Diffusion Il modello 2.0 è più veloce, open source, scalabile, più robusto del precedente

Stable Diffusion diventa pronto per la GPU con nuove funzionalità per il rendering in tempo reale

Guidato in profondità stable diffusion modello – Da immagine a immagine con nuove idee per applicazioni creative

Stability AI ha rilasciato un nuovo articolo sul suo blog su Stable Diffusion 2. In esso, Stability AI propone un nuovo algoritmo più efficiente e robusto del precedente confrontandolo con altri metodi all'avanguardia.

Originale di CompVis Stable Diffusion Modello V1 rivoluzionato la natura dell'open-source Modelli AI e ha prodotto centinaia di diversi modelli e progressi in tutto il mondo. Ha visto una delle salite più veloci a 10,000 stelle Github, accumulando 33,000 in meno di due mesi, più velocemente di più programmi su Github.

L'originale Stable Diffusion La versione V1 è stata guidata dal dinamico team di Robin Rombach (Stability AI) e Patrick Esser (Runway ML) del CompVis Group della LMU di Monaco, guidato dal Prof. Dr. Björn Ommer. Hanno costruito sul precedente lavoro del laboratorio con Latent Modelli di diffusione e ha ricevuto un supporto critico da LAION e Eleuther AI.

Ciò che rende Stable Diffusion v1 diverso da Stable Diffusion v2?

Stable Diffusion 2.0 include una serie di miglioramenti e funzionalità significativi rispetto alla versione precedente, quindi diamo un'occhiata a loro.

I Stable Diffusion La versione 2.0 presenta robusti modelli text-to-image addestrati con un nuovo codificatore di testo (OpenCLIP) sviluppato da LAION con l'assistenza di Stability AI, che migliora notevolmente la qualità del immagini generate rispetto alle precedenti versioni V1. I modelli text-to-image di questa versione possono produrre immagini con risoluzioni predefinite di 512×512 pixel e 768×768 pixel.

Questi modelli vengono addestrati utilizzando un sottoinsieme estetico del set di dati LAION-5B generato da Stability AIDeepFloyd di , che viene poi filtrato per escludere i contenuti per adulti utilizzando il filtro NSFW di LAION.

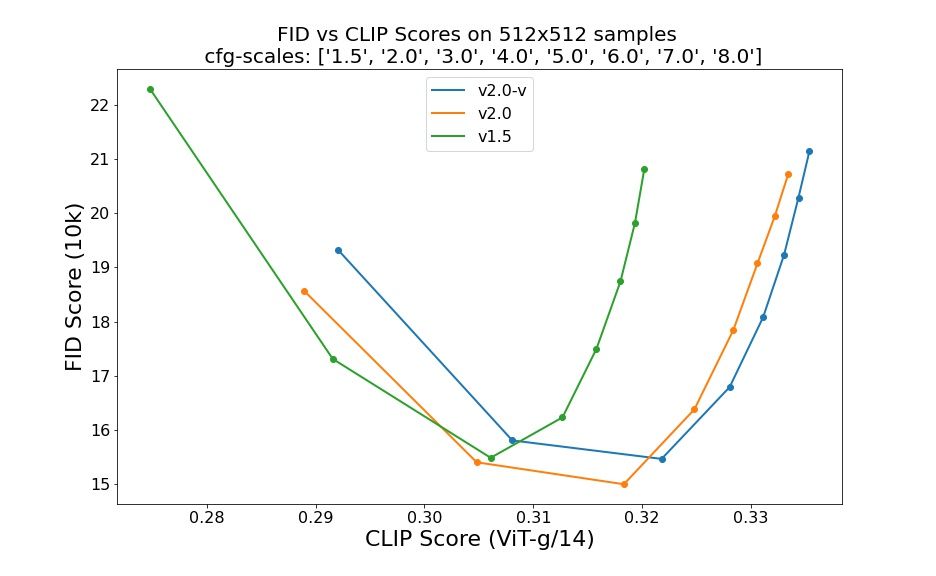

Le valutazioni che utilizzano 50 passaggi campione DDIM, 50 scale guida prive di classificatore e 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 e 8.0 indicano miglioramenti relativi dei punti di controllo:

Stable Diffusion 2.0 ora incorpora un modello Upscaler Diffusion, che aumenta la risoluzione dell'immagine di un fattore quattro. Un esempio del nostro modello upscaling di seguito è mostrata un'immagine generata di bassa qualità (128×128) in un'immagine a risoluzione più elevata (512×512). Stable Diffusion 2.0, se combinato con i nostri modelli text-to-image, può ora generare immagini con risoluzioni di 2048×2048 o superiori.

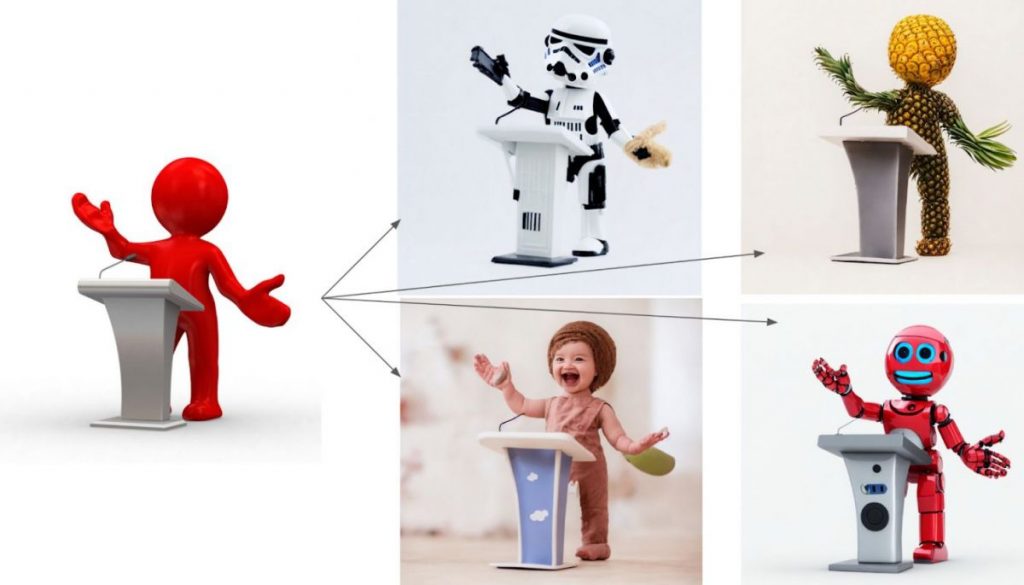

La nuova guida in profondità stable diffusion modello, depth2img, estende la precedente funzionalità immagine-immagine della V1 con possibilità creative completamente nuove. Depth2img determina la profondità di un'immagine di input (utilizzando un modello esistente) e quindi ne genera una nuova immagini sulla base sia del testo che delle informazioni approfondite. Depth-to-Image può fornire una pletora di nuove applicazioni creative, offrendo modifiche che sembrano significativamente diverse dall'originale pur mantenendo la coerenza e la profondità dell'immagine.

Cosa c'è di nuovo in Stable Diffusion 2?

- Il nuovo stable diffusion modello offre una risoluzione 768×768.

- U-Net ha la stessa quantità di parametri della versione 1.5, ma è stata addestrata da zero e utilizza OpenCLIP-ViT/H come codificatore di testo. Un cosiddetto modello di previsione v è SD 2.0-v.

- Il suddetto modello è stato adattato dalla base SD 2.0, anch'essa resa disponibile ed è stato addestrato come un tipico modello di previsione del rumore su immagini 512×512.

- È stato aggiunto un modello di diffusione guidata da testo latente con ridimensionamento x4.

- Raffinata base SD 2.0 con guida in profondità stable diffusion modello. Il modello può essere utilizzato per la preservazione della struttura img2img e la sintesi condizionale della forma ed è condizionato dalle stime della profondità monoculare dedotte da MiDaS.

- Un modello di inpainting guidato da testo migliorato basato sulla base SD 2.0.

Gli sviluppatori hanno lavorato sodo, proprio come l'iterazione iniziale di Stable Diffusion, per ottimizzare l'esecuzione del modello su una singola GPU: volevano renderlo accessibile a quante più persone possibile fin dall'inizio. Hanno già visto cosa succede quando milioni di individui mettono le mani su questi modelli e collaborano per costruire cose assolutamente straordinarie. Questo è il potere dell'open source: sfruttare il vasto potenziale di milioni di persone di talento che potrebbero non avere le risorse per addestrare un modello all'avanguardia ma avere la capacità di fare cose incredibili con uno.

Questo nuovo aggiornamento, combinato con nuove potenti funzionalità come depth2img e migliori capacità di upscaling della risoluzione, fungerà da base per una pletora di nuove applicazioni e consentirà un'esplosione di nuovo potenziale creativo.

Per saperne di più, leggi Stable Diffusion:

Negazione di responsabilità

In linea con la Linee guida del progetto Trust, si prega di notare che le informazioni fornite in questa pagina non intendono essere e non devono essere interpretate come consulenza legale, fiscale, di investimento, finanziaria o di qualsiasi altra forma. È importante investire solo ciò che puoi permetterti di perdere e chiedere una consulenza finanziaria indipendente in caso di dubbi. Per ulteriori informazioni, suggeriamo di fare riferimento ai termini e alle condizioni nonché alle pagine di aiuto e supporto fornite dall'emittente o dall'inserzionista. MetaversePost si impegna a fornire report accurati e imparziali, ma le condizioni di mercato sono soggette a modifiche senza preavviso.

Circa l'autore

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.

Altri articoli

Damir è il team leader, il product manager e l'editore di Metaverse Post, che copre argomenti come AI/ML, AGI, LLM, Metaverse e Web3campi correlati. I suoi articoli attirano un vasto pubblico di oltre un milione di utenti ogni mese. Sembra essere un esperto con 10 anni di esperienza in SEO e marketing digitale. Damir è stato menzionato in Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto e altre pubblicazioni. Viaggia tra Emirati Arabi Uniti, Turchia, Russia e CSI come nomade digitale. Damir ha conseguito una laurea in fisica, che secondo lui gli ha fornito le capacità di pensiero critico necessarie per avere successo nel panorama in continua evoluzione di Internet.