Modello AI da testo a video

Che cos'è il modello AI da testo a video?

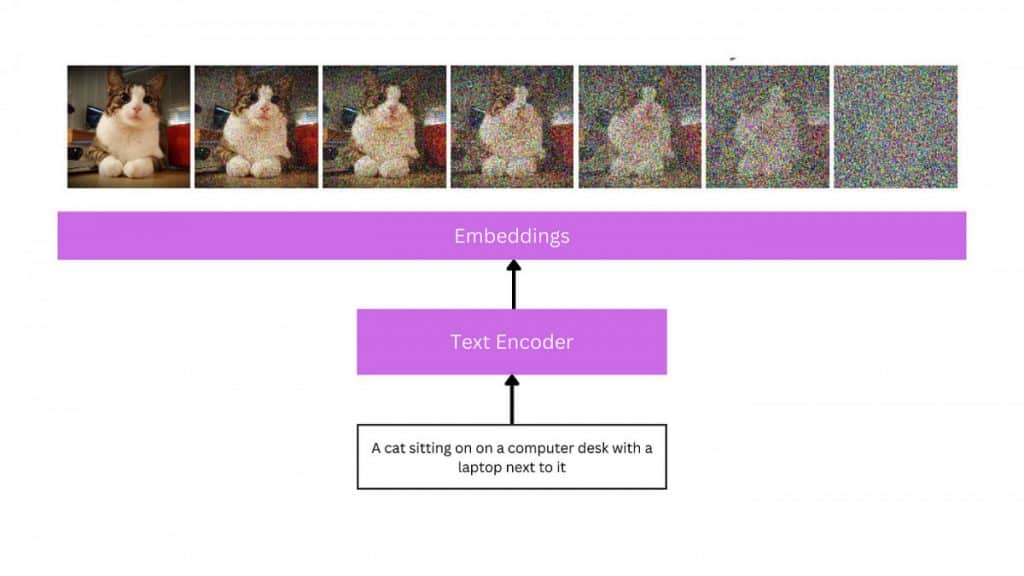

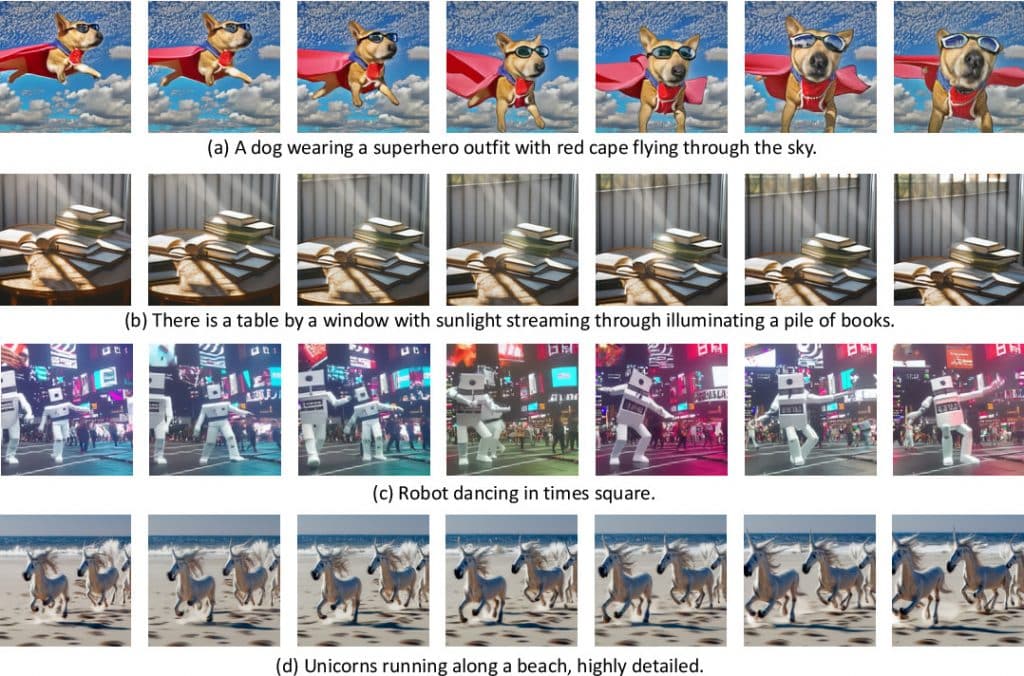

Le istruzioni in linguaggio naturale sono l'input utilizzato dai modelli da testo a video per creare video. Questi modelli comprendono il contesto e la semantica del testo di input e quindi producono una sequenza video corrispondente utilizzando sofisticati machine learning, deep learning o approcci di rete neurale ricorrenti. Il text-to-video è un'area in rapido sviluppo che richiede enormi quantità di dati e potenza di elaborazione per essere addestrata. Potrebbero essere utilizzati per aiutare nel processo di realizzazione del film o per produrre video divertenti o promozionali.

Comprensione del modello AI da testo a video

Analogamente al problema del testo in immagine, la produzione del testo in video è stata studiata solo da pochi anni in questo momento. Gli studi precedenti generavano per lo più fotogrammi con didascalie in modo autoregressivo utilizzando tecniche basate su GAN e VAE. Questi studi sono limitati a movimenti a bassa risoluzione, a corto raggio e unici e isolati, anche se hanno gettato le basi per un nuovo problema di visione artificiale.

La successiva ondata di ricerca sulla generazione di testo-video ha utilizzato strutture di trasformatori, attratte dal successo di modelli di trasformatori preaddestrati su larga scala nel testo (GPT-3) e immagine (DALL-E). Mentre lavori come TATS presentano approcci ibridi che includono VQGAN per la creazione di immagini con un modulo trasformatore sensibile al tempo per la generazione di fotogrammi sequenziali, Phenaki, Make-A-Video, NUWA, VideoGPTe CogVideo propongono tutti framework basati su trasformatori. Phenaki, uno dei lavori di questa seconda ondata, è particolarmente intrigante poiché consente di creare film di lunghezza arbitraria basata su una serie di suggerimenti o su una narrazione. Allo stesso modo, NUWA-Infinity consente la creazione di estesi,definizione di film proponendo una tecnica di generazione autoregressiva su autoregressiva per la sintesi infinita di immagini e video da input di testo. Tuttavia, i modelli NUWA e Phenaki non sono accessibili al grande pubblico.

La maggior parte dei modelli da testo a video nella terza e attuale ondata includono topologie basate sulla diffusione. I modelli di diffusione hanno mostrato risultati impressionanti nel generare immagini ricche, iperrealistiche e varie. Ciò ha suscitato interesse nell’applicazione di modelli di diffusione ad altri domini, tra cui audio, 3D e, più recentemente, video. Video Diffusion Models (VDM), che espandono i modelli di diffusione nel dominio video, e MagicVideo, che suggerisce un framework per produrre video clip in uno spazio latente a bassa dimensionalità e rivendica significativi vantaggi in termini di efficienza rispetto a VDM, sono i precursori di questa generazione di modelli . Un altro esempio degno di nota è Tune-a-Video, che consente di utilizzare una coppia testo-video per mettere a punto un modello testo-immagine preimpostato e consente di modificare il contenuto video mantenendo il movimento.

| Leggi Anche: Oltre 10 migliori generatori di intelligenza artificiale text-to-video: potenti e gratuiti |

Futuro del modello AI da testo a video

Il testo in video di Hollywood e intelligenza artificiale (AI) il futuro è pieno di opportunità e difficoltà. Potremmo aspettarci video molto più complessi e realistici generati dall’intelligenza artificiale man mano che questi sistemi di intelligenza artificiale generativa si sviluppano e diventano più abili nella produzione di video da istruzioni di testo. Le possibilità offerte da programmi come Gen2 di Runway, NeRF di NVIDIA e Transframer di Google sono solo la punta dell’iceberg. Espressioni emotive più complesse, editing video in tempo reale e persino la capacità di creare lungometraggi a partire da un suggerimento testuale sono possibili sviluppi futuri. Ad esempio, la visualizzazione dello storyboard durante la pre-produzione potrebbe essere realizzata con la tecnologia text-to-video, offrendo ai registi l'accesso a una versione incompleta di una scena prima che venga girata. Ciò potrebbe comportare un risparmio di risorse e tempo, migliorando l’efficienza del processo di realizzazione del film. Questi strumenti possono essere utilizzati anche per produrre materiale video di alta qualità in modo rapido ed economico per scopi di marketing e promozionali. Possono essere utilizzati anche per creare video accattivanti.

Ultime notizie sul modello AI testo-video

- Zeroscope, una tecnologia text-to-video gratuita e open source, è un concorrente di Gen-2 di Runway ML. Mira a trasformare le parole scritte in immagini dinamiche, offrendo una risoluzione più elevata e un rapporto di aspetto 16:9 più vicino. Disponibile in due versioni, Zeroscope_v2 567w e Zeroscope_v2 XL, richiede 7.9 GB di VRam e introduce rumore di offset per migliorare la distribuzione dei dati. Zeroscope è una valida alternativa open source alla Gen-2 di Runway, offrendo una gamma più diversificata di video realistici.

- VideodirettoreGPT è un approccio innovativo alla generazione di testo-video, che combina modelli linguistici di grandi dimensioni (LLM) con la pianificazione video per creare video multi-scena precisi e coerenti. Utilizza LLM come maestro della narrazione, creando descrizioni di testo a livello di scena, elenchi di oggetti e layout fotogramma per fotogramma. Layout2Vid, un modulo di generazione video, fornisce il controllo spaziale sui layout degli oggetti. I modelli Masterpiece di Yandex e Gen-2 di Runway offrono accessibilità e semplicità, migliorando allo stesso tempo la creazione e la condivisione di contenuti sulle piattaforme di social media.

- Yandex ha introdotto una nuova funzionalità chiamata Masterpiece, che consente agli utenti di creare brevi video della durata fino a 4 secondi con un frame rate di 24 fotogrammi al secondo. La tecnologia utilizza il metodo di diffusione a cascata per creare fotogrammi video successivi, consentendo agli utenti di generare un'ampia gamma di contenuti. La piattaforma Masterpiece integra le funzionalità esistenti, inclusa la creazione di immagini e post di testo. La rete neurale genera video tramite descrizioni basate su testo, selezione di fotogrammi e generazione automatizzata. La funzionalità ha guadagnato popolarità ed è attualmente disponibile esclusivamente per gli utenti attivi.

Ultimi post social sul modello AI testo-video

Negazione di responsabilità

In linea con la Linee guida del progetto Trust, si prega di notare che le informazioni fornite in questa pagina non intendono essere e non devono essere interpretate come consulenza legale, fiscale, di investimento, finanziaria o di qualsiasi altra forma. È importante investire solo ciò che puoi permetterti di perdere e chiedere una consulenza finanziaria indipendente in caso di dubbi. Per ulteriori informazioni, suggeriamo di fare riferimento ai termini e alle condizioni nonché alle pagine di aiuto e supporto fornite dall'emittente o dall'inserzionista. MetaversePost si impegna a fornire report accurati e imparziali, ma le condizioni di mercato sono soggette a modifiche senza preavviso.

Circa l'autore

Viktoriia è una scrittrice su una varietà di argomenti tecnologici, tra cui Web3.0, AI e criptovalute. La sua vasta esperienza le consente di scrivere articoli approfonditi per un pubblico più ampio.

Altri articoli

Viktoriia è una scrittrice su una varietà di argomenti tecnologici, tra cui Web3.0, AI e criptovalute. La sua vasta esperienza le consente di scrivere articoli approfonditi per un pubblico più ampio.