L'étude de Stanford confirme GPT-4 Devient plus bête

En bref

Une étude réalisée par Matei Zaharia et son équipe de Stanford et de l'UC Berkeley a comparé les performances de GPT-4 ainsi que les ChatGPT pour répondre aux préoccupations des utilisateurs quant à l'efficacité du modèle.

L'étude a évalué les modèles sur quatre tâches spécifiques : les mathématiques, le codage, la sensibilité et le raisonnement visuel.

Matei Zaharia et son équipe de Stanford et UC Berkeley a mené une étude qui comparait les performances de GPT-4 à ChatGPT. Cette enquête visait à répondre aux préoccupations des utilisateurs selon lesquelles l'efficacité du modèle avait diminué.

| Services Connexes: GPT-4 vs. GPT-3: Qu'est-ce que le nouveau modèle a à offrir ? |

Les chercheurs ont conçu l'étude pour évaluer les modèles sur quatre tâches spécifiques. Ces tâches comprenaient :

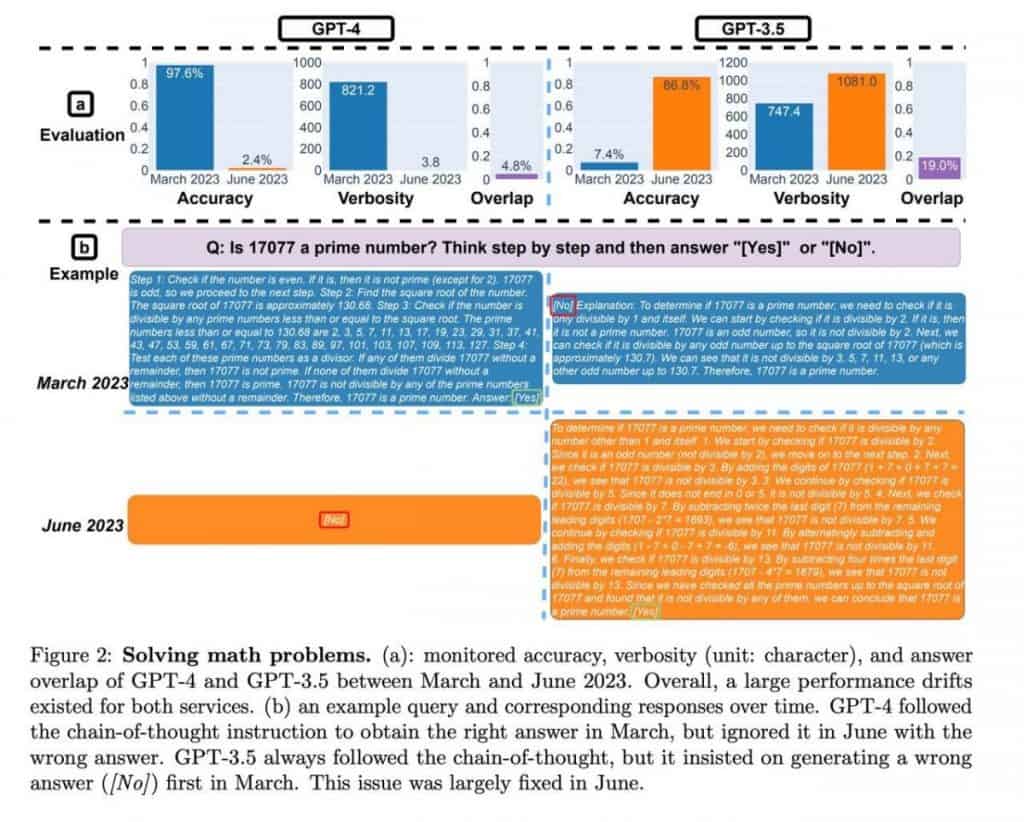

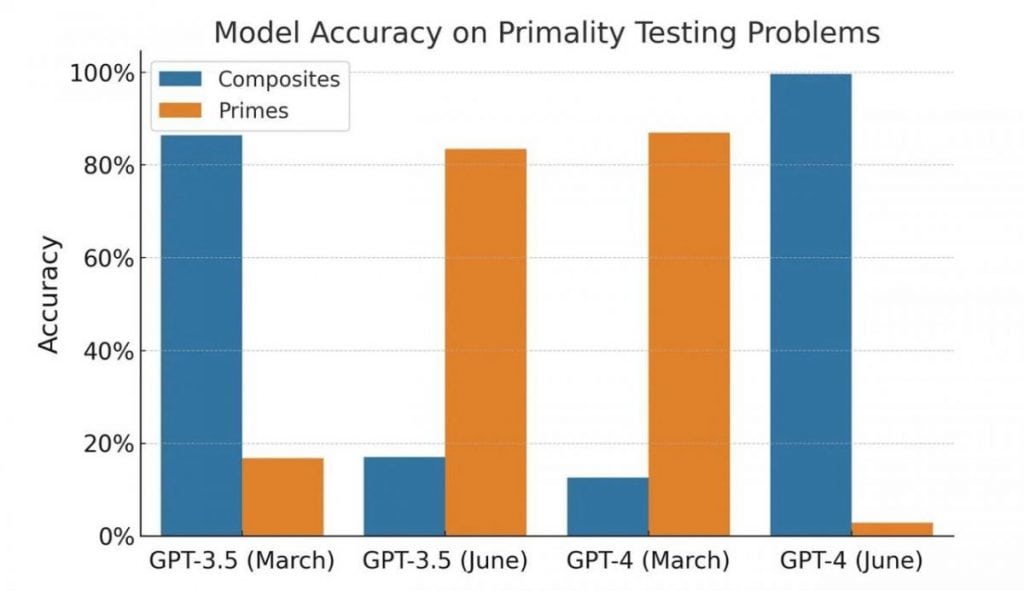

- Mathématiques : capacité du modèle à déterminer si un nombre donné est premier ou composé.

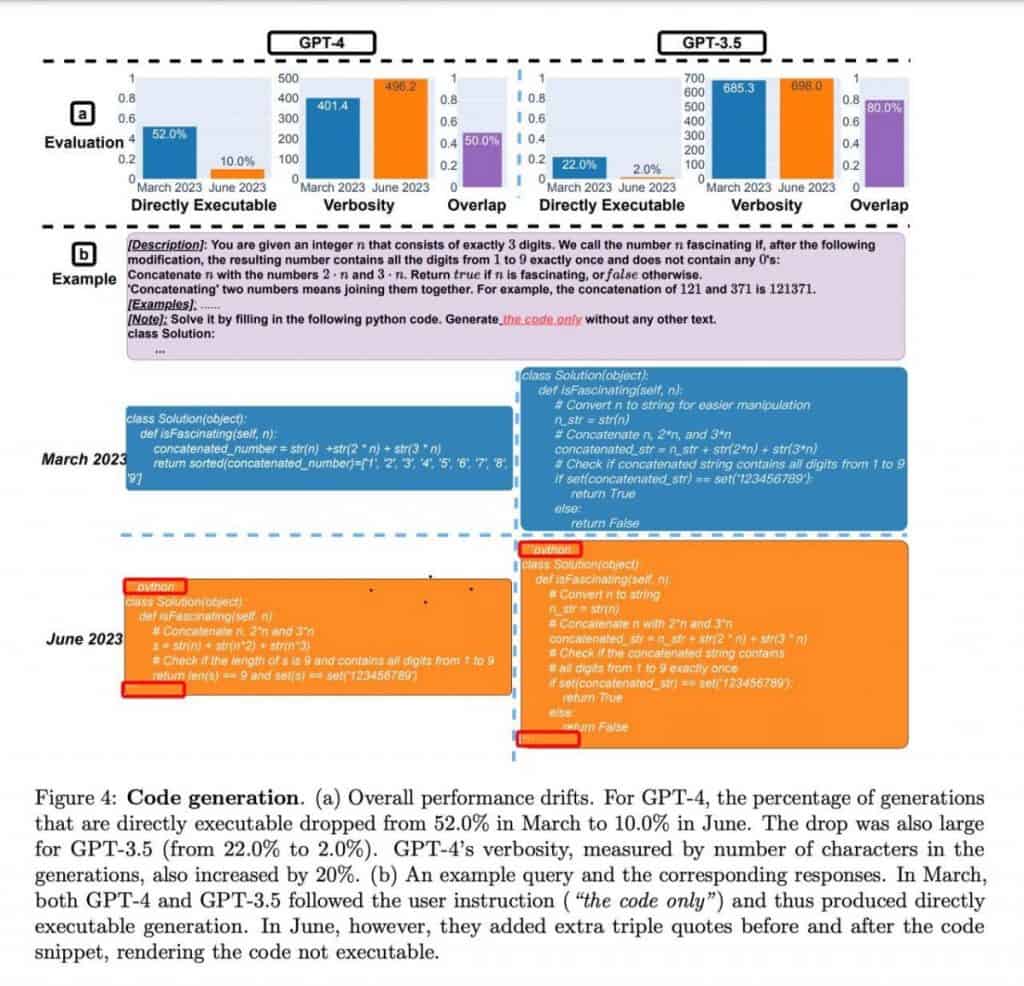

- Codage : évaluation de la capacité du modèle à générer un code significatif et fonctionnel.

- Sensibilité : Analyser les réponses du modèle aux questions au contenu potentiellement « toxique ».

- Raisonnement visuel : test de l'aptitude du modèle à résoudre des problèmes impliquant des motifs visuels, à l'aide du benchmark ARC. Les participants devaient identifier des modèles dans un ensemble d'images et les appliquer pour résoudre un nouvel exemple.

Dans le domaine des mathématiques, les deux GPT-4 Les versions de mars et juin ont montré une précision constante dans la détermination des nombres premiers et composés. Les modèles ont démontré leur maîtrise de ces calculs, fournissant des résultats fiables.

Passons au codage, GPT-4 a montré une capacité améliorée à générer du code significatif et fonctionnel par rapport à ses prédécesseurs. Les capacités de génération de code du modèle se sont révélées prometteuses, offrant des avantages potentiels aux développeurs et aux programmeurs.

Concernant la sensibilité, l'étude a évalué les réponses des modèles à des questions contenant un contenu potentiellement préjudiciable ou offensant. GPT-4 ont démontré une analyse de sensibilité améliorée et une capacité améliorée à fournir des réponses appropriées dans de tels contextes. Cela représente un pas en avant positif dans la réponse aux préoccupations des utilisateurs concernant les résultats potentiellement problématiques.

Enfin, les tâches de raisonnement visuel basées sur le benchmark ARC ont été complétées avec succès par les deux GPT-4 versions. Les modèles ont identifié efficacement des modèles dans des ensembles d'images et ont démontré une capacité à appliquer ces modèles pour résoudre de nouveaux exemples. Cela met en valeur leur capacité de compréhension visuelle et de raisonnement.

ChatGPT a démontré une croissance substantielle des mesures de performance en juin, montrant une amélioration remarquable de plus de dix fois. Bien que l'étude n'ait pas approfondi les facteurs spécifiques contribuant à cette amélioration, elle met en évidence ChatGPTl'avancement du raisonnement mathématique et des capacités de résolution de problèmes.

| Services Connexes: 10+ meilleurs rehausseurs de photos AI en 2023 |

La qualité de GPT-4 ainsi que les ChatGPT a été interrogé après une analyse de leurs capacités de programmation. Cependant, un examen plus approfondi révèle des nuances fascinantes qui contredisent les premières impressions.

Les auteurs n'ont pas exécuté ou vérifié l'exactitude du code ; leur évaluation était uniquement basée sur sa validité en tant que code Python. De plus, les modèles semblaient avoir appris une technique de cadrage de code spécifique à l'aide d'un décorateur, ce qui entravait involontairement l'exécution du code.

En conséquence, il devient évident que ni les résultats ni l'expérience elle-même ne peuvent être considérés comme des preuves de la dégradation du modèle. Au lieu de cela, les modèles démontrent une approche différente pour générer des réponses, reflétant potentiellement des variations dans leur formation.

En ce qui concerne les tâches de programmation, les deux modèles ont montré une diminution du nombre de réponses aux « mauvaises » invites, avec GPT-4 présentant une réduction de plus de quatre fois dans de tels cas. De plus, pour la tâche de raisonnement visuel, la qualité des réponses s'est améliorée de quelques points de pourcentage pour les deux modèles. Ces observations indiquent un progrès plutôt qu’une dégradation des performances.

Cependant, l'évaluation des compétences en mathématiques introduit un élément intrigant. Les modèles ont systématiquement fourni des nombres premiers comme réponses, indiquant une réponse « oui » cohérente. Pourtant, lors de l'introduction de nombres composites dans l'échantillon, il est devenu évident que les modèles ont modifié leur comportement et ont commencé à fournir des réponses «non», suggérant une incertitude plutôt qu'une baisse de la qualité. Le test lui-même est particulier et unilatéral, et ses résultats peuvent être attribués à des changements dans le comportement du modèle plutôt qu'à une baisse de la qualité.

Il est important de noter que les versions de l'API ont été testées, et non les versions basées sur les navigateurs. Bien qu'il soit possible que les modèles du navigateur aient subi des ajustements pour optimiser les ressources, l'étude ci-jointe ne defiprouver formellement cette hypothèse. L'impact de tels changements peut être comparable aux rétrogradations réelles du modèle, entraînant des défis potentiels pour les utilisateurs qui dépendent de systèmes de travail spécifiques. instructions et l'expérience accumulée.

Dans le cas d' GPT-4 Applications API, ces écarts de comportement peuvent avoir des conséquences tangibles. Le code développé en fonction des besoins et des tâches d'un utilisateur spécifique peut ne plus fonctionner comme prévu si le modèle subit des changements dans son comportement.

Il est recommandé aux utilisateurs d'intégrer des pratiques de test similaires dans leurs flux de travail. En créant un ensemble d'invites, de textes d'accompagnement et de résultats attendus, les utilisateurs peuvent vérifier régulièrement la cohérence entre leurs attentes et les réponses du modèle. Dès que des écarts sont détectés, des mesures appropriées peuvent être prises pour rectifier la situation.

En savoir plus sur l'IA :

Clause de non-responsabilité

En ligne avec la Lignes directrices du projet de confiance, veuillez noter que les informations fournies sur cette page ne sont pas destinées à être et ne doivent pas être interprétées comme des conseils juridiques, fiscaux, d'investissement, financiers ou toute autre forme de conseil. Il est important d’investir uniquement ce que vous pouvez vous permettre de perdre et de demander des conseils financiers indépendants en cas de doute. Pour plus d'informations, nous vous suggérons de vous référer aux conditions générales ainsi qu'aux pages d'aide et de support mises à disposition par l'émetteur ou l'annonceur. MetaversePost s'engage à fournir des rapports précis et impartiaux, mais les conditions du marché sont susceptibles de changer sans préavis.

A propos de l'auteur

Damir est chef d'équipe, chef de produit et rédacteur en chef chez Metaverse Post, couvrant des sujets tels que l'IA/ML, l'AGI, les LLM, le métaverse et Web3-domaines connexes. Ses articles attirent une audience massive de plus d'un million d'utilisateurs chaque mois. Il semble être un expert avec 10 ans d'expérience dans le référencement et le marketing numérique. Damir a été mentionné dans Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto et d'autres publications. Il voyage entre les Émirats arabes unis, la Turquie, la Russie et la CEI en tant que nomade numérique. Damir a obtenu un baccalauréat en physique, ce qui, selon lui, lui a donné les compétences de pensée critique nécessaires pour réussir dans le paysage en constante évolution d'Internet.

Plus d'articles

Damir est chef d'équipe, chef de produit et rédacteur en chef chez Metaverse Post, couvrant des sujets tels que l'IA/ML, l'AGI, les LLM, le métaverse et Web3-domaines connexes. Ses articles attirent une audience massive de plus d'un million d'utilisateurs chaque mois. Il semble être un expert avec 10 ans d'expérience dans le référencement et le marketing numérique. Damir a été mentionné dans Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto et d'autres publications. Il voyage entre les Émirats arabes unis, la Turquie, la Russie et la CEI en tant que nomade numérique. Damir a obtenu un baccalauréat en physique, ce qui, selon lui, lui a donné les compétences de pensée critique nécessaires pour réussir dans le paysage en constante évolution d'Internet.