Los grandes modelos de lenguaje actuales serán modelos pequeños, según un investigador de OpenAI

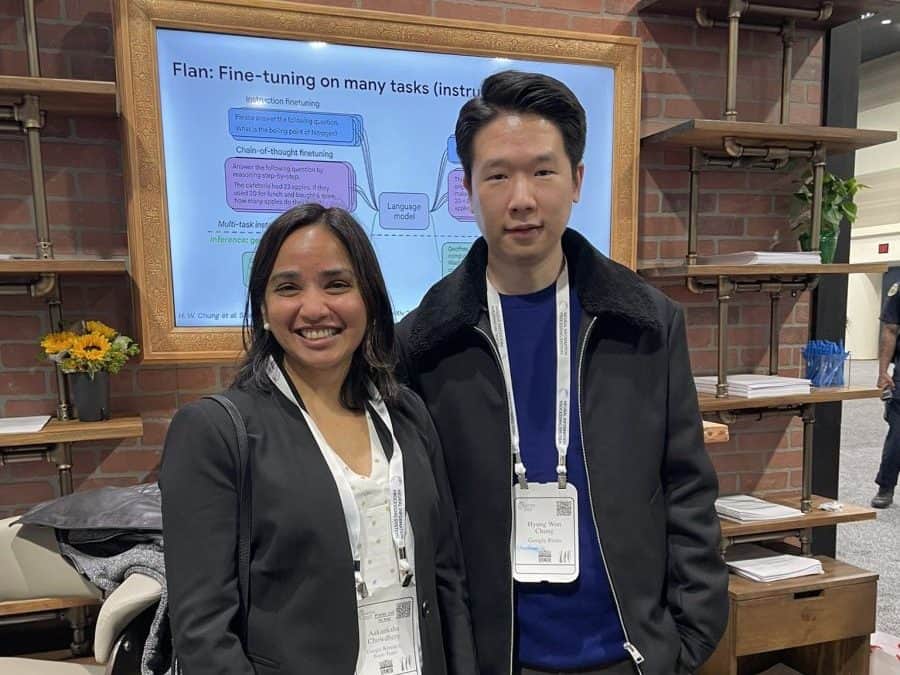

Hyung Won Chung, un consumado investigador de IA que anteriormente trabajó en Google Brain y actualmente es miembro de la OpenAI equipo, pronunció un discurso de 45 minutos que hizo reflexionar en el que exploró el mundo de los grandes modelos de lenguaje en 2023. Chung tiene experiencia en el campo; fue el primer autor del artículo de Google "Instrucción escalable: modelos de lenguaje perfeccionados,”que examina cómo se pueden entrenar modelos de lenguaje grandes para que sigan instrucciones.

Chung enfatiza que el mundo de los modelos lingüísticos extensivos es dinámico. En el mundo de los LLM, el principio rector evoluciona constantemente, a diferencia de los campos tradicionales donde los supuestos fundamentales suelen permanecer estables. Con la próxima generación de modelos, lo que actualmente se considera imposible o poco práctico puede volverse posible. Enfatiza la importancia de anteponer la mayoría de las afirmaciones sobre las capacidades de LLM con "por ahora". Un modelo puede realizar una tarea; simplemente aún no lo ha hecho.

Los modelos grandes de hoy serán modelos pequeños dentro de unos años

Hyung Won Chung, OpenAI

La necesidad de una documentación meticulosa y reproducibilidad en Investigación de IA es una de las lecciones más importantes que se pueden aprender del discurso de Chung. Es crucial documentar minuciosamente el trabajo en curso a medida que se desarrolla el campo. Esta estrategia garantiza que los experimentos puedan replicarse y revisarse rápidamente, lo que permite a los investigadores aprovechar trabajos anteriores. A través de esta práctica, se reconoce que en el futuro pueden desarrollarse capacidades que no eran prácticas durante la investigación inicial.

Chung dedica una parte de su charla a dilucidar las complejidades de los datos y el paralelismo de modelos. Para aquellos interesados en profundizar en los aspectos técnicos de la IA, esta sección proporciona información valiosa sobre el funcionamiento interno de estas técnicas de paralelismo. Comprender estos mecanismos es crucial para optimizar entrenamiento de modelos a gran escala.

Chung postula que la función objetivo actual, Máxima Verosimilitud, utilizada para la formación previa de LLM es un cuello de botella cuando se trata de lograr escalas verdaderamente masivas, como 10,000 veces la capacidad de GPT-4. A medida que avanza el aprendizaje automático, las funciones de pérdida diseñadas manualmente se vuelven cada vez más limitantes.

Chung sugiere que el próximo paradigma en el desarrollo de la IA implica el aprendizaje de funciones a través de algoritmos separados. Este enfoque, aunque está en sus inicios, promete una escalabilidad más allá de las limitaciones actuales. También destaca los esfuerzos en curso, como el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) con modelado de reglas, como pasos en esta dirección, aunque aún quedan desafíos por superar.

Observación

En línea con la Directrices del Proyecto Confianza, tenga en cuenta que la información proporcionada en esta página no pretende ser ni debe interpretarse como asesoramiento legal, fiscal, de inversión, financiero o de cualquier otro tipo. Es importante invertir sólo lo que pueda permitirse perder y buscar asesoramiento financiero independiente si tiene alguna duda. Para mayor información sugerimos consultar los términos y condiciones así como las páginas de ayuda y soporte proporcionadas por el emisor o anunciante. MetaversePost se compromete a brindar informes precisos e imparciales, pero las condiciones del mercado están sujetas a cambios sin previo aviso.

Sobre el Autor

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.

Más artículos

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.