El estudio de Stanford lo confirma GPT-4 se está volviendo más tonto

En Resumen

Un estudio realizado por Matei Zaharia y su equipo de Stanford y UC Berkeley comparó el rendimiento de GPT-4 y ChatGPT para abordar las preocupaciones de los usuarios sobre la eficacia del modelo.

El estudio evaluó los modelos en cuatro tareas específicas: matemáticas, codificación, sensibilidad y razonamiento visual.

Matei Zaharia y su equipo de Stanford y UC Berkeley llevó a cabo un estudio que comparó el desempeño de GPT-4 a ChatGPT. Esta investigación buscó abordar las preocupaciones de los usuarios de que la efectividad del modelo había disminuido.

| Relacionado:: GPT-4 vs GPT-3: ¿Qué tiene que ofrecer el nuevo modelo? |

Los investigadores diseñaron el estudio para evaluar los modelos en cuatro tareas específicas. Estas tareas incluyeron:

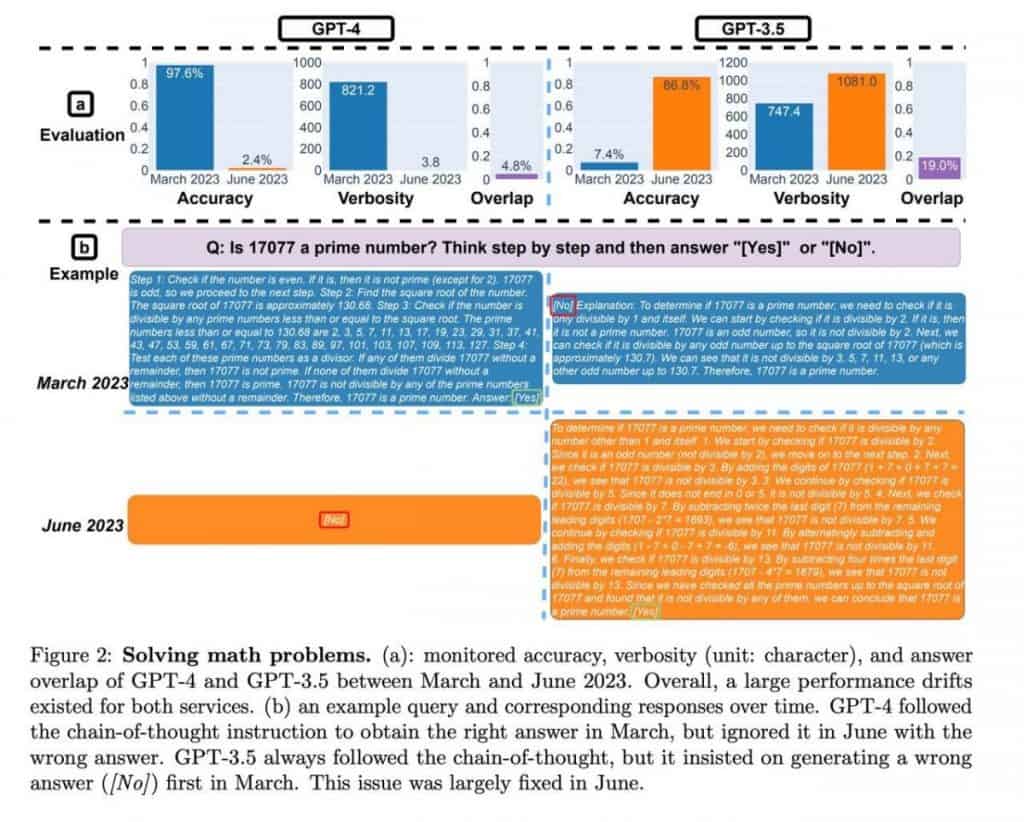

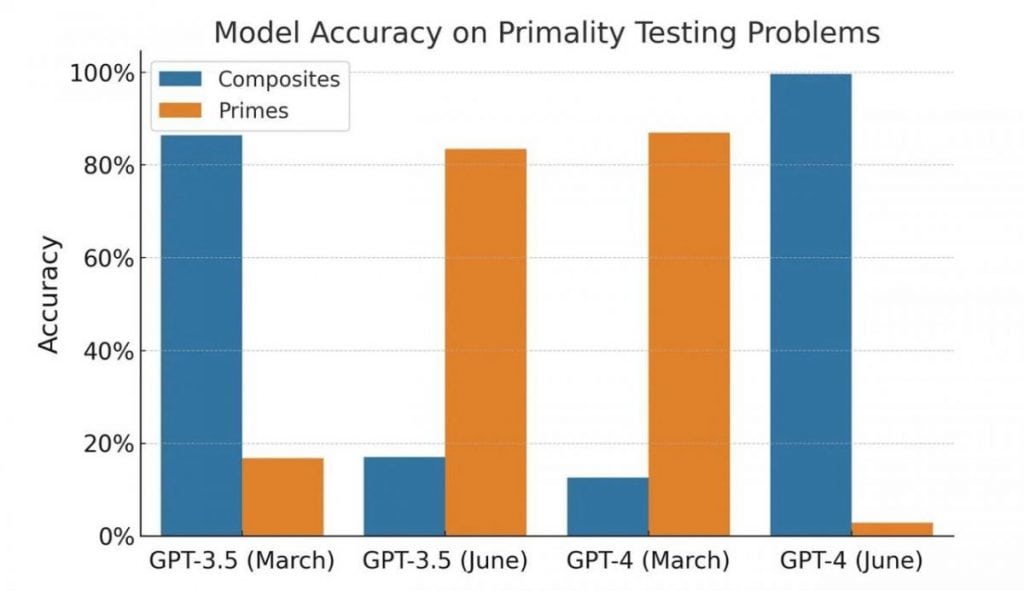

- Matemáticas: la capacidad del modelo para determinar si un número dado es primo o compuesto.

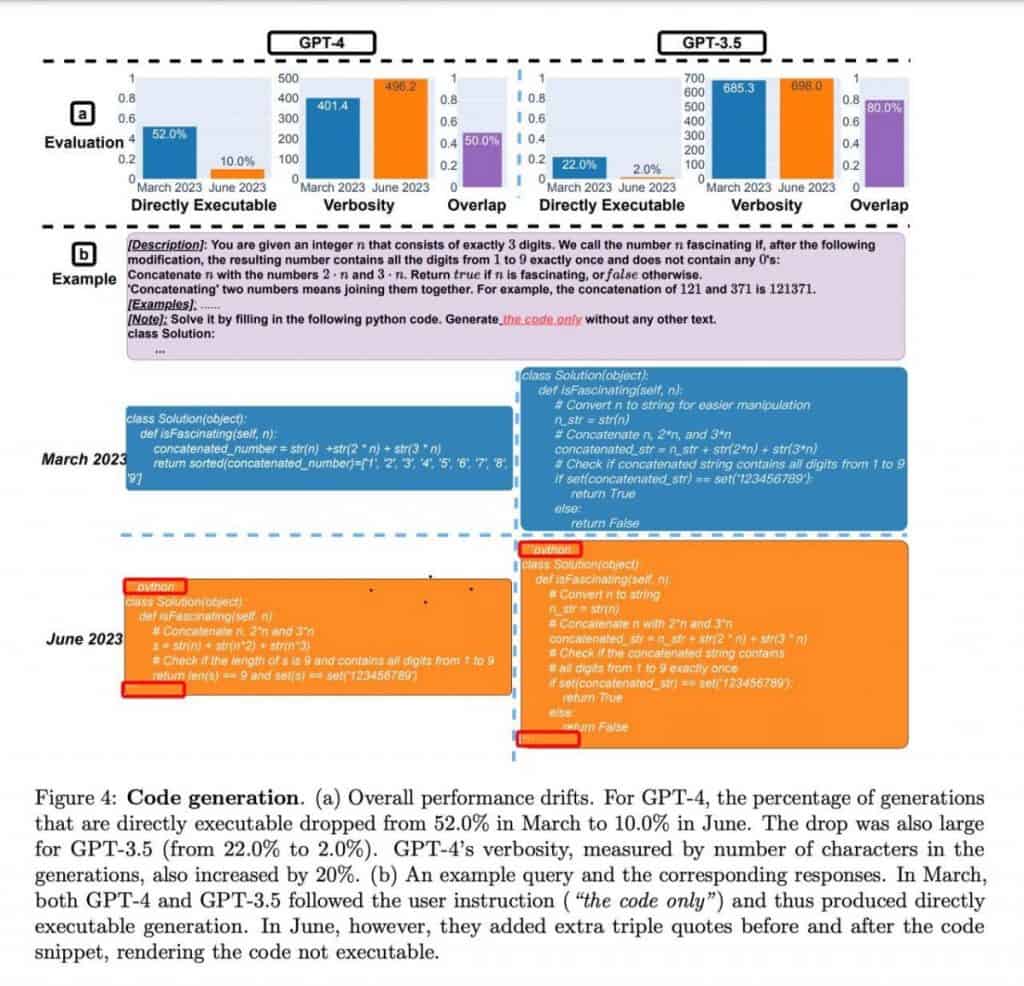

- Codificación: evaluación de la capacidad del modelo para generar código significativo y funcional.

- Sensibilidad: Analizar las respuestas del modelo a preguntas con contenido potencialmente “tóxico”.

- Razonamiento visual: probar la aptitud del modelo para resolver problemas que involucran patrones visuales, utilizando el punto de referencia ARC. Los participantes debían identificar patrones en un conjunto de imágenes y aplicarlos para resolver un nuevo ejemplo.

En el campo de las matemáticas, tanto GPT-4 Las versiones de marzo y junio mostraron una precisión constante en la determinación de números primos y compuestos. Los modelos demostraron competencia en el manejo de estos cálculos, proporcionando resultados confiables.

Pasando a la codificación, GPT-4 exhibió una capacidad mejorada para generar código significativo y funcional en comparación con sus predecesores. Las capacidades de generación de código del modelo se mostraron prometedoras y ofrecieron beneficios potenciales para desarrolladores y programadores.

En cuanto a la sensibilidad, el estudio evaluó las respuestas de los modelos a preguntas con contenido potencialmente dañino u ofensivo. GPT-4 demostró un análisis de sensibilidad mejorado y mostró una capacidad mejorada para proporcionar respuestas apropiadas en tales contextos. Esto significa un paso positivo para abordar las preocupaciones de los usuarios sobre resultados potencialmente problemáticos.

Por último, las tareas de razonamiento visual basadas en el punto de referencia ARC fueron completadas con éxito por ambos. GPT-4 versiones. Los modelos identificaron eficazmente patrones dentro de conjuntos de imágenes y demostraron la capacidad de aplicar estos patrones para resolver nuevos ejemplos. Esto muestra su capacidad de comprensión y razonamiento visual.

ChatGPT demostró un crecimiento sustancial en las métricas de rendimiento en junio, mostrando una notable mejora de más de diez veces. Si bien el estudio no profundizó en los factores específicos que contribuyen a esta mejora, destaca ChatGPT's avance en el razonamiento matemático y la capacidad de resolución de problemas.

| Relacionado:: Más de 10 mejores potenciadores de fotos con IA en 2023 |

La calidad de GPT-4 y ChatGPT ha sido cuestionado después de un análisis de sus habilidades de programación. Sin embargo, una mirada más cercana revela algunos matices fascinantes que contradicen las primeras impresiones.

Los autores no ejecutaron ni verificaron la corrección del código; su evaluación se basó únicamente en su validez como código Python. Además, los modelos parecían haber aprendido una técnica específica de enmarcado de código utilizando un decorador, lo que obstaculizó involuntariamente la ejecución del código.

Como resultado, se hace evidente que ni los resultados ni el experimento en sí pueden considerarse evidencia de degradación del modelo. En cambio, los modelos demuestran un enfoque diferente para generar respuestas, lo que potencialmente refleja variaciones en su entrenamiento.

Cuando se trata de tareas de programación, ambos modelos mostraron una disminución en la respuesta a indicaciones "incorrectas", con GPT-4 mostrando una reducción de más de cuatro veces en tales casos. Además, en la tarea de Razonamiento visual, la calidad de las respuestas mejoró en un par de puntos porcentuales para ambos modelos. Estas observaciones indican un progreso más que una degradación del desempeño.

Sin embargo, la evaluación de las habilidades matemáticas introduce un elemento intrigante. Los modelos siempre proporcionaron números primos como respuestas, lo que indica una respuesta constante de "sí". Sin embargo, al introducir números compuestos en la muestra, se hizo evidente que los modelos cambiaron su comportamiento y comenzaron a proporcionar respuestas negativas, lo que sugiere incertidumbre en lugar de una disminución de la calidad. La prueba en sí es peculiar y unilateral., y sus resultados pueden atribuirse a cambios en el comportamiento del modelo más que a una disminución de la calidad.

Es importante tener en cuenta que se probaron las versiones de API y no las versiones basadas en navegador. Si bien es posible que los modelos en el navegador hayan sufrido ajustes para optimizar los recursos, el estudio adjunto no defiprobar claramente esta hipótesis. El impacto de tales cambios puede ser comparable a las degradaciones de modelos reales, lo que genera desafíos potenciales para los usuarios que dependen de funciones de trabajo específicas. ideas y experiencia acumulada.

En el caso de los GPT-4 En las aplicaciones API, estas desviaciones de comportamiento pueden tener consecuencias tangibles. Es posible que el código desarrollado en función de las necesidades y tareas de un usuario específico ya no funcione según lo previsto si el modelo sufre cambios en su comportamiento.

Se recomienda que los usuarios incorporen prácticas de prueba similares en sus flujos de trabajo. Mediante la creación de un conjunto de indicaciones, textos adjuntos y resultados esperados, los usuarios pueden comprobar periódicamente la coherencia entre sus expectativas y las respuestas del modelo. Tan pronto como se detecten desviaciones, se pueden tomar las medidas apropiadas para rectificar la situación.

Lea más sobre la IA:

Observación

En línea con la Directrices del Proyecto Confianza, tenga en cuenta que la información proporcionada en esta página no pretende ser ni debe interpretarse como asesoramiento legal, fiscal, de inversión, financiero o de cualquier otro tipo. Es importante invertir sólo lo que pueda permitirse perder y buscar asesoramiento financiero independiente si tiene alguna duda. Para mayor información sugerimos consultar los términos y condiciones así como las páginas de ayuda y soporte proporcionadas por el emisor o anunciante. MetaversePost se compromete a brindar informes precisos e imparciales, pero las condiciones del mercado están sujetas a cambios sin previo aviso.

Sobre el Autor

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.

Más artículos

Damir es el líder del equipo, gerente de producto y editor en Metaverse Post, que cubre temas como AI/ML, AGI, LLM, Metaverse y Web3-campos relacionados. Sus artículos atraen una audiencia masiva de más de un millón de usuarios cada mes. Parece ser un experto con 10 años de experiencia en SEO y marketing digital. Damir ha sido mencionado en Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto y otras publicaciones. Viaja entre los Emiratos Árabes Unidos, Turquía, Rusia y la CEI como nómada digital. Damir obtuvo una licenciatura en física, que él cree que le ha dado las habilidades de pensamiento crítico necesarias para tener éxito en el panorama siempre cambiante de Internet.