Stability AI's Stable Diffusion 2-algoritmen er endelig offentlig: ny depth2img-model, opskalerer i superopløsning, intet voksenindhold

Kort sagt

Stable Diffusion 2.0-modellen er hurtigere, open source, skalerbar, mere robust end den forrige

Stable Diffusion bliver GPU-klar med nye funktioner til realtidsgengivelse

Dybdestyret stable diffusion model – Billede-til-billede med nye ideer til kreative applikationer

Stability AI har frigivet et nyt papir på sin blog om Stable Diffusion 2. I den, Stability AI foreslår en ny algoritme, der er mere effektiv og robust end den forrige, mens den sammenlignes med andre avancerede metoder.

CompVis' original Stable Diffusion V1-model revolutioneret karakteren af open source AI modeller og producerede hundredvis af forskellige modeller og fremskridt rundt om i verden. Det oplevede en af de hurtigste stigninger til 10,000 Github-stjerner, og samlede 33,000 på mindre end to måneder, hurtigere end flere programmer på Github.

Den oprindelige Stable Diffusion V1-udgivelsen blev ledet af det dynamiske team af Robin Rombach (Stability AI) og Patrick Esser (Runway ML) fra CompVis Group ved LMU München, ledet af prof. Dr. Björn Ommer. De byggede videre på laboratoriets tidligere arbejde med Latent Diffusionsmodeller og modtog kritisk støtte fra LAION og Eleuther AI.

Hvad laver Stable Diffusion v1 forskellig fra Stable Diffusion v2?

Stable Diffusion 2.0 indeholder en række væsentlige forbedringer og funktioner i forhold til den tidligere version, så lad os tage et kig på dem.

Stable Diffusion 2.0-udgivelsen indeholder robuste tekst-til-billede-modeller trænet med en frisk ny tekstkoder (OpenCLIP) udviklet af LAION med assistance fra Stability AI, hvilket markant forbedrer kvaliteten af genererede billeder i forhold til tidligere V1-udgivelser. Denne udgivelses tekst-til-billede-modeller kan udskrive billeder med standardopløsninger på 512×512 pixels og 768×768 pixels.

Disse modeller trænes ved hjælp af en æstetisk delmængde af LAION-5B-datasættet genereret af Stability AI's DeepFloyd-team, som derefter filtreres for at udelukke voksenindhold ved hjælp af LAIONs NSFW-filter.

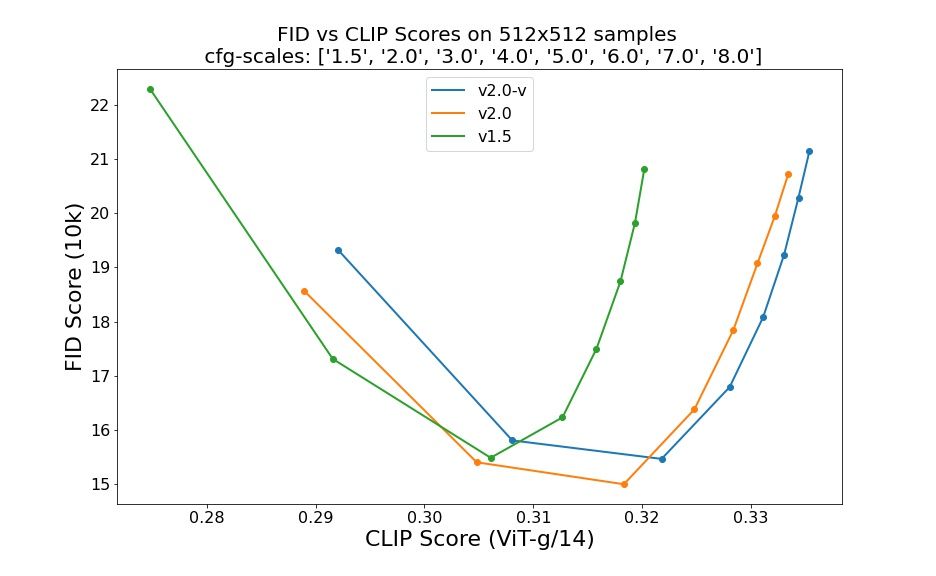

Evalueringer ved hjælp af 50 DDIM prøvetrin, 50 klassificeringsfrie vejledende skalaer og 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 og 8.0 indikerer relative forbedringer af kontrolpunkterne:

Stable Diffusion 2.0 inkorporerer nu en Upscaler Diffusion-model, som øger billedopløsningen med en faktor på fire. Et eksempel på vores model opskalering et lavkvalitetsgenereret billede (128×128) til et billede med højere opløsning er vist nedenfor (512×512). Stable Diffusion 2.0, når det kombineres med vores tekst-til-billede-modeller, kan nu generere billeder med opløsninger på 2048×2048 eller højere.

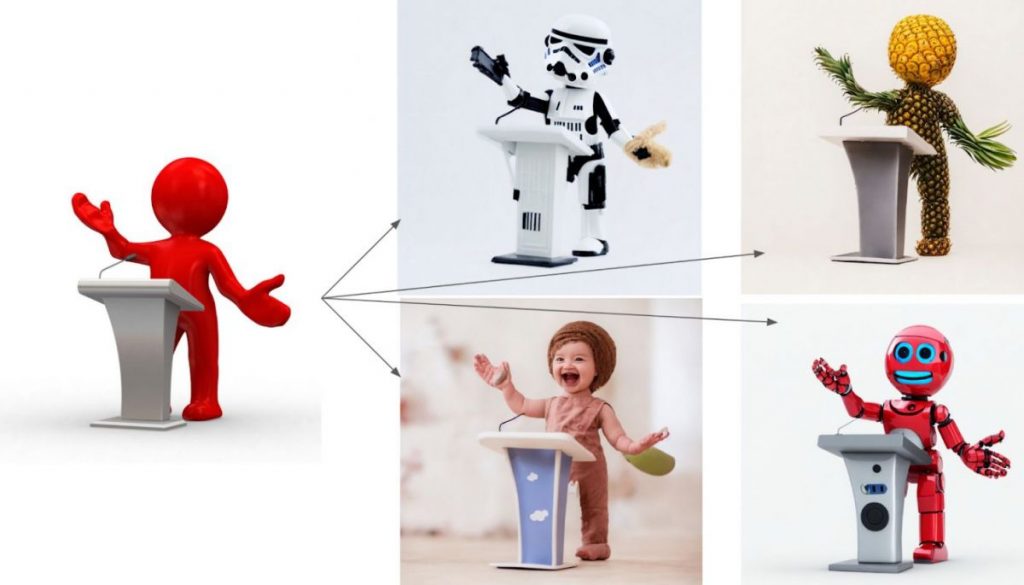

Den nye dybdestyrede stable diffusion model, depth2img, udvider den tidligere billed-til-billede-funktion fra V1 med helt nye kreative muligheder. Depth2img bestemmer dybden af et inputbillede (ved hjælp af en eksisterende model) og genererer derefter nye billeder baseret på både teksten og dybdeinformationen. Depth-to-Image kan give et væld af nye kreative applikationer, der tilbyder ændringer, der virker væsentligt anderledes end originalen, samtidig med at billedets sammenhæng og dybde bevares.

Hvad er nyt i Stable Diffusion 2?

- Den nye stable diffusion model tilbyder en opløsning på 768×768.

- U-Net har samme mængde parametre som version 1.5, men det er trænet fra bunden og bruger OpenCLIP-ViT/H som sin tekstkoder. En såkaldt v-forudsigelsesmodel er SD 2.0-v.

- Den førnævnte model blev justeret fra SD 2.0-base, som også er gjort tilgængelig og blev trænet som en typisk støj-forudsigelsesmodel på 512×512 billeder.

- En latent tekststyret diffusionsmodel med x4-skalering er blevet tilføjet.

- Raffineret SD 2.0-base dybdestyret stable diffusion model. Modellen kan bruges til strukturbevarende img2img og formbetinget syntese og er betinget af monokulære dybdeestimater udledt af MiDaS.

- En forbedret tekststyret malingsmodel bygget på SD 2.0-fundamentet.

Udviklere arbejdede hårdt, ligesom den første iteration af Stable Diffusion, for at optimere modellen til at køre på en enkelt GPU – de ønskede fra starten at gøre den tilgængelig for så mange mennesker som muligt. De har allerede set, hvad der sker, når millioner af individer får fingrene i disse modeller og samarbejder om at bygge helt bemærkelsesværdige ting. Dette er kraften ved open source: at udnytte det enorme potentiale hos millioner af talentfulde mennesker, som måske ikke har ressourcerne til at træne en banebrydende model, men som har evnen til at gøre utrolige ting med en.

Denne nye opdatering, kombineret med kraftfulde nye funktioner som depth2img og bedre opløsningsopskaleringsfunktioner, vil tjene som grundlaget for et væld af nye applikationer og muliggøre en eksplosion af nyt kreativt potentiale.

Læs mere om Stable Diffusion:

Ansvarsfraskrivelse

I tråd med den Trust Project retningslinjer, bemærk venligst, at oplysningerne på denne side ikke er beregnet til at være og ikke skal fortolkes som juridiske, skattemæssige, investeringsmæssige, finansielle eller nogen anden form for rådgivning. Det er vigtigt kun at investere, hvad du har råd til at tabe, og at søge uafhængig finansiel rådgivning, hvis du er i tvivl. For yderligere information foreslår vi at henvise til vilkårene og betingelserne samt hjælpe- og supportsiderne fra udstederen eller annoncøren. MetaversePost er forpligtet til nøjagtig, objektiv rapportering, men markedsforholdene kan ændres uden varsel.

Om forfatteren

Damir er teamleder, produktchef og redaktør på Metaverse Post, der dækker emner som AI/ML, AGI, LLM'er, Metaverse og Web3-relaterede felter. Hans artikler tiltrækker et massivt publikum på over en million brugere hver måned. Han ser ud til at være en ekspert med 10 års erfaring i SEO og digital markedsføring. Damir er blevet nævnt i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto og andre publikationer. Han rejser mellem UAE, Tyrkiet, Rusland og SNG som en digital nomade. Damir tog en bachelorgrad i fysik, som han mener har givet ham de kritiske tænkningskompetencer, der er nødvendige for at få succes i internettets evigt skiftende landskab.

Flere artikler

Damir er teamleder, produktchef og redaktør på Metaverse Post, der dækker emner som AI/ML, AGI, LLM'er, Metaverse og Web3-relaterede felter. Hans artikler tiltrækker et massivt publikum på over en million brugere hver måned. Han ser ud til at være en ekspert med 10 års erfaring i SEO og digital markedsføring. Damir er blevet nævnt i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto og andre publikationer. Han rejser mellem UAE, Tyrkiet, Rusland og SNG som en digital nomade. Damir tog en bachelorgrad i fysik, som han mener har givet ham de kritiske tænkningskompetencer, der er nødvendige for at få succes i internettets evigt skiftende landskab.