Tekst-til-video AI-model

Hvad er tekst-til-video AI-model?

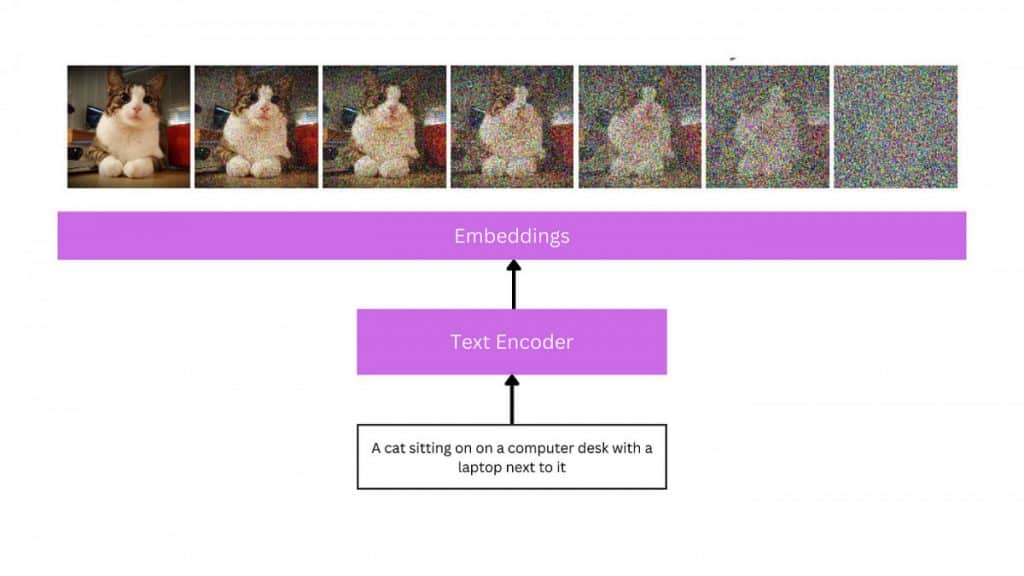

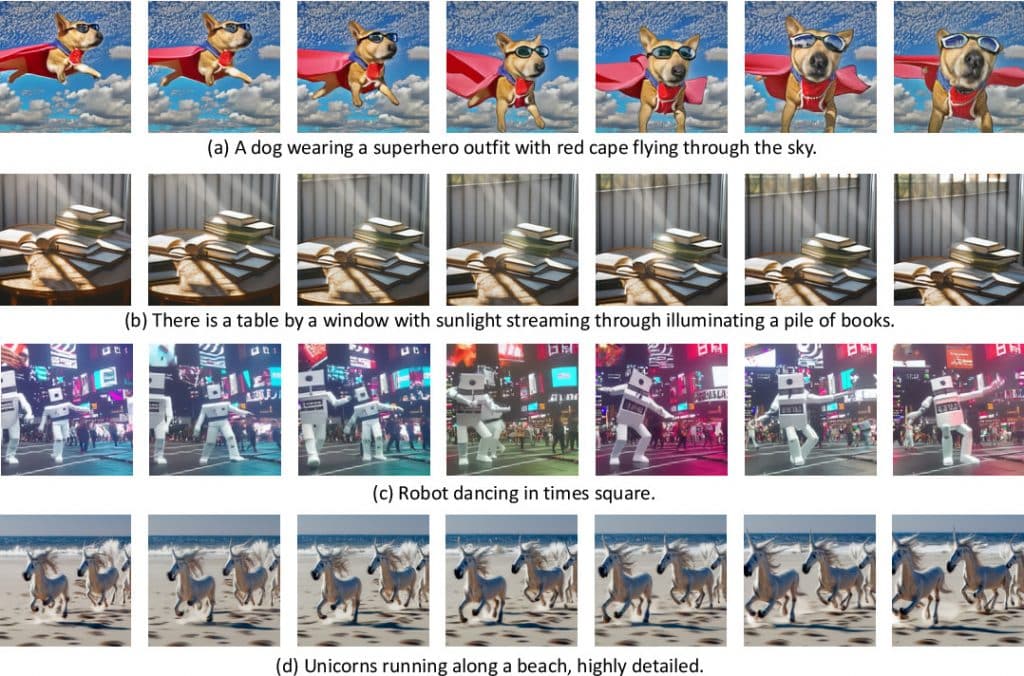

Spørgsmål med naturligt sprog er input, der bruges af tekst-til-video-modeller til at skabe videoer. Disse modeller forstår konteksten og semantikken af inputteksten og producerer derefter en tilsvarende videosekvens ved hjælp af sofistikeret machine learning, dyb læring eller tilbagevendende neurale netværkstilgange. Tekst-til-video er et område i hastig udvikling, som kræver enorme mængder data og processorkraft at træne. De kan bruges til at hjælpe med filmfremstillingsprocessen eller til at producere underholdende eller salgsfremmende videoer.

Forståelse af tekst-til-video AI-model

I lighed med tekst-til-billede-problematikken er tekst-til-video-produktion kun blevet undersøgt i nogle få år på dette tidspunkt. Tidligere undersøgelser genererede for det meste frames med billedtekster autoregressivt ved hjælp af GAN- og VAE-baserede teknikker. Disse undersøgelser er begrænset til lav opløsning, kort rækkevidde og unikke, isolerede bevægelser, selvom de lagde grunden til et nyt computersynsproblem.

Den følgende bølge af tekst-til-video generationsforskning brugte transformerstrukturer, tegnet af succesen med storskala fortrænede transformatormodeller i tekst (GPT-3) og billede (DALL-E). Mens værker som TATS præsenterer hybride tilgange, der inkluderer VQGAN til billedoprettelse med et tidsfølsomt transformermodul til sekventiel frame generation, Phenaki, Make-A-Video, NUWA, VideoGPT, og CogVideo foreslår alle transformer-baserede rammer. Phenaki, et af værkerne i denne anden bølge, er særligt spændende, da det giver en mulighed for at skabe vilkårligt lange film baseret på en række opfordringer eller en fortælling. På samme måde tillader NUWA-Infinity skabelsen af udvidede, høj-defifilm ved at foreslå en autoregressiv over autoregressiv genereringsteknik til endeløs billed- og videosyntese fra tekstinput. NUWA- og Phenaki-modellerne er dog ikke tilgængelige for offentligheden.

Størstedelen af tekst-til-video-modeller i den tredje og nuværende bølge inkluderer diffusionsbaserede topologier. Diffusionsmodeller har vist imponerende resultater i at generere rige, hyperrealistiske og varierede billeder. Dette har vakt interesse for at anvende diffusionsmodeller til andre domæner, herunder lyd, 3D og, for nylig, video. Video Diffusion Models (VDM), som udvider diffusionsmodeller til videodomænet, og MagicVideo, som foreslår en ramme til produktion af videoklip i et lavdimensionelt latent rum og hævder betydelige effektivitetsfordele i forhold til VDM, er forløberne for denne generation af modeller . Et andet bemærkelsesværdigt eksempel er Tune-a-Video, som gør det muligt at bruge ét tekst-video-par til at finjustere en fortrænet tekst-til-billede-model og giver mulighed for at ændre videoindholdet, mens man bevarer bevægelse.

Fremtiden for tekst-til-video AI-model

Hollywoods tekst-til-video og kunstig intelligens (AI) fremtiden er fuld af muligheder og vanskeligheder. Vi kan forvente meget mere komplekse og naturtro AI-genererede videoer, efterhånden som disse generative AI-systemer udvikler sig og bliver dygtigere til at producere videoer fra tekstprompter. De muligheder, som programmer som Runways Gen2, NVIDIAs NeRF og Googles Transframer tilbyder, er kun toppen af isbjerget. Mere komplekse følelsesmæssige udtryk, videoredigering i realtid og endda kapaciteten til at skabe spillefilm i fuld længde ud fra en tekstprompt er mulige fremtidige udviklinger. For eksempel kan storyboard-visualisering under præproduktion udføres med tekst-til-video-teknologi, hvilket giver instruktører adgang til en ufærdig version af en scene, før den optages. Dette kan resultere i ressource- og tidsbesparelser, hvilket forbedrer effektiviteten af filmfremstillingsprocessen. Disse værktøjer kan også bruges til hurtigt og overkommeligt at producere videomateriale af høj kvalitet af marketing- og reklamemæssige årsager. De kan også bruges til at skabe fængslende videoer.

Seneste nyt om tekst-til-video AI-model

- Zeroscope, en gratis og open source tekst-til-video-teknologi, er en konkurrent til Runway ML's Gen-2. Det sigter mod at omdanne skrevne ord til dynamiske billeder, der tilbyder højere opløsning og et tættere 16:9 billedformat. Tilgængelig i to versioner, Zeroscope_v2 567w og Zeroscope_v2 XL, kræver den 7.9 GB VRam og introducerer offset støj for at forbedre datafordelingen. Zeroscope er et levedygtigt open source-alternativ til Runways Gen-2, der tilbyder et mere varieret udvalg af realistiske videoer.

- VideodirektørGPT er en innovativ tilgang til tekst-til-video-generering, der kombinerer store sprogmodeller (LLM'er) med videoplanlægning for at skabe præcise og konsistente videoer med flere scener. Den bruger LLM'er som en historiefortællingsmester, der laver tekstbeskrivelser på sceneniveau, objektlister og ramme-for-ramme-layout. Layout2Vid, et videogenereringsmodul, giver rumlig kontrol over objektlayouts. Yandex’ Masterpiece og Runway’s Gen-2-modeller tilbyder tilgængelighed og enkelhed, samtidig med at de forbedrer indholdsskabelse og deling på sociale medieplatforme.

- Yandex har introduceret en ny funktion kaldet Masterpiece, som giver brugerne mulighed for at lave korte videoer, der varer op til 4 sekunder med en billedhastighed på 24 billeder i sekundet. Teknologien bruger den kaskadede diffusionsmetode til at lave efterfølgende videoframes, hvilket giver brugerne mulighed for at generere en bred vifte af indhold. Masterpiece-platformen supplerer eksisterende muligheder, herunder billedoprettelse og tekstindlæg. Det neurale netværk genererer videoer gennem tekstbaserede beskrivelser, billedvalg og automatiseret generering. Funktionen har vundet popularitet og er i øjeblikket udelukkende tilgængelig for aktive brugere.

Seneste sociale indlæg om tekst-til-video AI-model

Ansvarsfraskrivelse

I tråd med den Trust Project retningslinjer, bemærk venligst, at oplysningerne på denne side ikke er beregnet til at være og ikke skal fortolkes som juridiske, skattemæssige, investeringsmæssige, finansielle eller nogen anden form for rådgivning. Det er vigtigt kun at investere, hvad du har råd til at tabe, og at søge uafhængig finansiel rådgivning, hvis du er i tvivl. For yderligere information foreslår vi at henvise til vilkårene og betingelserne samt hjælpe- og supportsiderne fra udstederen eller annoncøren. MetaversePost er forpligtet til nøjagtig, objektiv rapportering, men markedsforholdene kan ændres uden varsel.

Om forfatteren

Viktoriia er en forfatter om en række teknologiske emner, herunder Web3.0, AI og kryptovalutaer. Hendes store erfaring giver hende mulighed for at skrive indsigtsfulde artikler til et bredere publikum.

Flere artikler

Viktoriia er en forfatter om en række teknologiske emner, herunder Web3.0, AI og kryptovalutaer. Hendes store erfaring giver hende mulighed for at skrive indsigtsfulde artikler til et bredere publikum.