8 ting du bør vide om store sprogmodeller

Kort sagt

Store sprogmodeller (LLM'er) bruges til at udforske nuancerne af naturligt sprog, forbedre maskinernes evne til at forstå og generere tekst og automatisere opgaver såsom stemmegenkendelse og maskinoversættelse.

Der er ingen nem løsning til at administrere LLM'er, men de er lige så dygtige som mennesker.

Med en stigning i udviklingen af naturlig sprogbehandling og dens brug i erhvervslivet er der en stigende interesse for store sprogmodeller. Disse modeller bruges til at udforske nuancerne af naturligt sprog, forbedre maskinernes evne til at forstå og generere tekst og automatisere opgaver såsom stemmegenkendelse og maskinoversættelse. Her er otte vigtige ting, du bør vide om store sprogmodeller (LLM).

- LLM'er er mere "dygtige", da omkostningerne bliver ved med at stige

- Et hurtigt kig på hvordan GPT modeller tilpasses efterhånden som uddannelsesomkostningerne stiger

- LLM'er lærer at spille brætspil ved at bruge repræsentationer af omverdenen

- Der er ingen nem løsning til at administrere LLM

- Eksperter har problemer med at forklare, hvordan LLM fungerer

- LLM'er er lige så dygtige som mennesker

- LLM'er skal være mere end blot "jack-of-all-trades"

- Modeller er 'klogere' end folk tror baseret på første indtryk

LLM'er er mere "dygtige", da omkostningerne bliver ved med at stige

LLM'er bliver forudsigeligt mere "dygtige" med stigende omkostninger, selv uden fede innovationer. Det vigtigste her er forudsigelighed, som blev vist i artiklen om GPT-4: Fem til syv små modeller blev undervist med et budget på 0.1% af den endelige, og så blev der lavet en forudsigelse for en kæmpe model baseret på dette. For en generel vurdering af forvirring og metrikker på en delprøve af en specifik opgave var en sådan forudsigelse meget nøjagtig. Denne forudsigelighed er vigtig for virksomheder og organisationer, der er afhængige af LLM'er til deres drift, da de kan budgettere i overensstemmelse hermed og planlægge fremtidige udgifter. Det er dog vigtigt at bemærke, at selvom stigende omkostninger kan føre til forbedrede kapaciteter, kan forbedringshastigheden i sidste ende stige, hvilket gør det nødvendigt at investere i nye innovationer for at fortsætte fremskridt.

Et hurtigt kig på hvordan GPT modeller tilpasses efterhånden som uddannelsesomkostningerne stiger

Imidlertid har specifikke vigtige færdigheder en tendens til at dukke uforudsigeligt op som et biprodukt af stigning uddannelsesomkostninger (længere træning, flere data, større model) — det er næsten umuligt at forudsige, hvornår modeller vil begynde at udføre visse opgaver. Vi udforskede emnet mere i dybden i vores artikel om historien om udviklingen af GPT modeller. Billedet viser fordelingen af kvalitetsstigningen på modeller på tværs af forskellige opgaver. Det er kun de store modeller, der kan lære at udføre forskellige opgaver. Denne graf fremhæver den betydelige virkning af opskalering af størrelsen på GPT modeller på deres præstationer på tværs af forskellige opgaver. Det er dog vigtigt at bemærke, at dette kommer på bekostning af øgede beregningsressourcer og miljøpåvirkning.

LLM'er lærer at spille brætspil ved at bruge repræsentationer af omverdenen

LLM'er lærer og bruger ofte repræsentationer af omverdenen. Der er mange eksempler her, og her er et af dem: Modeller trænet at spille brætspil baseret på beskrivelser af individuelle træk, uden nogensinde at se et billede af spillefeltet, lære interne repræsentationer af brættets tilstand ved hvert træk. Disse interne repræsentationer kan så bruges til forudsige fremtiden bevægelser og resultater, hvilket giver modellen mulighed for at spille spillet på et højt niveau. Denne evne til at lære og bruge repræsentationer er en nøgle aspekt af maskinlæring og kunstig intelligens.

Der er ingen nem løsning til at administrere LLM

Der er ingen pålidelige metoder til at kontrollere LLM-adfærd. Selvom der er sket nogle fremskridt med at forstå og afhjælpe forskellige problemer (inklusive ChatGPT , GPT-4 ved hjælp af feedback), er der ikke konsensus om, hvorvidt vi kan løse dem. Der er stigende bekymring for, at dette vil blive et enormt, potentielt katastrofalt problem i fremtiden, når endnu større systemer skabes. Derfor udforsker forskere nye metoder til at sikre, at AI-systemer stemmer overens med menneskelige værdier og mål, såsom værditilpasning og belønningsteknik. Det er dog stadig en udfordrende opgave at garantere sikkerhed og pålidelighed af LLM'er i komplekse scenarier i den virkelige verden.

Eksperter har problemer med at forklare, hvordan LLM fungerer

Eksperter kan endnu ikke fortolke LLM's indre funktioner. Ingen teknik ville tillade os at angive på nogen tilfredsstillende måde, hvilken slags viden, ræsonnement eller mål modellen bruger, når den genererer et resultat. Denne mangel på fortolkning giver anledning til bekymringer om pålideligheden og retfærdigheden af LLM's beslutninger, især i applikationer med høj indsats såsom strafferetspleje eller kreditvurdering. Det fremhæver også behovet for yderligere forskning i udvikling af mere gennemsigtige og ansvarlige AI-modeller.

LLM'er er lige så dygtige som mennesker

Selvom LLM'er er uddannet primært til efterligne menneskelig adfærd, når du skriver tekst, de har potentialet til at overgå os i mange opgaver. Dette kan allerede ses, når man spiller skak eller Go. Dette skyldes deres evne til at analysere enorme mængder data og træffe beslutninger baseret på den analyse med en hastighed, som mennesker ikke kan matche. Men LLM'er mangler stadig den kreativitet og intuition, som mennesker besidder, hvilket gør dem mindre egnede til mange opgaver.

LLM'er skal være mere end blot "jack-of-all-trades"

LLM'er må ikke udtrykke værdierne for deres skabere eller de værdier, der er kodet i et udvalg fra internettet. De bør ikke gentage stereotyper eller konspirationsteorier eller søge at fornærme nogen. I stedet bør LLM'er udformes til at give upartiske og faktuelle oplysninger til deres brugere, mens de respekterer kulturelle og samfundsmæssige forskelle. Derudover bør de gennemgå regelmæssig test og overvågning for at sikre, at de fortsat opfylder disse standarder.

Modeller er 'klogere' end folk tror baseret på første indtryk

Estimater af en models evne baseret på første indtryk er ofte vildledende. Meget ofte skal du komme med den rigtige prompt, foreslå en model og måske vise eksempler, og den vil begynde at klare sig meget bedre. Det vil sige, at det er "smartere", end det ser ud ved første øjekast. Derfor er det afgørende at give modellen en fair chance og give den de nødvendige ressourcer til at yde sit bedste. Med den rigtige tilgang kan selv tilsyneladende utilstrækkelige modeller overraske os med deres evner.

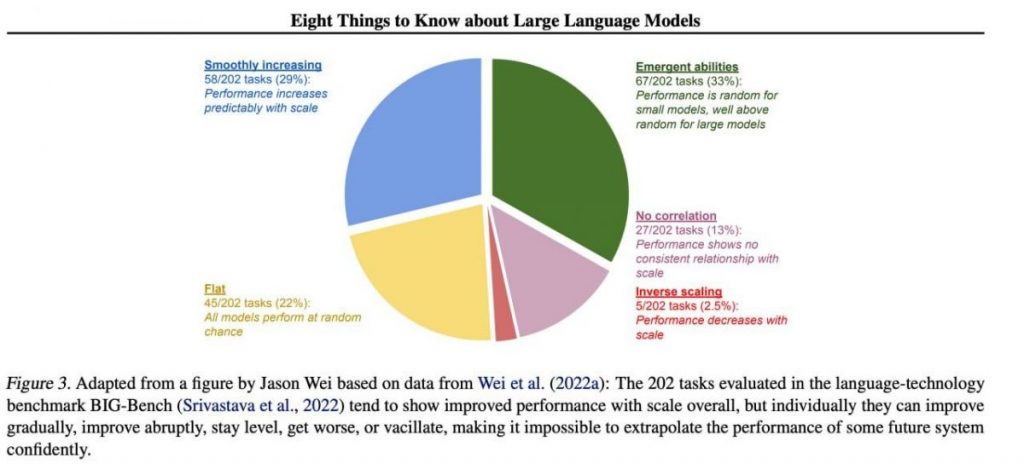

Hvis vi fokuserer på en prøve på 202 opgaver fra BIG-Bench-datasættet (det blev specielt gjort vanskeligt at teste sprogmodeller fra og til), så viser modellerne som regel (i gennemsnit) en kvalitetsstigning med stigende skala, men hver for sig kan metrikken i opgaverne:

- forbedres gradvist,

- forbedre drastisk,

- Forbliv uændret,

- formindske,

- viser ingen sammenhæng.

Alt dette fører til umuligheden af sikkert at ekstrapolere ydeevnen af ethvert fremtidigt system. Den grønne del er især interessant — det er netop her, kvalitetsindikatorerne springer kraftigt op uden grund overhovedet.

Læs mere om AI:

Ansvarsfraskrivelse

I tråd med den Trust Project retningslinjer, bemærk venligst, at oplysningerne på denne side ikke er beregnet til at være og ikke skal fortolkes som juridiske, skattemæssige, investeringsmæssige, finansielle eller nogen anden form for rådgivning. Det er vigtigt kun at investere, hvad du har råd til at tabe, og at søge uafhængig finansiel rådgivning, hvis du er i tvivl. For yderligere information foreslår vi at henvise til vilkårene og betingelserne samt hjælpe- og supportsiderne fra udstederen eller annoncøren. MetaversePost er forpligtet til nøjagtig, objektiv rapportering, men markedsforholdene kan ændres uden varsel.

Om forfatteren

Damir er teamleder, produktchef og redaktør på Metaverse Post, der dækker emner som AI/ML, AGI, LLM'er, Metaverse og Web3-relaterede felter. Hans artikler tiltrækker et massivt publikum på over en million brugere hver måned. Han ser ud til at være en ekspert med 10 års erfaring i SEO og digital markedsføring. Damir er blevet nævnt i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto og andre publikationer. Han rejser mellem UAE, Tyrkiet, Rusland og SNG som en digital nomade. Damir tog en bachelorgrad i fysik, som han mener har givet ham de kritiske tænkningskompetencer, der er nødvendige for at få succes i internettets evigt skiftende landskab.

Flere artikler

Damir er teamleder, produktchef og redaktør på Metaverse Post, der dækker emner som AI/ML, AGI, LLM'er, Metaverse og Web3-relaterede felter. Hans artikler tiltrækker et massivt publikum på over en million brugere hver måned. Han ser ud til at være en ekspert med 10 års erfaring i SEO og digital markedsføring. Damir er blevet nævnt i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto og andre publikationer. Han rejser mellem UAE, Tyrkiet, Rusland og SNG som en digital nomade. Damir tog en bachelorgrad i fysik, som han mener har givet ham de kritiske tænkningskompetencer, der er nødvendige for at få succes i internettets evigt skiftende landskab.