Facebook desenvolupa un nou mètode per duplicar el rendiment dels transformadors d'IA

En breu

Facebook ha desenvolupat un nou mètode per duplicar el rendiment dels transformadors d'IA basat en l'arquitectura del transformador.

El nou mètode troba els pegats més similars als buits entre el processament de diferents blocs i els combina per reduir la complexitat computacional.

Facebook ha desenvolupat un nou mètode per duplicar el rendiment dels transformadors AI. El mètode és basat en l'arquitectura del transformador i està dissenyat específicament per a textos llargs com ara llibres, articles i blocs. L'objectiu del nou transformador d'IA és millorar el rendiment de models basats en transformadors en text llarg, fent-los més eficients i eficaços a l'hora de manejar seqüències llargues. Els resultats del transformador d'IA són molt prometedors, i aquest nou mètode té l'oportunitat d'ajudar a millorar el rendiment dels models basats en transformadors en una varietat de tasques.

S'espera que aquest nou mètode tingui un impacte significatiu en les tasques de processament del llenguatge natural, com ara la traducció del llenguatge, el resum i els sistemes de resposta a preguntes. També s'espera que condueixi al desenvolupament de models d'IA més sofisticats que puguin gestionar textos més llargs i complexos.

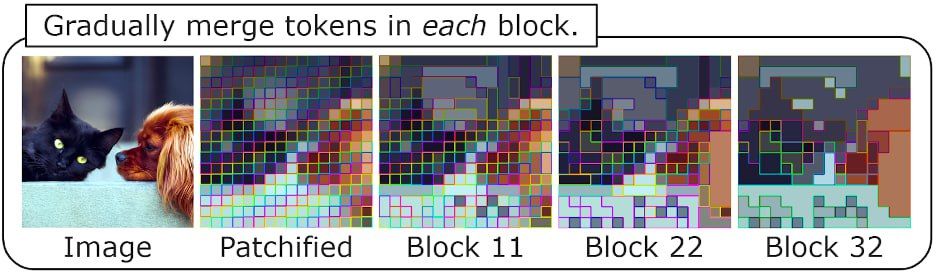

Per processar la imatge, els transformadors moderns la tallen en pedaços (generalment quadrats: vegeu el gif a continuació) i després operen amb representacions d'aquestes partícules, cadascuna de les quals està representada per un "token". Els transformadors, com sabem, funcionen més lentament com més peces hi ha d'aquestes fitxes (això s'aplica tant als textos com a les imatges), i el transformador més comú té una relació quadràtica. És a dir, a mesura que s'afegeixen més fitxes, més lent es fa el processament. Per abordar aquest problema, els investigadors han proposat diverses tècniques per reduir el nombre de fitxes necessaris per al processament d'imatges, com ara l'agrupació jeràrquica i adaptativa. Aquests mètodes tenen com a objectiu mantenir la qualitat de la sortida alhora que minimitzen el cost computacional.

El nou mètode troba els pegats més similars als buits entre el processament de diferents blocs i els combina per reduir la complexitat computacional. La quota de fitxes combinades és un hiperparàmetre; com més alt sigui, més baixa serà la qualitat però també major serà l'acceleració. Els experiments mostren que és possible combinar aproximadament el 40% dels fitxes amb una pèrdua de qualitat del 0.1 al 0.4% i obtenir una acceleració doble (consumint així menys memòria). Aquest nou mètode és una solució prometedora per reduir la complexitat computacional del processament d'imatges i podria permetre un processament més ràpid i eficient sense comprometre la qualitat de la sortida final.

Aquests enfocaments d'enginyeria basats en l'enginy i la comprensió de com funciona alguna cosa semblen molt atractius. A més, els desenvolupadors de Meta prometen aportar més a StableDiffusion per tal d'accelerar les coses també. És increïble que, com que els transformadors estan a tot arreu, aquests trucs es puguin implementar ràpidament en una àmplia gamma de models. Això mostra el potencial de les solucions d'enginyeria per tenir un impacte ampli en diverses indústries. Serà interessant veure com es fan aquests avenços models de transformadors seguirà evolucionant i millorant amb el temps.

- Meta AI i Paperswithcode han llançat el primer model 120B Galactica entrenat en textos científics, permetent prediccions més precises i ràpides. L'objectiu de Galactica és ajudar els investigadors a separar l'important de l'irrellevant.

Llegeix més notícies relacionades:

renúncia

En línia amb la Directrius del projecte Trust, si us plau, tingueu en compte que la informació proporcionada en aquesta pàgina no pretén ni s'ha d'interpretar com a assessorament legal, fiscal, d'inversió, financer o de cap altra forma. És important invertir només el que et pots permetre perdre i buscar assessorament financer independent si tens dubtes. Per obtenir més informació, us suggerim que feu referència als termes i condicions, així com a les pàgines d'ajuda i assistència proporcionades per l'emissor o l'anunciant. MetaversePost es compromet a fer informes precisos i imparcials, però les condicions del mercat estan subjectes a canvis sense previ avís.

About The Autor

Damir és el líder d'equip, cap de producte i editor de Metaverse Post, que cobreix temes com AI/ML, AGI, LLMs, Metaverse i Web3-camps relacionats. Els seus articles atrauen una audiència massiva de més d'un milió d'usuaris cada mes. Sembla ser un expert amb 10 anys d'experiència en SEO i màrqueting digital. Damir ha estat esmentat a Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i altres publicacions. Viatja entre els Emirats Àrabs Units, Turquia, Rússia i la CEI com a nòmada digital. Damir va obtenir una llicenciatura en física, que creu que li ha donat les habilitats de pensament crític necessàries per tenir èxit en el paisatge en constant canvi d'Internet.

més articles

Damir és el líder d'equip, cap de producte i editor de Metaverse Post, que cobreix temes com AI/ML, AGI, LLMs, Metaverse i Web3-camps relacionats. Els seus articles atrauen una audiència massiva de més d'un milió d'usuaris cada mes. Sembla ser un expert amb 10 anys d'experiència en SEO i màrqueting digital. Damir ha estat esmentat a Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto i altres publicacions. Viatja entre els Emirats Àrabs Units, Turquia, Rússia i la CEI com a nòmada digital. Damir va obtenir una llicenciatura en física, que creu que li ha donat les habilitats de pensament crític necessàries per tenir èxit en el paisatge en constant canvi d'Internet.