Lätt-till-svår generalisering

Vad är lätt-till-svår generalisering?

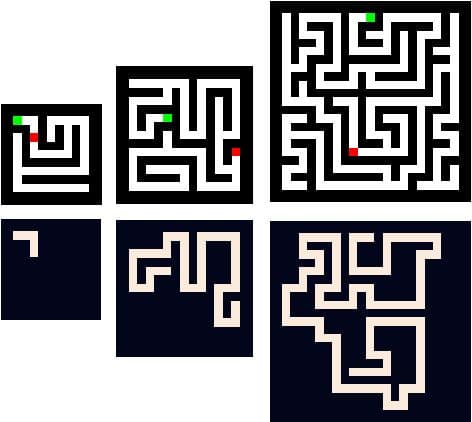

Lätt-till-hård generalisering hänvisar till processen att utvärdera prestanda hos algoritmer på uppgifter som varierar i komplexitet, från enkla och hanterbara till mer utmanande. I samband med AI-utveckling hjälper detta tillvägagångssätt att säkerställa att modeller inte bara är effektiva för att hantera enkla uppgifter utan också kan skala sitt beteende när de står inför mer komplexa utmaningar.

Förstå lätt-till-svår generalisering

Tänk till exempel på scenariot där en modell testas för uppgiften att identifiera buggar i en liten bit kod.

Till exempel, inom maskininlärning, kan lätt till svår generalisering innebära att man tränar en modell på en datauppsättning som börjar med enkla eller väl åtskilda exempel och gradvis introducerar mer komplexa eller överlappande exempel. Detta tillvägagångssätt syftar till att förbättra modellens förmåga att hantera utmanande scenarier och förbättra dess övergripande prestanda på osynliga data.

Inom perceptuell inlärning kan lätt-till-hård generalisering innebära att man tränar individer i perceptuella uppgifter som börjar med lätt urskiljbara stimuli och gradvis introducerar svårare eller tvetydigare stimuli. Denna process hjälper individer att utveckla bättre diskrimineringsförmåga och generalisera sitt lärande till ett bredare spektrum av stimuli.

Sammantaget är lätt-till-hård generalisering en strategi som används för att förbättra inlärningen, förbättra prestanda och främja bättre generaliseringsförmåga genom att gradvis öka svårigheten eller komplexiteten hos exempel eller uppgifter.

Senaste nytt om Lätt-till-svår generalisering

- Forskare från University College London har infört Spawrious dataset, en bildklassificering riktmärke svit, för att ta itu med falska korrelationer i AI-modeller. Datauppsättningen, som består av 152,000 2 bilder av hög kvalitet, innehåller både en-till-en och många-till-många falska korrelationer. Teamet fann att datamängden visade otrolig prestanda och avslöjade svagheterna hos nuvarande modeller på grund av deras beroende av fiktiva bakgrunder. Datauppsättningen lyfte också fram behovet av att fånga de intrikata relationerna och ömsesidiga beroenden i MXNUMXM falska korrelationer.

- Den nya AI, känd som en Differential Neural Computer (DNC), förlitar sig på en extern minnesenhet med hög genomströmning för att lagra tidigare inlärda modeller och generera nya neurala nätverk baserade på arkiverade modeller. Denna nya form av generaliserat lärande kan bana väg för en era av AI som kommer att anstränga den mänskliga fantasin.

- En färsk tidning från MIT fann det GPT-4, en språkmodell (LLM) som fick 100 % i MIT:s läroplan, hade ofullständiga frågor och partiska utvärderingsmetoder, vilket resulterade i betydligt lägre noggrannhet. Allen Institute for AI:s "Faith and Fate: Limits of Transformers on Compositionality" diskuterar begränsningarna hos transformatorbaserade modeller, med fokus på kompositionsproblem som kräver flerstegsresonemang. Studien fann att transformatormodeller visar en minskning i prestanda när uppgiftens komplexitet ökar, och finjustering med uppgiftsspecifika data förbättrar prestandan inom den tränade domänen men misslyckas med att generalisera till osynliga exempel. Författarna föreslår att transformatorer bör bytas ut på grund av deras begränsningar i att utföra komplexa kompositionsresonemang, beroende av mönster, memorering och enstegsoperationer.

Senaste sociala inlägg om lätt-till-hård generalisering

Vanliga frågor

Lätt-till-hård Generalisering hänvisar till processen att träna eller lära in modeller, algoritmer eller system genom att gradvis öka svårigheten eller komplexiteten hos exemplen eller uppgifterna. Tanken bakom lätt-till-hård generalisering är att börja med enklare eller enklare exempel och successivt introducera mer utmanande eller svåra sådana för att förbättra modellens förmåga att generalisera och prestera bra på ett brett spektrum av input.

«Tillbaka till ordlistaindexVillkor

I linje med den Riktlinjer för Trust Project, vänligen notera att informationen på den här sidan inte är avsedd att vara och inte ska tolkas som juridisk, skattemässig, investerings-, finansiell eller någon annan form av rådgivning. Det är viktigt att bara investera det du har råd att förlora och att söka oberoende finansiell rådgivning om du har några tvivel. För ytterligare information föreslår vi att du hänvisar till villkoren samt hjälp- och supportsidorna som tillhandahålls av utfärdaren eller annonsören. MetaversePost är engagerad i korrekt, opartisk rapportering, men marknadsförhållandena kan ändras utan föregående meddelande.

Om författaren

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.

fler artiklar

Damir är teamledare, produktchef och redaktör på Metaverse Post, som täcker ämnen som AI/ML, AGI, LLMs, Metaverse och Web3-relaterade områden. Hans artiklar lockar en massiv publik på över en miljon användare varje månad. Han verkar vara en expert med 10 års erfarenhet av SEO och digital marknadsföring. Damir har nämnts i Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto och andra publikationer. Han reser mellan Förenade Arabemiraten, Turkiet, Ryssland och OSS som en digital nomad. Damir tog en kandidatexamen i fysik, som han tror har gett honom de kritiska tänkande färdigheter som behövs för att bli framgångsrik i det ständigt föränderliga landskapet på internet.