Stability AI'S Stable Diffusion 2 Algoritmul este în sfârșit public: nou model depth2img, upscaler super-rezoluție, fără conținut pentru adulți

Pe scurt

Stable Diffusion Modelul 2.0 este mai rapid, open source, scalabil, mai robust decât cel anterior

Stable Diffusion devine pregătit pentru GPU cu funcții noi pentru randarea în timp real

Ghidat în adâncime stable diffusion model – Imagine la imagine cu idei noi pentru aplicații creative

Stability AI are eliberat o nouă lucrare pe blogul său despre Stable Diffusion 2. În ea, Stability AI propune un nou algoritm care este mai eficient și mai robust decât cel anterior, în timp ce îl face comparativ cu alte metode de ultimă generație.

Originalul CompVis Stable Diffusion Modelul V1 revoluționat natura open-source Modele AI și a produs sute de modele și progrese diferite în întreaga lume. A văzut una dintre cele mai rapide urcări la 10,000 de stele Github, strângând 33,000 în mai puțin de două luni, mai rapid decât mai multe programe de pe Github.

Originală Stable Diffusion Lansarea V1 a fost condusă de echipa dinamică a lui Robin Rombach (Stability AI) și Patrick Esser (Runway ML) de la Grupul CompVis de la LMU München, condus de Prof. Dr. Björn Ommer. S-au bazat pe munca anterioară a laboratorului cu Latent Modele de difuzie și a primit sprijin critic din partea LAION și Eleuther AI.

Ceea ce face ca Stable Diffusion v1 diferit de Stable Diffusion v2?

Stable Diffusion 2.0 include o serie de îmbunătățiri și caracteristici semnificative față de versiunea anterioară, așa că haideți să le aruncăm o privire.

Stable Diffusion Versiunea 2.0 oferă modele robuste text-to-image instruite cu un nou codificator de text (OpenCLIP) dezvoltat de LAION cu asistență de la Stability AI, ceea ce îmbunătățește semnificativ calitatea imaginile generate față de versiunile anterioare V1. Modelele text-to-image ale acestei versiuni pot scoate imagini cu rezoluții implicite de 512×512 pixeli și 768×768 pixeli.

Aceste modele sunt antrenate folosind un subset estetic al setului de date LAION-5B generat de Stability AIechipa DeepFloyd a lui, care este apoi filtrată pentru a exclude conținutul pentru adulți folosind filtrul NSFW al LAION.

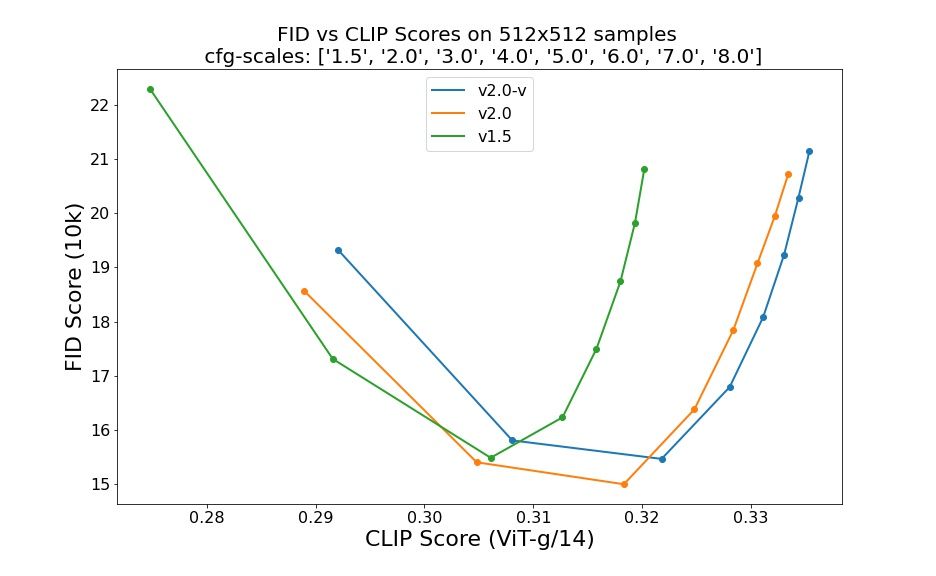

Evaluările care utilizează 50 de pași eșantion DDIM, 50 de scale de ghidare fără clasificator și 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 și 8.0 indică îmbunătățiri relative ale punctelor de control:

Stable Diffusion 2.0 încorporează acum un model Upscaler Diffusion, care mărește rezoluția imaginii cu un factor de patru. Un exemplu al modelului nostru upscaling o imagine generată de calitate scăzută (128×128) într-o imagine cu rezoluție mai mare este afișată mai jos (512×512). Stable Diffusion 2.0, atunci când este combinat cu modelele noastre text-to-image, poate genera acum imagini cu rezoluții de 2048×2048 sau mai mare.

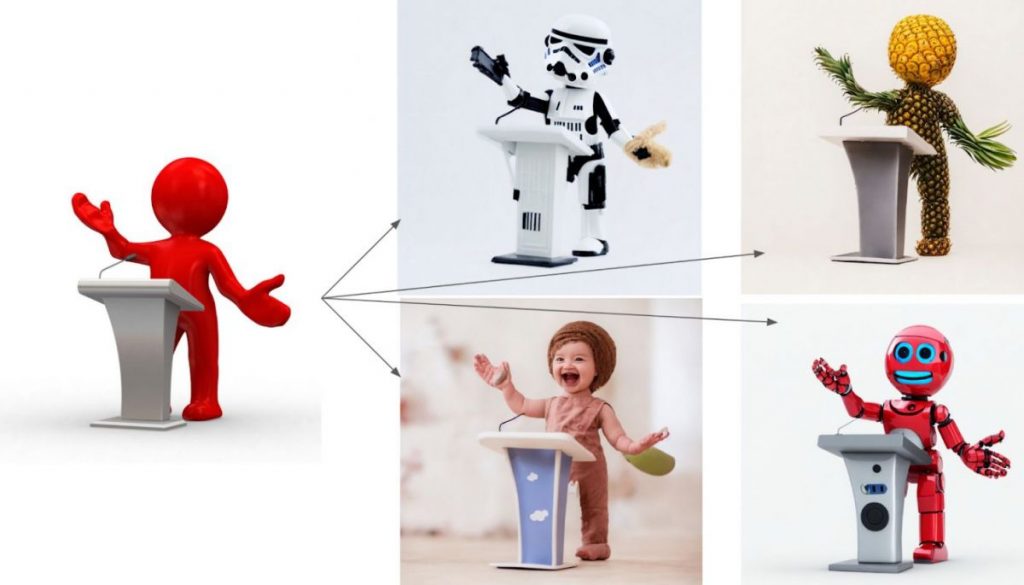

Noul ghidat în adâncime stable diffusion model, depth2img, extinde funcția anterioară imagine-la-imagine de la V1 cu posibilități creative complet noi. Depth2img determină adâncimea unei imagini de intrare (folosind un model existent) și apoi generează noi imagini bazată atât pe text, cât și pe informațiile de profunzime. Depth-to-Image poate oferi o multitudine de noi aplicații creative, oferind modificări care par semnificativ diferite de originalul, păstrând în același timp coerența și profunzimea imaginii.

Ce este nou în Stable Diffusion 2?

- Noul stable diffusion model oferă o rezoluție de 768×768.

- U-Net are aceeași cantitate de parametri ca și versiunea 1.5, dar este antrenat de la zero și folosește OpenCLIP-ViT/H ca codificator de text. Un așa-numit model v-prediction este SD 2.0-v.

- Modelul menționat mai sus a fost ajustat de la baza SD 2.0, care este, de asemenea, disponibil și a fost antrenat ca model tipic de predicție a zgomotului pe imagini 512×512.

- A fost adăugat un model de difuzie latent ghidat de text cu scalare x4.

- Rafinat SD 2.0-bază ghidată de adâncime stable diffusion model. Modelul poate fi utilizat pentru conservarea structurii img2img și sinteza condiționată a formei și este condiționat de estimările adâncimii monoculare deduse de MiDaS.

- Un model îmbunătățit de pictură ghidată de text construit pe fundația SD 2.0.

Dezvoltatorii au muncit din greu, la fel ca la iterația inițială a Stable Diffusion, pentru a optimiza modelul pentru a rula pe un singur GPU — au vrut să-l facă accesibil cât mai multor oameni de la început. Ei au văzut deja ce se întâmplă atunci când milioane de indivizi pun mâna pe aceste modele și colaborează pentru a construi lucruri absolut remarcabile. Aceasta este puterea open source: valorificarea potențialului vast al milioanelor de oameni talentați care nu au resursele pentru a antrena un model de ultimă oră, dar au capacitatea de a face lucruri incredibile cu unul.

Această nouă actualizare, combinată cu funcții noi puternice, cum ar fi depth2img și capabilități de upscaling de rezoluție mai bună, va servi drept fundație pentru o multitudine de aplicații noi și va permite o explozie a noului potențial creativ.

Citiți mai multe despre Stable Diffusion:

Declinare a responsabilităţii

În conformitate cu Ghidurile proiectului Trust, vă rugăm să rețineți că informațiile furnizate pe această pagină nu sunt destinate și nu trebuie interpretate ca fiind consiliere juridică, fiscală, investițională, financiară sau orice altă formă de consiliere. Este important să investești doar ceea ce îți poți permite să pierzi și să cauți sfaturi financiare independente dacă ai îndoieli. Pentru informații suplimentare, vă sugerăm să consultați termenii și condițiile, precum și paginile de ajutor și asistență furnizate de emitent sau agent de publicitate. MetaversePost se angajează să raporteze corecte, imparțial, dar condițiile de piață pot fi modificate fără notificare.

Despre autor

Damir este liderul echipei, manager de produs și editor la Metaverse Post, care acoperă subiecte precum AI/ML, AGI, LLM-uri, Metaverse și Web3-domenii conexe. Articolele sale atrag o audiență masivă de peste un milion de utilizatori în fiecare lună. El pare a fi un expert cu 10 ani de experiență în SEO și marketing digital. Damir a fost menționat în Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto și alte publicații. Călătorește între Emiratele Arabe Unite, Turcia, Rusia și CSI ca nomad digital. Damir a obținut o diplomă de licență în fizică, despre care crede că i-a oferit abilitățile de gândire critică necesare pentru a avea succes în peisajul în continuă schimbare al internetului.

Mai multe articole

Damir este liderul echipei, manager de produs și editor la Metaverse Post, care acoperă subiecte precum AI/ML, AGI, LLM-uri, Metaverse și Web3-domenii conexe. Articolele sale atrag o audiență masivă de peste un milion de utilizatori în fiecare lună. El pare a fi un expert cu 10 ani de experiență în SEO și marketing digital. Damir a fost menționat în Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto și alte publicații. Călătorește între Emiratele Arabe Unite, Turcia, Rusia și CSI ca nomad digital. Damir a obținut o diplomă de licență în fizică, despre care crede că i-a oferit abilitățile de gândire critică necesare pentru a avea succes în peisajul în continuă schimbare al internetului.