Alibaba ievieš atvērtā koda Qwen-7B valodas modeli

Alibaba ir atklājusi savu atvērtā koda lielo valodu modeli (LLM). Qwen-7B, atzīmējot to pirmo ienākšanu publiski pieejamo LLM jomā. Šis modelis ir balstīts uz 7 miljardiem parametru.

Kontekstam Qwen-7B tika apmācīts, izmantojot 2.2 triljonus žetonu. Šajā apmācību fāzē iestatītais konteksta lielums bija 2048, savukārt lietotāji testēšanas laikā to var palielināt līdz maksimāli 8192. Salīdzinot, Llama-2, vēl viens LLM, piedāvā konteksta lielumu 4096.

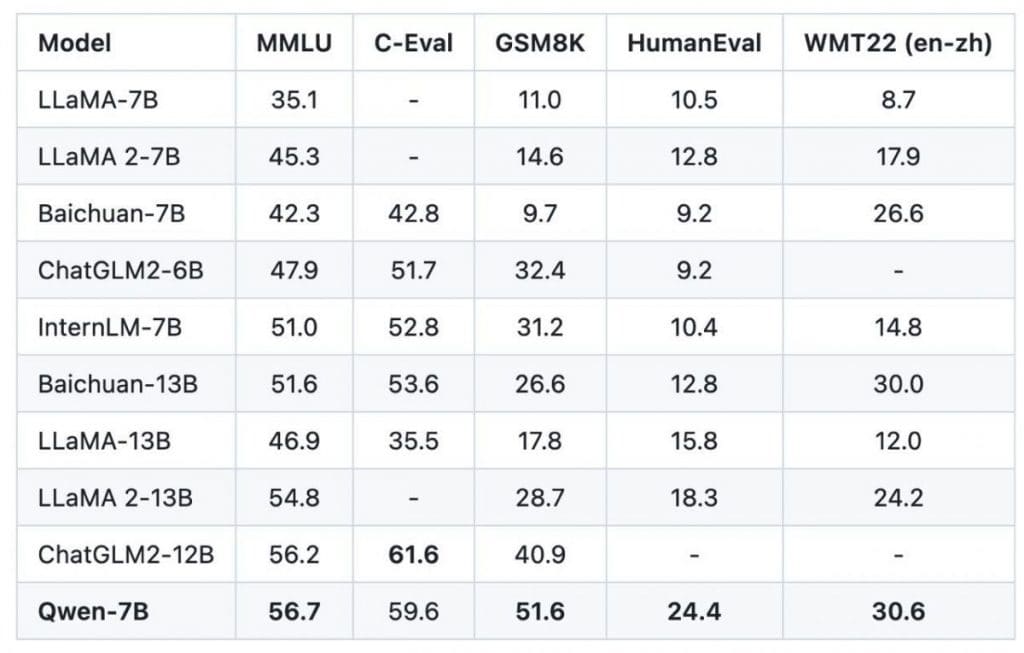

Etaloni ir būtiski, lai novērtētu šādu modeļu veiktspēju, un šajā jomā Ķīnas izstrādātāji apgalvo, ka Qwen-7B ir pārspējis Llama-2. Viens no rādītājiem, kas izceļas, ir Human-Eval kodēšanas etalons, kur Qwen-7B rezultāts ir 24.4 pret Llama-2's 12.8. Tomēr ir saprātīgi aplūkot šos skaitļus ar zināmu piesardzību. Daži etaloni norāda, ka Qwen-7B pārspēj ne tikai bāzes modeli LLama-2-7B, bet arī LLaMA-2-13B variants. Tomēr, salīdzinot ar uzlabotajām versijām Llama-2, starpības robeža kļūst šaurāka. Jāatzīmē, ka tās izstrādātāji nav skaidri aprakstījuši Qwen-7B precīzu apmācības metodiku.

Funkcionalitātē paralēli LLaMa2-čats, Qwen ir prezentējis uz tērzēšanu orientētu versiju ar nosaukumu Qwen-7B-Chat. Šis modelis ir optimizēts mijiedarbībai ar lietotājiem, un tajā ir iekļauti dažādi rīki un API lai uzlabotu tā atsaucību.

Tiem, kuriem ir tendence uz tehnisko specifiku, būtu interesanti uzzināt, ka Qwen-7B arhitektoniskais pamats ir līdzīgs LLaMA. Tomēr ir atšķirīgas iezīmes, kas atšķir Qwen-7B:

- Tas izmanto nesaistītu iegulšanu.

- Tiek izmantota rotācijas pozicionālā iegulšana.

- Neobjektivitātes ir izslēgtas, izņemot QKV uzmanību.

- RMSNorm ir priekšroka salīdzinājumā ar LayerNorm.

- Standarta ReLU vietā ir iekļauts SwiGLU.

- Lai paātrinātu apmācības procesu, ir ieviesta zibatmiņas uzmanība.

- Modelis sastāv no 32 slāņiem, tā iegulšanas izmērs ir 4096, un tajā ir 32 uzmanības galviņas.

Licencēšanas ziņā Qwen-7B atbilst Llama-2. Tas pieļauj komerciālu izmantošanu, bet ar nosacījumu par lietotāju skaitu. Kamēr Llama-2 nosaka šo ierobežojumu 700 miljonu aktīvo lietotāju mēnesī, Qwen-7B slieksnis ir 100 miljoni.

Tie, kas vēlas veikt padziļinātu pārbaudi, var atsaukties uz tehnisko ziņojumu, kas pieejams vietnē GitHub. Turklāt Qwen-7B demonstrācija, kas sniegta ķīniešu valodā, ir pieejama tiem, kas interesējas par modeļa iespēju praktisku izpēti.

Lasiet vairāk par AI:

Atbildības noraidīšana

Atbilstīgi Uzticības projekta vadlīnijas, lūdzu, ņemiet vērā, ka šajā lapā sniegtā informācija nav paredzēta un to nedrīkst interpretēt kā juridisku, nodokļu, ieguldījumu, finanšu vai jebkāda cita veida padomu. Ir svarīgi ieguldīt tikai to, ko varat atļauties zaudēt, un meklēt neatkarīgu finanšu padomu, ja jums ir šaubas. Lai iegūtu papildinformāciju, iesakām skatīt pakalpojumu sniegšanas noteikumus, kā arī palīdzības un atbalsta lapas, ko nodrošina izdevējs vai reklāmdevējs. MetaversePost ir apņēmies sniegt precīzus, objektīvus pārskatus, taču tirgus apstākļi var tikt mainīti bez iepriekšēja brīdinājuma.

Par Autors

Damirs ir komandas vadītājs, produktu vadītājs un redaktors Metaverse Post, kas aptver tādas tēmas kā AI/ML, AGI, LLM, Metaverse un Web3- saistītie lauki. Viņa raksti katru mēnesi piesaista lielu auditoriju, kas pārsniedz miljonu lietotāju. Šķiet, ka viņš ir eksperts ar 10 gadu pieredzi SEO un digitālā mārketinga jomā. Damirs ir minēts Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto un citas publikācijas. Viņš ceļo starp AAE, Turciju, Krieviju un NVS kā digitālais nomads. Damirs ir ieguvis bakalaura grādu fizikā, kas, viņaprāt, ir devis viņam kritiskās domāšanas prasmes, kas nepieciešamas, lai gūtu panākumus nepārtraukti mainīgajā interneta vidē.

Vairāk rakstus

Damirs ir komandas vadītājs, produktu vadītājs un redaktors Metaverse Post, kas aptver tādas tēmas kā AI/ML, AGI, LLM, Metaverse un Web3- saistītie lauki. Viņa raksti katru mēnesi piesaista lielu auditoriju, kas pārsniedz miljonu lietotāju. Šķiet, ka viņš ir eksperts ar 10 gadu pieredzi SEO un digitālā mārketinga jomā. Damirs ir minēts Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto un citas publikācijas. Viņš ceļo starp AAE, Turciju, Krieviju un NVS kā digitālais nomads. Damirs ir ieguvis bakalaura grādu fizikā, kas, viņaprāt, ir devis viņam kritiskās domāšanas prasmes, kas nepieciešamas, lai gūtu panākumus nepārtraukti mainīgajā interneta vidē.