Stability AI's Stable Diffusion 2 L'algorithme est enfin public : nouveau modèle depth2img, upscaler super-résolution, pas de contenu pour adultes

En bref

Stable Diffusion Le modèle 2.0 est plus rapide, open source, évolutif, plus robuste que le précédent

Stable Diffusion est prêt pour le GPU avec de nouvelles fonctionnalités pour un rendu en temps réel

Guidé en profondeur stable diffusion modèle – Image à image avec de nouvelles idées pour des applications créatives

Stability AI a libéré un nouvel article sur son blog à propos Stable Diffusion 2. Dans celui-ci, Stability AI propose un nouvel algorithme plus efficace et robuste que le précédent tout en le comparant à d'autres méthodes de pointe.

L'original de CompVis Stable Diffusion Modèle V1 révolutionné la nature de l'open source Modèles AI et produit des centaines de modèles et d'avancées différents dans le monde entier. Il a vu l'une des ascensions les plus rapides vers 10,000 33,000 étoiles Github, accumulant XNUMX XNUMX en moins de deux mois, plus rapidement que plus de programmes sur Github.

L'ouverture a Stable Diffusion La sortie de la V1 a été menée par la dynamique équipe de Robin Rombach (Stability AI) et Patrick Esser (Runway ML) du groupe CompVis du LMU Munich, dirigé par le professeur Björn Ommer. Ils se sont appuyés sur les travaux antérieurs du laboratoire avec Latent Modèles de diffusion et a reçu un soutien critique de LAION et d'Eleuther AI.

Ce qui rend Stable Diffusion v1 différent de Stable Diffusion v2 ?

Stable Diffusion 2.0 inclut un certain nombre d'améliorations et de fonctionnalités importantes par rapport à la version précédente, alors jetons-y un coup d'œil.

Les Stable Diffusion La version 2.0 propose des modèles texte-image robustes entraînés avec un nouvel encodeur de texte (OpenCLIP) développé par LAION avec l'aide de Stability AI, ce qui améliore considérablement la qualité de images générées par rapport aux versions V1 précédentes. Les modèles texte-image de cette version peuvent produire des images avec des résolutions par défaut de 512 × 512 pixels et 768 × 768 pixels.

Ces modèles sont entraînés à l'aide d'un sous-ensemble esthétique de l'ensemble de données LAION-5B généré par Stability AIde l'équipe DeepFloyd, qui est ensuite filtrée pour exclure le contenu réservé aux adultes à l'aide du filtre NSFW de LAION.

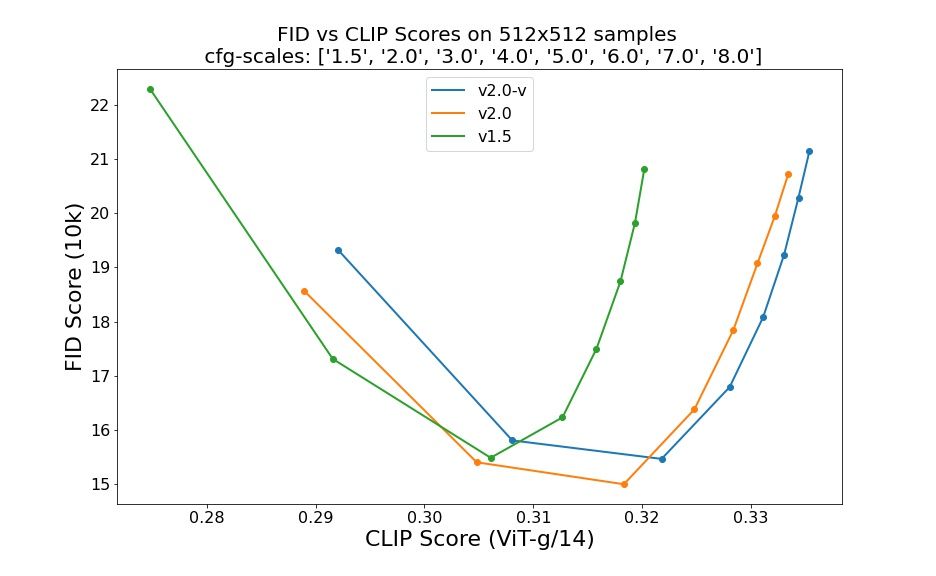

Les évaluations utilisant 50 étapes d'échantillonnage DDIM, 50 échelles de guidage sans classificateur et 1.5, 2.0, 3.0, 4.0, 5.0, 6.0, 7.0 et 8.0 indiquent des améliorations relatives des points de contrôle :

Stable Diffusion 2.0 intègre désormais un modèle de diffusion Upscaler, qui augmente la résolution de l'image d'un facteur quatre. Un exemple de notre modèle Upscaling une image générée de faible qualité (128 × 128) en une image de résolution plus élevée est présentée ci-dessous (512 × 512). Stable Diffusion 2.0, lorsqu'il est combiné avec nos modèles texte-image, peut désormais générer des images avec des résolutions de 2048 × 2048 ou plus.

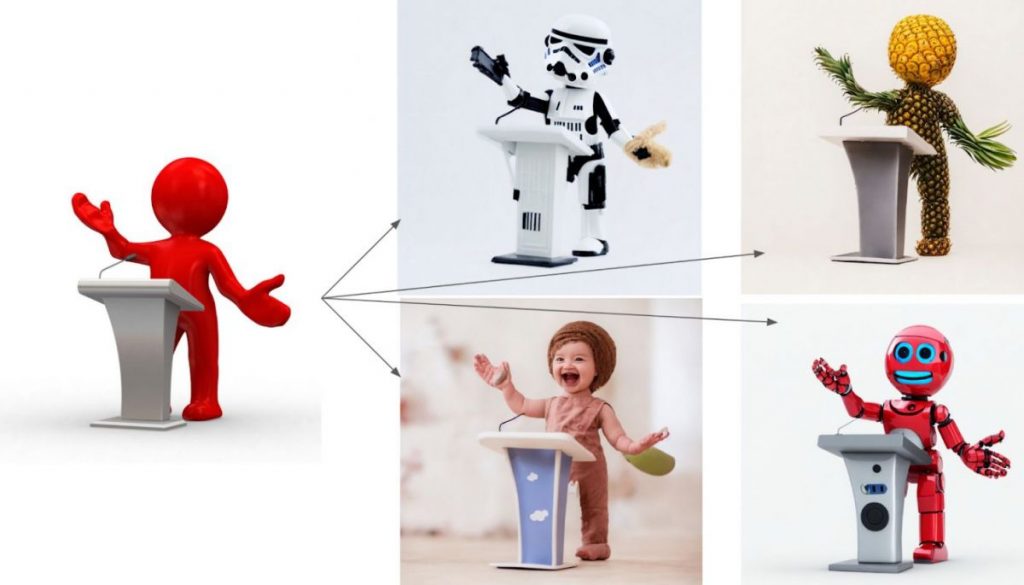

Le nouveau guidage en profondeur stable diffusion modèle, depth2img, étend la fonctionnalité précédente d'image à image de la V1 avec des possibilités créatives entièrement nouvelles. Depth2img détermine la profondeur d'une image d'entrée (à l'aide d'un modèle existant) puis génère de nouvelles satellite basé à la fois sur le texte et sur les informations de profondeur. Depth-to-Image peut fournir une pléthore de nouvelles applications créatives, offrant des changements qui semblent très différents de l'original tout en conservant la cohérence et la profondeur de l'image.

Quoi de neuf dans Stable Diffusion 2?

- Le nouveau système d’ stable diffusion modèle offre une résolution de 768×768.

- Le U-Net a le même nombre de paramètres que la version 1.5, mais il est formé à partir de zéro et utilise OpenCLIP-ViT/H comme encodeur de texte. Un modèle dit de prédiction v est SD 2.0-v.

- Le modèle susmentionné a été ajusté à partir de la base SD 2.0, qui est également mise à disposition et a été formé comme un modèle de prédiction de bruit typique sur des images 512 × 512.

- Un modèle de diffusion guidée par le texte latent avec une mise à l'échelle x4 a été ajouté.

- Guide de profondeur de base SD 2.0 raffiné stable diffusion modèle. Le modèle peut être utilisé pour l'img2img préservant la structure et la synthèse conditionnelle de forme et est conditionné sur des estimations de profondeur monoculaires déduites par MiDaS.

- Un modèle amélioré d'inpainting guidé par le texte construit sur la fondation SD 2.0.

Les développeurs ont travaillé dur, tout comme l'itération initiale de Stable Diffusion, afin d'optimiser le modèle pour qu'il s'exécute sur un seul GPU. Ils souhaitaient dès le départ le rendre accessible au plus grand nombre. Ils ont déjà vu ce qui se passe lorsque des millions d'individus mettent la main sur ces modèles et collaborent pour construire des choses absolument remarquables. C'est le pouvoir de l'open source : exploiter le vaste potentiel de millions de personnes talentueuses qui n'ont peut-être pas les ressources nécessaires pour former un modèle de pointe mais qui ont la capacité de faire des choses incroyables avec un.

Cette nouvelle mise à jour, combinée à de nouvelles fonctionnalités puissantes telles que depth2img et de meilleures capacités de mise à l'échelle de la résolution, servira de base à une pléthore de nouvelles applications et permettra une explosion de nouveau potentiel créatif.

Découvrez notre article sur Stable Diffusion:

Clause de non-responsabilité

En ligne avec la Lignes directrices du projet de confiance, veuillez noter que les informations fournies sur cette page ne sont pas destinées à être et ne doivent pas être interprétées comme des conseils juridiques, fiscaux, d'investissement, financiers ou toute autre forme de conseil. Il est important d’investir uniquement ce que vous pouvez vous permettre de perdre et de demander des conseils financiers indépendants en cas de doute. Pour plus d'informations, nous vous suggérons de vous référer aux conditions générales ainsi qu'aux pages d'aide et de support mises à disposition par l'émetteur ou l'annonceur. MetaversePost s'engage à fournir des rapports précis et impartiaux, mais les conditions du marché sont susceptibles de changer sans préavis.

A propos de l'auteur

Damir est chef d'équipe, chef de produit et rédacteur en chef chez Metaverse Post, couvrant des sujets tels que l'IA/ML, l'AGI, les LLM, le métaverse et Web3-domaines connexes. Ses articles attirent une audience massive de plus d'un million d'utilisateurs chaque mois. Il semble être un expert avec 10 ans d'expérience dans le référencement et le marketing numérique. Damir a été mentionné dans Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto et d'autres publications. Il voyage entre les Émirats arabes unis, la Turquie, la Russie et la CEI en tant que nomade numérique. Damir a obtenu un baccalauréat en physique, ce qui, selon lui, lui a donné les compétences de pensée critique nécessaires pour réussir dans le paysage en constante évolution d'Internet.

Plus d'articles

Damir est chef d'équipe, chef de produit et rédacteur en chef chez Metaverse Post, couvrant des sujets tels que l'IA/ML, l'AGI, les LLM, le métaverse et Web3-domaines connexes. Ses articles attirent une audience massive de plus d'un million d'utilisateurs chaque mois. Il semble être un expert avec 10 ans d'expérience dans le référencement et le marketing numérique. Damir a été mentionné dans Mashable, Wired, Cointelegraph, The New Yorker, Inside.com, Entrepreneur, BeInCrypto et d'autres publications. Il voyage entre les Émirats arabes unis, la Turquie, la Russie et la CEI en tant que nomade numérique. Damir a obtenu un baccalauréat en physique, ce qui, selon lui, lui a donné les compétences de pensée critique nécessaires pour réussir dans le paysage en constante évolution d'Internet.